Это копия, сохраненная 6 мая 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ https://halite.io/ https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/jobs?q=deep+learning&l=

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Предыдущий тред: >>1105498 (OP)

Предлагаю переписать шапку, добавив ответов на платину, дедовских и свежих книг и, возможно, списки статей

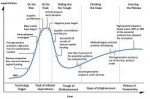

221 Кб, 648x526

221 Кб, 648x526самообучающийся, полиморфный червь, избегающий слива сигнатур и не поддающийся обнаружению

Никто не будет читать простыню в шапке. Все, что нужно, сейчас есть: единственная книга, стоящая времени на ее прочтение, и архив-санити со статьями. Платину расписывать бессмысленно, т.к. все равно будут спрашивать.

def mod1(...):

...

model.compile(...)

return model

Хайп уже сдувается, все пишут смарт-контракты и блокчейн на эрганге и голом железе.

Ты думаешь почему не перекатывали, маня?

Пока ты дрочишь свои манянейронки, всякие заки уходят нахуй из разработки блокчейн технологий, только потому что их не устраивает зп в сотни к баксов в месяц

https://github.com/zack-bitcoin/amoveo/blob/master/docs/why_I_left.md

Мои тут два последних поста второй с пруфом

Нахуй мне бы вообще всралось форсить тут блокчейны и семенить, как и остальным, ты ебанутый?

50 Кб, 797x928

50 Кб, 797x928Можешь сделать свою, посмотрим будет ли лучше. По-моему она вообще не важна, можно просто сократить до "Очередной тред про нейроночки." Все остальное постеры либо уже знают, либо оно им не нужно/не поможет.

автор текущей шапки

Ну да, мне ведь так важно засеменить опа-хуя что я полезу менять хтмли двача.

Вернись в б, плиз

Люди делают и более странные вещи ради более глупых целей. Так что меня бы это совершенно не удивило. Более того, сам факт того, что ты счел нужным скринить свои посты ради какого-то пруфа неизвестно чего, делает такое объяснение наиболее вероятным. Т.е. создалась такая парадоксальная ситуация, когда запостив пруф ты только убедил всех еще больше в своей виновности.

Мань, из чистого двачеблагородства я тебе посоветовал осваивать нормальные вещи на которые скоро будет спрос, через пару лет крутильщики ползунков гиперпараметров пойдут на свалку. А ты уже каких-то манятеорий себе напридумывал, да и еще мой скриншот под свои выдумки подогнал. Более того сам факт твоей фантазии делает объяснение, что ты не способен объективно воспринимать реальность, наиболее вероятным. И даже когда прямо тебя попросят пройти на помоечку, ты таки не сможешь понять что твои нейроночки уже даже сейчас никому не нужны, а будешь под это строить очередной свой манямирок.

>у меня есть, скажем, PSD макет или просто изображение мокапа страниц и я хочу этот мокап представить в виде жсона (точнее представление уже есть, просто надо научить этому комп)

>например:

>Изображение ->

>{

>Form1:{

>children:[{

>Button_1...,

>TextField1...,

>}]

>}

>}

>

>Т.е представить страницу в виде древовиднойструктуры

кто чем может, дайте инфы

знаю проекты типа pix2code, но там рендерится сразу страница, а мне бы кастомный объект, чтобы в редакторе на работе открыть.

Спасибо.

Очень неумело траливанишь. Рекомендую пройти шестимесячную подготовку в /b/, а потом возвращаться.

pix2code ровно это и делает. Ты бы хоть статью прочёл для начала. Естественно, под твою задачу тебе придётся тренировать свою модель.

просто думал, что может есть другая модель для такой задачи

+ мне компилятор не нужен, чисто структуру выдавать.

короче я даун, пошел читать статью

сложновато будет, конечно.

быстрый вопрос

гугл бесплатно предоставляет мейнфрейм? а то у меня комп на работе слабоват для МЛ.

300$ там при регистрации на счёт кладут. Возможно, этого хватит.

Во вложенные объекты оно умеет. Насколько хорошо - сам посмотришь. Я бы на твоём месте скачал их модель и подергал на своих примерах, чтобы понять примерно возможности.

ну да, спс

просто опыта у меня в МЛ ноль

я веб макака, просто у нас проект типа кайнд оф билдер сайтов для бизнес-аналитиков

так я прям загорелся идеей заюзать похожую штуку, только чтобы с нашим DSL приложения.

годнота была бы.

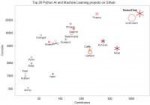

263 Кб, 1531x1024

263 Кб, 1531x1024Опыт в МЛ на деревьях не растет, именно так ты его и получаешь. Пробуй, смотри что и как. Бекграунд по первой ссылке в шапке, если зайдешь в тупик.

По возможностям в МЛ: смарите на этих чуваков, сделавших pix2code (пикрел). Они сделали хорошую работу на хайповую тему (все же обсуждали, как ИИ отнимет у всех работу), написали статью. Это взлетело, они уже организовали конторку под это дело (uizard), походят сейчас на конференции, туда-сюда, и их купит какой-нибудь гугл за 100млн. Это бабло делится на 4 основателей, и вот они уже в свои 20-30 лет могут больше не работать ни дня. Вот так куются бабки в силиконовой долине. Ради этого можно не спать ночами, красноглазить на хакатонах и проч.

Немного грустно, что нам с вами максимум от этого пирога светит Н1В рабство за 100к, да и то лишь для 0.1% самых лучших, пробивных и удачливых. Но такова уж наша орочья доля.

> Ради этого можно не спать ночами, красноглазить на хакатонах и проч.

так это все, обычно, не ради бабок делается, а ради интереса/for fun

ставить целью бабки это изначально угробить мотивацию

Тебе должно быть пиздец интересно то, что ты делаешь иначе никак

Конечно, не отнимет. Как самый максимум эта штука внешний вид интерфейса может оформить, но как это все должно работать кто-то все равно должен кодить.

Про не работать: я не имел в виду сидеть на диване. Независимость от работы переводит тебя из рабочего класса в буржуи. Это реально другой мир. Ты обретаешь полную свободу, делаешь что хочешь. Хочешь - работаешь, но опять же только там, где тебе самому нравится. Захотел, не знаю, написать книгу или научиться играть на скрипке, или пройти весь pacific crest trail, забраться на Эверест, съездить в Антарктиду, пожить в тибетском монастыре и выучить тибетский язык, вообще все что тебе в голову взбредет - пожимаешь руки своим коллегам-батракам и просто идешь и делаешь. Весь мир твой. Как если бы в ММО ты из НПЦ превратился в игрока. Это головокружительная перспектива.

ну так-то да. Тут не поспоришь.

Да и, в принципе, можно как цукербрин, сидеть работать сколько хочешь и норм.

>Немного грустно, что нам с вами максимум от этого пирога светит Н1В рабство за 100к, да и то лишь для 0.1% самых лучших, пробивных и удачливых. Но такова уж наша орочья доля.

Рашка в жопу говна заливает? Вон недавно гугл купил беларуский стартап по нейроночкам.

Ничоси, почитал про AIMATTER. Но уверен на 100%, это не такая простая контора.

Например, см. здесь:

https://techcrunch.com/2017/01/13/fabby-grabs-2m/

>The seed round of funding was led by Haxus Venture Fund. Haxus knows what it is doing in terms of image filter apps: it’s known for previously funding the MSQRD & Prisma filters, and was co-founded by Yuri Gurski. Fabby was co-founded by Yuri Melnichek (the founder of Maps.me).

(Fabby = AIMATTER)

https://techcrunch.com/2017/08/16/google-acquires-aimatter-maker-of-the-fabby-computer-vision-app/

>AIMatter had people working in Minsk, the Bay Area, and Zurich (Switzerland being particularly strong in computer vision tech, see here, here, and here). It’s not clear yet if the staff will stay where they are now or relocate elsewhere, or what else they will be working on for Google.)

Из этого следует, что основатели сами из тусовки в Долине, а в Беларуси у них просто галеры.

в беларуси образование говнище просто.

если ты со школы в олимпиадки не вкатывался, то отупеешь в универе хуже некуда.

и мотивацию потеряешь.

не хочу сказать ничего плохого, но выглядит просто пиздец

с точки зрения искусства полное дерьмо.

А мне понравилось.

С т.з. Искусства, конечно, нейроночка никуда не годится - у нее же нет никакой идеи, никакого мессаджа, чисто рандомом фигачит, стараясь сделать похожую картинку. Но стиль ничо так выходит.

какой-то адекватный тред

уже 20 минут, а меня еще нахуй не послали.

посижу тут еще.

Не, так-то да, акварель какая-то.

по крайней мере, лучше меня рисует.

Ну ключевые фигуры: Гурский и Мельничек обычные бульбаши, просто работали и на всякие гуглы прежде чем придти к успеху. Они кстати еще не так давно продали maps with me майлу, отличные карты кстати.

Так что и у орков есть шансы

>>22344

>ну это при условии что ты умен, талантлин и не проебал время/мотивацию в шараге.

Как будто к стартапам в долине это не относиться.

>>22349

>если ты со школы в олимпиадки не вкатывался, то отупеешь в универе хуже некуда.

Не согласен, я сам был олимпиадником(неуспешным), мне это привило такое отвращение к алгоритмам из-за этих ебанутых надуманных задач, что я только спустя 5-6 лет начинаю получать интерес читая и реализуя какой-нибудь хитрый алгоритм.

>у нее же нет никакой идеи, никакого мессаджа, чисто рандомом фигачит

Лол, ты думаешь черный квадрат Малевича был рождён иначе?

Методов и либ миллион, ищи на гитхабе. Лично мне всегда было неудобно втискивать свой код в эти фреймворки, и я каждый раз делал свое.

>Потому что цвета непрерывны.

Хорошо, давай тогда объединим все 3 цвета в один и сделаем только одну входную карту.

Я не понял, что ты предлагаешь, но в любом случае обосновывать почему это лучше придется тебе.

Если уж заниматься улучшательством, то можно перевести цвета в более осмысленную кодировку, например в HSV или специально задизайненную для этой цели. Но это на самом деле не нужно, слишком низкоуровневое преобразование. Нейроночка такое прекрасно может сделать сама.

Я им завидую, но по-белому. Рад за них. Это ведь очень хорошо, когда есть такие возможности у ученых, обогатиться на собственной работе. В какой еще области ты, делая исследования, можешь стать миллионером? Именно в Долине общество приблизилось к идеалу, награждая людей пропорционально вкладу.

Я предлагаю обосновать, почему данные именно в РГБ формате, а не в битовом как-то запихиваются в сеть. Ведь сети всегда удобнее оперировтаь дискретными данными 0 или 1.

И еще интересен вопрос почему гугл капча пихает картинки с ветринами и мостами, сеть их плохо распознает? На сколько я видел сегментация любых объектов для автопилота проходит неплохо с любыми объектами.

Потому что это неплохой формат в данном случае. Непрерывные величины из заранее заданного диапазона тоже вполне хорошо оперируются.

Как конкретно работает рекапча это секрет гугла.

>Как конкретно работает рекапча это секрет гугла.

Я не спрашиваю секрет это или нет, я спрашиваю в чем сложность распознавания того что он выдает.

Из того, что мне попадалось, там бывают очень сложные случаи, где знаки сливаются с фоном, где они мелкие и нечеткие. Но это все гадания. Может быть, никакой особой сложности нет.

>Нейроночка такое прекрасно может сделать сама

Может, но захочет ли, если её специально не учить. Вот это я не понимаю. Из чего нейронка догадается, что конвертацию в HSV делать эффективнее? Как это следует из статистических данных выборки обучения?

Например, ты учишь нейроночку отличать яблоки от апельсинов по фотографиям. Тогда из данных нейроночка установит, что ответ зависит от тона, в некоторой степени от насыщенности, но не от яркости. Вот на фильтрах первых слоев и появится соответствующее преобразование. Конечно, это не будет именно HSV, но нечто подобное ему.

Так это надо сначала учить на оттенки на специальном датасете, а потом обученные слои переносить на котиков, например. Кто-нибудь так делает? Не думаю. Ну, претренированные сети используют конечно, на несчастном Imagenet, там всего 1000 классов.

Я так понял сеть изначально ленивая, если научилась котов детектить например по ушам - дальше не учится, на другие признаки плевать. Потому что нет сигнала ошибки - нет обучения.

У тебя наивные представления о том, как работают нейроночки. Почитай книгу из шапки для более детального понимания.

7,3 Мб, 448x128

7,3 Мб, 448x128У него небось и искусственный интеллект уже полноценно существует в голове, и нейронки сами догадываются, как им учиться.

Ленивая сеть, мда. Сеть - это не человек, она не может быть ленивой, трудоспособной, угрюмой, дружелюбной и так далее. Она может быть только в разной степени эффективной.

Объясняю мысль. В первую очередь классификатором выделяются сильные и простые признаки. Например, для леопарда - это пятна. По ним легко и просто определить его. Сеть учится выделять пятна. Все, леопарда узнаем в 100%. Значит на леопарде нет сигнала ошибки, градиенты по нолям, веса не меняются, другие признаки леопарда не выделяются. Все выглядит прекрасно, пока мы не подаем на вход Леонтьева в леопардовых трусах. Так понятнее?

Нужно не прочесть ни одной книги чтобы не знать что такое ленивость, жадность и угрюмость алгоритма. Для 2018 это достижение, так держать!

Я тут вспомнил, что для борьбы с этим уже придумали dropout.

Ладно, изобретаю нейронку дальше.

Она не пятна учится выделять, а циферки на входе.

Так он это в антропологическом смысле говорил.

Кто что думает? Почему еще нет впечатляющих результатов от них? Чего им не хватает?

Работающей теории.

Ссылки в ОП-посте не предлагать, там всё на собачьем.

Реализация того покерного алгоритма, который уже давненько тестили на профессионалах, не появилась в открытом доступе?

Но я так и не понял, можно ли чтобы данная функция показала какое уравнение графика у неё получилось в результате обучения? Например, получилась прямая и можно ли как-то получить уравнение прямой?

Спасибо

А есть что-нибудь нормальное почитать \ поюзать касаемо синтеза речи?

Да, слышал про tacotron, wavenet и lyrebird, кто-нибудь с этим работал?

Где конкретно там читать?

В чём можно смоделировать нейронку? Интересуют инструменты наподобие матлабовского Neural Network Tool.

Что быстрее работает: torch7 или tensorflow? Или есть что-то ещё быстрее из фреймворков? в гугле забанен

У них немного разные концепции исполнения. Торч (я имел дело только с питорчем) выполняет действия сразу, а тф отложенно. В тф сначала создаёшь граф вычислений, а потом его многократно гоняешь. Задачи, которые хорошо укладываются в модель работы тф, будут там немного быстрее обычно.

В тф недавно сделали immediate mode, который работает как в питорче, но он вроде пока медленный.

Вообще так и делается в коммерческих сетках - гугли HSV преобразование.

>>28623

Полезного точно нет ничего. А смысл на русском? Все равно вся матчасть алгоритмов, весь софт, вся документация на английском.

Когда нюфаня, английский смущает. Мне бы подвкатиться, что бы общую концепцию понять, тогда язык уже не принципиален, тем более уже привычно, что свежая инфа только на англ, переводить всем лень, тк нахуй никому не надо, гугол транслит чудеса творит.

Посоветуйте для нюфани, хоть на английском.

>Мне бы подвкатиться, что бы общую концепцию понять,

Общую концепцию чего? Глубоких нейросетей, точнее сверточных, т.к. другие глубокие архитектуры уже не в моде? Педивикия, хабр, на ютубе лекций полно.

И еще что почитать, посмотреть на тему нейронок?

> че

Что-то там capability. Пишет, что надо 3.0 и выше. Если меньше - бреешься, gpu работать не будет нигде, от матлаба и микрософта cntk до слесарьплова. На сайте нвидии есть таблица, сколько у каждой видюхи. Максимум вроде 5.5 но это всякие Теслы. Поддержку ниже 3.0 отключили все, как по указке сверху. И мне кто-то будет говорить, что нет сговора производителей.

>И еще что почитать, посмотреть на тему нейронок?

https://habrahabr.ru/company/mailru/blog/333862/

> Ебать дебил.

Мань, факт в том, что не самые новые-модные-молодежные видюхи физически блочат. Без всякой разумной причины это делать кроме стимулирования спроса. А то что ты дебил, как и представился, роли не играет.

Интересно. Что знаешь и что умеешь? И на каком примерно уровне? Как пришел, как готовился и что учил? Сам наверное начну с этого так как вакансии в моем городе и в соседнем как раз дата инженер и что то рядом, а для сайнтистов нет.

что нн - это просто умножение матриц

друг на друга. Интересно о чем это он?

Вроде бы умножить каждую ячейку

массива где 2 уровня на ячейку матрицы

близнеца и умножение на ноль в фильтре

даст ноль, а потом все числа сложить и

получиться большое число, а потом

сравнить это число с результатом

фильтр * на фильтр

Михаил, примите вещества и покиньте тред.

> Потому что никому нахуй не надо поддержать зоопарк устаревших версий.

Устаревших версий чего? Куда поддерживает, драйвера последние поддерживают. А слесарьплов работает с драйвером и кудой, ему похуй, какая видюха, процессор, память итд. Не знаешь, так хоть бы хуйни не нес.

Какие языки используются в нейроночке да машобчике? Так понимаю, безраздельно властвует Python с иногда библиотеками на крестах, верно? Что по поводу какой-нибудь Java?

> Не понимаю в чём нахуй космический эффект питона что большинство нейронок на нем?

Стильно, модно, молодежно, бородатым петушкам из барбершопов нраица, индусы говоря молодца, хорошо сделоли. Хипстерская технология от хипстеров для хипстеров.

Коэффициенты поверхности лежат в coef_, как выше сказали. Нарисовать можешь сам если размерность пространства не больше 3

в ашане (в некоторых) в дс уже частично заменили и без нейросетей

питон - это сахар для библиотек на плюсах (тензорфлоу), там хоть р, хоть хаскель, хоть брэинфак используй

Загуглить, не? Может и есть чё под жабу, а на шарпе с этим совсем плохо.

Думаю то, что этот язык даже дебил осилит. Вот и пишут на нём.

В области роботизированной ебулды нейроночки сосут хуй с самого своего появления. И это я еще умолчу о том, что внедрять алгоритм, для которого нет строгих математических доказательств устойчивости, не будет никто, т.к. никому не нужно, чтобы роботизированный поезд метро со всей дури размазал пару сотен пассажиров об тупиковую призму, или чтобы автоматизированная доменная печь сожгла ползавода вместе с работягами. В этой области хороши контроллеры, в т.ч. на нечеткой логике. Напомню, первый поезд на нечетко-логических контроллерах ввели в эксплуатацию еще в 1987 году (после почти 10 лет работ и испытаний). На нейроночках ничего подобного нет и в наше время, более того, не будет никогда по причине отсутствия госта "ебань хипстерская, как работает хуй ее знает, но GPU надо хотя бы с 4 гигами оперативы".

байтоёбы лают, караван идёт

>строгих математических доказательств

Ненужно.

>роботизированный поезд метро со всей дури размазал пару сотен пассажиров об тупиковую призму, или чтобы автоматизированная доменная печь сожгла ползавода вместе с работягами

Всем похуй, чем меньше людишек - тем лучше.

213 Кб, 491x424

213 Кб, 491x424>Ненужно.

Конечно-конечно, раз уж школотрон-мизантрап на мейлру так написал, значит и правда ненужно. Я тебе реальную причину назвал, почему с этим говном из жопы в промышленности не связываются и не будут связываться никогда. Все потуги сирожина пирожина гугла - это реклама от рекламной параши. Самое серьезное достижение нейроночек со времен Розенблатта - научились котиков под пикассо раскрашивать и негров детектить.

27 Кб, 204x269

27 Кб, 204x269>tensorflow использует только нвидиа гпу

Нафиг так жить, котаны?

Хочу как-нибудь с зарплат себе купить пеку для игорей и нейроночек, что лучше брать? Учитывая уязвимости интелов и их говнокодерские заплатки

486 Кб, 592x592

486 Кб, 592x592Ну сделай что-то подобное вместо кукарекания. Я пока твою нечеткую логику видел только в стиральной машине (еще бы она там была нужна)

В промышленности будут связываться и уже связываются, они дают добиться лучших или целевых результатов за меньшее время, в промышленности на заводах они могут использоваться для определения брака на ранних стадиях.

6,7 Мб, 300x168

6,7 Мб, 300x168>Ну сделай что-то подобное

Во, еще одно огромное достижение. И про порнуху забыл с любым подставляемым еблом. Передний край прогресса - болтающий сиськами Пыня.

Ты либо траллишь, либо очень недалекий. Завтра уже в твой роботизированный паровоз поставят нейронку и она будет управлять твоим контроллером и тормозить, когда на путях постороннее тело. Никто не говорит что нейронки заменят классические алгоритмы.

Ну блэдж, это уже придётся буквально год копить, а там всё опять поменяется.

Я хотел как средний класс за 2 месяца купить пеку за 1к и начинать для себя нейроночки дрочить.

>Завтра уже в твой роботизированный паровоз поставят нейронку

Нужно только потерпеть? Не поставят, я уже объяснил почему. Давно бы поставили, если бы была возможность.

>я уже объяснил

Всем похуй на твою маняматику и прочую чухню для задротов-неудачников вроде тебя

Как только станет экономически оправдано - тут же поставят, сразу же.

>Всем похуй на твою маняматику и прочую чухню для задротов-неудачников

Ты - это не все. "Одному дегенерату похуй" не равно "всем похуй".

Ничего ты не объяснил. Для человека нет и не будет никаких строгих математических доказательств, однако же его сажают управлять самолетом.

Да и вообще, внутре нейронки кроются все те же алгоритмы и нечеткие множества с вероятностями, известные из других подходов, это одинаковые яйца в профиль. Найдут способ и их верифицировать, упростят и причешут, а ты хочешь быстро

Да не нужны три карты. Их все три нагрузить довольно трудно, т.к. автоматического распараллеливания нет. Ты можешь, например, тренировать три нейроночки параллельно, но это уже продвинутое использование, когда гиперпараметры подбираешь, например. В большинстве хобби-проектов это не нужно.

И одну-то нагрузить полностью надо еще постараться.

Есть где-нибудь подробные видеогайды по TensorFlow на русском? По-другому информацию о программировании никак не воспринимаю.

+ к этому: если тебе нужно будет параллельно тренировать много нейроночек для подбора гиперпараметров, будет эффективнее закинуть сотню баксов в облако и тренировать там. С учетом того, что там можно хоть сотни, если не тысячи инстансов гонять параллельно, и нужно тебе это будет от силы раз в год для статьи или чего-то такого, это будет и быстрее, и проще, и выгоднее по деньгам, чем держать несколько карт у себя, которые будут почти всегда простаивать.

>воспринимать трудно пиздец.

Налицо легкая степень олигофрении.

Можешь попробовать ноотропы хотя вряд ли существенно помогут

Ебать ты тонкий тролль.

Даунич. Если человек учится не на ебнутых книжках, которые невозможно читать, а как-то по-другому, то он повторяет как макака сразу?

Если человек учится на ебнутых книжках, которые невозможно читать, а не как-то по-другому, то он просто повторяет действия, как макака, всё.

Да мне как-то похуй на твоё мнение, если я лучше тебя разрабатывать буду. А вот что ты делать будешь со своим илитарством?

Лучше ты можешь разрабатывать только свое очко. Кстати, видеоуроки тут реально помогут лучше книжки.

Как горит у учебникопидора.

260 Кб, 2048x1152

260 Кб, 2048x1152Даунич. Твоя математика уже не действует в современных технологиях. Нейросети не представляют никаких функций. Они показывают соотношения совпадений результатов.Ты бы ещё эволюционный алгоритм как функцию рассматривал. Никому нахуй не сдались твои блокчейны, заебал.

> Даунич. Твоя математика уже не действует в современных технологиях.

Дебил тупой, читал бы хоть что пишешь. Машоб это математика от и до.

> Нейросети не представляют никаких функций. Они показывают соотношения совпадений результатов

Это и есть аппроксимация функций.

> Никому нахуй не сдались твои блокчейны, заебал.

Какие блохчейны, чучело? Уроки иди делай.

>вопрос идентификации реальных законов системы

Ты в курсе, что ньютоновская механика - это тоже аппроксимация левыми функциями? Тебя это не беспокоит?

> Ты в курсе, что ньютоновская механика - это тоже аппроксимация левыми функциями? Тебя это не беспокоит?

Есть реальная система, есть её описание и есть её аппроксимация. Точное описание часто невозможно из-за неустранимой неточности, но это лучше, чем аппроксимировать линейными функциями, полиномами итд, когда они не имеют никакого отношения к реальной системе. Вопрос в практическом применении, с ньютоновской механикой ситуация все же лучше, чем с предсказанием временных рядов.

Но ведь процессор в комплюктере тоже синусы аппроксимирует полиномами, как дальше жить?

>чем с предсказанием временных рядов

С этим вообще как бы ситуация не очень, но есть здоровая конкуренция, и пусть она решит, кто прав.

Спекулянты давным-давно используют нейросети, а уж их-то не обманешь.

> Но ведь процессор в комплюктере тоже синусы аппроксимирует полиномами, как дальше жить?

Когда есть знание, что изначальная функция это синусоида, это одно дело. А когда полиномом аппроксимируют хуй знает что - совсем другое. Проблема как раз в том, что одну и ту же систему можно описать кучей разных функций. Но какие-то из них будут давать более лучшую экстраполяцию, какие-то наоборот в зависимости от степени близости к реальной системе. И если не ставить вопрос о выборе наиболее адекватной функции, которая может быть суперпозицией чего угодно, то никакими алгоритмами не повысить качество модели. Именно поэтому никакая манянейроночка как бы хорошо она не распознавала котиков, не поможет предсказать какие-нибудь бинарные опционы даже на минуту. Притом что там не рандом, ибо если бы там был рандом, любой дебил на этом делал бы триллионы тупо методом мартингейла, т.е 100% заходило бы максимум на 3-4 ставке. И вот, при всем этом, вопрос автоматического выбора наилучшей функции и метода подбора их суперпозиций не ставится вообще никем.

ты бы хотя бы 1 книжку по машинному обучению прочитал. Узнал бы что такое эмпирический риск. и что нейронки действительно востанавливают зависимости.

> ы лезешь с апроксимацией туда, где никакой функции, блять, нету вообще.

Если есть система (совокупность связанных переменных), то есть и наиболее точно описывающая её функция или суперпозиция многих функций.

Двачую. Сраная биржа это самодестабилизирующаяся система. Как только в ней появляется хоть какая-то закономерность - все игроки ломятся туда, и расшатывают всю упорядоченность к хуям.

Да суперпозиция то есть, но ты же понимаешь, что по сути она у тебя только на один набор данных. И исходные значения каждого элемента сети изменены по закономерностям без возможности восстановления.

> Да суперпозиция то есть, но ты же понимаешь, что по сути она у тебя только на один набор данных. И исходные значения каждого элемента сети изменены по закономерностям без возможности восстановления.

С чего бы? Есть система, по каким-то законам она работает. Значит, их можно восстановить, используя данные, порождаемые системой.

> Систем измерения этих данных не существует.

Ты даже не в курсе, что такое идентификация систем, а пытаешься спорить. Иди лучше делай уроки.

> У тебя нет конкретных значений в системе измерения. Как ты модель построишь?

Конкретные значения есть всегда. Даже словесное кукареканье можно выразить в тексте, а текст в виде tfxidf матрицы вещественных чисел.

Про теорию хаоса слышал? Так вот у тебя значения могут находиться где угодно, но не последовательно.

> Про теорию хаоса слышал?

Как и про методы работы с хаотическими системами. В частности, восстановления хаотических аттракторов, определение наличия хаотической системы по сечению Пуанкаре и т.д. все это частный случай идентификации систем.

> Только количество возможных диапазонов не известно.

Систему всегда можно идентифицировать, если она существует. Чистый рандом да, это просто нормальное распределение. Но если есть какие-то законы, их можно восстановить по данным, порождаемые системой. В этом суть всего машоба, обучение на данных возможно только в случае, если в этих данных содержатся закономерности, зависимости одних переменных от других. Вот только делать это можно по-разному.

Ты сам то понимаешь, что говоришь о модели нейросети как о функции, которую нейросеть аппроксимирует.

16 Кб, 400x400

16 Кб, 400x400> Ты сам то понимаешь, что говоришь о модели нейросети как о функции, которую нейросеть аппроксимирует.

А то ты не знаешь, что так оно и есть? Посмотри на матчасть хоть нейроночки, хоть svm, это параметризованная суперпозиция функций и алгоритм настройки свободных параметров функции. Другое дело, что вид функций задан априори, это сигмоиды, relu и прочее говнишко, относящееся к реальной идентифицируемой системе ровно никак. А я ещё в прошлом году писал, что если такую структуру задать типизированной лямбдой, то свободными параметрами станет и сама структура svm, автоматически подбираемая под конкретные данные например генетическим программированием в типизированной лямбде. Такой алгоритм максимально точно идентифицировал бы систему по имеющемуся датасету и сходу дал бы пососать любому существующему подходу. Палишь бесплатно идею для стартапа, который купит гугл за сто мильенов долларов, а никто даже не понимает о чем речь. Это смешно, субханалла

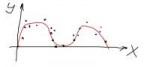

23 Кб, 774x349

23 Кб, 774x349У меня есть два метода по аппроксимации взятых из Python:

1)Из sklearn построение аппроксимирующего многочлена по точкам

2)Из scipy подбор синусоиды к точкам

В обоих случаях выходит результат как на картинке, то есть программа строит красную линию близкую к синусу.

Подскажите, пожалуйста, каким показателем измеряется точность аппроксимирующей модели по отношению к точкам из выборки? То есть за счет какого показателя можно сказать какой из методов лучше первый или второй? Я думал, что буду использовать коэффициент корреляции Пирсона, но я прочитал, что он плохо подходит для кривых аппроксимирующих, ибо коэффициент работает только для прямых.

А каким показателем тогда оценивать точность модели? Дисперсией? Корнем из дисперсии? Коэффициентом корреляции Спирмена? Может есть какой-нибудь волшебный коэффициент детерминации для кривых?

Стандарт для регрессии - среднеквадратичная ошибка. Это оптимальная оценка, если данные сгенерированы твоей моделью с аддитивным гауссовским шумом.

Благодарю

Детекция позы человека нейроночкой. Делает полный маппинг текстуры обобщенного человека на картинку. Можно, например, голые тела маппить на людей в видео. Мы стали на шаг ближе к раздевающим очкам.

> Можно, например, голые тела маппить на людей в видео. Мы стали на шаг ближе к раздевающим очкам.

Фейковое ЦП, ну наканецта!

Ну если про CV говорить, то там достаточно очевидно что можно аппроксимировать. Это как разложение в ряды Тейлора. Над просто побольше параметров захуярить, чтоб аппроксимация соответствовала функции с ошибкой меньше эпсилон.

58 Кб, 555x469

58 Кб, 555x469Никогда не слышал, чтобы такое реализовывали. Речь, по-сути, о том, чтобы в методе группового учета аргументов процесс порождения кандидатов на лучшую функцию представить чем-то уровня пикрелейтед, а саму функцию (в оригинале - частные полиномы от полного степенного) заменить на регуляризованную SVM. Т.о. последовательно будет строиться SVM, в которой как вид функций, так и параметры будут настраиваться исходя из подходящих критериев (н-р, наилучшей экстраполяции построенной модели на данные, далекие от тренировочных).

сказал рекурсивный программист

Перечитай определение нейронной сети. Их суть и смысл - приближение некоторой функции. Уже обученная нейронная сеть, по сути своей, и является функцией из множества возможных входных данных в возможных возможных выходных данных.

Никогда, кстати, не понимал, с какого хуя все ограничивают себя 3-4 стандартными функциями на нейронах, да ещё и функции эти друг на друга слишком сильно похожи.

Нет бы запилить старый добрый синус и посмотреть, что получится

385 Кб, 849x1200

385 Кб, 849x1200Кто из вас зарабатывает при помощи ИИ и если да, то как именно?

Ну в svm итд используются ядра преобразования входных данных (кернелы), причём их класс очень большой, по-сути это любая функция, удовлетворяющая требованиям теоремы Мерсера. Это уже лучше, вот только выбор ядра остаётся за пользователем и по-сути есть простое шаманство, выбираешь или пишешь ядро, натягиваешь на него сову и смотришь что получится. По уму нужен алгоритм подбора кернела, в т.ч в виде суперпозиции симметричных функций, исходя из качества аппроксимации или классификации данных за пределами тренировочных. Но тут опять же, лучше лямбды сложно что-то придумать.

Я даже не знаю в какой сфере их можно применять промышленно. Только разработка ведь.

> Вот подскажите мне, обязательно ли заканчивать университет, чтобы стать великим гуру в сфере нейроничков и машоба?

Без бамажки на РАБоту не возьмут и хипстеры с пхд засмеют. Самому можно разобраться, но на практике мотивации не хватит, в универе хоть заставят что-то учить, а сам просто дропнешь через пару месяцев.

Ты с кем разговариваешь?

> Сраная биржа это самодестабилизирующаяся система

Сраная биржа - это не то, чем она кажется простому обывателю. И манямодели, построенные по её представлению для простого обывателя соснут обязательно. Их предел в таком варианте - механизация скальподрочерства, упирающееся в интернет-канал.

Если в нейросеточки инсайдерскую информацию подавать, причем которая обычно или "государственные тайна" или "коммерческая тайна" - то нейросетки тут же сосать перестанут.

Ну, допустим, применительно к биткоину, какая может быть инсайдерская информация? Просто некто с большим капиталом шатает курс в целях извлечения выгоды, или просто хацкер сливает битки, мелочь пытается эти события ванговать и тоже извлечь прибыль.

Ты предлагаешь на вход нейросети подавать желания всех игроков? Ну тогда задача предсказания будет очень простой.

>>32687

Начнём с того, что суть теханализа в том, что все, важное для рынка отражается на курсе, капитализации, объёме продаж и тп первичных данных, доступных для анализа. Это же касается и инсайдерской информации. Например, захотели рептилоиды пошатать курс, сделали для этого что-то с объёмами продаж, капитализацией итп, курс пошатался. Т.е есть готовая закономерность изменения курса, функция, которую можно идентифицировать. Похуй, что нам доподлинно неизвестно, кто и для чего шатал курс, но нам известны объективные показатели рынка и их взаимосвязи.

> Т.е. теханализ изначально предполагает стационарность этих связей? Лол

Теханализ предполагает их наличие. Стационарности или динамичность нельзя предполагать априори, их можно получить только из самих данных.

Я говорю о том, что для идентификации системы таких предположений не требуется. Так-то никто не запрещает.

В общем случае - от меньшего числа переменных. Думаю, две - наиболее удобный для представления и вычисления вариант.

>все игроки ломятся туда

Какие "все"? Все занимаются тем что строят разнообразные прямые, чтобы воспринимать их пересечение как ЗНАК.

Это нужно у здешних биологодаунов спрашивать, у которых нейросетки - это савсем не нийроны!!

>По уму нужен алгоритм подбора кернела

Ах как было бы хорошо! Ну придумай. Хотя ладно, спалю идею на сто триллионов: придумай алгоритм, который сконструировал бы данный алгоритм. И думать не надо. Ах как хорошо!

Есть массив из 30 значений на входе и попытка предсказания следующих 5 на выходе. Соответственно есть хуева гора этих массивов по 35 для тренировки (30 на вход, 5 на выход).

Обычная полновесная нейросеть нормально жрет эту гору и тренируется без проблем (и даже кое-как работает).

А сверточная выебывается на входные данные.

Данные генерирую так:

trainx=[];trainy=[]

for i in train:

trainx.append(i[:30])

trainy.append(i[30:])

x=np.array(trainx)

y=np.array(trainy)

train это та самая гора массивов по 35. Результат:

ValueError: Error when checking input: expected conv1d_1_input to have 3 dimensions, but got array with shape (395049, 30)

395049 примеров по 30 значений. Что сделать чтобы оно заработало?

>30 значений. Что сделать чтобы оно заработало?

либо x = x[:,:, np.newaxis], изменит форму входа на [batch_size, 30, 1], либо x = x[:, np.newaxis] изменит форму входа на [batch_size, 1, 30]. Ну и входные размерности пофиксить.

ты сверточную сеть для картинок взял? бездумно копипастить не прокатит

Для школьников да, для нейроночек нужна вузовская математика.

Не помогает:

ValueError: Error when checking input: expected conv1d_1_input to have shape (None, None, 30) but got array with shape (395049, 30, 1)

Второй выдает (395049, 5)

>Ну и входные размерности пофиксить.

Как?

>Предлагаю переписать шапку, добавив ответов на платину, дедовских и свежих книг и, возможно, списки статей

>Предлагаю переписать шапку, добавив ответов на платину, дедовских и свежих книг и, возможно, списки статей

https://hal.archives-ouvertes.fr/hal-01221226/document

в Conv1d нужно указать input_shape = [30,1], а не просто 30 читай инструкцию к keras.

Какую модель тут лучше взять?

SVM, очевидно же. "Купил/не купил" - 2 класса (1/0), остальное - входные данные. Я бы с такого начал.

>Ах как было бы хорошо! Ну придумай.

Для тебя "генетическое программирование с типизированной лямбдой" набор рандомных слов, я правильно понял?

Это я действительно проглядел но ошибка остается.

Доки говорят что вход должен быть (batch_size, steps, input_dim) и я нифига не понимаю что это значит.

Для Dense вход (batch_size, input_dim) поэтому я предполагаю что batch_size это количество примеров а input_dim это количество значений в примере но что такое steps и как преобразовать входной массив я не понимаю.

Пофапано.

Ну ты хоть трапик, так что можно тебе всё простить. А то достала аватаркофажить повсюду.

385 Кб, 849x1200

385 Кб, 849x1200просто ты изрващенец, приследуешь меня и следишь за мной везде ^^

Ну че ты сразу ругаешься, а?

1) explained variance score

2) mean squared log error - я думал, что это "средняя квадратичная логарифмическая ошибка", но загуглил такое сочетание слов и оказалось, что его не существует. Ещё помогите пожалуйста с mean squared log error, как правильно перевести error как ошибку или как погрешность?

2) Это точно "ошибка", перевод кажется правильным.

1) Вроде, объясненная дисперсия. С русскоязычными тяжело сравнивать, ибо на русском там формулы для мат. статистики и теории вероятности. А в sklearn формулы для y и y с крышечкой.

2) В другом треде советуют, что error - это отклонение.

Ну то есть я неправильно выразился, короче, на русском определения для ВУЗовских предметов, а в sklearn для машинного обучения. И так как я умственно отсталый, то не осилил сравнить эквивалентность формул.

На кого ты учишься, что в гугл не можешь и про педивикию не слышал?

https://en.wikipedia.org/wiki/Explained_variation

https://www.kaggle.com/marknagelberg/rmsle-function

>помогите пожалуйста с mean squared log error, как правильно перевести error как ошибку или как погрешность?

Еррор - это еррор. Перевести можно как "ошибка", разумеется. Русский язык слишком могучий, поэтому переводят как хотят - ошибка, погрешность, отклонение, невязка итд.

Спасибо, я плох в английским, поэтому не смог такую хорошую ссылку найти как вторую которую ты дал.

Или на харкаче только хайпомакаки вместо самих разработчиков?

можно, но ненужно

15 Кб, 337x153

15 Кб, 337x153нейронками в основном решают задачи классификации и регрессии, и часто бывает что в интеллектуальных системах эти задачи визникают и их можно решить в том числе и нейронками.

39 Кб, 774x533

39 Кб, 774x5331) функция f(x) выражающая количественные характеристики первого вещества, где характеристика "у" зависит от количественной характеристики "х" по закону f(x)

2) есть второе вещество с такими же количественными характеристиками "х" и "у", но "у" от "х" зависит уже по закону g(x)

3)А потом первое и второе вещество смешали в пропорции 40% на 60% и получился третий закон для смешанного вещества h(x).

Подскажите, пожалуйста, есть ли методы машинного обучения позволяющие по законам f(x), g(x), h(x) и по величине пропорций веществ определить как закон смешанного вещества h(x) выражается через первые два g(x) и f(x)?

Ну например, допустим, что окажется, что h(x) = 0.4f(x) + 0.6g(x). То есть ли методы машинного обучения позволяющие эту зависимость h(x) от f(x) и от g(x) выявить?

> есть ли методы машинного обучения позволяющие эту зависимость h(x) от f(x)и от g(x) выявить?

Это вопрос представления данных. Алгоритм почти любой сойдёт. По-сути у тебя речь об идентификации системы, нахождении зависимости вида y = f(x1, x2), где y это h(x), x1 это f(x), x2 - g(x). Собираешь датасет из 3х столбцов, строки которого - h(x), f(x), g(x) при разных концентрациях и подсовываешь чему угодно, хоть svm.

О, прикольно, спасибо большое

Очень классно, спасибо огромное ещё раз, ну ты жесткий тип))

1. Товаров много а просто скармливать значения по всем не выйдет - сеть же с памятью. Как лучше сделать? Можно просто в лоб создать несколько сетей для каждого товара но может есть варианты получше? Слышал что можно вытащить не только ответ но и внутреннее состояние сети.

2. В последовательности довольно много нулей (цена без изменений). Если просто выкинуть все нули то может ли это негативно повлиять на точность предсказания?

Я тута чуть выше вскрывал тему, почему весь вообще машобчик люто, бешено сосёт в предсказании временных рядов, и почему никакая мегагитлер нейроночка на мегагитлер кластере для этой задачи не лучше дубового arima из прошлого века. Поэтому лично я в качестве алгоритма взял бы svm, там хотя бы теоретически обосновано, почему при правильном использовании результат будет лучшим на конечном датасете.

> 1. Товаров много а просто скармливать значения по всем не выйдет - сеть же с памятью. Как лучше сделать? Можно просто в лоб создать несколько сетей для каждого товара но может есть варианты получше? Слышал что можно вытащить не только ответ но и внутреннее состояние сети.

Отдельная модель для каждой системы, т.е товара. Если не хочешь предсказания уровня среднего анализа мочи по больничке.

> 2. В последовательности довольно много нулей (цена без изменений). Если просто выкинуть все нули то может ли это негативно повлиять на точность предсказания?

Т.е у тебя там дельты цены, разницы между последним и предпоследним значениями? Выкидывать не надо.

Я конечно не пробовал ни arima ни svm но обычный персептрон более-менее адекватно предсказывал следующее изменение (а вот второе, третье и тд очень херово).

>svm

Есть что почитать про это? Нашел только какие-то дикие формулы при полном отсутствие примеров.

>Т.е у тебя там дельты цены, разницы между последним и предпоследним значениями? Выкидывать не надо.

Да, дельты. Выглядеть может примерно так:

-0.2 0.0 0.0 0.0 0.0 0.0 0.0 0.5 0.0 -0.1 0.0 -0.4 0.0 0.0 0.0 0.7 0.0

Вообще интересуют именно следующие движения, а когда они будут - через 2 шага или через 10 - пофиг.

В принципе, если перцептрон устраивает, то им и пользуйся, SVM вещь крайне годная, но матчасть там страшновата, да. Лучшая реализация с либами для всех ЯП https://www.csie.ntu.edu.tw/~cjlin/libsvm/ там же пейперы и примеры.

>Выглядеть может примерно так: -0.2 0.0 0.0 0.0 0.0 0.0 0.0 0.5 0.0 -0.1 0.0 -0.4 0.0 0.0 0.0 0.7 0.0

Из временного ряда лучше сделать матрицу Ганкеля столбца в 4, и уже строки из нее подавать алгоритму по типу 4столбец = f(3,2,1).

Перцептрон не совсем устраивает тк предсказывает только на шаг вперед, мне бы на 3-5 шагов.

В sklearn есть и свм и документация и примеры. Там и попробую.

>Из временного ряда лучше сделать матрицу Ганкеля столбца в 4, и уже строки из нее подавать алгоритму по типу 4столбец = f(3,2,1).

Я не совсем понимаю зачем и честно говоря не знаю как. Нужно будет входные данные преобразовать в такую матрицу, изменить input_shape под нее, (4, 4) вроде как? Что такое f(3,2,1)?

У lstm один из плюсов это то что можно по одному значению подавать на вход и получать результат.

>Я не совсем понимаю зачем и честно говоря не знаю как. Нужно будет входные данные преобразовать в такую матрицу, изменить input_shape под нее, (4, 4) вроде как? Что такое f(3,2,1)?

Например, у тебя есть временной ряд из 10 значений - 1 2 3 4 5 6 7 8 9 10. Нужно построить матрицу вида:

1 2 3 4

2 3 4 5

3 4 5 6

4 5 6 7

5 6 7 8

6 7 8 9

7 8 9 10

Далее, последняя колонка используется как выход у, первые 3 - как вход х. Такая схема для временных рядов практически идеальна для идентификации систем. Ну а матрицу Ганкеля из временного ряда можно строить автоматически, это есть на каждом углу, в пистоне уж точно есть https://docs.scipy.org/doc/scipy-0.14.0/reference/generated/scipy.linalg.hankel.html LSTM тоже можешь пробовать, но я очень сомневаюсь, что любой метод даст 500% качества от перцептрона (5 шагов вперед вместо 1), хотя если сама система там несложная, то мб, но это надо пробовать все подряд и смотреть что лучше.

Еще вариант - построить 5 моделей, каждая из которых будет предсказывать на определенное кол-во шагов вперед. Но тогда соотв. образом должны быть сделаны датасеты (выход должен быть соотв-но следующий шаг, потом второй, третий, 4ый и 5ый). Это можно следать с перцептроном, ты ж говоришь, что на 1 шаг вперед точно предсказывает, тут то же, только вместо одного у тебя будет 5 перцептронов. Это аутизм, конечно, но мб и поможет, машобчик то еще шаманство вприсядку с бубном.

Теперь понял. У меня примерно так и есть.

Для 5 шагов с перцептроном скорее подойдет вариант добавления предсказанного шага в входную последовательность (как я понял в LSTM это так и работает).

Перцептрон плохо предсказывает на более чем 1 шаг (пробовал), скорее всего именно потому что пытается предсказать не глядя на предсказание предыдущего. Под плохо я имею ввиду что-то вроде -0.002 при любом вводе.

Временные ряды вообще довольно гиблое дело. Чувак выше дельный совет дал - попробуй ARIMA для начала, хотя бы как бейзлайн. То, что изменение цены происходит лишь иногда, сильно ухудшает прогноз. Вряд ли хоть какой-то метод тебе предскажет, что мол через три дня будет +5. Тут тебе кроме цены нужны другие факторы, которые влияют на нее.

На LSTM я бы сильно не расчитывал в данной ситуации. Поиграться можно, но вряд ли это даст результат.

Ещё хуже, старье из 00х

нетъ

Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX AVX2

В интернетах советуют либо забить на это либо компилить весь TensorFlow целиком.

Неужели нет скомпилированных вариантов с этими инструкциями?

>>38392

Я еще играюсь но LSTM дает довольно таки неплохие результаты. Конечно ошибается в отдельных шагах но в целом предсказания дает похожие на правду.

Если с английским так себе, то можно пройти бесплатный трехнедельный курс про нейронные сети на русском:

https://stepik.org/course/401

Там чисто базовый алгем, матан и самые основы нейронных сетей.

1,6 Мб, webm,

1,6 Мб, webm,640x360, 0:18

Сап искусственные интеллекты. Как сделать так чтобы на вход нейроночки подавать флоат с двумя знаками после точки от -5 до 5, а на выход получать интежер от 0 до 99?

>Насколько сложно написать свою реализацию без тензорфлоу?

Написать свою реализацию - хуйня по сравнению с используеванием этого вашего тензорфлоу. Пиздец, как долго я его пытаюсь задрочить, а нихуя не выходит.

Со следующей версии вроде обещали компилить сразу с этими инструкциями, пока только самому.

Тарик Рашид - Создаем нейронную сеть

Как раз про самые основы и создание своей сети почти с нуля.

В написании статей с хайповым названием и зарабатывании на этом цитирований и респекта.

Очень плохо.

А если серьезно?

Мне в голову пришла еще разве что хемоинформатика с предсказыванием структуры молекул.

> Мне в голову пришла еще разве что хемоинформатика с предсказыванием структуры молекул.

Это не физика. Если про молекулы заговорили, машобчик можно использовать для классификации геномов. Правда, там разного рода хитрая кластеризация, а не эти ваши нейроночки. Попадалось немного работ на эту тему, местами весьма круто, можно прямо филогенетические графы строить по степени близости видов, кто от кого произошёл, и все это как обучение без учителя. Противники эволюции сгорели бы дотла от батрушки, но к счастью для них, они дегенераты и не поймут подобных работ. По структурно-функциональным зависимостям молекул тоже попадались пейперы, самый интересный про карты Кохонена с взвешенной кросскорелляцией в качестве метрики (вместо обычной для этих алгоритмов евклидовой). Автор - голландский химик, написал не только статью, но и реализацию этого алгоритма в виде либы wccsom для R.

Знают ли анонимные эксперты справляется ли random forest с такими данными, где какие-то две фичи, применяемые по отдельности, не дают результата, а их совместное применение дают огромную синергию?

Само собой, я могу просто нагенерить синтетических данных и проверить, но я буду это делать 2-3 часа, а анонимные эксперты может быть УЖЕ такие опыты проводили

Во первых catboost это градиентный бустинг на деревьях решений, во вторых деревья решений, который обычно используются не могут видеть связи между признаками.

Я не про (A-B), я про (A>=C)&(B>=D)

> градиентный бустинг на деревьях решений

градиентный бустинг, как я понимаю, это алгоритм обучения, а не устройство сети. Совокупность деревьев решений называется лесом, то есть random tree forest

>За черным квадратом стоит большая идея, просветись.

"Большую идею" придумали "критики" после увиденного. Если бы ты не знал, что указанные картинки нарисовали нейросети, а какой-нибудь художник, ты бы тоже в них начал искать идею.

бустинг и бэггинг принципиально разные вещи (ансамбли), в catboost действительно есть лес (смысле графов), но прицип работы принципиально другой, если в random forest дерьвья слабо коррелированы, то в градиентном бустинге каждое следующее дерево зависит от всех предыдущих. И как в одном так и в другом деревья могут быть каким-нубудь CART.

> в градиентном бустинге каждое следующее дерево зависит от всех предыдущих

Оба-на. Я думал, что каждое отдельное дерево обучается само и не связано с другими. Спасибо

>деревья решений, который обычно используются не могут видеть связи между признаками

Это не так. Если глубина больше 1, то вполне себе видят. Очевидно же, что модель, не видящая связей между признаками, крайне ограничена, и не сможет решить даже совсем простые задачи, например XOR.

XOR (как и NOT, AND, OR) решается заучиванием, а не аналитическим разбором

Ты бы для начала википедию прочитал:

There are concepts that are hard to learn because decision trees do not express them easily, such as XOR, parity or multiplexer problems. In such cases, the decision tree becomes prohibitively large. Approaches to solve the problem involve either changing the representation of the problem domain (known as propositionalization)[21] or using learning algorithms based on more expressive representations (such as statistical relational learning or inductive logic programming).

>либа для R

>не ставится без питона

А для софта на С у вас в зависимостях паскаль или гиви бейсик? А почему вместе с этой либой яндекс браузер не ставится, и яндекс-панель во все установленные браузеры?

Имею небольшой мат бэкграунд. Не хочу заниматься нейроночками, потому что они из всех щелей лезут. Нравятся обычные алгоритмы, например для обработки большого объёма данных. Не откажусь от всяких анализов текстов.

Как называется этот раздел и что упарывать? Заранее спасибо.

> Нравятся обычные алгоритмы, например для обработки большого объёма данных.

Data mining.

> Не откажусь от всяких анализов текстов.

NLP, natural language processing

> Как называется этот раздел и что упарывать? Заранее спасибо.

Будешь смеяться, но топовые алгоритмы для NLP это нейроночки - skipgram, cbow, glove модели. Ищи реализацию под нужный тебе яп таких вещей как fasttext, word2vec, text2vec и кури документацию и оригинальные пейперы.

Под хаскель научных либ мало, а так добро.

> Поясните чем глубокое обучение отличается от простого обучения?

В глубоком стыкованные алгоритмы неглубокого. Пример - аутоэнкодер это простое обучение, стыкованный аутоэнкодер - глубокое.

36 Кб, 650x586

36 Кб, 650x586Блэн, все равно ничего не понял, ну ладно.

не менее пяти 5

Спасибо! Попробую переписать.

Сап

Есть одна нейронка, она работает, но в моем грузится почти 10 минут.

Вопрос: как делают чтобы все работало быстро и не грузилось каждый раз по пол часа при запуске скрипта? Может можно сохранить результат обучения или еще какие то хитрости?

Смотри короче, суть такова. При неглубоком обучении особенности(фичи) по которым будет проходить обучение выбираешь ты, а при глубоком система сама обучается их выделять. Например фильтры в свёрточных сетях. В целом архитектуру тех же сетей ты всё равно выбираешь, поэтому на эти разделения можно хуй положить.

76 Кб, 1280x720

76 Кб, 1280x720>Может можно сохранить результат обучения

Ты чё, каждый раз сбрасываешь все конфициенты и заново учишь сеть? Ты ебобо?

А какие книжки можно почитать про идентификацию систем?

Я. Продаю футболки с красивым принтом "ИИ близко, спасайтесь люди"

Для понимания, решил начать с написания собственной простенькой нейросети (посоветуйте элементарный пример с минимумом нейронов, который можно воплотить), пока не получилось, проблема, судя по всему с математикой, я не понял по какой формуле нужно аджастить вес чтобы оно нормально училось, но надеюсь, разберусь. В шапке ссылки, блин, оно хорошо, но из опыта знаю, что прям сильно глубоко разбираться, сразу не пробуя на практике - говно, я так по Java 2 тома прочитал, в итоге на моем уровне и половина не требуется.

Короче, если знаете ссылку (можно англ), где разжовывается элементарная, но имеющая смысл нейросеть, то поделитесь, плз. Разберусь с вами или без вас.

Deeplearningbook (первая ссылка из оппоста) это то, что тебе надо. То, что ты просишь, аналогично "я не хочу сейчас глубоко изучать умножение, просто объясните, почему 2х2=4". Ну разберешься ты с элементарной нейроночкой (что это такое вообще? Перцептрон?), а дальше что? Элементарные нейроночки - сюрприз - не работают. Обучаются медленно и плохо. Работает глубокое обучение, которое не элементарно. Не трать время на перелопачивание говн мамонта, сразу учи то, что нужно.

>сразу не пробуя на практике

Вторая ссылка из оппоста.

И, если ты вдруг не в курсе, то нейроночки уже давно играют в арканоид и многое другое. Как с помощью обучения с подкреплением, так и на генетических алгоритмах. На гитхабе полно примеров. Только обучается это очень долго - пару суток на 1080ти как минимум, на ЦПУ забудь.

На stepik.org есть очень доступный курс, там как раз во всех подробностях рассказывают про алгоритм обратного распространения ошибки и градиентный спуск.

Какая структура для такой нейронки подойдет? Сколько входов надо сделать?

Свёрточные.

гугли keras

Потрогал dnn в опенсв, качество распознавания из говна, хожу чем у HOG+SVM.

нашел джва проеба на пикче, а какой же будет пиздец в реале

>>49957

На диплом взял робомобиль лол)))

Думал, что сейчас возьму обученную сетку и без задней мысли найду всех пешеходов, а потом сверху наверну разных методов принятия решений и зарулю как царь.

Но Че то надужной ОБУЧЕННОЙ сетки для детекта пешеходов не нашел.

Pedestrian detection, и MOT это целая проблема похоже.

Как итерация нейронной сети может передавать значения предыдущей вообще?

И тред с собой прихвати.

Квантовые компьютеры основаны на квантовых битах или кубитах. Они также имеют два возможных значения, которые мы можем назвать 0 и 1. Но законы квантовой механики также допускают другие значения, которые мы называем состояниями суперпозиций.

В каком-то смысле состояния суперпозиции представляют собой значения, которые существуют между крайностями 0 и 1. Мы можем представить кубит как сферу, причем 0 и 1 расположены на противоположных полюсах. Состояния суперпозиции — все остальные возможные точки на поверхности.

https://habrahabr.ru/company/mailru/blog/350208/

Интересно, доживу я до того момента, когда квантовое наебалово вскроется, или нет.

As a change of pace from my current Oculus work, I wanted to write some from-scratch-in-C++ neural network implementations, and I wanted to do it with a strictly base OpenBSD system. Someone remarked that is a pretty random pairing, but it worked out ok.

Despite not having actually used it, I have always been fond of the idea of OpenBSD — a relatively minimal and opinionated system with a cohesive vision and an emphasis on quality and craftsmanship. Linux is a lot of things, but cohesive isn’t one of them.

I’m not a Unix geek. I get around ok, but I am most comfortable developing in Visual Studio on Windows. I thought a week of full immersion work in the old school Unix style would be interesting, even if it meant working at a slower pace. It was sort of an adventure in retro computing — this was fvwm and vi. Not vim, actual BSD vi.

In the end, I didn’t really explore the system all that much, with 95% of my time in just the basic vi / make / gdb operations. I appreciated the good man pages, as I tried to do everything within the self contained system, without resorting to internet searches. Seeing references to 30+ year old things like Tektronix terminals was amusing.

I was a little surprised that the C++ support wasn’t very good. G++ didn’t support C++11, and LLVM C++ didn’t play nicely with gdb. Gdb crashed on me a lot as well, I suspect due to C++ issues. I know you can get more recent versions through ports, but I stuck with using the base system.

In hindsight, I should have just gone full retro and done everything in ANSI C. I do have plenty of days where, like many older programmers, I think “Maybe C++ isn’t as much of a net positive as we assume...”. There is still much that I like, but it isn’t a hardship for me to build small projects in plain C.

Maybe next time I do this I will try to go full emacs, another major culture that I don’t have much exposure to.

I have a decent overview understanding of most machine learning algorithms, and I have done some linear classifier and decision tree work, but for some reason I have avoided neural networks. On some level, I suspect that Deep Learning being so trendy tweaked a little bit of contrarian in me, and I still have a little bit of a reflexive bias against “throw everything at the NN and let it sort it out!”

In the spirit of my retro theme, I had printed out several of Yann LeCun’s old papers and was considering doing everything completely off line, as if I was actually in a mountain cabin somewhere, but I wound up watching a lot of the Stanford CS231N lectures on YouTube, and found them really valuable. Watching lecture videos is something that I very rarely do — it is normally hard for me to feel the time is justified, but on retreat it was great!

I don’t think I have anything particularly insightful to add about neural networks, but it was a very productive week for me, solidifying “book knowledge” into real experience.

I used a common pattern for me: get first results with hacky code, then write a brand new and clean implementation with the lessons learned, so they both exist and can be cross checked.

I initially got backprop wrong both times, comparison with numerical differentiation was critical! It is interesting that things still train even when various parts are pretty wrong — as long as the sign is right most of the time, progress is often made.

I was pretty happy with my multi-layer neural net code; it wound up in a form that I can just drop it into future efforts. Yes, for anything serious I should use an established library, but there are a lot of times when just having a single .cpp and .h file that you wrote ever line of is convenient.

My conv net code just got to the hacky but working phase, I could have used another day or two to make a clean and flexible implementation.

One thing I found interesting was that when testing on MNIST with my initial NN before adding any convolutions, I was getting significantly better results than the non-convolutional NN reported for comparison in LeCun ‘98 — right around 2% error on the test set with a single 100 node hidden layer, versus 3% for both wider and deeper nets back then. I attribute this to the modern best practices —ReLU, Softmax, and better initialization.

This is one of the most fascinating things about NN work — it is all so simple, and the breakthrough advances are often things that can be expressed with just a few lines of code. It feels like there are some similarities with ray tracing in the graphics world, where you can implement a physically based light transport ray tracer quite quickly, and produce state of the art images if you have the data and enough runtime patience.

I got a much better gut-level understanding of overtraining / generalization / regularization by exploring a bunch of training parameters. On the last night before I had to head home, I froze the architecture and just played with hyperparameters. “Training!” Is definitely worse than “Compiling!” for staying focused.

Now I get to keep my eyes open for a work opportunity to use the new skills!

I am dreading what my email and workspace are going to look like when I get into the office tomorrow.

As a change of pace from my current Oculus work, I wanted to write some from-scratch-in-C++ neural network implementations, and I wanted to do it with a strictly base OpenBSD system. Someone remarked that is a pretty random pairing, but it worked out ok.

Despite not having actually used it, I have always been fond of the idea of OpenBSD — a relatively minimal and opinionated system with a cohesive vision and an emphasis on quality and craftsmanship. Linux is a lot of things, but cohesive isn’t one of them.

I’m not a Unix geek. I get around ok, but I am most comfortable developing in Visual Studio on Windows. I thought a week of full immersion work in the old school Unix style would be interesting, even if it meant working at a slower pace. It was sort of an adventure in retro computing — this was fvwm and vi. Not vim, actual BSD vi.

In the end, I didn’t really explore the system all that much, with 95% of my time in just the basic vi / make / gdb operations. I appreciated the good man pages, as I tried to do everything within the self contained system, without resorting to internet searches. Seeing references to 30+ year old things like Tektronix terminals was amusing.

I was a little surprised that the C++ support wasn’t very good. G++ didn’t support C++11, and LLVM C++ didn’t play nicely with gdb. Gdb crashed on me a lot as well, I suspect due to C++ issues. I know you can get more recent versions through ports, but I stuck with using the base system.

In hindsight, I should have just gone full retro and done everything in ANSI C. I do have plenty of days where, like many older programmers, I think “Maybe C++ isn’t as much of a net positive as we assume...”. There is still much that I like, but it isn’t a hardship for me to build small projects in plain C.

Maybe next time I do this I will try to go full emacs, another major culture that I don’t have much exposure to.

I have a decent overview understanding of most machine learning algorithms, and I have done some linear classifier and decision tree work, but for some reason I have avoided neural networks. On some level, I suspect that Deep Learning being so trendy tweaked a little bit of contrarian in me, and I still have a little bit of a reflexive bias against “throw everything at the NN and let it sort it out!”

In the spirit of my retro theme, I had printed out several of Yann LeCun’s old papers and was considering doing everything completely off line, as if I was actually in a mountain cabin somewhere, but I wound up watching a lot of the Stanford CS231N lectures on YouTube, and found them really valuable. Watching lecture videos is something that I very rarely do — it is normally hard for me to feel the time is justified, but on retreat it was great!

I don’t think I have anything particularly insightful to add about neural networks, but it was a very productive week for me, solidifying “book knowledge” into real experience.

I used a common pattern for me: get first results with hacky code, then write a brand new and clean implementation with the lessons learned, so they both exist and can be cross checked.

I initially got backprop wrong both times, comparison with numerical differentiation was critical! It is interesting that things still train even when various parts are pretty wrong — as long as the sign is right most of the time, progress is often made.

I was pretty happy with my multi-layer neural net code; it wound up in a form that I can just drop it into future efforts. Yes, for anything serious I should use an established library, but there are a lot of times when just having a single .cpp and .h file that you wrote ever line of is convenient.

My conv net code just got to the hacky but working phase, I could have used another day or two to make a clean and flexible implementation.

One thing I found interesting was that when testing on MNIST with my initial NN before adding any convolutions, I was getting significantly better results than the non-convolutional NN reported for comparison in LeCun ‘98 — right around 2% error on the test set with a single 100 node hidden layer, versus 3% for both wider and deeper nets back then. I attribute this to the modern best practices —ReLU, Softmax, and better initialization.

This is one of the most fascinating things about NN work — it is all so simple, and the breakthrough advances are often things that can be expressed with just a few lines of code. It feels like there are some similarities with ray tracing in the graphics world, where you can implement a physically based light transport ray tracer quite quickly, and produce state of the art images if you have the data and enough runtime patience.

I got a much better gut-level understanding of overtraining / generalization / regularization by exploring a bunch of training parameters. On the last night before I had to head home, I froze the architecture and just played with hyperparameters. “Training!” Is definitely worse than “Compiling!” for staying focused.

Now I get to keep my eyes open for a work opportunity to use the new skills!

I am dreading what my email and workspace are going to look like when I get into the office tomorrow.

Не срать в нейроночкотреде тоже просто, а вот ты не справился. Так и везде.

>Реально ли самому заработать авторитет на кэгле и устроится на работу показав работодателю место?

Если только у тебя есть 3-5 лет опыта как программиста.

> Но чаще функции и их суперпозиции, описывающие систему, неизвестны.

Неправда. Неизвестны все переменные. Но все переменные и не нужно знать достаточно только тех, знание которых позволяет построить функциональную зависимость между ними и результатом с необходимой точностью. Это имеет место быть в большинстве процессов, если не касаться процессов связанных с человеческим поведением, но даже там есть вполне конкретные взаимосвязи (психоанализ и ежи с ним).

>Помимо этого есть ещё неустранимая неточность, которая в общем случае к вероятности не сводится.

Ложь. Любая неточность, читай ошибка, сводится к плотности распределения вероятности этой ошибки. Для этого достаточно наблюдать процесс долгое время. Ты не знаешь составляющих ошибки, но саму ошибку с точки зрения вероятности описать можно как и ее динамику. Исключения только те процессы, которые не могут быть наблюдаемыми.

>Но это всегда будет аппроксимация неизвестных функций всякой хуетой, которая даёт удовлетворительную точность только на обучающих данных. При уже минимальной экстраполяции получается хуйня, т.к реально функции не те.

Верно. При отсутствие реальной (то есть физической) математической модели, хотя бы приближенной, то любая экстраполяция может соснуть, если только не рассматриваются тривиальные модели типа ортогональных функций.

>И вот на этот момент всем похуй

Ага, то-то научные эксперименты существуют. Вы вообще хотя бы гуглили эту "проблему"?

>И лично мне не известен ни один подход в машобе, который бы ставил вопрос идентификации реальных законов системы, а не его аппроксимацию левыми функциями.

Потому что это не задача машинного обучения? Насколько я знаю искусственный интеллект еще далёк от понимания абстракций, что является основой для любой научной деятельности. Вы наверное не в курсе.. Но то что вы написали

>идентификации реальных законов системы

это как раз задача исследователей, а не нейронной сети.

>решения не будет, потому что проблема не ставится во всей её полноте.

Не знаю по поводу индусов и прочих, но здесь соглашусь: неправильное определение проблемы одна из самых распространенных ошибок в любой сфере деятельности.

> Но чаще функции и их суперпозиции, описывающие систему, неизвестны.

Неправда. Неизвестны все переменные. Но все переменные и не нужно знать достаточно только тех, знание которых позволяет построить функциональную зависимость между ними и результатом с необходимой точностью. Это имеет место быть в большинстве процессов, если не касаться процессов связанных с человеческим поведением, но даже там есть вполне конкретные взаимосвязи (психоанализ и ежи с ним).

>Помимо этого есть ещё неустранимая неточность, которая в общем случае к вероятности не сводится.

Ложь. Любая неточность, читай ошибка, сводится к плотности распределения вероятности этой ошибки. Для этого достаточно наблюдать процесс долгое время. Ты не знаешь составляющих ошибки, но саму ошибку с точки зрения вероятности описать можно как и ее динамику. Исключения только те процессы, которые не могут быть наблюдаемыми.

>Но это всегда будет аппроксимация неизвестных функций всякой хуетой, которая даёт удовлетворительную точность только на обучающих данных. При уже минимальной экстраполяции получается хуйня, т.к реально функции не те.

Верно. При отсутствие реальной (то есть физической) математической модели, хотя бы приближенной, то любая экстраполяция может соснуть, если только не рассматриваются тривиальные модели типа ортогональных функций.

>И вот на этот момент всем похуй

Ага, то-то научные эксперименты существуют. Вы вообще хотя бы гуглили эту "проблему"?

>И лично мне не известен ни один подход в машобе, который бы ставил вопрос идентификации реальных законов системы, а не его аппроксимацию левыми функциями.

Потому что это не задача машинного обучения? Насколько я знаю искусственный интеллект еще далёк от понимания абстракций, что является основой для любой научной деятельности. Вы наверное не в курсе.. Но то что вы написали

>идентификации реальных законов системы

это как раз задача исследователей, а не нейронной сети.

>решения не будет, потому что проблема не ставится во всей её полноте.

Не знаю по поводу индусов и прочих, но здесь соглашусь: неправильное определение проблемы одна из самых распространенных ошибок в любой сфере деятельности.

> Ложь. Любая неточность, читай ошибка, сводится к плотности распределения вероятности этой ошибки. Для этого достаточно наблюдать процесс долгое время. Ты не знаешь составляющих ошибки, но саму ошибку с точки зрения вероятности описать можно как и ее динамику. Исключения только те процессы, которые не могут быть наблюдаемыми.

Я же приводил пример - временные ряды, пусть цена валюты. У нас есть сколько угодно исторических данных, какой-нибудь архив truefx за пару лет с миллисекундным разрешением. Это достаточно долгое наблюдение за процессом, чтобы вычислить плотности вероятности всех его составляющих (т.к процесс недетерминированный, только о них и можно говорить). И что, даст нам это возможность прогнозировать процесс хотя бы на минуту вперёд и хотя бы в виде прогноза "больше - меньше текущего значения"? Нет. Можно изьебываться как угодно, построить любую модель, все равно результат будет плачевный. Вопрос - почему? Ведь у нас есть все для вычисления.

> Неправда. Неизвестны все переменные. Но все переменные и не нужно знать достаточно только тех, знание которых позволяет построить функциональную зависимость между ними и результатом с необходимой точностью. Это имеет место быть в большинстве процессов, если не касаться процессов связанных с человеческим поведением, но даже там есть вполне конкретные взаимосвязи (психоанализ и ежи с ним).

На примере временных рядов очень легко увидеть, что это не так, и что сколь угодно точная аппроксимация не экстраполируется вообще никак. Опять же вопрос - почему?

> Потому что это не задача машинного обучения?

Это как раз самая что ни на есть задача машинного обучения. Но в такой форме её не ставил никто кроме Ивахненко.

>Я же приводил пример - временные ряды, пусть цена валюты. У нас есть сколько угодно исторических данных, какой-нибудь архив truefx за пару лет с миллисекундным разрешением. Это достаточно долгое наблюдение за процессом, чтобы вычислить плотности вероятности всех его составляющих (т.к процесс недетерминированный, только о них и можно говорить). И что, даст нам это возможность прогнозировать процесс хотя бы на минуту вперёд и хотя бы в виде прогноза "больше - меньше текущего значения"? Нет. Можно изьебываться как угодно, построить любую модель, все равно результат будет плачевный. Вопрос - почему? Ведь у нас есть все для вычисления.

Для вычисления ошибки модели? Ведь именно про нее я и написал. Если так, то да. Конечно. Сравнивая значения реальных данных (те самые котировки) и значения полученные с помощью созданной мат. модели мы можем получить невязку и ее статистические характеристики. Это позволит нам правильно выбрать уровень доверия" к выбранной модели.

>Нет. Можно изьебываться как угодно, построить любую модель, все равно результат будет плачевный. Вопрос - почему? Ведь у нас есть все для вычисления.

Для вычисления невязки - да. Для предсказания того как поведет себя процесс в будущем? На самом деле тоже да. Построив плотность распределения вероятности мы сможем сказать, что вероятность того, что завтра доллар будет стоить 36 рублей маловероятно*. Это связано с тем, что настолько резкое изменение цены на доллар не характерно, то есть маловероятно. А вот через год это чуть более вероятно. А через 5 лет еще более вероятно. А через 100 лет мы приблизимся к 50/50 - то есть к равновероятному результату, потому что я для простоты решил, что у нас ПРВ нормальная. НО это будет справедливо для выбранной модели, которая основана только на статистическом анализе процесса изменения цены. Я думаю очевидно, что этого недостаточно для торговли ценными бумагами.

>На примере временных рядов очень легко увидеть, что это не так, и что сколь угодно точная аппроксимация не экстраполируется вообще никак. Опять же вопрос - почему?

Опять таки где вы вообще увидели, что я говорил про аппроксимацию? Я говорил про создание мат. модели имеющую вполне конкретную ошибку и что эту ошибку можно учесть. Аппроксимировать непонятный процесс - это в принципе отчаянный поступок. Нормальные ученные стремятся найти аналитическое решение функции, а не просто нагородить полиномы 20-тых степеней и типа и так сойдет. Я повторяю второй раз - для предсказания нужна математическая модель, которая основана на физическом, реальном мире. У ценообразования доллара есть такая модель. Она написана в учебниках по экономике и психоанализе действий трейдеров. И эта модель не идеальна и не точна, но тем не менее она будет точнее и лучше любого полинома, который был выведен для аппроксимации кривой изменения цены.

>Это как раз самая что ни на есть задача машинного обучения.

Я немного сомневаюсь в этом, но воля ваша так считать.

>Я же приводил пример - временные ряды, пусть цена валюты. У нас есть сколько угодно исторических данных, какой-нибудь архив truefx за пару лет с миллисекундным разрешением. Это достаточно долгое наблюдение за процессом, чтобы вычислить плотности вероятности всех его составляющих (т.к процесс недетерминированный, только о них и можно говорить). И что, даст нам это возможность прогнозировать процесс хотя бы на минуту вперёд и хотя бы в виде прогноза "больше - меньше текущего значения"? Нет. Можно изьебываться как угодно, построить любую модель, все равно результат будет плачевный. Вопрос - почему? Ведь у нас есть все для вычисления.

Для вычисления ошибки модели? Ведь именно про нее я и написал. Если так, то да. Конечно. Сравнивая значения реальных данных (те самые котировки) и значения полученные с помощью созданной мат. модели мы можем получить невязку и ее статистические характеристики. Это позволит нам правильно выбрать уровень доверия" к выбранной модели.

>Нет. Можно изьебываться как угодно, построить любую модель, все равно результат будет плачевный. Вопрос - почему? Ведь у нас есть все для вычисления.