Это копия, сохраненная 14 июня 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ https://halite.io/ https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/jobs?q=deep+learning&l=

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Список дедовских книг для серьёзных людей:

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Trevor Hastie et al. "The Elements of Statistical Learning"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Напоминание ньюфагам: персептроны и прочий мусор серидины прошлого века действительно не работает на серьёзных задачах

Предыдущий тред: >>1121858 (OP)

Знаю все необходимую матбазу из шапки. Умею немного в плюсы, знаю чуть-чуть теории из алгоритмов на больших объемах данных(т.е. получить что-то из огромной базы с высокой вероятностью), типа кластеризации или работы с разряженными матрицами. Рассказывали что-то про распарарллеливание и как это должно работать в хадупе, но ничего прикладного так и не сделали. Все, что умею мне нравится.

Расскажите, куда катиться с такими начальными(в смысле мне это нравится) и куда не стоит. Хотелось бы чего-нубидь сложного и не с курсеры. Заранее спасибо за любой ответ отличающийся от

>катиться к хуям

> куда катиться с такими начальными

Душить змею, десу. В смысле, питон учить. И матрицы никто не разряжает. Их делают более рЕдкими. От этого они становятся разреженными.

А после питона то что? Алсо он мне не очень нравится, если для дело надо, то конечно, но просто так его учить не тянет.

А про разреженные спасибо, мне тоже казалось, что так правильно, но я решил, что неправильно запомнил.

катиться в ScyPy. По сути в науку. Дальше неизбежно столкнёшься с морфологией, а тм и Перельман пришлёт тебе на обсуждение очередную статью

>сиридины

Блять, как же я так проебался.

>>62379

У тебя очень широкий вопрос. Погугли, какие задачи дип лёрнинг решает, выбери интересную, книжку из шапки почитай, потом найди список свежих пейперов по теме и реализуй методы из них.

>>62425

В России скорее всего нет. Т.е. если ты чисто машобом хочешь, то нет.

Обычные прогерские скиллы, очевидно.

Ну чувак на таком уровне, где геометрия сливается с математикой, и одним словом это можно назвать логика. Человеческая логика сейчас находится на уровне Перельмана. Именно так мы сейчас осмысливаем предметы вокруг себя.

<ывают проскальзывают вакухи Big data etc

Ну т.е. буквально, стоит ли ужимать бюджет немного на второе ради первого, или наоборот?

важно найти самый простой способ провести бейслайн в классификаторе. Если это не получается то начинаешь перебирать с помощью CPU.

Я в нейроночках диван, но советую сначала упереться в железку на практике, а потом считать бюджеты.

Для обучения - видеокарта, желательно с большим объёмом памяти, иначе будешь ебаться с подгрузкой данных кусками.

ryzen, 1080ti, 16+Гб для домашней системы стандарт сейчас

>логика

Я занимаюсь логикой и это очень далеко от диффуренциальных уравнений. Логика скорее похожа на самую слабую в смысле ограничений на объекты алгебру, но не более.

>>62497

Видеоуроки и платить еще за это предлагают.

>>62707

Еще раз, это вводные, чтобы объяснить что мне нравится, а что не особо. И что именно начинать на курсере то?

Насколько я понял, то, что я описал это не машоб а просто работа с большими объемами информации. Или я не прав?

ОПчик, halite.io из шапки уже закончился. Можно мейлрушный канкурс вместо него поставить.

У тебя типичный вопрос из серии что мне делать со своей жизнью. Он не имеет смысла, как и твоя жизнь. Че хочешь, то и делай. Хочешь поступай на пхд, хочешь пускай krokodil по вене.

Блин, второй проёб в шапке. Тред медленно будет лимит набирать, но в следующий раз постараюсь на обосраться.

Не знаю. Я прошу рассказать какие есть направления и темы в том, что называется data science. Видимо это много.

Гугли. Тут секретов нет, интернет забит подобными вопросами.

статистика, r, julia

scala @ spark, clojure @ storm\onyx

катиться - в шад

курсера - это, кстати, не видосы, а курсы, и притом бесплатные (платный - сертифицированный сертификат)

>статистика, r, julia

>scala @ spark, clojure @ storm\onyx

>катиться - в шад

Спасибо, но это же все технологии или вообще языки, а статистику я вроде более менее знаю. В шад же меня не возьмут, да и в этом треде о нем нелестно отзывались. Да и там нужно выбрать одно из трех направлений, а в этом то вся проблема и заключается.

А по поводу курсеры я так понял, там в зависимости от курса либо плата за сертификат, либо плата за сам курс, есть триальная 7дневная версия, но все не то. И в основном там видеоуроки в этих самых курсах, по крайней мере в тех, что я видел.

Как мне обучить нейросеть играть например в герои 6 не хуже человека, чтобы по тактике рвал, какую библиотеку скачать как начать обучения сети?

это очень сложно. Я думаю почти невозможно.

Для начала нужно распилить игру. найти то место которое отвечает за инпут. Переделать инпут с мышки на процесс, в котором крутится нейронка.

Дальше найти место которое отвечает за оутпут, в смысле то которое стоит перед оутпутом на видяху. Потому что там совсем мрак. Понять рендеры каких объектов ты видишь. Сделать мап этих обьектов в нейронку. Дальше нейронка запомианет паттерны движения этих объектов и учится. Проще конечно зареверсить движок, найти файлы которые отвечают за игровую механику, замапить их в нейронку. Потом обученная нейронка мапит свои оутпуты в апиху игры. но если ты такое сделаешь, можешь претендовать на нобелевскую премию в области нейросетей.

Наркоман? К какому-нибудь openai universe можно при делать любой вывод на экран и любые действия с клавой, мышкой итд. Там даже в примерах используются обычные игры, никто их не ковыряет. Другой вопрос, что научить нейроночку чему-то сложнее арканоида в домашних условиях вряд ли реально, мощности не те. Нужно как минимум поднимать всю эту ебулду на каком-нибудь амазоновском инстансе.

Нейронные сети имеют такое же отношение к мозгу, как андеркаты и прочая хипстерская хуита - к нормальному виду.

Нейронки зохавали моцг

Во-первых, твой вопрос плохо сформулирован, и я не понимаю о чем он. Во-вторых, это место именно для дегенеративного обсуждения про нейроночки. За сириус бизнесом иди в реддит.

> а мой резонный вопрос про деление машоба и вообще науки об информации, до сих пор без ответа?

Что за вопрос-то?

Стакай xgboostы и сверточнхы слоев побольше накатывай.

«День знаний» для ИИ: опубликован ТОП30 самых впечатляющих проектов по машинному обучению за прошедший год (v.2018)

https://habrahabr.ru/company/cloud4y/blog/346968/

Топ-10 трендов технологий искусственного интеллекта (ИИ) в 2018 году

https://habrahabr.ru/company/otus/blog/350614/

Да наоборот прогресс ускоряется, в 2016 году я вообще не слышал новости об нейронках и не знал что это.

21 Кб, 866x122

21 Кб, 866x122 213 Кб, 491x424

213 Кб, 491x424Хайп спадает, теперь ждать пока деды от машинлернинга не придумают очередную хуитку, позволяющую повысить качество распознавания негров на 0,5%.

>>63937

>опубликован ТОП30 самых впечатляющих проектов по машинному обучению за прошедший год (v.2018)

Единственная интересная вещь - fasttext, это да, очень круто. Остальное - распознавание негров а-ля пикрелейтед, нескучное автоматическое разрисовывание котиков в стиле Пикассо и анимешных девочек, костыли к слесарьплову, морфинг лошадей в зебр, изменение голоса и прочее говно из жопы.

>почему абсолютно дегенеративное обсуждение про нейроночки так оживлено идет, а мой резонный вопрос про деление машоба и вообще науки об информации, до сих пор без ответа?

Единственное адекватное деление машоба на два стула было сделано еще в 60-е - асимптотически-оптимальные и конечно-оптимальные алгоритмы. Первый случай - нейроночки и прочее говнишко, над которым можно прыгать с бубном до японской пасхи в надежде, что десяток дополнительных видюх, новая борода из более модного барбершопа и совместное камлание на коворкинге приведет к увеличению качества еще на 0,05%. Второй случай - алгоритмы на основе теории статистического обучения.

573 Кб, 730x551

573 Кб, 730x551Over-fitting это же теремок (сказка такая) или даже украинское "рукавичка", этот принцип дети учат очень рано

Всё дабы запутать простых людей. Даже думаю, что дети машинное обучение будут понимать намного проще. Примерно как со следующей задачей:

На книжной полке рядом стоят два тома Пушкина:

первый и второй. Страницы каждого тома имеют вместе толщину 2 см, а обложка –– каждая –– 2 мм. Червь прогрыз (перпендикулярно страницам) от первой страницы первого тома до последней страницы второго тома. Какой путь он прогрыз?

Эту задача дети решают за 0,(9) секунды, а профессора за длинную эпоху тяжелых размышлений.

68 Кб, 225x225

68 Кб, 225x225Хотя мне немного грустно от всего этого.

Смотря в каком порядке стоят тома

Лол, ну так дело в том что мелкие пидорахи узко мыслят, поэтому и быстрее.

Я сам обосрался, признаю, но как минимум взрослый человек если подумает над этой задачей больше 5 секунд поймет что книги могут стоять по разному, могут быть какие-то манякниги где первая страница в конце, маетматики могут еще в своих неэвклидовых гемоетриях позалипать. В общем хуита пример. И с теремком тоже. Специальные термины нужны т.к. им задают гораздо более узкий и точный смысл чем имеют привычные обывательске понятия, и потом дауны делают ошики из за недопонимания т.к. каждый понимает "манятеремок" или "сообразительный, но выбывший малый" по разному, либо делают акценты на разные характеристи этих мысленных объектов.

Короче очередной кукаерк в стиле "чейто энти ваши ученые там делают, лушеб коз выпасли или корову подоили, только деньхи наши тратят, дармоеды"

>изменение голоса

Это именно то, что я хотел сделать после прохождения машинного обучения на курсере. Неужели все так нетривиально?

А ты небось думал что нейроночки и машобчик это так, месяцок позалипал на курсах\книжках и можно на легке хуячить все те охуительные идеи, которые ты придерживал до изобретения ии?

Нейронки нужны для хайпа и попила бабла, а твое изменение голоса решается на коленке любым ЯП.

И правда, как только без нейронок голоса раньше меняли. Кстати, какова математическая постановка задачи изменения голоса?

Есть куча синтезаторов голоса, а если копнешь глубже в акустику, то какие проблемы в его изменение?

Нет, всякие phd десятилетиями этим занимаются и в лучем случае могут побить какой-нибудь порог точности на 5-10% в имажнете или мнисте.

Любая крупная контора типа фейсбука, гугла, даже мейл ру имеют целые ресерч отделы, где лучшие в этом направлении люди за крупную зарплату каждодневно пытаются сделать что-то подобное. И тут такой вкатывается васян с двача после курсеры и мутит свой морфер изменятель голоса, бота для героев и прочих самореплецирующихся киборгов математиков.

А вот хуй, это так не работает

>как только без нейронок голоса раньше меняли

Питч двигали, гармоник добавляли, да хорус. Это детский лепет. Автотюн незаметный до сих пор не могут сделать, епта.

>>64194

>Есть куча синтезаторов голоса

Начнем с того, что они такое говно, что даже глухой отличит их от живого человека.

Под изменением голоса я понимаю качественный синтез, имитацию голоса конкретного человека, работу с интонацией.

>имитацию голоса конкретного человека

А, ну да, тут без нейронки и поллитры смузи не обойтись.

>Единственное адекватное деление машоба на два стула было сделано еще в 60-е - асимптотически-оптимальные и конечно-оптимальные алгоритмы

А можно поподробнее про второе? По каким запросам гуглить книги, что изучать.

Вот не пиздел бы, для всяких английских и испанских есть много годных синтезаторов, просто языки простые. Работа с интонацией заключается в определение семантики текста, а это NLP, там нейронки сосут в первую очередь.

68 Кб, 570x712

68 Кб, 570x712Поковырял бы в матчасте что ли

Ты школьнег?

Ты мыслишь ограниченно.

>>64182

Любым ЯП не получится сделать голос конкретного человека, например.>>64209

>Под изменением голоса я понимаю качественный синтез, имитацию голоса конкретного человека

Не, это перебор. Я еще в теорию кодирования голоса не вникал, но мне кажется, что просто покрутить параметры (с помощью ГА, например) для создания похожего голоса недостаточно, т.к. параметры будут единые для всего потока. Нейронка же, возможно, сможет адапитроваться к определенным патернам изменения голоса.

Когда хочется "ну вот так, чтобы охуенно было, как в фильме", но "ЯП это скучно, посоны засмеют", то всегда говори "нейронка сможет".

>Ты мыслишь ограниченно.

Лол, ну давай, неограниченный наш, не забывай хорошо учиться и заполнять дневник, чтобы когда обосрешься с первой тренировкой нейроночки(если вообще до этого осилишь) хоть аттестат был.

>как только без нейронок голоса раньше меняли

Хуёво, вот как. Даже тупо повысить голос на октаву не могли без артефактов.

Самое интересное, что в фантастических фильмах про будущее, голос искусственного интеллекта и суперкомпьютера сейчас изображает живая баба. А актеры, озвучивающие симпсонов, получают миллионы. Интересно, начнут ли они песдеть про авторские права и персональные данные, когда нейросетки их порешают? когда-нибудь

Учусь в маге в неплохом тех.вузе нерезиновой, решил пошароебиться по собесам, есть оффер на неплохую стартовую должность аналитика в полуайти компании(небезызвестная платежная система для школьников и наркоманов) с возможностью дальнейшего переката в мл. Мат.база минимальная есть, прохожу курсы, вся хуйня. Собсна, вопрос: стоит ли бросать нахуй магу, если я уверен, что по специальности работать не буду, или же продолжить учебу ради корки магистра?

Доучивайся 100%, без корки в Рашке (и не только) ты никому нахуй не сперся.

мимо старый бомж без корки шлют на всех собесах нахуй

Траблос в том, что у меня уже 3 знакомых ( 2 мидла-кодера и один джун дс) ща работают в яндексе вообще без каких-либо корок, поэтому и назревает вопрос. А проебывать 2 года на хуйню, которой заниматься я не особо хочу, - вообще не радужная перспектива

Не доучивайся 100%, корка в Рашке интересует только крыс из бухгалтерии, которые её ПРИКЛАДЫВАЮТ К ЛИЧНОМУ ДЕЛУ

62 Кб, 700x523

62 Кб, 700x523Поехавший либираха у которого на швятом жападе все в шоколаде? Ну, ну.

Дак бля это будет магистр по ядерной физике и технологиям, от которых прост пиздец воротит. Насчет мля - не уверен, можно ж проходить курсы вышки, например

С чего такая уверенность? Один хуй корка будет не по компьютер сайнсу, а если наработать опыта и сдавать языковые экзы - думаю, шансов все равно больше

Наводнение рольнул. Не самый плохой вариант, чо. Шансы есть в течение месяца-двух. Изменение климата? Ахаах, выдумки китайцев, да мы же только выиграем, засеем тундру, ой чтбульбульбульбульбуль

93 Кб, 918x688

93 Кб, 918x688Ну так дропни и возьми магистратуру с чем-нибудь cs релейтед

Мифишник в треде? Сам мифишник закончивший в ядерную физику.

Ты подумал о настоящих причинах своей нездоровой тяги к мертвым, похороненным теориям? Думай. Думай об этом постоянно. Каждый раз, когда отвлечешься от мыслей об этом, возвращайся к ним, как только заметишь это. С утра проснулся - первая мысль: почему же я некрофил? Перед сном вспоминай, размышляй о тлене, разложении, почему тебя именно это привлекает. Когда ешь, визуализируй сгнившую, червивую, иссохшую еду перед тобой, задавайся вопросом, почему тебе это нравится. Отныне все твои мысли заняты только этим, ничто другое не имеет значения. Представляй себе свою собственную смерть, при каких обстоятельсвах она произойдет, как скоро.

> Ты подумал о настоящих причинах своей нездоровой тяги к мертвым, похороненным теориям?

Лол, мань, статистикал лернинг живее любых нейроночек. Бустинг тот же.

По вопросу ничего не могу сказать, но в ответ спрошу: а что такое чатботы, особенно в индустрии? Вообще что они делают, для чего там нейроночки?

Я слышал в реддите про это, но только какое-то невнятное бормотание. Никаких примеров этого я не видел. В жизни, например, сталкивался с чатботом на техподдержке моего сотового провайдера, было довольно круто, мой вопрос был решен. Но там банальное дерево диалога, как в РПГ из 70-х годов, только сверху прикручено распознавание и синтез голоса. Последние два, видимо, на нейроночках, но это из другой области вещи, как я понял. Чатботы же это именно про содержание текста?

В моем случае чисто дерево диалога с выбором из вариантов. Единственное, можно было выбор сделать голосом, например что-то вроде: вам нужна техподдержка, проверка баланса или настройка голосовой почты? Говоришь техподдержка. Раньше надо было кнопками выбирать, очень неудобно.

Но это явно не про те чатботы, о которых идет речь в посте выше. Или это они и есть? Тогда зачем там корпус твитов нужен?

>Или это они и есть? Тогда зачем там корпус твитов нужен?

ну смотри, тех поддержка там все просто, все вероятные проблемы захардкожены, если бот типа болталки там можно собрать ответы на типичные фразы из инета/твитора, если добвить к ней некую реакцию получится ассистент. все это симуляция ии, хотя может выглядеть впечатляющи.

Что за бот типа болталки? Я совершенно не в теме, представления не имею, о чем идет речь. Это просто боты, отвечающие рандомными фразами, как Элиза из 66-го? Тогда какое отношение они имеют к индустрии? Или это индустрия развлечений какая-то, тогда где это все можно посмотреть?

И что это за ассистент? Если это как сири в айфоне, то там все точно так же захардкожено по ключевикам. Шаг влево, шаг вправо и "here is what I found on the web on your request", тупо в гугл забивает твой запрос.

>болталки = Элиза из 66-го

да

>ассистент = сири в айфоне

да, отличие в том, что у сири будут реакция на фразы типа проверь почту

Имхо сири на 100% по ключевикам работает, т.е. это проверь почту кто-то там забил в БД руками, посмотрев список частых запросов, которые не удалось распознать другими ключевиками. Ну на самом деле я не знаю, может там и правда пупир нейтронные касмические квантовые технологии на блохчейне, но по тупости эта система в точности равна БД ключевых слов.

примерно как у яндексопидоров

https://habrahabr.ru/company/yandex/blog/339638/

а тот анон, просто еще не понимает, что нейронки это лютая хуета

Спасибо, теперь какое-то представление получил. Наверное, там как раз описано то, что тот анон имел в виду.

>что тот анон имел в виду.

наверное. тому анону пора спускаться с небес и хотя бы понять, что даже синтаксический разбор предложения является нерешенной задачей в nlp, не говоря уж о семантике, а под капотам цири и алис скрывается паровой двигатель.

Да ведь на хабре все это как раз и описано. Там два варианта использования нейроночек: классификация текста по категориям, для чего глубокий разбор не нужен (по факту там просто несколько шаблонов распознается, т.е. можно сказать что нейроночка автоматически подбирает нужные ключевые фразы), и режим болталки где нет никаких гарантий, т.е. это классическая Элиза на модных технологиях. То, что нейроночка и близко не делает никакого разбора текста, их не особо волнует, оно им и не нужно.

Конечно, сказать что у нас тут ПОМОЩНИК С ИИ НА НЕЙРОНОЧКАХ, или Я ДЕЛАЛ ДИАЛОГОВЫЙ ИИ В ИНДУСТРИИ - бесценно. Ну да хрен с ними, пусть делают. Все равно в НЛП застой уже лет 30, хуже не будет.

> Все равно в НЛП застой уже лет 30, хуже не будет.

Какой застой 30 лет, ты что-нибудь слышал про word2vec и лингвистические регулярности?

>word2vec

Едрить прорыв.

>лингвистические регулярности

Это ты про king - man + woman = queen? См. выше.

> Это ты про king - man + woman = queen? См. выше.

Что там смотреть? Мнение очередного школьца? Алгебраические операции на пространствах векторных представлений текста уровня корпусов common crawl даёт огромные возможности, если уметь что-то кроме кукареканья.

>>65579

> не работоспособное говно

Когда в голове прошлогоднее говнишко, то да. Но это проблема не word2vec, разумеется.

>common crawl

че бля? какие на хуй возможности для нормальных языков с флексией и свободным порядком слов? еще эсперанто подтяни или бейсик.

Нуя ж говорю, ты просто не понимаешь как это работает непосредственно, на уровне линейной алгебры и никогда не видел всего этого вживую.

>ты просто не понимаешь как это работает непосредственно

ну да, я вот всего лишь ебусь с проджектом по нлп

Для релокейта нужна корка. Да и 95% вакансий МЛ на Западе её просят.

но если это мага. то у тебя уже есть бакалавр?

Если нужно сделать что-то, что будет.

1. Генерировать разнообразные ответы

2. Воспринимать больше, чем набор заготовленных фраз.

То нейронки с этим справляются лучше других алгоритмов. Ещё нейросети являются расширяемым фреймворком, то есть решение проблемы часто получается не очень костыльным, например здесь - https://arxiv.org/abs/1603.06155 чуваки просто и эффективно решают проблему несвязности разных ответов друг с другом.

Нет

Не распарсил.

> Какой уровень знаний нужен для книги Vladimir N. Vapnik "The Nature of Statistical Learning Theory"?

Матан, теорвер, линейная алгебра, основы вариационного исчисления.

> И какой уровень будет после?

Если осилишь - просветление. Поймешь, почему нынешний мейнстрим в машобе это путь в никуда и почему все кроме конечно-оптимальных алгоритмов в машобе это чистое шаманство.

> Сектанство не нужно.

Это не сектантство. Из всего машоба это единственный подход без сектантства.

Сектант, плес

Будете на Байкалах нейроночки тренировать, нефиг тут.

> Будете на Байкалах нейроночки тренировать

На луньсунях, ты хотел сказать. Это же пижженые китайские процы longson. А так, сразу было ясно, для чего гебне цензура. AWS интересен тем, что позволяет с common crawl работать, нейроночки нахуй не нужны.

синтаксический парсер отлично работает, только он ничего не дает и непонятно, что с этим синтаксисом делать

Отлично работает (только если предложение не использует необычный синтаксис) (обычный синтаксис используют 3% предложений) (отлично значит приемлемо) (то есть результат можно отличить от выхлопа ГСЧ) (статистическая значимость отличия от ГСЧ 0.1 на выборке из 100000000 предложений)

Но разве я не могу свести любой не марковский процесс к марковсому тупо записывая все что нужно в стейт? Т.е. если мне например нужно знать какую-то хуитку, которая была три состояния назад, я просто беру и в стейте держу дополнительную величину "хуйнянейм три стейта назад", в конце концов я же могу тупо всю историю состояний записывать в текущий стейт.

Тогда нахуя они вообще нужны?

ты дурак а я умный

Манька, а как ты собираешься узнавать всю историю процесса? Или ты прого-дебич, не могущий вообразить ничего за пределами кампуктера?

Можешь. Именно так и делают, если это возможно. Но это бывает невозможно реализовать на практике. Например, полное состояние может быть слишком большим, или содержать переменные к которым у тебя нет доступа.

Чего так нагрелся то? Агрессивный вапникофорсер eto ti?

Во-первых, да не могу, иначе бы не спрашивал.

Во-вторых ессно меня интересует то, что можно реализовать на компьютере, иначе я бы спрашивал у чистопетухов в матаче, а не в зекаче.

Читаю книжку по RL, там часто делается на это акцент, вот и стало интересно. Писали бы уже про какую-нибудь markov representation, а так только запутывает.

462 Кб, 752x1083

462 Кб, 752x1083>меня интересует то, что можно реализовать на компьютере, иначе я бы спрашивал у чистопетухов в матаче,

Они грязнопетухи на самом деле. То, что нельзя реализовать на кудахтере или что то же самое, в виде ментальных построений, нельзя реализовать никак. Это не математика, а аутизм.

Анон, а есть какая-нибудь годная книжка по конструктивной математике? Чтобы только не ебали когомологиями колец с первых страниц.

Лучше сразу какой-нибудь прувер разбирай, непонятное догугливай. Когда будешь думать что понял, пробуй на нем написать что-нибудь из Барендрегта, "lambda calculi with types".

https://cloud.google.com/natural-language/

https://habrahabr.ru/post/317564/ (немного криво обучено)

>>66589

отлично - не хуже других NLP задач, где выше 90+% даже на простых задачах не получают/до недавнего времени не получали (типа несчастного определения частей речи)

и не очень понимаю проблем с нейронками и синтаксисом, задача почти не отличается от любых других задач, например, Named entity recognition и тд, да и проблемы те же самые

Столкнулся с тем что было бы очень удобно получать элемент А по индексу A[index] если А - list, а не ndarray (index тоже list). Как-нибудь так можно?

это не нейроночка. Нейроночка это то что ты фитишь. А ты юзаешь апи этой нейроночки. тебе в треб с радостным удавом на пике.

Ну train_test_split это не то чтобы апи нейроночки ) Или мне и перемножение матриц самому на плюсах писать?

а ну да маленько не доглядел. извиняй

кстати если тебе будет нужны датасеты обращяйся

Так он же склерном только тестирует.

Ты из тех для которых с нуля это на своей ос, со своим языком и стандартными либами?

потому что могу

В порядке возрастания это как? О каком порядке вообще может идти речь, если данные обычно смешаны и перетасованы?

11 Кб, 530x65

11 Кб, 530x65есть опыт с скашечкой?

я еще зелэный.

ну вот хуй знает. типа надо подготовить трейнинг сет, например чтобы его таргеты были в виде вектора

вот прикладываю скрин с туториала, 'y' это таргетсы из трейнинг сета

Пройди туториал самый базовый хотя бы. У тебя вопросы на уровне как запустить хеллоуворд.

y_i у тебя должен соответствовать твоему ветору иксов из матрицы X т.е. y_2 соответствует второй строке твоей матрицы данных.

>>68020

спасибо. То есть не обязательно чтоб таргетсы были по возрастающей? Просто у меня не правильно сработало. правда таргетсы были не 1, 2, 3 а соотвественно 650, 400, 820

и модель только одну 820 правильно предсказала.. а остальных цифр которые она выдала вообще не было в таргетсах, что типа 118 и 500

так же вектор имеется ввиду просто массив, необязательно чтоб он был именно возрастающим или убывающим?

>>68028

Блин, я вообще не очень понимаю что у тебя там с таргетсами. Разберись минимально и станет понятно. Ничего там возрастающим и убывающим быть не должно.

У тебя данные обычно представлены матрицей mXn, т.е. m - количество строк - это все твои наблюдения т.е. к примеру если это фильмы

то там будет строка со всеми характеристиками фильма типа название, жанр, длительность и т.д., n - количетство столбцов - это какие-то характеристики твоих данных т.е. в случае с фильмом первый столбец название, второй жанр, третий длительность и т.д.

Если тебе к примеру нужно предсказать жанр(т.е. в твоем тренировочном наборе этот столбец будет, а в тестово нет), ты берешь все остальные столбцы как x т.е. будет матрица mX(n - 1), а столбец y - это жанр mX1. Главное чтобы они у тебя соответсвтвовали твоему иксу т.е. пятый элемент твоего столбца y относился к пятой строке матрицы X.

Со своим датасетом можешь делать что хочешь, главное чтобы сохранялось это соответсвие. А когда ты наконец читанешь про numpy и pandas то поймешь что делать это элементарно и почему твой вопрос такое дно.

>ты берешь все остальные столбцы как x т.е. будет матрица mX(n - 1), а столбец y - это жанр mX1

спасибо, пояснил за регрешн, спасибо!

но я пока на классификаторе сижу, до регрешина ещё не дошёл. Теперь вижу что те же яица вид сбоку как говорится

Какая ето функция?

Я тебе даже больше скажу, тут не только написано сложновато, это вообще довольно сложные вещи, если ты рассчитываешь на что-то большее чем использование моделей из sklearn. Вероятно, тебе придется вообще всесторонне повышать уровень знаний, а твои вопросы и манера речи свидетельствуют о том что это будет долгий и тернистый путь. Зачем это тебе?

нет кроме моделей из sklearn ничего делать не собираюсь. хочу помаксимум с ними разобраться и использовать на благо своей макакской работы. Ну и для себя хочу попробовать написать AI который будет играть со мной в спейсфутбол. ну а на счёт манеры речи. да я неаккуратно пишу чёт ленюсь, извиняй

Я вовсе не агрессивен. Я максимально дружелюбен. Я засыпаю улыбаясь и обняв подушку, потому что представляю как нахожу друзей в тредике, с которыми обмениваюсь статьями и идеями, разбираю практические проблемы и штурмую PhD.

ебаные

13 Кб, 344x92

13 Кб, 344x92Еще бы посмотреть на этот аналитический вид в общем случае (для сети из N слоев с Mi блоков в каждом слое). А то что-то не могу найти.

Я этого хочу.

Более-менее привел код к рабочему виду,

https://paste.ofcode.org/YZeyPTuk4wckpu9eU3G5k6

вроде оно иногда работает, но как-то странно

Например на digits результаты сильно разные и иногда очень хуевые, если указать достаточно большой градиентный шаг (больше чем 0.01) то на digits обычно оно вообще нихуя не сходится.

Как можно бороться со всем этим?

хотя не, для digits если указать побольше нейрончиков то точность почти 1

А вот почему такой маленький градиентный шаг непонятно

>если указать достаточно большой градиентный шаг (больше чем 0.01)

>вообще нихуя не сходится

>как можно бороться со всем этим

Ставить меньше, очевидно. Если не сходится, значит перелетаешь минимум постоянно. Шаг 0.001 и меньше это норма так-то.

> Еще бы посмотреть на этот аналитический вид в общем случае (для сети из N слоев с Mi блоков в каждом слое). А то что-то не могу найти.

Сам нарисуй схему и по ней выпиши, хуле ты. У прости господи Вапника перцептрон и SVM так описаны, да и вообще такая нотация на каждом шагу встречается.

>такая нотация на каждом шагу встречается

Прочитал всю фундаментальную книжку из шапки и не нашел такой встречающейся на каждом шагу нотации.

> Прочитал всю фундаментальную книжку из шапки и не нашел такой встречающейся на каждом шагу нотации.

Книжка в шапке хипстерская, фундаментальность там рядом не стояла. Поди даже не написано, зачем в нейроночках "нейроны", для чего вообще вход разбивать именно таким образом, из каких соображений это следует и что даёт.

Никак не могу понять, в лекции от беркеле ебут обобщенными формулами без особой конкретики. В пейперах еще больше математической дичи.

Вот допустим есть простая игра где бот двигается в 2d плоскости и может стрелять в других врагов. Наиграл я пару сотен матчей и насобирал данных, что дальше то?

Вряд ли тебе кто-то будет разжевывать тут столь нетривиальные вещи. Иди ботай статьи.

LSTM это особая атмосфера, с ними надо пару лет плотно позаниматься, чтобы начать понимать как их эффективно использовать. Для твоей задачи, если тебя устроит ограниченное окно, рекомендую банальную 1д свертку по времени.

Вот я о чем и говорю. Вы прочитаете про полторы хипстерские нейроночки, и не понимая зачем они вообще, пытаетесь засунуть их везде. У тебя задача на кластеризацию. Вот есть у тебя фичи, полученные из 14 временных рядов в пределах окна из 64 значений. Казалось бы, собирай их в один вектор и подсовывай карте Кохонена, построенной на исторических данных, где ты можешь отметить векторы фич, ассоциированных с искомыми событиями. Все, дальше смотришь насколько близко тестовый вектор фич проецируется к нужному тебе. Потом, если у тебя есть помеченные наборы таких фич, можно их попробовать разделить на классы с помощью SVM, м.б этого будет достаточно. Зачем тут lstm вообще, ты же пол не болгаркой подметаешь.

Спасибо за совет. А существуют ли какие нибудь готовые библиотеки python для выполнения сверток?

Линейные классификаторы я тоже использовал, но они отработали хуже чем тот же двухслойный MLP. Как на сырых рядах, так и на статистических фичах. Скорее всего, это из-за данных, потому что у них очень неявное разделение на классы. Поэтому не факт, что мое решение с подсчетом статистических фич для окон явно описывает класс. Но нейронка в пределах 80-85% смогла распознать. Но хотелось бы конечно результат получше.

> Линейные классификаторы я тоже использовал, но они отработали хуже чем тот же двухслойный MLP.

Но я про линейные классификаторы ничего не говорил. Как вариант, можешь ещё бустинг навернуть.

21 Кб, 640x505

21 Кб, 640x505Но потом меня обоссали и сказали, что регрессионные методы уже давно известны, ты втёр нам старьё, Вася! Делай тоже самое, но только нейронными сетями! БЫСТРА! ОДНА СУТКА ВРЕМЕНИ ТЕБЕ!

ПОЭТОМУ, ПОДСКАЖИТЕ, ПОЖАЛУЙСТА, КНИГУ НА РУССКОМ, ГДЕ ОПИСАН КАКОЙ-НИБУДЬ ФРЕЙМВОРК ИЛИ БИБЛИОТЕКА С НЕЙРОННЫМИ СЕТЯМИ, ЧТОБЫ МОЖНО БЫЛО ЕЙ СКОРМИТЬ ТОЧКИ И ЧТОБЫ НЕЙРОННАЯ СЕТЬ НАРИСОВАЛА КОРРЕЛЯЦИОННУЮ ЛИНИЮ

Прошу книгу на русском, так как осталась одна сутка. Пока ищу, не могу найти. Вроде, задачу регрессии не принято нейронными сетями решать.

Ну или хотя бы подскажите библиотеку, которая может сделать регрессию нейронными сетями

О, как хорошо, спасибо огромное. Целую тебя, анон, ты просто прекрасен, ты как лучик света в тёмном царстве.

13 Кб, 429x412

13 Кб, 429x412Не смущай меня, пожалуйста.

sklearn проще, даже на русском много книг есть с описанием sklearn. А TensorFlow потяжелее хреновина.

>А зачем?

Да и действительно. А потом читари таких книжек приходят сюда и говорят, "а что нейроночку можно в виде функции записать?!?!", "а что, нейроночка может в регрессию????" итд.

А в каких книжках это фундаментально описано?

вкатился в sklearn, сейчас перекатываюсь на TesorFlow. Подкупило макакское комьюнити впику научному sklearn. И то что это гугл, который умеет в макакское API

Вместо чтобы выебываться и шизить, быстрее бы привел запись нейронки в виде функции, если уж в твоих совкодрочерских книжках это на каждом шагу.

>в твоих совкодрочерских книжках это на каждом шагу.

Это вообще в принципе на каждом шагу, почти в любой книжке или статье в тему. Соотв-но: однослойный перцептрон, многослойный перцептрон, SVM в виде двуслойной сети.

А теперь то же без реккурентной формы для отдельного нейрона. Для всей сети, как чисто аналитическую функцию от входов и весов для N-слойного перцептрона.

>Подставляй

Понятно. То есть в книгах в общей форме такой записи нет. А орали что на каждом шагу

Tensorflow, pytorch.

От тебя никакого толка, только выебыаешься. Как доходит до дела, сливаешься.

Ты хочешь частный, конкретный случай для конкретной архитектуры сети и конкретных функций активации. В этой книжке http://b-ok.xyz/s/?q=AE6CE64B978DCC3E4C0623C70D6D5973&e=1 похожие примеры разбираются, она даже в шапке была когда-то по моему совету, но выпилили. Я пользуясь случаем, еще раз посоветую эту книжку.

Да пусть сидит уже, он стал своим, домашним. Как старый таракан.

Все лучше чем времена нашествия дебильных шизиков из /ссы, бесконечно толкущих воду в ступе стенами словесного поноса про ишкуштвеный нтеллехт.

А по моему книга из шапки вполне так, если разобраться во всем что там написано то знать будешь куда больше большинства экспертов из этого треда.

Поддвачну. Тем более есть хороший русский перевод. Пока всякие недоснобы воротят нос, мол "мам, скажи им, читать на русском это никрута", другие ведут себя адекватно и вникают в интересные вещи.

Русек то тут причем? И это не снобство, одну книжку перевели, 1000 других не переведут. Про пейперы я вообще молчу + будешь путаться в терминологии + реддиты, стекоферфловы, кворы где можно задать вопрос или почитать развернутый ответ тебе тоже не доступны.

Вкатываться в датасаенс не зная английского край тупости. Даже русскоязычные курсы постоянно ссылаются на англоязычные термины и статьи

Никто и не спорит, что английский нужен.

плюсую. сам сперва купил видеокарту для этого. занялся обучением. хватает проца с головой. даже достаточно сложные на мой взгляд модели требуют минут десять. а карта манит себе спокойно

Куда поступать чтобы получить PhD? Мне нужны варианты если меня не возьмут в мит и калтех. В своем универе я уже всех задолбал.

Проведи исследование, собери данные миллионов мужчин, затем данные о том кому дают тянки и кому не дают, найди наиболее оптимальный вектор развития к локальному экстремуму, далее вкладывай время-деньги пока не начнут давать.

Проанализировав данные о 12 826 322 мужчинах мне удалось доказать что в локальном максимуме, достижимом из моего текущего состояния, вероятность того что мне даст тянка не превышает q.7E-7

Ему нужно совершать случайные блуждания по бабам.

Арнольд, Колмогоров сложно пишут. Ты видел доказательство работы нейроночек у Колмогорова? Там очень не просто. Ну только если ты не выпускник матфака. Вапника не читал, не знаю, новерное все же стоит почитать.

Не является ли bagging более продвинутым алгоритмом (хотя он и проще) хотя бы потому что он не может уйти в редкие цепочки вида (A>N1)&(B<N2)&(B>=N3)&(...) ? Покрывает ли boosting всё алгебраическое множество, когда положительные результаты в диаметрально противоположных углах пространства? Например (A>0.95)&(B>0.95) и (A<0.05)&(B<0.05) ?

Вапниколюб должен быть доволен.

сенсационные новости о том, что теория вапника не применима к нейронкам

https://calculatedcontent.com/2018/04/01/rethinking-or-remembering-generalization-in-neural-networks/

Я знаю, и это давно известно. Собственно, это очевидно из практики, даже если не углубляться в детали теории.

Но моя ссылка вообще не об этом. Я люблю рассматривать радикально новые модели, а-ля всякие NTM и spiking networks, все-таки просто нейроночки уже мейнстрим и немного наскучили (хотя DNC и прочее еще нужно дорабатывать).

У этого чувака прям совсем другая идея, интересно же. Хотелось бы статью обсудить с кем-то серьезно.

> Я люблю рассматривать радикально новые модели, а-ля всякие NTM и spiking networks,

Все равно эти модели либо конечно-оптимальны либо асимптотически- оптимальны. Даже если там нахуевертили столько всего, что vc- размерность для этой мутоты заебешься высчитывать. С этих двух стульев машоб не слезет, кроме них там и нет ничего. То, что на датасете типа белого шума SVM не работает, ебать Америку открыли. Будто что-то другое сработает в условиях чистого рандома. Эти все "радикально новые модели" от хипстеров ничего нового не несут, максимум - взгляд с другой стороны на общеизвестные вещи.

мимокрокодил

>Все равно эти модели либо конечно-оптимальны либо асимптотически- оптимальны

то есть не имеет смысл что то придумывать? имеет смысл брать модели из коробки как есть, и натренировывать их на датасетах под конкретную задачу (пиксели или лексика) та?

Если есть в параметрах warm_start, то можно грузануть предыдущий результат и дообучить.

забавно. то есть модель теоретически может расползтись на 3мб в оперативной памяти?

> то есть не имеет смысл что то придумывать?

Придумывать можно по-разному. Нахуярить слоёв, непойми чего, а потом утверждать что Вапник хуй, потому что vc- размерность твоей ебулды подсчитать невозможно, это в любом случае не путь здорового человека. Алгоритм должен выводиться из математической постановки задачи обучения, а не из интуитивных представлений о том, "как нада".

правильно ли я понял, что в sklearn есть дохера разных оценителей для всех задач с которыми сталкивается машоб и нужно просто выбрать один из этих об]ектов и обучить его и и nакой естимитор обучится мгновенно. Нежели собрать свою модель из слоёв во всяких хипстерских машоблибах типа Keras?

>Алгоритм должен выводиться из математической постановки задачи обучени

Ну и как успехи, много алгоритмов вывел? Где можно ознакомится?

>3 мб

Что-то вы совсем уж бедуете в своих нейроночках. Почему не делаете нейроночки на гигабайты?

а разве не для того, чтобы смапить результат сложения предыдущего слоя в заданный рейндж для данной сети напр 0<activation<1 ?

644 Кб, 598x599

644 Кб, 598x599> Ответ математика - правильный, но бесполезный

Умный дохуя? Ответь полезнее. Нейроночки это изначально математика, тебе ответ пчеловода нужен?

28 Кб, 841x102

28 Кб, 841x102Вот то-то поэтому хр выёбваться уже

ну и что что для макак. Я макака и горжусь этим

>Пистех - та ещё помойка

Обоснуй, пожалуйста.

Я слышал, что в Физтехе зубодробительно сложно учиться, но при этом дают очень хорошую физмат-подготовку. Что там?

Это ПТУ для математиков, где тебя вусмерть задрочат решением примитивных пазлов, замаскированных под задачи.

Вся суть хипстоты. Услышал что MIT круто, пересказал всем друзьям, пистех теперь говно потому что не MIT, а MIT эта крута.

Даже если это так, он абсолютно прав.

Погуглил учебный план по калькулусу, посмотрел пдфы. Что там такого сверхъестественного? Я как-то смотрел программу пистеха, там примерно то же было.

мимо примат СПбГУ

В голосяндру с носа пездоглазихи

Так в эту хуету можно поиграть или она ещё в разработке?

В этом треде. Если серьезный бизнес то надо идти регистрироваться и на реддит и писать там.

Ну это просто ты пришел.

добавил быдло вопрос

Я про видеолекции(калькулус, теорвер, линал, диффуры), после них можно свободно наворачивать любую современную книгу в которой предпологается знание соответствующего раздела матана.

После постсовковых шаражек ты разве что можешь наворачивать ненужные упражнения на листочках, а понимания зачем все это нужно 0.

Зочем видеолекции, когда прочитать быстрее?

Но могу подтвердить, матан стал лучше пониматься после забугорной книжки для идиотов 1917 года.

Можешь на процессоре считать.

Преподавай, снимай лекции, веди курсы.

нет нет проскакивают жирные вакухи

от книг зависит.

У нас например тоже есть бодрые книги 60х годов. В то время у нас был расцвет науки. А потом в 80-е всё пришло в упадок и утонуло.

С тобой можно где-нибудь вне треда пообщаться? У меня абсолютно та же ситуация.

Ок, посмотрел пару лекций. Там просто приводят примерчики типа "используется в физике", "почему производная - скорость" и "что такое двойной интеграл". Ну охуеть, как будто в России преподы такого не дают. Где обещанная магия-то? Я и до этого мог современные книжки читать. недавно, например, по теории управления и теории информации книжки из нулевых читал

http://mexuaz.com/opencv-machine-learning-03/

Код написан на Tensorflow 1.2/Keras 2.0.5

Я хотел взять ту же задачу, распараллелить её и выполнять в полотора-джва раза быстрее на нескольких ядрах. Я стал искать как же в Tensorflow/Keras делается параллельность на нескольких ядрах и нихрена не нашёл, нашёл только про подрубание GPU видеокарты.

Насколько мне показалось, в Tensorflow/Keras автоматически используется параллельность ядер.

НО! Узнать об этом точно у меня не получается, так как у меня всего два ядра. Я взял PyCharm в котором у меня код программы на Tensorflow/Keras, я и в диспетчере задач отрубил второе ядро, оставив только одно. И эта программа на Tensorflow/Keras выполнилась вдвое медленнее.

ПОЭТОМУ Я ХОЧУ СПРОСИТЬ, ПРАВИЛЬНО ЛИ Я ПОНЯЛ, ЧТО В ПРОГРАММЕ НА Tensorflow/Keras АВТОМАТИЧЕСКИ ИСПОЛЬЗУЮТСЯ ВСЕ ДОСТУПНЫЕ ЯДРА ДЛЯ УСКОРЕНИЯ НЕЙРОННОЙ СЕТИ?

Некоторые операции распараллеливаются, например умножение больших матриц. Но вообще ТФ это про ГПУ, там над ЦПУ производительностью никто не парится особо.

Даже больше, если у тебя видюха от инвидии, слесарь тебе сам всё будет на ней считать

Я не спорю, просто на 1917 год триггернулся как красный комуняка

Спасибо

Вот тренируется нейронка, она может сразу воспроизвести результат, фактически на этом всё и держится, на том что нейронка может что-то воспроизвести.

Может ли быть так, чтобы был проёбан этап тренировки, но оставался этап воспроизведения? нихуя непонятно наверное, но я не знаю как иначе спросить

> Может ли быть так, чтобы был проёбан этап тренировки, но оставался этап воспроизведения?

Нет. Тренировка это настройка параметров функции, аппроксимирующей зависимости выходов датасета от входов. Перед тренировкой эти значения инициализируются какими-либо числами, но без тренировки ответ сети никак не будет связан с текущим датасетом.

Нда, крута...

Можно, но зачем? Вон прямо берёшь и псевдокодишь:

function hellocommaworldwithoutneuralnetworks () {

print("Hello, world");

}

Или даже

If "еда":

call слюна;

Ты не зная что такое аппроксимация пытаешься родить вопрос "можно ли получить вывод из нейронки которая не обучалась"?. Ответ - можно. Подавай что-то на вход, после умножения на случайно сгенерированные веса ты получишь свой мусор на выход. Если копать еще глубже в "голую сущность", то можно вывести веса девственной нейронки, и это будет тот же мусор. Простая нейронка это результат умножения массивов, никаких лишних сущностей нет. Я просто надеюсь что ты еще учишься в средней школе и пытаешься найти свой путь в жизни, поэтому не тыкаю мордой в то какой ты биомусор.

Нет, парень, я спрашиваю как спрашиваю. Вопрос про воспроизведение. Голое воспроизведение без подразумеваемых в нём данных вообще. Продублировал вопрос также в философаче

https://2ch.hk/ph/res/71196.html#71997 (

>>71758 это спросил тот кто не хотел гуглить.

Если ты спрашиваешь так что тебя никто не может понять, то проблема на твоей стороне, учись формулировать мысли. Ты зачем-то упомянул нейронки в треде про машинное обучение, а оказывается имел ввиду абстрактные сущности. Если вопрос сугубо философский, можно ли воспроизводить пустоту, то ты ошибся тредом. Если вопрос научно-прикладной, то голым воспроизведением является функция воспроизведения, можешь не передавать в нее никаких данных, в контексте программы она является чистым и незамутненным воспроизведением.

Я другой анон, но тоже не могу вкурить твой вопрос. На вход нейронки подается некий сигнал, на выход - преобразованный сигнал. То, как он будет преобразован, зависит от исследователя, от того, как он построит сеть и как обучит ее. Всё. Если не настраивать нейронку под задачу, то она будет выдавать что-то рандомное и никому нахуй не нужное.

> Голое воспроизведение без подразумеваемых в нём данных вообще.

Это тебе в лямбда исчисление. Там как раз такая нотация - голая абстракция функции любой сложности и структуры, в т.ч нейроночки конечно. Классика чтива - Барендрегт. Но ты не осилишь.

Собираюсь вкатываться в тему не бейте лучше обоссыте, но есть проблема: у меня достаточно старый комп, к тому же видюха от амд, пробовал запускать примеры на керасе, все жутко тормозит, тензорфлоу естественно не считает на гпу.

А я как раз собирался избавляться от десктопа в пользу ноутбука. И тут встал вопрос: стоит ли тратить дополнительные 20-30к за ноут с 1060? На буржуйских сайтах везде пишут, что практичнее будет купить ноут подешевле, разницу потратить на облако от Амазона. Но мне кажется, что это какой-то булшит: облако у Амазона стоит по несколько баксов в час, т.е. разницы в цене мне хватит примерно на 200-300 часов. Это же не очень много?

Вообще, на практике, насколько мне хватит 1060 для учебных заданий и своих проектов?

Если ты будешь гонять нейроночки на ноуте, он перегреется и сгорит через месяц. У них охлаждение не предназначено для этого.

Поступила на соответствующую специальность, гоняю нейронки на сервере универа, брат жив, зависимость есть.

15 лет пользуюсь только ноутами, причем лежа на кровати. Никакого хондроза, шея говорит малацца, позвоночник воскрес. И никогда не вернусь на стационарный комп. Пиздец блять, 3018 год на дворе, а всё пользуются стационарными гробами.

У меня есть 2 года опыта серверной разработки на сях, щас ботаю мл по специализации яндекса, потом планирую нейронок навернуть и быдлопроектик свой навелосипедить.

Но я ведь просто червь-пидор по сравнению с ребятами из ШАД например, или даже просто профильных кафедр МФТИ/МГУ/ВШЭ. Кому я нужен то?

Сам физик изи МИФИ, c матаном +- дружу.

>2 года опыта серверной разработки на сях

>вкатывается в машоб

Ты ведь понимаешь, что перекатываешься из условного НИИ жопоебли в песочницу к детям с синдромом дауна, чтобы жрать вместе с ними песок?

user->items -> black box -> user -> must_to_see_items

Предполагаю что для начала нужно пользователей как то кластеризовать по схожести их историй просмотра, а затем из максимально близко расположенного выдавать пользователю рекомендации.

На ум приходит k-mean или там knn, но они как то слабо подходят, объектов для рекомендации порядка 100к.

SOM ежжи. Оно очень хорошо классифицирует музло по соотв. фичам, может само, без учителя, распознавать жанры. Примеры есть в этой книжке:

http://gen.lib.rus.ec/book/index.php?md5=6F2C8128E2ADE1815E1967AEB57AA351

Analysing the Similarity of Album Art with Self-Organising Maps....Pages 357-366

Где-то видел даже готовый софт для автоматической экстракции фич из папок с мп3 в виде, пригодном для самоорганизующихся карт, сейчас нагуглить не могу. Но это вот они http://www.ifs.tuwien.ac.at/dm/somtoolbox/ делали. Суть рекомендаций в случае карт Кохонена - рекомендовать близкорасположенные к истории просмотра пейсни и даже жанры.

>Никакого хондроза, шея говорит малацца

Сколько тебе лет, сынок? И что ты на кровати с ноутом делаешь? Дрочишь что ли? Люди вообще-то работают.

42 года. Я работаю лежа. Сынок.

Ноут "все в одном" - хуевая идея. Надо сделать так: иметь СЕРВЕР, который дома будет пахать 24х7 и обучать нейронки. И любой ноут, через который ты будешь подключаться к серверу в режиме терминала - даже через банальный тимвьювер. При чем за сервер вполне может сойти твой днищекомп, оперативы только докупить. У меня, например, в компе 2012 года пашет 1080Ti и пашет примерно на 30% медленнее, чем его сосед с современным процессором и SSD. То есть на уровне 1080, а разница в цене между 1080 и 1080Ti - 10 тысяч рублей. То есть особой выгоды мне менять мой комп 2012 года на более новый нет. Но тот комп у меня довольно неплохой, шестиядреный феном с кучей оперативы и хорошим кулером процессора, не знаю, что у тебя там за дно.

Теперь, почему такой ноут - хуевая идея.

1. Это хуевое вложение средств, потому что они слабо апгрейдятся. Ну купишь ты 1060, через 2 года эта 1060 будет дном днищенским, в десктопе ты ее продашь, купишь новую и вставишь в тот же самый десктоп, а в ноуте что? Ноут только продавать и покупать новый.

2. Ноуты аналогичного железа сильно дороже.

3 У геймерских ноутов (а это будет геймерский ноут) проблемы с охлаждением, они не расчитаны работать 24х7 и что-нибудь у тебя поплавится, поведет от температуры, а еще есть шанс проблем с питанием. Если только не брать убер-ноут с оверпрайсом - а ноуты и так оверпрайснуты по сравнению с десктопным железом.

4. Допустим тебе надо куда-то поехать и ты берешь ноут с собой... В итоге ты стопоришь обучение, или едешь с печкой в портфеле.

5. Ноут больше 13" и временем работы меньше 8 часов - зашквар для колхозников и гастарбайтеров, видюхи, мощной понятное дело, в таком ноуте быть не может.

68 Кб, 1417x752

68 Кб, 1417x752Может тут кто знает.

ставлю rpy2. Для этого поставил R последний, х64. У директории r\bin есть config.sh, который задействуется при установке

R.exe CMD config, но выдаётся ошибка "sh не является программой/командой". В интернете пишут, что может быть проблема в прописанных путях в переменных окружения, но у меня вроде всё ок.

-------------

C:\PROGRA~1\R\R-34~1.4\bin\R CMD config --ldflags

"sh" не является внутренней или внешней

командой, исполняемой программой или пакетным файлом.

Traceback (most recent call last):

File "C:\Python35\Scripts\rpy2-2.9.2\setup.py", line 374, in <module>

ri_ext = getRinterface_ext()

File "C:\Python35\Scripts\rpy2-2.9.2\setup.py", line 269, in getRinterface_ext

ldf = shlex.split(' '.join(rexec.cmd_config('--ldflags')))

File "C:\Python35\Scripts\rpy2-2.9.2\setup.py", line 222, in cmd_config

universal_newlines = True)

File "C:\Python35\lib\subprocess.py", line 629, in check_output

kwargs).stdout

File "C:\Python35\lib\subprocess.py", line 711, in run

output=stdout, stderr=stderr)

subprocess.CalledProcessError: Command '('C:\\PROGRA~1\\R\\R-34~1.4\\bin\\R', 'CMD', 'config', '--ldflags')' returned non-zero exit status 1

-------------------

Ставь линукс.

Облако нужно в основном чтобы параллельно кучу всего тренировать. Дешевле, чем свой кластер содержать.

> выдаётся ошибка "sh не является программой/командой".

Поди под глинукс собрано. Попробуй вместо простого R мокрософтовский r open. Как вариант, поставь пакет из исходников или вручную - скачай и распакуй в каталог libs.

А, ещё вариант, поставь r tools.

Не дешевле. Возьмем комп на базе 1080TI. Сам тиай стоит тысяч 60, комп к нему - полноценный комп с 16 гб памяти, ssd (в т.ч. для свопа) и нормальным блоком питания, в днищекорпусе, может быть с похилее амд процессором - 40 тысяч. Итого за 100К ты имеешь dedicated машину, в которую при желании ты можешь добавить второй GPU. Жрать этот комп будет ватт 500, то есть 2 рубля в час, или 3 цента.

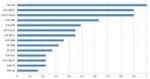

По AWS цены на инстансы on demand:

G2.2x: 0.05 (сильно подешевели однако)

G3.4x: 1.14

P2.1x: 0.9

P3.2x: 3.06

По перформансу имеем следующие коэффициенты из-за разной скорости:

G2: 0.1

G3: 0.4

P2: 0.2

P3*: 1.0

Со звездочкой, потому что у P3 быстрее в 2 раза на float16, но трейнинг float16 это отдельная сложная тема.

Переводим в деньги: G2 - 0.5 в час, G3 - 2.85 в час, P2 - 4.5 в час, P3 - 3.06 в час.

А комп с тиаем нам достался за $1500. Значит после того, как он отработает 3000 часов (потратив 100 баксов на электричество), он будет работать в плюс. При этом заменять он будет 10 инстансов G2. Остальные же инстансы просто не конкуренты, P3 например вырабатывает цену нашего компа за каких-то 500 часов, то есть 20 дней, P2 и G3 просто нахуй не нужны за такие деньги.

То есть если ты планируешь нагрузить свой тиай больше, чем на 3000 часов, то амазон тебе менее выгоден, чем купить прекрасную машину, которая будет жужжать у тебя на балконе и с 0 мс доступом. А если ты вставишь шикарный тиай в свой днищепека, то и 2000 часов хватит.

Но - это был вопрос денег. А еще есть вопрос удобства. И одна быстрая карточка лучше, чем десять медленных. Во-первых, в нее влезет нейронка потолще, с батчсайзом побольше. Во-вторых, какая-нибудь байесова оптимизация гиперпараметров на ней будет более эффективной - вместо того, чтобы ждать 6 часов и получить 6 хуевых результатов, ты каждый час будешь уточнять свою модель. А у меня например модель тренируется часа 3, на g2 придется ждать сутки? Хуйня неудобная.

Короче амазон или для инференса на сервере (неизвестно сколько юзеров будет завтра и дешевые g2 подходят), для стартапов, которые не хотят вкладываться в железо до раунда инвестиций, для тех, кто кому результат нужен вчера. А для нормального исследователя-контрактора выгоднее иметь 2-4 топовых консьюмерских жпу, соединенных в локальную сеть и с синхронизацией файлов на них.

Не дешевле. Возьмем комп на базе 1080TI. Сам тиай стоит тысяч 60, комп к нему - полноценный комп с 16 гб памяти, ssd (в т.ч. для свопа) и нормальным блоком питания, в днищекорпусе, может быть с похилее амд процессором - 40 тысяч. Итого за 100К ты имеешь dedicated машину, в которую при желании ты можешь добавить второй GPU. Жрать этот комп будет ватт 500, то есть 2 рубля в час, или 3 цента.

По AWS цены на инстансы on demand:

G2.2x: 0.05 (сильно подешевели однако)

G3.4x: 1.14

P2.1x: 0.9

P3.2x: 3.06

По перформансу имеем следующие коэффициенты из-за разной скорости:

G2: 0.1

G3: 0.4

P2: 0.2

P3*: 1.0

Со звездочкой, потому что у P3 быстрее в 2 раза на float16, но трейнинг float16 это отдельная сложная тема.

Переводим в деньги: G2 - 0.5 в час, G3 - 2.85 в час, P2 - 4.5 в час, P3 - 3.06 в час.

А комп с тиаем нам достался за $1500. Значит после того, как он отработает 3000 часов (потратив 100 баксов на электричество), он будет работать в плюс. При этом заменять он будет 10 инстансов G2. Остальные же инстансы просто не конкуренты, P3 например вырабатывает цену нашего компа за каких-то 500 часов, то есть 20 дней, P2 и G3 просто нахуй не нужны за такие деньги.

То есть если ты планируешь нагрузить свой тиай больше, чем на 3000 часов, то амазон тебе менее выгоден, чем купить прекрасную машину, которая будет жужжать у тебя на балконе и с 0 мс доступом. А если ты вставишь шикарный тиай в свой днищепека, то и 2000 часов хватит.

Но - это был вопрос денег. А еще есть вопрос удобства. И одна быстрая карточка лучше, чем десять медленных. Во-первых, в нее влезет нейронка потолще, с батчсайзом побольше. Во-вторых, какая-нибудь байесова оптимизация гиперпараметров на ней будет более эффективной - вместо того, чтобы ждать 6 часов и получить 6 хуевых результатов, ты каждый час будешь уточнять свою модель. А у меня например модель тренируется часа 3, на g2 придется ждать сутки? Хуйня неудобная.

Короче амазон или для инференса на сервере (неизвестно сколько юзеров будет завтра и дешевые g2 подходят), для стартапов, которые не хотят вкладываться в железо до раунда инвестиций, для тех, кто кому результат нужен вчера. А для нормального исследователя-контрактора выгоднее иметь 2-4 топовых консьюмерских жпу, соединенных в локальную сеть и с синхронизацией файлов на них.

Ты вообще не о том. Если тебе надо натренировать 1000 моделей для подбора гиперпараметров (это примерно минимум для средней статьи в 2к 18), то у тебя есть три стула:

- обсчитывать это 15 лет на своем домашнем пека;

- собрать кластер за 100 миллионов долларов, что займет 3 года работы, и потом натренировать модели на нем за неделю;

- натренировать за неделю на амазоне, заплатив несколько тысяч грина.

Я о том, просто ты туповатый какой-то и говоришь какие-то цифры с потолка. Какие нахуй 15 лет, какие нахуй 100 миллионов долларов.

Берем инстанс P3. На $10000 ты можешь купить 3000 часов. В неделе 168 часов, то есть ты купишь на эти деньги 3000/168=18 инстансов.

Второй стул - это потратить $10000 на 4 компа с парой 1080TI. В этом случае ты будешь считать две с половиной недели. Не 15 лет, а две недели. Только в первом случае ты проебешь $10000 навсегда, а во втором будешь иметь 4 компа с двумя 1080TI. На которых, внезапно, свою следующую статью вообще бесплатно будешь считать. 5 компов - это не какой-то там высранный тобой кластер за 100 миллионов долларов, это меньше школьного компьютерного класса.

Твоя логика это что-то типа "квартиры за 6 млн. дорого, лучше буду снимать такую квартиру за 250 тысяч в месяц - это выгодно."

не, это божественные Экспертные Системы

С натяжкой случайный лес можно чем-то таким назвать, но не нейронки

ЕСЛИ нейроночка сказала, что это кошка ТО это кошка

Решающие деревья.

> Но я ведь просто червь-пидор по сравнению с ребятами из ШАД например, или даже просто профильных кафедр МФТИ/МГУ/ВШЭ. Кому я нужен то?

Поверь, ты сильно переоцениваешь их.

24 Кб, 640x505

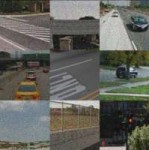

24 Кб, 640x505В начале я пытаюсь на Keras сделать регрессию с одной входной переменной, например, для синуса или параболы. Всё получается отлично программа предсказывает по точкам правильно и синус и параболу.

Дальше я увеличиваю размерность входных данных для двух переменных. И получается как на картинке. Вместо правильной синей линии программа строит очень грубую усредненную прямую.

ПОДСКАЖИТЕ, ПОЖАЛУЙСТА, КАК НА АНГЛИЙСКОМ ПРАВИЛЬНО ЗАГУГЛИТЬ ПРИМЕР НА Keras, ЧТОБЫ ТАМ ВМЕСТО РЕГРЕССИИ С ОДНОЙ ВХОДНОЙ ПЕРЕМЕННОЙ БЫЛО ДВЕ ВХОДНЫХ, КАК У МЕНЯ НА КАРТИНКЕ?

>ЧТОБЫ ТАМ ВМЕСТО РЕГРЕССИИ С ОДНОЙ ВХОДНОЙ ПЕРЕМЕННОЙ БЫЛО ДВЕ ВХОДНЫХ, КАК У МЕНЯ НА КАРТИНКЕ?

Домики деревянные набигают?

фикс Вместо правильной ЗЕЛЕНОЙ линии программа строит очень грубую усредненную прямую - СИНЮЮ линию

Обычно в примерах одна переменная 'х', а предсказывают 'y'. А я хочу найти с двумя 'x1', 'x2' и предсказывают 'y'.

То есть как у меня на картинке, вместо двух осей будет третья.

То есть ищу пример с тремя осями, вместо двух.

Иными словами, я имею ввиду, чтобы было не точь в точь как у меня, а только лишь чтобы было три переменные как на картинке. Какие-нибудь 'x1','x2' и третья которую предсказывают 'y'.

Только я слова для поиска подобрать не могу.

24 Кб, 640x505

24 Кб, 640x505Здравствуйте. У меня задача регрессии. Я хочу на нейронной сети сделать регрессию с двумя входными переменными. То есть по двум независимым переменным предсказывать третью.

В начале я пытаюсь на Keras сделать регрессию с одной независимой переменной 'x' и второй переменной, которую предсказывают 'y', например, для синуса или параболы y=f(x). Всё получается отлично программа предсказывает по точкам правильно и синус и параболу.

Дальше я увеличиваю размерность входных данных для двух переменных z=f(x,y). И получается как на картинке. Вместо правильной зеленой линии программа строит очень грубую усредненную прямую - синюю линию.

ПОДСКАЖИТЕ, ПОЖАЛУЙСТА, КАК НА АНГЛИЙСКОМ ПРАВИЛЬНО НАПИСАТЬ ЗАПРОС ДЛЯ ГУГЛА, ЧТОБЫ НАЙТИ ПРИМЕР НА Keras С ДВУМЯ НЕЗАВИСИМЫМИ ПЕРЕМЕННЫМИ И С ТРЕТЬЕЙ ПЕРЕМЕННОЙ, КОТОРУЮ ПРЕДСКАЗЫВАЮТ?

>Я хочу

Истинно говорят: источник всех человеческих страданий в желаниях. Стоит лишь тебе правильно сделать регрессию с двумя переменными, и ты тут же захочешь регрессию с тремя. Очевидно, это никогда не закончится, и ты проведешь жизнь в бесплодных страданиях, плача и стеная на форумах о том, как твоя регрессия строит неправильные линии. Избавление от страданий придет к тебе только после осознания, что регрессия тебе не нужна.

Это да, я изменил размерность массива х. Просто я для наглядности объяснил, что нужно вторую независимую переменную добавить z=f(x,y) вместо y=f(x).

А так да, лучше было бы объяснить, что нужно y=f(x1,x2) вместо y=f(x1)

100 Кб, 943x903

100 Кб, 943x903 1,1 Мб, webm,

1,1 Мб, webm,640x360, 0:23

>Батч еле в 8 гигов влезает.

Пришло время купить у (((дяди))) оперативку.

>Хуйня в смысле возрастание лосса с падением lr.

Оверфиттинг?

Если лосс на трейне растет, значит ты какую-то вообще лютую хуйню сделал.

Графики осей под подписей - молодец, ведь истинный специалист по ДЛ сразу поймет что у тебя там за хуйня.

Если лосс растет при падении lr, значит lr падает недостаточно быстро.

лосс по-русски называется функция потерь

>>73614

Decay (то есть спад скорости обучения со временем) по логике надо бы увеличить.

Мне другой перевод нравится decay - загнивание. Попробую увеличить, посмотрю.

ну мам

Ты какую-то совсем азбуку ML спрашиваешь.

Математические функции ничего не делают, они вечны и находятся в пространстве идей. Все, что мы делаем, это подбираем с помощью оптимизатора ее параметры так, чтобы она была чем меньше, тем лучше.

Допустим у тебя есть набор чисел x1, x2, x3, и y1, y2, y3 и ты хочешь найти такие k и b чтобы f(x)=kx+b было равно y как можно точнее для всех трех случаев. Это случится, когда мы подберем такие k и b, что

loss(k, b) = (y1 - (kx1+b))^2+(y2 - (kx2+b))^2+(y3 - (kx3+b))^2 будет минимальным. Вот это и называется функцией потерь. Именно у нее мы найдем градиент dloss/dk и dloss/db и будем минимизировать. Как можешь заметить, чем меньше у тебя лосс, тем лучше ты моделируешь, чем больше лосс, тем хуже.

С нейронками происходит то же самое, только вместо f(x) с параметрами k и b и скалярами x и y, у нас нейронка с миллиардами параметров, а вместо xi и yi - тренировочный датасет.

Если лосс-функция минимизирует квадраты разности входа и выхода, это называется l2-loss, если модули разности - l1-loss, можно еще минимизировать еще как-то. И туда же обычно включают разного рода регуляризирующие ограничения на параметры.

> С нейронками происходит то же самое, только вместо f(x) с параметрами k и b и скалярами x и y, у нас нейронка с миллиардами параметров, а вместо xi и yi - тренировочный датасет.

То же самое и в нейрон очках ваших, каждый нейрон считает частную функцию от двух аргументов, а через их суперпозицию получается полная функция от многих аргументов. И лосс так же можно посчитать частный от двух аргументов, а потом общий, через суперпозицию.

47 Кб, 500x500

47 Кб, 500x500>а что деляет оптимизатур?

>а что деляет параметур?

>а что деляет прастранстуво?

>ыыы

>а что деляет датасет?

>егуляезищие ыыы

150 Кб, 1600x935

150 Кб, 1600x935Да вообще пиздец. Такое ощущение, что тут пара-тройка жирных сидит и угарает со скота, который на подобное отвечает.

>нейрон считает частную функцию от двух аргументов

разве не просто складывает значения от базы двух нейронов предыдущего слоя помноженную на соответсвенно вес своего синопсиса?

не ругайтесь позязя я есе мааенький

а что такое суперпозиция?

Ну и как ты продолжишь последовательность чисел (1 5 9 13 ?) без нейросетей?

Скажу, что это случайные числа и что здесь подойдёт любое число.

2,9 Мб, 1920x1280

2,9 Мб, 1920x1280Это норма, настоящая точность на тестовом. Это тоже азбука.

Говорят школьник из из пятого класса нейронки за неделю выучит, это только доктора наук из США считают что нужно образование магистра в информационных технологиях, чтобы изучать эту тему.

>если вообще до этого осилишь

Вот вот я уже 5 месяц учу разные алгоритмы и математические правила для нейронных сетей и это всё чтобы только научиться писать нейронки, не говоря о том что я уже два года провёл за программированием. Как только смогу на дваче тред открою с моей нейронкой или вкину в тему.

2,2 Мб, 2448x3264

2,2 Мб, 2448x3264> Ну и как ты продолжишь последовательность чисел (1 5 9 13 ?) без нейросетей?

Смотри, дебилок. Простая линейная регрессия на копеешном китайском калькуляторе, считаем весь твой числовой ряд попарно (х 1, у 5), (х 5, у 9), (х 9, у 13), затем вводим последний пример из твоего числового ряда, 13, получаем предсказанное значение 17. Угадал? И где твой бог теперь? Я ж говорю, вы ебонажки, не зная азы лезете в какой-то диплернинх.

Почему двух-то. В полносвязном слое - всех нейронов предыдущего слоя, в сверточном слое - в размере ядра свертки, и т. п.

Пчеловод в треде. Без математики не куда.

Ой, да не неси хуйни. Эти моченые ученые 30 лет не могли допереть до того, чтобы вместо сигмоида использовать relu. Они с чем только не ебались, машины больцмана, энтропии-хуепии, DBN, а до такой простой вещи не додумались. А потом оказалось, что lenet с relu и дропаутом можно отмасштабировать и натренировать на мощностях, доступных на супермкомьютерах 90-х, и выиграть imagenet.

Но для этого должна была случиться одна вещь - появились GPU, которые дали возможность тысячам васянов экспериментировать и пробовать комбинировать простые приемы, которые работают.

А моченые ученые выдумывают неработающую хуйню типа капсульных сетей.

В нейронках грамотный датасет решает все. А у ученых такой роскоши нет, если кто-то напишет, что он дописал 10000 примеров к mnist и повысил распознавание цифр до 99.99997%, ему скажут, ну ок, а новизна где, на minst твой метод сосет. А васян может наращивать датасет сколько угодно, поэтому и разработать крутой прикладной продукт.

>бНо я ведь просто червь-пидор по сравнению с ребятами из ШАД например, или даже просто профильных кафедр МФТИ/МГУ/ВШЭ. Кому я нужен то?

>Сам физик изи МИФИ, c матаном +- дружу.

Пиздец с кем я на борде сижу. Меня в вузе только курсовые строчить немного научили да бумагу марать. Посколько я тогда был тупой ещё не сразу понял что мне пиздец, а потом я начал изучать питон, а потом data science, а сейчас когда я начал изучать machine learning я понимаю что моё образование дно и математику я не фига не знаю, понимаю 50-70% формул в machine learning. Ещё когда посмотрю какие задачи на олимпиадах студенты решают по программированию, то зависть берёт, я без гугла не одну олимпиадную задачу не решу.А у меня iq 108-114, а чувствую себя дауном, обидно.

Ходил как то в ШАД, могу сказать что из МГУ и МФТИ реалли очень умные ребята. Если ты в ПТУ вроде Бауманки ходишь, то да, там тебя научат бумагу марать и чужое говно впаривать.

Когда уже в моде васянов будут нейроночки с подкреплением?

1,6 Мб, webm,

1,6 Мб, webm,1280x720, 0:10

Толпы студентов, крутящих гиперпараметры - это ноука теперь, что ли?

у меня iq 104 и я вебмакака

пытался в машинлернинг, но не получилось, для меня тяжело я не очень умный

Оно и объяснимо - чтобы накатать статейку по нейроночам, не нужно вообще ничего: взял датасет, накатал на керасе архитектуру от балды, ну и написал любой нужный вывод. Все равно это говно никто проверять и верифицировать не будет.

Корчеватель во все поля.

> На реддите поговаривают, что мол диплернинг, как научная область, уже стал больше физики по количеству занятых в ней людей. Всей. Физики. Вместе взятой.

И хули толку? Там одни хипстеры, причём ан масс индусы. Поэтому прогресс по-сути зависит от десятка человек типа лекуна. Остальные просто лгбт- балласт.

735 Кб, 1280x996

735 Кб, 1280x996Насколько реально запилить хуйню, которая бы создавала уровни в 3д игре на основе уже созданных уровней другими людьми? Ну то есть нейросеть обучается на реальных картах и пытается высрать свою.

Если такой возможно, подскажите, куда копать? Может кто-то уже занимается подобными исследованиями?

111 Кб, 850x492

111 Кб, 850x492Ты потратишь гораздо больше времени и сил на обработку данных и нейроночку, чем на то чтобы сделать карты руками. Хотя, что-то простое можно попробовать если ты скинешь мне описание карт таблицами [X, Y, Z, объект в этих координатах] или как-то так, ты лучше знаешь с чем работаешь, ну и конечно тебе нужно будет получив подобную сгенерированную таблицу сконвертировать ее обратно в карту.

вот допустим у меня есть битмап

как я понимаю нейронка может или сказать является ли этот битмап чем то или не является

а может ли она сказать четыре координаты из этого битмапа, что между ними находится что-то, например кот?

Может. Для этого даже не нужна нейронка, хаар-каскады отлично подходят для твоей задачи.

Еще раз, можно. Это классическая задача машинного зрения.

В аналоге ЕГЭ через 10 лет будет закон божий, патриотическое воспитание и домострой. Байесовские методы - от лукаваго, в рашке такого не нужно.

домострой годная вещь. глядишь простой анон перестанет хрючевом питаться, научиться жарить картошечку и котлеты.

Как может прогресс зависеть от лекуна, если он с открытия ленет занимался хуй пойми чем? Прогресс двигает как раз толпа, на arxiv-sanity.com постоянно охуенные результаты от нонеймов.

А разгадка простая - отрасль экспоненциально взрывается и всем есть работа. Кроме тебя. Потому что ты тупой.

Это называется object detection, решается с помощью сеток типа SSD

Это не норма. У тебя overfitting на dev set. Увеличь его размер. Проверь, что dev и test содержат данные одинакового распределения.

> Прогресс двигает как раз толпа, на arxiv-sanity.com постоянно охуенные результаты от нонеймов.

Ты дурилка картонная просто и не понимаешь что несешь. Толпа никогда и ни в какой области прогресс не двигала. То, что у одной обезьяны из барбершопа результаты случайно вышли на 0.01% лучше, чем у остальных - это не прогресс. Прогресс - это новые парадигмы, алгоритмы, которые меняют облик всей отрасли.

А че, дип лернинг - это какие-то неебацо новые революционные алгоритмы? Да нихуя, просто комбинация из биг даты, возросшей вычислительной мощности и gpu.

>А че, дип лернинг - это какие-то неебацо новые революционные алгоритмы?

Ну вообще, да. Даже до самых деревянных глубоких архитектур - стыкованных аутоэнкодеров и машин Больцмана нужно было додуматься. Ни один хипстер этого не сделал, хотя те же машины Больцмана известны с 80-х годов. Сверточные сети тоже никто до Лекуна не придумал, хотя неокогнитроны существовали до него, не говоря о перцептронах и работах Хьюбела и Визеля по структуре зрительной коры кошки (что и легло в основу). Борода не делает мудрецом, это еще в древней Греции понимали. И барбершоп мозгов так же не добавляет.

Я ставлю n_jobs=1 и код выполняется за 4 секунды. Ставлю n_jobs=2 и код тоже выполняется 4 секунды.

https://ideone.com/B7KP3n

Помогите, пожалуйста, понять что неправильно. Почему n_jobs=2 не помогает ускориться?

Для дииплернинга тоже нужно оборудование, а еще и датасеты. Вон гугл клепает статьи в промышленных масштабах, а все потому что у них есть и то, и другое.

Почему теоретиков в физике достаточно, и сколько достаточно, а в нейроночках недостаточно?

Обезьян из барбершопа ты сам придумал. Дипленингом занимаются ученые, каждый из которых умнее тебя, и таких тысячи человек. Каждый выдумывает свою часть. А те, кого ты называешь, это, в основном, талантливые организаторы, чье имя по этой причине видно на куче статей.

Для дипленинга ничего особенного не нужно, даже на машине за $1500 можно прекрасно работать, а лаборатория для изучения automl будет стоить сраные по научным меркам $100000 - цена одного интерферометра.

А в физике просто ничего хорошего и интересного не происходит, одно уныние.

Не все обьекты точечные. Есть блоки и любые другие выпуклые геометрические тела с гранями. Есть сетки дисплейсментов.

this.

> Обезьян из барбершопа ты сам придумал. Дипленингом занимаются ученые

Ты их видел, этих т.н учёных? Хипстеры классические. Я понимаю, что сейчас такая мода ебанутая, но все равно смешно с деградантов.

> , каждый из которых умнее тебя,

Не умнее, доводилось переписываться в т.ч с топовыми специалистами. Первый раз слышат такие вещи, которые как по мне, каждая вторая собака знает. За пределами очень узкой специализации кругозора вообще 0, да и в своей области шаг влево - шаг вправо и ответ уровня "i have no idea what энныйтермин stands for", даже чисто на уровне загуглить. Ну и т.д.

>30 лет не могли допереть до того, чтобы вместо сигмоида использовать relu

Я больше чем уверен, что и в нынешних нейронках еще дохрена путей улучшения. Лет через 10 допрут ну как допрут, случайно получится

>но все равно смешно с деградантов.

И в чем заключается деградантство? Это ты похож на бабушку с подъезда или на гопника, которому лишь бы доебаться до внешности.

>За пределами очень узкой специализации кругозора вообще 0, да и в своей области шаг влево - шаг вправо и ответ уровня "i have no idea what энныйтермин stands for", даже чисто на уровне загуглить. Ну и т.д.

Это показатель уравновешенной личности, которая не боится сказать, что чего-то не знает, и не пытается казаться умнее. А вот когда человек начинает судорожно гуглить, чтобы произвести впечатление - тут начинается хуета.

Не, сейчас уже такого не будет, это было, когда в нейронки никто не верил и ими занимались 1.5 яйцеголовых. Сейчас проблема в другом, открытие может затеряться среди кучи говна. Например https://arxiv.org/abs/1802.05074 - говно или нет? Я попробовал, не сработало. Но мне кажется, что где-то там есть много хорошего.

Ты еще скажи что инсепшен говно. Наука не так работает.

Например, я могу спокойно опубликовать 90% своих открытий, которые касаются дл в целом, но не буду публиковать 10% конкретно своей предметной области, чтобы не плодить конкурентов.

>10% конкретно своей предметной области,

Тогда 90% нахуй не нужны. Наука в текущем виде это говно и этого говна особенно много в ИИ. Если ты притащил что то из открытого доступа, варианта джва и все они хуевые.

>инсепшен

В душе не ебу, что это такое

>машобчиком как наукой

Кокая это наука? Скинул все в череый чщик, хорошенько потряс и хуяк, вот на 0.7 обезьяна а на 0.2777 негр

Ты тогда и строительство мостов макакингом обзовешь. Хули, сопромат ведь уже изобрели.

В машобе есть фундаментальные исследователи, а есть прикладные. И фундаментальные не значит святые, зачастую они страдают соверешенно неудобоваримой хуйней, например, задрачивают свои методы для работы на популярных в науке датасетах.

>чем занимаются хорошо если человек 20.

Блядь, да открой месячный топ на arxiv-sanity и посмотри количество фамилий. То, что вы как говнари знаете только о существовании 3-4 фамилий говорит больше о вас, чем об отрасли.

Окей, центр объекта и радиус минимальной сферы в которую он вписывается. Или центр, высоту и радиус цилиндра.

пожалуйста сделайте это в хедер следующей темы. Ещё кота забыл упомянуть.

На хабре было недавно, https://habrahabr.ru/post/350718/

Малореально что-то выиграть на этом, проще rule based генератор запилить

>количество фамилий

Куча макак пытаются из говна слепить мозг макаки, ох лол. Лучше покажи прогресс, да на примере.

Нахуя метать бисер перед свиньей? Хочешь быть неандертальцем типа Карманова, будь им. А я продолжу революцию творить.

24 Кб, 450x353

24 Кб, 450x353>А я продолжу революцию творить.

Ох, лол, кто тут у нас. Образованный, революционер. Вот только предыдущий оратор прав, примеров реального прогресса от ноунейм хипстеров нет, поэтому ты их не смог бы привсти, даже если бы захотел. Ты такой же неандерталец, как Карманов. Я вот тоже кое-что пилю на тему машобчика, и даже не имеющего аналогов и реально с собственными разработками, однако я прекрасно понимаю, что я нихуя не творец по сравнению с титанами мысли. А вот у тебя похоже, ЧСВ реально опухло

Так нонейм хипстеров вы придумали. Прогресс как и везде в науке делают работающие в университетах ученые и их далеко не 20 человек, да и эти "20 человек" зачастую работают как хабы, присваивающие в глазах толпы открытия, сделанные внутри их тусовки.