Это копия, сохраненная 27 февраля 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ https://halite.io/ https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/jobs?q=deep+learning&l=

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Зачем сделали ограничение в минуту? Играть, так играть же.

Цель этой статьи - показать, что альфа зеро превосходит по силе старые методы. Одна минута на ход для этого вполне подходит. Если они будут потом участвовать в каких-то официальных турнирах, сделают так, чтобы работало по турнирным ограничениям.

Местным хейтерам понравится. Вернее, понравилось бы, если бы они понимали английский.

Наверное, только совсем тривиальные. Надо пробовать. Попробуй ты, например. Если что-то выйдет, можешь даже опубликоваться.

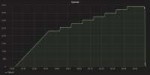

157 Кб, 1198x673

157 Кб, 1198x673НЕЙРОНОЧКИ ЕБОШАТ ДАЖЕ КЛАССИЧЕСКИЕ АЛГОРИТМЫ В РАЗЫ ЛУЧШЕ.

ДО 2Х УСКОРЕНИЕ ПОСИКА ПО КЛЮЧУ ПРИ ДО 15 РАЗ МЕНЬШЕМ ИНДЕКСЕ.

ПОГРОМИСТЫ ПЕРЕУЧИВАЙТЕСЬ НА САНТЕХНИКОВ НА ХУЙ.

СОФТВАРЕ 2.0 СУКА ГРЯДЕТ, ПОКАЙТЕСЬ!

https://medium.com/@karpathy/software-2-0-a64152b37c35

Скрин отсюда:

http://learningsys.org/nips17/assets/slides/dean-nips17.pdf

>Software 2.0 is not going to replace 1.0 (indeed, a large amount of 1.0 infrastructure is needed for training and inference to “compile” 2.0 code), but it is going to take over increasingly large portions of what Software 1.0 is responsible for today.

>ДО 2Х УСКОРЕНИЕ ПОИСКА ПО КЛЮЧУ ПРИ ДО 15 РАЗ МЕНЬШЕМ ИНДЕКСЕ

Допустимо ли предиктор называть индексом?

983 Кб, 2400x1432

983 Кб, 2400x1432> Высокоуровневые языки програмирования никогда не заменят язык ассеблера. Большое количесво кода на ассеблере требуетсмя днаписания компилятора языка высокого уровня.

> Компьютеры никогда не заменят логарифмические линейки. Большое количесво линеек требуетсмя для проектирования и построения компьютера

> Автомобили никогда не заменят лошадей. Большое количесво лошайдей требуется для доставки деталей на автомобильную фабрику!

> Станки никогда не заменят рабов! Множество рабов требуется для того что бы построить один станок!

17 декабря 1903 Братья Райт совершили первый длительный управляемый полёт аппарата тяжелее воздуха с двигателями.

Уже через 40 лет, в воздуже летали реактивные бомбардировщики и лайнры доставляющие пассажиров через океан со всеми удобствами.

Через 20 лет "Программирую на c++" == "Подковываю лошадей"

Как по мне, то это завист от того обеспечивает он 100% точность.

Если да, то он, дефакто, индексом и является(изоморфен), и из него за конечное время можно класический индекс построить обратно.

Ну вот у меня сильное подозрение, что 100% он не обеспечит, иначе это архиватор Бабушкина.

>Через 20 лет "Программирую на c++" == "Подковываю лошадей"

Конечно, ведь есть божественный Rust, а С++ говнище которое не могут до нормального вида довести и уже не смогут. Спасибо комитету по стандартизации и Бьерну Страуструпу

Ну первая ссылка - хуйня для попиариться.

А вот насчет индексов - интересно. Ссылка на ту статью https://arxiv.org/pdf/1712.01208.pdf

Поясните, как тензорслесари байтослесарю, что значит Model Err для B-Tree на Figure 6?

132 Кб, 1020x834

132 Кб, 1020x834Для того что бы говорить о замене страничного индекса эта велични должна быть 1/2 страницы или меньше.

Страничный индекс работает как алфавитный указатель в книге. Он дает тебе ссылку только на страницу, Не на сам слово(ключ) на странице. Но нам ключ на странице есть точно.

Их нейронка дает тебе указатель на конкретное слово в пределах не более (размер страницы пополам) от нужного тебе со 100% гарантией.

Разница в том, что от страницного указателя нужно перебрать размер_страницы записей вперед, а от того, что дала нейронка размер_страницы/2 вперед и размер_страницы/2 назад.

> Спасибо комитету по стандартизации и Бьерну Страуструпу

Комитет не хочет портить обратную совместимость из-за зиллионов уже написанных строк. А не потому что там долбоебы, которые хотят чтобы крестовики страдали.

Очередной плач маняматика о том что де не поверить гамалогиями нейросети. Ну, а кто же виноват, что маняматика настолько бессильная что реальные задачи ставящиеся бизнесом она решить не в состоянии? Промышленности некогда ждать пока аутисты раскачаются и начнуть доказывать первые робкие baby-теоремки, будет тут некоторый элемент алхимии и искусства, обычное дело.

4,7 Мб, 811x409

4,7 Мб, 811x409У тебя два стула выхода.

1. Увеличить присутствие второго класса хоятя бы до 10%, например, сгенерировав фейковые/средние/случайные значения

2. Считать объекты второго класса аномалиями и использовать:

https://en.wikipedia.org/wiki/Anomaly_detection

https://alexanderdyakonov.wordpress.com/2017/04/19/поиск-аномалий-anomaly-detection/

Не надо грязи. Али говорит, что если нельзя доказать теорему, хотя бы демонстрируйте эффекты на предельно простых экспериментах. А если уже начали говорить о чем-то ("internal covariate shift"), то будьте добры определить это, показать его существование, и продемонстрировать его эффект.

Конечно можно. Так же как и на сях только пишешь нейронку на паскале, ну или враппер для слесарфлоу.

Один хрен ничего сложнее С-с-классами не компилируется спустя 10 лет.

есть, в /b

https://www.reddit.com/r/MachineLearning/ -?

Туда и авторы AlphaGo, например, захаживают

>Hi everyone.

>We are David Silver (/u/David_Silver) and Julian >Schrittwieser (/u/JulianSchrittwieser) from DeepMind. We >are representing the team that created AlphaGo.

https://www.reddit.com/r/MachineLearning/comments/76xjb5/ama_we_are_david_silver_and_julian_schrittwieser/

Пойдет?

На v2 еще и тренировать нейроночки можно. Ясно, что это круто, просто пока что это людям недоступно, только крупным конторам. Покупку такой штуки можно сравнить с запуском своего коммерческого спутника, например.

>На Паскале можно сделать ИИ? А как?

Почти все API и так на питоне, куда уж дальше деградировать?

339 Кб, 1341x912

339 Кб, 1341x912Да ладно. Производительность всего 180 teraflops на юнит. У копеечного титана V 110 teraflops.

копеечного для такой производительности.

3 к баксов это ничто. Дисковая подсистема с аппаратным рейдом стоит больше.

Пока что не очень понятно, что под "deep learning teraflops" подразумевается. И памяти там мало. Так что еще смотреть надо, но вообще это хорошо, что разработки идут. Гугловский ТПУ, наверное, не очень эффективен по цене/производительности.

30 Кб, 604x303

30 Кб, 604x303>Пока что не очень понятно, что под "deep learning teraflops" подразумевается.

>Хуанг.

Всем все понятно.

>180 teraflops

и чо, теперь ваши нейронки в 10 раз быстрее нулевой результат будут производить?

Прочитал по диоганале и не понял.

Че уже пишут код нейронные сети?

Когда мне в макдак пиздовать?

Прямо сейчас беги, а то все места займут.

Еще хуже. Код вообще не нужен, его заменяют на нейроночки. Те, кто поумнее уже года три как в маке работают, в менеджеры уже выбились. А когда ты надумаешь, там будет очередь из тысяч бывших кодерков.

>Есть два класса, первого класса в датасете 97%

Недавно участвовал в конкурсе участники конкурсов догадались в каком, где были как раз такие данные. Стандартные ml-методы хреново работают в таких условиях. Копай в стороны детекции аномалий, денойза, детекции выбросов и т.д.

Советую на собесе обговорить возможность заниматься собственно нейроночками, а не только фронтендом. Ты же ради этого туда идешь. Даже если они не особо хотят тебя к этому пускать, если им силно нужен фронтендер, могут уступить и будет уже договоренность заранее. Иначе потом могут сказать, что не твоего ума это дело.

ноуп

Ну здрасти, я на это и буду упор делать. Мол читал книги по алгоритмам в мл, в свободное время накатываю numpy.

Я туда тока для этого и иду, что мне в свое время точно такая же идея, как та, которую они реализуют, в голову пришла, поэтому я буду ммаксимум заинтересован в этом проекте.

Даже если до питона будут со скрипом допускать, я все равно скачаю их проектик (я же для него интерфес буду делать) и разберу код.

В шапке.

>накатывает numpy

>библиотека про умножение матриц

Ну хотя бы соври им, что уже тензорфлоу накатываешь.

А как ты тензорфлоу пользуешься, ничего до этого на нампае не писав? Где предобработка данных, бака?

Меня не забанят на каггле, если я создам второй аккаунт для тестирования решений? Как может это выясниться? Разумеется, в победители не мечу, просто два сабмишена в сутки не хватает для тестирования гипотез.

Вполне возможно. Могут вычислить по айпи или по совпадению решений, например. Раньше абьюзеров удаляли.

Обучающая выборка и так очень маленькая в том соревновании.

>>06858

А каким образом? Я же засылаю результаты, а не код, а они каждый раз отличаются. А айпи может совпадать, если два программиста живут рядом или это общага, например.

Я же не собираюсь брутфорсить решения, перебирая их, я просто хочу, чтобы в день у меня было 4 или 6 попыток вместо 2.

Если засылать с разных айпи, не забанят?

Они регулярно банят клоны, уж не знаю, как вычисляют. Не думай, что ты единственный хитрец.

Если обучающая выборка маленькая - часто используют сторонние данные, обычно правилами это разрешено.

НЕТУ ТАКИХ ДАННЫХ БЛЕАТЬ, ГДЕ Я ТЕБЕ ФОТКИ ОПРЕДЕЛЕННОГО ТИПА СО СПУТНИКОВ НАЙДУ

Ладно, понял, спасибо, надо было раньше начать делать.

новый уровень data augmentation

>Меня не забанят на каггле, если я создам второй аккаунт для тестирования решений?

Забанят и правильно сделают. Это прописано в правилах.

Они ж обе на питоне, подавай выход одной на вход другой. В чем проблема?

664 Кб, 768x448

664 Кб, 768x448https://www.reddit.com/r/deepfakes/comments/7jqvny/release_face_swap_model_tool/

И какой вид нейронки они используют для обучения? Вообще как выглядит схема обучения. В питоне не всегда понятно что и как соединено даже с описанием.

> Посоны, поясните за Q-learning когда комбинаций огромное множество как в шахматах.

Чего тут пояснять, обучение затянется на годы и все. Если бы все было так просто, давно бы уже реализовали. Как вариант, придумать метод оценки результативности во время самой игры, т.е уже по ходу партии как-то отсекать бесполезные ходы. Опять же, вручную это нереализуемо, нужны какие-то эвристики полезности.

Результат можно заценить на pornhub, лол.

Спасибо за ссылку. Сейчас пойдет волна всевозможных фейков. Уходит эпоха человека, похожего на генпрокурора.

Щас бы думать что крупнейшая площадка соревнований по машинлернингу не сможет вычислить наебывающего васяна.

Вангую что это делается в полуавтоматическом режиме, сначала твои аккаунты на основании комбинации подозрительных факторов помечает система, а потом уже его рассматривает под лупой специальный человек

>Тебе книгу по RL тут пересказать или чо? Иди учи основы. Для начала осиль Саттона.

Люди умещают весь этот процесс в несколько строк питона.

дело же не в технологиях, а в людях.

Один из сотни алгоритмов. И без понимания хотя бы на уровне определений, ты все равно не поймешь почему надо делать именно так.

Я прогоняю на комбинациях и пишу на бумажку. Пытаюсь интуитивно понять, как параметры влиаят на процесс, но по сути просто случайно ищу.

Это понятно. Меня больше интересует то, как этот поиск запускается (автоматически?), как наблюдается результат (очеты/графики?), что потом происходит с "лучшей" моделью (автоматический деплой на dev/test/stage-сервер?).

Ну и соответственно: какие инструменты для всего этого must have?

>>08023

Именно тот процесс от которого хочется уйти.

Хорошо, какой использует гугл в Alpha Zero? Например, хочется самому потренировать. Все таки такие задачи интересней, потому что у них нет точной оценки действия.

Прочти статью, там все расписано. У alphazero нетрадиционная тренировка, собственно в ней и заключается прорыв. Вроде бы кто-то на гитхабе делал клон. Но для го или шахмат там годы вычислений на ГПУ требуются.

нужен и пиздец какой. можешь почитать книгу по алгоримтам аи и офигеешь от формул.

Нужна довольно серьезная математическая база. Без нее максимум что тебе светит - бездумно копировать стоки или целые репозитории с готовыми решениями.

А ты можешь какую-то конкретную статью/конкретную главу из конкретной книги по ухудшениям от дропаутов посоветовать?

Батч-нормализация судя по результатам все-таки улучшает.

Не могу. Дропаут - это регуляризация, соответственно можно ожидать более медленной сходимости, например. Вплоть до полной остановки обучения. Еще слышал что на свертках он не работает, но тут не уверен.

Например, ты сможешь правильно применить этот алгоритм, обнаружить и устранить проблемы в его работе, сказать в каких случаях он применим.

тут матан на уровне теорфизики 60-х годов, когда еще толком не вдупляли что такое интеграл фейнмана и как суммировать ряды диаграмм. Что-то работало и давало офигенные результаты которые по-другому не посчитаешь. Что-то не работало, хотя вроде бы все делалось по правилам, но в результате получались какие угодно сечения рассеяний. То же самое и с нейронками сейчас: повезет, решишь задачу лучше человека, не повезет, будешь на уровне тупых алгоритмов из предыдущей эпохи болтаться. Но ждать пока матанщики допрут до этого не вариант: все задачи к этому времени уже решат те, кто не боится обосраться прилюдно.

А в чем публичный обсер? Если получилось, публикуешься, нет - закапываешь и копаешься дальше. В этом вся наука, собственно.

В целом хорошо описал ситуацию.

> Не шаманство, а скорее инженерия, кое-где граничащая с шаманством. Читай шапку.

Да нет, кроме Вапника шаманство и есть. Он ещё в 60х годах выделил 2 подхода к машобу. То, что делает он это сложно, не зря у него ушли десятилетия на получение практически ценных результатов. Гораздо проще шаманить, это даже индусы могут.

ну в том, что например суммировать расходящиеся ряды - зашквар, который учат избегать еще на первом курсе.

ты не догоняешь. Когда математика поймет почему нейронки работают это уже будет в школьных учебниках. Ты представляешь, что алгоритм Hamiltonian Monte Carlo уже в 80х считал квантувую хромодинамику, а почему он работает начали понимать только в 2010х? Или ты только кукарекать про индусов можешь?

> Когда математика поймет почему нейронки работают

Пиздец. Почему они работают, было известно ещё в начале прошлого века. Ещё Маккаллоку с Питтсом. Ещё Розенблатту. Арнольд с Колмогоровым пояснили полностью. Вся суть там в представлении функций от многих переменных через суперпозиции частных функций от двух или около того переменных. Вот и все. Остальное это методы аппроксимации зависимости выхода от входов. Все это сто лет уже известно любому знакомому с математикой уровня выше школьного. Вапник же начал вообще с другой стороны, с постановки задачи обучения машины регрессии, классификации и восстановлению распределения вероятности по датасету, что покрывает вообще весь возможный машоб.

Математика всегда догоняет, смирись с этим. Программы тоже сначала пишут, они работают, и только потом через десятилетия математики кое-как на упрощенных моделях формально доказывают работоспособность.

В том что тут есть от 1 до 3 математикодрочеров, которые упорно форсят что текущий подход говно, нужно засесть за формальные доказательства и разработку мат теорий, а потом уже распознавалки песьих анусов писать.

На деле же этого нет, а есть шаманство и дрочево.

>Дебил ты. Просто дебил

лол, тот анон ппав. как кстати этот ваш черный ящик отлаживается, всмысле дебагинга?

Добавь-ка немного информативности в свои выперды. Что конкретно дал матан нейронкам? Прямой проход - это умножить и сложить, арифметика за третий класс. Алгоритм обратного распространения ошибки? Да его в девятьсот лохматом придумали. Потом надолго затупили на перцептроне. Затем догадались перцептрон по картинке построчно двигать - получилась свертка. Охуеть как сложно.

Сейчас топовая сетка на Imagenet - это NASNet, якобы сгенеренная автоматически. Я смотрю на нее - бред там с точки зрения человека. Типа два ReLU подряд, или Pooling(kernel_size=1, stride=2). Работает как и прежнее говно, но на один процент лучше. Где тут ваш матан, я его не вижу. Точнее, не вижу прогресс благодаря ему.

Честно говоря, на твой вопрос отвечает банальная No free lunch theorem

We have dubbed the associated results NFL theorems because they demonstrate that if an algorithm performs well on a certain class of problems then it necessarily pays for that with degraded performance on the set of all remaining problems.[1]

In 2005, Wolpert and Macready themselves indicated that the first theorem in their paper "state that any two optimization algorithms are equivalent when their performance is averaged across all possible problems".[3] The 1997 theorems of Wolpert and Macready are mathematically technical and some find them unintuitive.

Отсюда и все шаманство, что алгоритм всегда приходится выбирать под изучаемую проблему-пространство. И не существует золотой пилюли.

>No free lunch theorem

Пустая софистика. Из того, что средний анализ мочи / кала / крови по больничке всегда примерно на одном уровне, никак не следует, что анализы не могут служить диагностическими критериями. Хотя бы потому, что оценивается конкретная проба от конкретного поциента.

>не существует золотой пилюли.

Вообще, чисто теоретически выход есть. И я его описывал в этих тредах с полгода назад. Как можно автоматически построить алгоритм под любую конкретную задачу (подобрать параметры уже проще). Есть методы, только те, кто понимает что надо делать, не владеют в достаточной степени кодингом, а с индусов-быдлокодеров что взять. Так и живем.

Энивей, спасибо, попробую увеличить количество эпох.

Ну я так то только вкатываюсь.

Прохужу курс яндексовский на курсере и читаю лекции ВШЭ и Воронцова.

И когда дошло до стенкинга там прям написано: НУ БЛЯ ЕПТ НИКТО НЕ ПОНИМАЕТ ПОЧ СТЕКИНГ РАБОТАЕТ, РАБОТАЕТ И ХУЙ С НИМ

Вот у меня и сложилось впечателение, что если ты не ресерч гай, а простой слесарь в моем случает я просто хотел бы юзать опенсв на сС++ не как обезьяна, то особо глубоко понимать смысл всего этого не стоит.

ты нихера не понимаешь, анон. "Почему они работают" = "почему ожидание функции потерь на тренировочном сете и на тестовом сете различаются на маленькую величину и как она зависит от модели и количества тренировочных примеров". Ты видимо очередной фрик, считаешь что все еще архимед придумал. И Вапника ты видимо не читал, а если и читал то не понял.

Linguistic regularity это называется. SVM не при чем.

Да, word2vec гугли. Для R есть text2vec, тоже может в это. Но оно не всегда нормально работает, хотя в десятке ближайших векторов правильный ответ есть всегда.

И как?

Потому, что вы задрали своими тестами, анкетами, аджайлом и отчётностью в Битрикс24 с оплатой по часам, вот почему.

«Тестовое задание» — это значит, рабовладелец живёт за счёт родителей тех, кого нанимает на работу.

62 Кб, 537x537

62 Кб, 537x537Тащемта, я на linux.org.ru в разделе job это стащил. Вы же сами тут ноете, что работу найти не можете.

3,6 Мб, 1920x1080

3,6 Мб, 1920x1080И еще, насколько трудозатратно будет вкатиться в нейронки, если я не планирую ими зарабатывать, знаю питон, джаву и немного го и работаю ИТ не пограмист ? Хочу сделать генератор обоев с нужной цветовой гаммой. Задолбало ради них интернеты шерстить

Оттуда объяву уже удалили. Нет никакой информации о вакансии, гугл слышал только про одноименную контору в Голландии. Сайт-пустышка. Стремно как-то заниматься таким тестовым заданием.

>Хочу

А я хочу чтобы 15 числа менты оцепили Москву, и начали всячески гнобить хачей и не давать им кучковатся. И что бы хачи разозлились как следует. И чтобы приехал Кадыров на золотом трехэтажном лимузине, и сказал ментам «Идите на хуй». И чтобы менты пошли нахуй. И множество хачей стало собиратся около Европейского, по дороге пиздя всех подряд. И чтобы анон кинул в них бутылки с средством для костров. И чтоб хачи впали в ярость и кинулись терзать подъехавших омоновцев и ввшников, переворачивая и поджигая их автобусы, и насиловалуя женоментов и их немецких овчарок в глазницы. И чтобы разгневанные ноостями футбольные фанаты собрались на другом конце моста Богдана Хмельницкого и повесили несколько хачей на поручнях моста. И чтобы хачи увидели это и кинулись к ним. И чтобы они начали биться за мост, падая с него окровавленными комьями. И что бы лед провалился от веса трупов. И чтобы вконец ебнувшиеся еще летом от жары и дыма планарии стали выпрыгивать из воды и хавать трупы. И чтобы они забили своими разжиревшими телами Москву-реку. И чтобы начался потоп. И ополоумевшие таджики стали выскакивать из заливаемых подвалов со своими грудными таджичатами, кипятильниками из лезвий и горящими метлами, и начали поджигать прохожих и голубей. И чтобы горяшие голуби занесли огонь в Останкинскую телебашню. И чтобы из зала суда вырвался Ходорковский, и вместе с Каспаровым и Шендеровичем, он залез бы на самую высокую башню кремля, и стал кидать в творящийся внизу хаос тысячи сшитых им рукавиц. И чтобы болельщики все дрались и дрались бы с хачами, а хачи дрались между собой, и всех их хуячили бы менты, а ментов бы хуячили подтянувшиеся силы таманской дивизии, которым похуй кого пиздить потому что они загипнотизированы метелью, порхающими рукавицами и горящими голубями. И что бы Путин посреди улицы громко играл на рояле, а Медведев стоял рядом, делал фотки и выкладывал в твиттер. И всю эту хуйню показывали по всем каналам как 9/11. И чтобы хуйня все длилась и длилась, а Путин все играл и играл.

>Хочу

А я хочу чтобы 15 числа менты оцепили Москву, и начали всячески гнобить хачей и не давать им кучковатся. И что бы хачи разозлились как следует. И чтобы приехал Кадыров на золотом трехэтажном лимузине, и сказал ментам «Идите на хуй». И чтобы менты пошли нахуй. И множество хачей стало собиратся около Европейского, по дороге пиздя всех подряд. И чтобы анон кинул в них бутылки с средством для костров. И чтоб хачи впали в ярость и кинулись терзать подъехавших омоновцев и ввшников, переворачивая и поджигая их автобусы, и насиловалуя женоментов и их немецких овчарок в глазницы. И чтобы разгневанные ноостями футбольные фанаты собрались на другом конце моста Богдана Хмельницкого и повесили несколько хачей на поручнях моста. И чтобы хачи увидели это и кинулись к ним. И чтобы они начали биться за мост, падая с него окровавленными комьями. И что бы лед провалился от веса трупов. И чтобы вконец ебнувшиеся еще летом от жары и дыма планарии стали выпрыгивать из воды и хавать трупы. И чтобы они забили своими разжиревшими телами Москву-реку. И чтобы начался потоп. И ополоумевшие таджики стали выскакивать из заливаемых подвалов со своими грудными таджичатами, кипятильниками из лезвий и горящими метлами, и начали поджигать прохожих и голубей. И чтобы горяшие голуби занесли огонь в Останкинскую телебашню. И чтобы из зала суда вырвался Ходорковский, и вместе с Каспаровым и Шендеровичем, он залез бы на самую высокую башню кремля, и стал кидать в творящийся внизу хаос тысячи сшитых им рукавиц. И чтобы болельщики все дрались и дрались бы с хачами, а хачи дрались между собой, и всех их хуячили бы менты, а ментов бы хуячили подтянувшиеся силы таманской дивизии, которым похуй кого пиздить потому что они загипнотизированы метелью, порхающими рукавицами и горящими голубями. И что бы Путин посреди улицы громко играл на рояле, а Медведев стоял рядом, делал фотки и выкладывал в твиттер. И всю эту хуйню показывали по всем каналам как 9/11. И чтобы хуйня все длилась и длилась, а Путин все играл и играл.

начни с себя

> дальше хеллоуворда

ну ты критичен ко мне, я иногда под линуксы программирую, иногда быдловеб, все по большему счету для себя. На работе это все только коственно надо. Хобби у меня такое прос

А вопрос про карту стоящий? Сколько денег на железо нужно потратить чтобы вкатиться в нейронки? И можно ли купить просто специальный компьютер внешний, без переферии, только с видеокартой?

Можно просто купить еще одну видеокарту, ноя этого делать не буду, моей хватает

Я недавно собрал норм комп с 1080ти (топчик для МЛ сейчас по цене/скорости) за 2к грина вместе с монитором. Очень доволен, в перспективе можно поставить еще одну видеокарту.

тренирую сеть из 47 нейронов в одном скрытом слое. Входной слой - 7. Выходной - 1.

learning rate 0.45

библиотека theano.

cpu. Celeron.

10 эпох на 10 экзмплярах тренируются 500 секунд.

Так и должно быть?

Эффект выбросов в тренировочной части и сильно регуляризованной модели.

10 экземпляров, карл. 10 векторов - весь дейтасет. специально обрезал, чтобы посмотреть, за какое время это говно их обсчитает.

>Теано умер, кстати.

а тензорфлоу говно ёбанное, пусть со своим bazelем на хуй идут, раз делать нехуй, кроме как всякое говно без фатального недостатка not invented here втирать.

так что, хоть зайку и бросила хозяйка, он будет живее всех живых. По крайней мере до тех пор, пока гугл будет продолжать толкать свою уёбищную систему сборки.

вот только фиг его знает где. Сеть не моя - я готовую либу взял, которая всё делает и уже засветилась в статье. Ну не в теано он же.

Celeron не новый, а ещё 32х битный. Но я сильно сомневаюсь, что даже на таком целероне может так тормозить.

Ненене, 50с на 10 примеров? Как самый-самый минимум в 1000 раз быстрее должно быть, селерон, не селерон.

Возможно, та либа делает что-то гораздо более тяжелое внутри. Смотри по шагам, сделай сам маленькую нейроночку по туториалу, посмотри с какой скоростью она тренируется.

45 Кб, 525x557

45 Кб, 525x557Есть что-либо готовое, или придется самому собирать коллекцию и тренировать нейроночку? Долго же.

Или лучше вообще найти генератор фотореалистичных лиц, а затем обработать переносчиком стиля для портретизации?

Оупенсорс есть генератор анимешных девочек, если тебе такое подойдет. Прям портретов не видел вообще. Нвидиа сделала генератор фоток знаменитостей, но вроде не оупенсорс. Придется делать самому, скорее всего.

Для игр это было бы шикарно. Если сделаешь, выкладывай.

То есть я запускаю вот так

catboost-0.5 fit --learn-set "samples-catboost-2928.train.tsv" --test-set "samples-catboost-2928.test.tsv" --column-description "samples-catboost.column.tsv" --loss-function "CrossEntropy" --custom-loss Precision,Recall --train-dir "samples-out-CrossEntropy-0.1-6-20-28" --thread-count 5 --snapshot-file snapshot.model.bin --iterations 20 --depth 6 --l2-leaf-reg 28 --learning-rate "0.1" --fstr-file fstr.tsv --fstr-internal-file fstr-internal.tsv

Делаю так 10 раз, переименовывая папки, и у меня получаются модели, которые совершенно по разному обсчитываются на тестовой выборке. Где-то очень хорошо, где-то хуже. Очевидно, что в одном случае модель уходит в over fitting, в другом нет.

Я меняю depth (6 & 9), iterations, learning-rate, l2-leaf-reg, loss-function (между CrossEntropy & LogLoss). И обсчитываю каждую пермутацию параметров 10 раз, но если модель себя правильно показывает на тестовой выборке, я прекращаю обсчёт и перехожу к следующей пермутации.

Правильно ли я понимаю, что можно использовать ту модель, которая хорошо себя показывает на тестовой выборке или мне нужно поделить данные на 70%/20%/10% и тестировать каждую модель отдельно на 20% выборки и отдельно на 10% и только при обоюдных успешных тестах — использовать модель? Или полученные модели вообще нельзя использовать, потому что хорошие тесты это просто совпадения, а модели очевидно всегда в оверфите?

> catboost-

Что-то от яндекса? А с нормальным софтом типа deepboost или xgboost такие же проблемы?

Я начал с xgboost, но он меня подвёл кое в чём, поэтому сейчас трахаюсь с catboost'ом, но принципы-то одни и те же

А тебе из каких-то соображений именно бустинг нужен? Мб там SVM с регуляризацией достаточно или чего-то в этом роде.

данные специфичные. Но мб SVM и сработает

148 Кб, 1152x768

148 Кб, 1152x768>Ваши попытки потратить пару лет на вкатывание в нейронки обречены на провал

Так и есть.

>Через два года IT-пузырь родит новый хайп

Уже рождается. Просто до вкатывальщиков на зекаче волна еще не докатилась. Помогать этому я конечно не буду

Поясни картинку и что там на иероглифах. Хули, cnn, rnn, caffe не обязательно значат диплернинг.

Семен, плиз. Следующий хайп в IT - обучение роботов с ИИ, а дальше уже конец, гибель человечества.

>Семен, плиз

С чего ты решил что я семен, мань?

> Следующий хайп в IT - обучение роботов с ИИ, а дальше уже конец, гибель человечества.

Рановато ему гибнуть, ну и тебя не смущает твой вскукарек, исходя из того что пока промышленное производство редукторов, сервоприроводов и прочей релейтед хуйни для роботов в предзачаточном состоянии? Кроме darpa и пары исследовательских центров этим никто в мире массово не занимается.

Да и хипстеров с подворотами, скачущих по хайповым направлениям, аки твоя матушка по хуям, в обучение роботов не пустят.

>гибель человечества

Ссыканул на всякий случай в любителя примитивных киноштампов.

26 Кб, 672x138

26 Кб, 672x138>что там

Там в комментах все верно переведено. Это китайская разновидность индийских программеров на C++.

>Следующий хайп в IT - обучение роботов с ИИ

ах ну да, все предыдущие хайпы позорно слиты. тот же ocr ох какое дно, не грворя о более сложных вещах.

аж специальность в универы хотят вводить "спец по биткам" лел.

Участники также предлагают Минобрнауки России рассмотреть вопрос разработки и внедрения стандарта профессиональной квалификации «Специалист в сфере блокчейн – технологий».

https://gov-news.ru/роспатент-первый-российский-блокчейн-патент-появится-в-ближайшие-месяцы/

>а как же веб 4.0 на носимых устройствах

Все последние годы веб упорно стремился в тонкие клиенты, а десктопные приложения превращались в сайты. Скоро конвергенция нахуй, а за ней пустота.

>>09642

>промышленное производство редукторов, сервоприводов

Речь шла про хайп в АЙТИ.

>любителя примитивных киноштампов

Никаких Терминаторов и восстания ИИ, у среднего человека просто деградирует интеллект ниже критического уровня с очень нехорошими последствиями в условиях урбанизации и высокой плотности населения.

Вот подтверждение тезиса, что люди тупеют. Интеллектуальная элита - айтишники, повелись на МММ в блокчейне.

>Интеллектуальная элита - айтишники, повелись на МММ в блокчейне.

Айтишники повелись только тем что начинают внедрять блохчейны в любое говно за сотни тысяч долларов. Я бы не сказал что они тупые.

это говно на 32х битах пашет? майкрософтовское говно собралось, но как пашет её не пробовал.

это всё равно что сказать, что все те, кто обучился программированию опоздал. Но ведь это не так. Сейчас это совершенно необходимый навык, нужный каждому. Завтра (уже вчера на деле) к набору этих базовых навыков добавится ML. Кто не осилит - пойдёт на хуй. Кто осилит - не будет чем-то выдающимся из-за этого.

>Вернее, понравилось бы, если бы они понимали английский.

Нейронки местных Антонов настолько плохи что они не могут в ингриш?

Кому "каждому"? Люди школьную программу осилить не могут, а он про программирование говорит.

В реальном мире qc нереализуемо.

Ну и нахуй он нужен кажому? Я бы посмотрел как ты будешь тете зине на кассе объяснять что без навыков писать код она нинужна.

Ей это хозяин кассы объяснит, очень доходчиво, пинком под зад.

Керас проще для простых моделей, питорч для сложных.

Покопался все-таки немного с этой задачей ради интереса. Сложно, не осилил сделать нормально. Тут кто-нибудь пробовал?

Насколько правда, что вкатиться нельзя уже?

Все пишут, что у них, там на WMT такого-то года BLEU такой-то. Я иду на сайт соревнования http://www.statmt.org/wmt15/translation-task.html и вижу там в тест-сетах только по одному референсному переводу, на чем они BLEU считают? Правда на одном референсе или я просто плохо ищу?

Я к ним не буду подаваться, скорее всего, даже если сделаю это задание. Контора слишком мутная. Просто интересно, смогу ли. Там немного замаскированная задача про торговлю на рынке, и у меня не вышло побить их бенчмарк. Вот и спрашиваю, вдруг кто-то смог.

но ведь это чиновники повелись на хайп вокруг блокчейнов.

заебали, попробуй хеллоуворды, если зайдет то продолжай, работу найдешь, этож IT, тут хайпы умирают только среди хипсторов, если оно пришло в энтерпрайз, то протянет еще долго. Если не зашло - нехуй и продолжать, ты же не хочешь ненавидеть то чем занимаешься большую часть времени ?

которые конкурсы выигрывали, какие-то охуенные решения разрабатывают что-то в этом духе.

Или только на двощах пиздите дохуя?

ну так давайте равняться на всяких недоумков.

sklearn.preprocessor - если есть хоть один nan или None бросает ошибку. И разрабам похуй, тикет уже много лет висит. А мне нужно именно с пропущенными переменными - методы обучения отсутствующие переменные обработают.

patsy - лютый пиздец. во-первых коверкает имена и даже отображения старая колонка <-> новые колонки не предоставляет. Ладно, с именами можно ещё вручную поебаться, хоть и заёбывает конкретно, но ... блять, во-первых имена каждый раз разные в зависимости от фаз луны, а во-вторых наборок колонок бывает разный, и не остаётся ничего, кроме полного перебора, обёрнутого в try - except. А без патси нельзя - делает то, что sklearn.preprocess делать отказался. А ещё в этом дерьме почему-то число строк во взодной матрице отличается от числа строк выходной. Но ещё большие проблемы возникают, когда пытаюсь сделть предсказание по регрессии. Ето дерьмо ругается на входной вектор, типа не те типы.

lifelines - либа типа нормальная, но что-то регрессия Кокса выдаёт сумасшедшие результаты.

xgboost - почему-то делает одно дерево глубиной 3 на 4х категориальных переменных, хотя я предоставил дофига численных.

короче, как мне со всем этим говном совладать?

Успокойся и нормально почитай доки прежде чем юзать либу. По тому что ты написал не увидел чтобы авторы где-то выебывались

ну так поделитесь достижениями, а то такое ощущение что тут одни школьники сидят и пиздят

вкотиться могут те кто еще десять лет назад вкотился в матан и прочее.

то есть опция вкотиться есть, но не для всех.

Если ты не из этих, то сорри братан

Двачну. И ведь это совершенно очевидно, но нет, никто из них не засядет за матан. Так и будут тут стенать.

Достижениями делятся на конференциях, в крайнем случае на реддите. Здесь просто потрепаться, обсудить новости или какие-то непонятные вещи. Это же анонимный форум, чувак.

ну если он анонимный, то хуле тебе будет есть ты в одном сообщении с деанонишься. ты же фото с флажком в жопе не выкладывал в itt

> короче, как мне со всем этим говном совладать?

Использовать R вместо пистонопараши. Как вариант, можешь и дальше содомировать хуиту, не могущую даже в корректную обработку nan ов.

вот r - это и есть хуита хуит. Чтобы решить такую простую задачу, как парсинг числа из строки (число в хексе) пришлось конкретно заебаться. Выяснилось, что в r из коробки этого нет, после чего язык был послан по адресу.

104 Кб, 570x960

104 Кб, 570x960 39 Кб, 222x238

39 Кб, 222x238Ух ты, Go даже тут рулит, педалит и нагибает! А они мне говорили: язык для дебилов, язык для дебилов. Вон, уже просторы нейронных сетей во всю бороздит!

Чушок, вернись в свой загон. В машобе рулит, педалит, нагибает и будет продолжать с++ и биндинги на пистон. Все остальное не более чем игрушки(разве что r еще). Я посмотрю как ты свою парашу будешь юзать на мобилках и полностью переписывать современные промышленные решения лишь бы можно было корутинами в жепу поебстись.

Хотя наверное ты просто шутканул про первую пикчу, а я пропиздоглазил. Но тем не менее видал goвнарей с похожими заявлениями.

Тогда почему твоих чудокрестов даже на графиках ОПпика нет? Ммм? Соснул, крестоблядь?

больше похоже что он сам лажонул

2,1 Мб, 3648x2736

2,1 Мб, 3648x2736Придется размечать начальные фотки вручную?

Я один не вижу разницы между этими червями (что слева, что справа, что по центру)?

Смешная шутка.

Даже для этого вопроса тебе нужно их разметить, т.к. я в упор не вижу никакой разницы между теми, что справа, слева и по центру.

Допустим у нас есть готовая программа, которая однозначно классифицирует твоих червей смотри конкурсы про тюленей и сортировку рыбы. Что ты дальше будешь делать с результатом классификации? Сортировать их по баночкам?

На глаз не проще? Из пушки по куколкам воробьям. У тебя же не конвейер. CNN, object recognition, вот ето всё. Только тебе дохуя примеров надо самому разметить

>Что ты дальше будешь делать с результатом классификации? Сортировать их по баночкам?

Вы таки победитель "битвы экстрасенсов"?

А так да, мелких сразу в корм, крупных селекционировать, средних для поддержания текущий популяции.

3,2 Мб, 3648x2736

3,2 Мб, 3648x2736Так раскладывать все равно руками, там и определишь. Или как ты это себе представляешь? Если мечтаешь о роботизированной системе, лучше сразу забудь. Там работы на годы будет для целой команды специалистов.

>А так да, мелких сразу в корм, крупных селекционировать, средних для поддержания текущий популяции.

Думаю в твоем случае задачу стоит решать механическим способом. Как на заводах сортируют овощи, орехи и прочее. Сито разноячеестые и т.д.

Какое научное название твоих насекомых?

http://droicelabs.com/

как же печет.

Они вообще-то на рашкованьках обкатывать технологию будут. Там в вакансиях требование русского языка есть.

>Deep is a certified white-hat hacker (version 7).

>ГДЕ МОЙ ТРЕТИЙ УРОВЕНЬ ОБАЯНИЯ И СВИНЬЯ ДЕВЯТОГО УРОВНЯ СУКИ БЛЯДЬ????????

Это к ним вебмакака решила внедриться и украсть модель? Вангую что эта модель появится очень нескоро.

Watson с той же идеей уже лет 10 IBM пилит. А идея она довольно простая. Даже я на первом курсе хотел написать какую-нибудь базу данных с картами пациентов, чтобы врачам было удобнее смотреть какие лекарства помогли, а какие дали осложнения, и чтобы более точно диагнозы ставить. Конечно я хочет чтобы это потом всё в нейроночку да с AI, но тогда я даже не знал как к этому подступиться.

Дрочишь на них?

166 Кб, 960x640

166 Кб, 960x640>250 руб/100 грамм.

Ну нахуй. Мраморная говядина гораздо дешевле. Я понимаю, если бы твои черви полтос за кило стоили.

Да они на вкус как мел. Не сказал бы что такие уж вкусные. Пробовал как-то жаренных в тайланде.

Еще пару лет назад я их продавал по 400р/100 грамм, но появились пидорасы-конкуренты - цены снизились, объемы упали.

>>11026

Я конечно знаю, что они съедобны, но за те годы, что их держу так и не удосужился попробовать. Продаю их как корм для животных - хомячки, попугайчики, игуаны там, лемуры всякие. Хотя их уже и в святой Европке едят.

40 Кб, 604x302

40 Кб, 604x302>пару лет назад я их продавал по 400р/100 грамм, но появились пидорасы-конкуренты - цены снизились, объемы упали.

Несколько лет назад в /ne был тред, чувак гровил крупных жуков на продажу, он там писал, что в атмосфере с повышенным содержанием кислорода они пиздец крупные растут.

ну так несовершенство дыхательной системы - основной ограничитель предельного размера насекомых

прыщи

а что это за червячки? сделой сито с разными дырками или трубу через которую им нужно проползти, так и отсеишь.

Есть несколько фреймворков, поддерживающих кресты. Посмотри здесь, например:

https://github.com/tiny-dnn/tiny-dnn/wiki/Comparison-with-other-libraries

https://github.com/josephmisiti/awesome-machine-learning

Лично я бы, будучи привязанным к крестам, взял бы tiny-dnn, если не нужен ГПУ, и Darknet, если нужен.

Совсем уровня туториала - распознать мнист. Далее можешь усложнить. Например, пусть на картинке неколько цифр, и нужно определить их количество и распознать. Хардмод - если цифры могут пересекаться. Можно добавить шум. Используй какие-нибудь передовые методы из относительно свежих статей, и будет норм для диплома, да и в сиви потом хорошо пойдет.

Я не знаю, слишком много факторов. В принципе это возможно. Посоветуйся с научником.

Геморно проверять. Прогресс в нейронках не их дело, им главное показать, какая точность в принципе возможна. Далее заказчик сам разберется, на какой компромисс по вычислениям/точности он готов пойти.

>никакого прогресса в нейронках.

Там и не будет никакого прогресса, т.к. это асимптотически-эффективные алгоритмы. Вапник еще в 60х годах за это пояснил с математическими пруфами, сейчас мы просто наблюдаем это на практике - у кого фермы из титанов / кластеры больше, тот и крут. Умным людям и 50 лет назад было очевидно, что все эти индусско-хипстерские игрища - путь в никуда.

Страдай, хуле.

>петухи с фермами из титанов выигрывают

Манямирок неосилятора. Ты всегда можешь объединиться в команду с тем у кого есть лишнее железо, если у тебя есть годные идеи. Но у тебя идей-то нет.

Пол мира дрочит на биток. Хотя могли бы протеины высчитывать например. Обьединение не имеет смысла пока не несёт профита.

Ну последний комент мой, а я мимопроходил. Так что жди пока тот анон ответит.

Суть объединения в команды - либо нарастить мощность железа, либо собрать ансамбль из моделей, что опять-таки равносильно увеличению мощности железа. Здесь нет никаких новых идей, это не прогресс, это заведомый тупик. А соревнования в нынешнем виде этот путь поощряют. Это неправильно.

мдауш

471 Кб, 850x583

471 Кб, 850x583Для того, чтобы хотя бы подобраться к правильной формулировке вопросов, тебе предстоит многое изучить. Можешь начать с "Plato's Camera: How the Physical Brain Captures a Landscape of Abstract Universals" Черчленда.

>Невозможно написать программу для машины Тьюринга или любой другой универсальной вычислительной машины, которая была бы способна имитировать работу человеческого мозга и, таким образом, имитировать в любых ситуациях поведение человека. Этот аргумент можно сформулировать и несколько иначе, в виде утверждения, что человек обладает способностью решать алгоритмически неразрешимые проблемы

Нейросеть обладает возможностью решать алгоритмически неразрешимые проблемы. При том что нейросеть тоже алгоритм. Остальное можно не читать.

Эти ссаные философы ни в чем не разбираются, но лезут во все области науки. Гоните философов, насмехайтесь над ними.

А в чем проблема-то? Нейросеть работает с любыми данными на входе, значит обработает любые ситуации. Уж точно не хуже человека, который в нестандартных ситуациях тупит практически всегда.

Ты как себе представляешь ансамбль сеток для всего? Это какие вычислительные мощности нужны?

>тупит практически всегда

Ага, первое время. А потом очень быстро адаптируется.

>Это какие вычислительные мощности нужны?

Ну хотя бы как у мозга человека. Или ты хочешь ИИ на 1080? Так не бывает.

Да, и нужно добиваться большей генерализации, тогда требуемый объем сеток сильно сократится, а их производительность увеличится. Это хорошо видно на человеке с развитыми логическими и аналитическими способностями.

Пример алгоритмически неразрешимой задачи, которую спообен решить человек или нейросеть?

Это вопрос к Гёделю, с чего он взял, что такие задачи есть

Не трогать их, идти подскакивать кабанчиком в бизнес.

И то, и другое, это обертка вокруг сишных библиотек, разницы нет.

аноны, вопрос.

1 вот есть xgboost. Как его заставить предсказывать векторы вместо скаляров, используя одни и те же деревья, градиенты и хессианы?

2 есть ли либа для питон градиентного бустинга любой модели, а не только деревьев, если я предоставлю градиент и гессиан?

а вот меня не хуй послали, сказали "ты хочешь майнить битки на нашем компе, на хуй пошёл", хотя я им реально объяснил, что не для битков, а для нейросети.

Лучше пистона в разы.

1. Никак. Кроме того, в предсказаниях не используются градиенты и хессианы.

2. Не знаю посмотри sklearn. Для градиентного бустинга не нужен ни градиент модели, ни хессиан. Нужна только сама модель, т.е. функция fit, и функция потерь вместе с ее градиентом.

> R хорошая технология? Можно даже не просматривать на питон?

R это изначально язык обработки данных, тогда как пистон нет. Отсюда, весь машоб в Пистоне это костыли.

> 1 вот есть xgboost. Как его заставить предсказывать векторы вместо скаляров, используя одни и те же деревья, градиенты и хессианы?

Хгбуст это miso модель, множественный вход и единственный выход. А тебе нужно mimo, множественные как вход так и выход. Суть в том, что любая mimo модель представима как совокупность отдельных miso моделей, посчитанных на одних входах для разных выходов (компонент твоего вектора).

зачем эти протеины нужны? очередное биологическое ненужно же

773 Кб, 1212x388

773 Кб, 1212x388Пора напомнить очередным ньюфажикам положение R-параши

Эх, а ведь где-то новогоднюю версию проебал. Ебаный андроид, не может в сохранение картинок на сдкарту.

>1. Никак. Кроме того, в предсказаниях не используются градиенты и хессианы.

Если я хочу дать кастомную objective function, то туториал говорит передать функцию, которая вернёт кортеж из градиента и хессиана objective функции в данной точке.

>2. Не знаю посмотри sklearn.

Спасибо, но вроде смотрел, нет.

>Для градиентного бустинга не нужен ни градиент модели, ни хессиан. Нужна только сама модель, т.е. функция fit, и функция потерь вместе с ее градиентом.

Да, но xgboost требует это. Видимо предоставление в явном виде эффективнее, чем численное дифференциирование.

>>12062

я хочу сделать, чтобы xgboost бустил коэффициенты нелинейной регрессии.

То есть выдавал вектор коэффициентов регрессии для указанного экземпляра (вектора ковариатов). То есть вот у меня регрессия Кокса. Коэффициенты регрессии - это риск. вектор коэффициентов умножается скалярно на вектор ковариат и произведение ставится в экспоненту. Ковариаты нелинейно зависят друг от друга. Проблема тут в том, что для смеси разных страт (групп экземпляров, где работает модель кокса) эта модель может не работать - то есть коэффициенты будут разными для разных страт, а коэффициенты от регрессии на смеси страт вообще бредом будут. Истинные коэффициенты я не знаю - их и надо подобрать. Возникла идея заюзать tree gradient boosting c кастомной objective function - той же, что и для регрессии. Для регрессии всё равно нужен гессиан с градиентом, то есть функция, их считающая, уже у меня есть. Надо теперь знать, когда бить на страты. Мне кажется, что градиентный бустинг деревьев сможет разбить на страты в зависимости от ковариатов. А считать коэффициенты той же регрессией. Цель - предсказывать коэффициенты регрессии по ковариатам.

Вообще, что посоветуете? Нейронку уже пробовал, не обучается она. Да и dataset маловат.

Твоя модель выглядит вполне как нейроночка. С одним нейроном будет один набор коэффициентов, с двумя - два и т.д. Распиши математически свою модель и сам увидишь. На питорче можешь ее записать буквально так, как и на бумажке, и подгонять коэффициенты градиентным спуском. хгбуст тут ни к чему, по-моему.

Все наоборот

Ещё раз посмотрел sk-learn, там действительно есть общий градиентный бустинг, погуглил и набрёл на градиентный бустинг деревьев, скрещенный с регрессией Кокса. Не уверен, что это то, что нужно, так как пока ещё не смог вывести результаты в графическом виде. Работает чертовски медленно, всё таки не xgboost, api крайне непонятное: то ему pandas.DataFrame не подходит, то даже простой numpy.ndarray не то. Видимо придётся дорабатывать напильником. Вот только результаты нуужны были ещё в прошлом месяце, а сейчас уже поздно, я просрал все полимеры.

Или скорее всего я херовый data scientist. Вместо этого пихает несущественные признаки в корень деревьев. Concordance 60%. 50% - это если бы был случайный результат. Я же ожидал (не посчитано, просто угадываю) как минимум 75-90%.

Порезал лишние признаки. Если опять не осилит - пойду дальше хренью страдать.

3 дерева глубиной 10 на lr 0.1 без dropoutа дают concordancce 74. Экспериментирую дальше. Поставил learning rate и dropout по 0.5.

ты скозал

Слесарьплов жи.

26 Кб, 1000x500

26 Кб, 1000x500Вот допустим у меня есть пик, построен на агрегированых цифрах. Цифры у меня все есть, как агрегированые так и нет. Я хочу определить интервалы ступенек. Куда копать ? Ступеньки не всегда идут вверх, не всегда равны и обладают погрешностями. Куда копать ? А то судя по тому что мне гуглится, проще отрендерить такую же картинку и натравать на нее один ихз примеров. Ну и да, простой алгоритм который if-ами находит их на основе отклонения от предыдущего значения у меня уже есть, просто хочу попробовать сделать это хайповыми штуками нейронками

если не отговорю себя, буду использовать Keras. Питон вроде знаю

>Я хочу определить интервалы ступенек. Куда копать ?

В направлении скользящих средних и отклонения от них.

И сразу вопрос, относительно чего у тебя распознаются ступеньки. На одном масштабе у тебя 8 ступенек здесь, а в другом масштабе — АДЫН СТУПЭННЫК БИЛЯТЬ.

>В направлении скользящих средних и отклонения от них.

круто, пойду гуглить

>И сразу вопрос

не факт что я тебя правильно понял, но вот то что на графике это весь датасет который уйдет алгоритму, раньше/позже связаных с ним данных нет. При чем датасет может быть на временном интервале и 2ч как на пике, так и 8ч и с одной ступенью или вообще 24ч. При этом я не должен этого явно задавать. В алгоритм просто

Человек способен время примерно так почувствовать.

Вот прям сейчас возьми шар и попытайся запихнуть. Если сможешь - все у тебя получиться. Нет - даже не пытайся.

На самом деле и с вышкой бакалавра вкатиться практически анрил

Мне поможет опыт игр на заднем дворе и смазка, все просто.

А почему анрил-то? В треде никого работающего нет?

Я обучаемый, если что, математику уважаю.

Я сюда заглядываю практически с первых тредов. Кроме очевидных кукаретиков и парочки школокаглеров и отчисленных из ШАДа тут проскакивало только 2 работающих анона, один из них был аспирантом(хз работает ли он сейчас в мл). Зато тысячи вопросов о вкате и том какой вопрощающих супер-пупер мотивированный и нитакой как все. Максимум через месяц они куда-то отваливаются. Выводы делай сам. + Практические во всех вакансиях(зарубежных) нужен мастер, а у нас как минимум ищут синьоров с парой лет опыта работы в МЛ/ДАТАСАЕНС.

Конечно каких нибудь йоба каглеров с золотыми медалями возьмут и без диплома, но это сам понимаешь, элитка.

Моя аналогия с шаром была рассчитана на тех, кто не имеет опыта игр на заднем дворе, но походу на двачах таких таки нет за исключением меня

331 Кб, 1058x1521

331 Кб, 1058x1521>В треде никого работающего нет?

Ну вот я работающий например.

Для того чтобы работать в МЛ-рилейтед области кем-то кроме оператора-размечатора нужно минимум освоить университетскую программу и въебать гору времени в самообразование. Гору - это не месяц-два позадротить с целью пройти собес, а систематически учиться, уделяя этому своё личное драгоценное время.

Всё машинное обучение - это дрочка на минимизацию функций многих параметров, без _понимания_ того что происходит внутри основных алгоритмов (для чего нужен хороший матан, линалг и теорвер с матстатом) твои занятия МЛем ограничатся сценариями уровня

- ну вот тут я свм хуйнул, а тут xgboost'ов настакал, что-то напредиктило

- а почему именно так сделал

- эээ..

Если ты не осилил учебу в вузе то вероятность что ты станешь годным спецом в мл стремится к нулю - без обид. Сейчас и в других областях можно хорошие деньги поднимать, и много где не надо для этого ебать себе мозги матаном.

Ты можешь попытаться, но предупреждаю - вероятность успеха мала. Не ведись на хайп.

вот-вот, нахуй эти нейронки нужны, когда можно веб макакингом столько же если не больше рубить.

к тому же у работающих анонов нет времени эту поебень задротить, там кучи матана, книг, накатывания либ, да и пистон со фласком ковырять фу.

У тебя странное определение нахуйнужности. Я занимаюсь МЛем потому что мне это интересно, а не потому что там платят. Исключительно ради получения большего количества бабла - да, нинужно. Само по себе - интересно и нужно.

Но про пистон конечно да, писать на этой параше что-то сложнее чем from slesarlow inport * нестерпимо отвратительно.

>Я занимаюсь МЛем потому что мне это интересно

ты ебанутый, чел. проверься у психиатра. я смотрю аниму и занимаюсь сексом, потому что мне это интересно.

Для того чтобы работать в МЛ-рилейтед области кем-то кроме оператора-размечатора нужно минимум освоить университетскую программу и въебать гору времени в самообразование.

Первых двух курсов хватит же, плюс несколько книжек специализированных.

Вкатываюсь уже полгода потихоньку, думаю, года через два-три приду к успеху.

Ты неправильно меня понял. Я не "не осилил учёбу в вузе", я скорее не захотел тратить на это 4 года жизни в 21м-то веке. По баллам егэ мог подавать документы хоть в МГУ.

Но благо большинство погроммистских ваканский сейчас не требуют корочки, чисто работу найти не составляет труда.

Другое дело, что меня всё ещё интересует наука и работать над МЛ я хочу из этого побуждений, а не денег.

>Зато тысячи вопросов о вкате и том какой вопрощающих супер-пупер мотивированный и нитакой как все.

О, я как раз такой, выпизднут с третьего курса ПМИ, перекатываюсь из скриптомакакинга, нихуя не шарю впрочем имею неплохой математический бекграунд, матан там, линал, тервер, матстат, замотивирован по самые помидоры. А ты тут такой кайфоломщик, говоришь мол, много вас таких по весне оттаяло.

Сам матан (калькулюс) само собой.

Чего почитать, что попробовать накодить и тд?

Компьютерное зрение неудачный вариант для новичка из другого отдела. Область сложная, возможностей мало, работы тоже мало, а на каждую вакансию десяток макак. Сейчас каждый школьник учит OpenCV, а потом не знает что делать с ней. Лучше попробуй Haskell. На нём и конкуренция пониже, и зарплаты больше, и сам язык понятней. Если никогда не занимался программированием, то начинать лучше всего с Haskell. Работы полно, платят отлично. По книгам. Если есть хоть немного знаний программирования, читай это: http://www.ozon.ru/context/detail/id/30425643/ Если совсем новичок, пойдет эта книга: http://www.ozon.ru/context/detail/id/28346038/ Ну и куча онлайн-учебников. Вот, например: https://anton-k.github.io/ru-haskell-book/book/home.html Хороший учебник, всё расписано подробно. Сам по нему учился. Рекомендую.

Это такой толстый троллинг?

Пиздец, одни тут говорят о том что ФП всех заменит, другие что нейронки. А на деле нихуя не изменится.

30 Кб, 680x510

30 Кб, 680x510>Ты неправильно меня понял. Я не "не осилил учёбу в вузе", я скорее не захотел тратить на это 4 года жизни в 21м-то веке. По баллам егэ мог подавать документы хоть в МГУ.

А я не зафейлил собес в гугл, скорее не захотел тратить на него 5 лет жизни в 21м веке. Не обосрался, просто говно из жопы вывалилось, так сказать.

Баллы егэ это вообще пушка, если ты понимаешь разницу между "мог подать документы" и "получил образование".

>Другое дело, что меня всё ещё интересует наука и работать над МЛ я хочу из этого побуждений, а не денег.

Тебя не интересует наука, тебе просто кажется что ты умнее остальных и МЛ дастся тебе просто так, без усилий, а конкретно МЛ ты избрал объектом своей самореализации из-за хайпа который сейчас вокруг него есть.

Среди моих коллег абсолютно все кто хоть как-то занимается МЛем имеют минимум бакалавра/магистра или учатся на них в данный момент, причем не в шарагах а в более менее нормальных вузах. И имеют их не ради корочки.

Так что, не занимайся самовнушением - ты выбрал свой путь когда решил что четыре года опыта клепания гостевух важнее системного образования. В ушедший поезд уже не сесть.

В чем смысл заниматься такой демотивацией, как ты это делаешь здесь? Боишься конкуренции и демпинга со стороны людей, которые не нюхали 5 лет пыль за партой и не будут требовать денежки за свои бесполезные титулы? Стоило сделать профиль со словом саентист, как всплыли всякие "ученые", которые хотят вернуть своему бечполезному образованию ликвидность. Вед это же не макакинг а "саенс", и их бесполезные годы в шараге вновь обрели смысл.

Без обид, просто умный человек не будт демотивировать людей на пустом месте.

53 Кб, 369x480

53 Кб, 369x480>умный человек не будт демотивировать людей на пустом месте.

Разумеется. Только я не на пустом месте такую полемику начал, а строго после охуительной комбинации из "не захотел тратить 4 года жизни на учебу" (еще и сдобренное пренебрежительным "в 21м веке", будто в нашем веке модно быть долбоёбом) и "меня интересует наука".

Смысл заниматься демотивацией в том что у того анона в голове ветер а в жопе дым, возможно моя токсичность сэкономит ему немало времени. Очевидно что он ведется на около AI-шный хайп - а это путь в никуда (вестись на форсы, я имею ввиду).

>Боишься конкуренции и демпинга со стороны людей, которые не нюхали 5 лет пыль за партой и не будут требовать денежки за свои бесполезные титулы?

Мне платят не за красный диплом а за компетенцию - так что нет, не боюсь. Так же как не боюсь орд вкатывальщиков в ойти.

>Стоило сделать профиль со словом саентист, как всплыли всякие "ученые"

Тут бесспорно, пройти пол курса на курсере, натренить мобайлнет на фотках своей мамаши-шлюхи и выставить себе тайтл "саентист" - верный детектор долбоёба. Хинтон - саентист, Воронцов саентист, Вапник саентист, а я вот простой (почти) инженер.

>хотят вернуть своему бечполезному образованию ликвидность

Если для тебя любое образование - бесполезное, с тобой не о чем разговаривать. Годное системное образование (а не тир-3 шарага-"колледж" в залупинске) всегда будет ликвидно. И да, я еще не встречал случаев когда люди обучились математике (а весь МЛ суть она) по онлаен курсам или сами - это та область где нужны учителя.

>>14024

>Тогда что посоветуешь?

Посоветую не вестись на хайп, объективно оценивать свои возможности и искать _интересную_ работу. В отличии от МЛ, быть годным в коммерческом погромировании можно (хотя и сложнее) и без специализированного образования.

Если тебе прям пиздец как хочется - устройся в мл-рилейтед компанию или проект, и посмотри что оно такое изнутри, а потом решай надо ли тебе тратить время на то чтоб долбиться в эту стену.

>Накатить игор и скроллить /b/?

В /b/ рекомендую не заходить, адекваты кончились 5 лет назад и раздел действует на психику весьма хуево. В игры можешь играть, но не много.

53 Кб, 369x480

53 Кб, 369x480>умный человек не будт демотивировать людей на пустом месте.

Разумеется. Только я не на пустом месте такую полемику начал, а строго после охуительной комбинации из "не захотел тратить 4 года жизни на учебу" (еще и сдобренное пренебрежительным "в 21м веке", будто в нашем веке модно быть долбоёбом) и "меня интересует наука".

Смысл заниматься демотивацией в том что у того анона в голове ветер а в жопе дым, возможно моя токсичность сэкономит ему немало времени. Очевидно что он ведется на около AI-шный хайп - а это путь в никуда (вестись на форсы, я имею ввиду).

>Боишься конкуренции и демпинга со стороны людей, которые не нюхали 5 лет пыль за партой и не будут требовать денежки за свои бесполезные титулы?

Мне платят не за красный диплом а за компетенцию - так что нет, не боюсь. Так же как не боюсь орд вкатывальщиков в ойти.

>Стоило сделать профиль со словом саентист, как всплыли всякие "ученые"

Тут бесспорно, пройти пол курса на курсере, натренить мобайлнет на фотках своей мамаши-шлюхи и выставить себе тайтл "саентист" - верный детектор долбоёба. Хинтон - саентист, Воронцов саентист, Вапник саентист, а я вот простой (почти) инженер.

>хотят вернуть своему бечполезному образованию ликвидность

Если для тебя любое образование - бесполезное, с тобой не о чем разговаривать. Годное системное образование (а не тир-3 шарага-"колледж" в залупинске) всегда будет ликвидно. И да, я еще не встречал случаев когда люди обучились математике (а весь МЛ суть она) по онлаен курсам или сами - это та область где нужны учителя.

>>14024

>Тогда что посоветуешь?

Посоветую не вестись на хайп, объективно оценивать свои возможности и искать _интересную_ работу. В отличии от МЛ, быть годным в коммерческом погромировании можно (хотя и сложнее) и без специализированного образования.

Если тебе прям пиздец как хочется - устройся в мл-рилейтед компанию или проект, и посмотри что оно такое изнутри, а потом решай надо ли тебе тратить время на то чтоб долбиться в эту стену.

>Накатить игор и скроллить /b/?

В /b/ рекомендую не заходить, адекваты кончились 5 лет назад и раздел действует на психику весьма хуево. В игры можешь играть, но не много.

Мое мнение об образовании - оно про российские реалии. Хорошо, если студент получит хоть какой то знание необходимых скиллов в духе линейной, статистики и прочего. Это в лушчем случае. Остальное вообще неясно зачем нужно. Может в мгу есть смысл обучаться, я не знаю, я там не учился.

Согласен с тобой на 90%, но вот с этим нет:

> И да, я еще не встречал случаев когда люди обучились математике (а весь МЛ суть она) по онлаен курсам или сами - это та область где нужны учителя.

Если мы говорим о прикладном ML - для применения в своих продуктах, то там всё равно есть разделение на учёных теоретиков и инженеров/ программистов. В первую категорию без образования не попасть, само собой. Да и с образованием далеко не все с этим справятся. А вот во вторую категорию вполне себе можно пролезть, если у тебя нет проблем со школьной математикой и ты шаришь а алгоритмах (путь не топовый олимпиадник, но задачи второго дивизиона решаться уметь ты должен).

Итого, теоретики дают направление, подсказывают новые методы, следят за методологией и всё в таком духе, разработчики же разработают. По крайней мере, так это было в Яндексе.

Мне лично приходит в голову аналогия между кодерами и архиторами. Если есть скииллы и опыт, то сам сможешь вырасти, даже и без формального образования.

Ясно. Ты недооцениваешь мою силу и детерминацию. Всего доброго.

Кстати, если кому мой опыт интересен, то я в ML вкатился благодаря курсам Андрея Нг и своему опенсорс проекту по теме. В универе мне давали все эти вещи слишком теоретически, я вообще не имел понятия как всё это используется на практике. Так что, курсера сильно помогла.

66 Кб, 400x325

66 Кб, 400x325>Ты недооцениваешь мою силу и детерминацию

>боевые картиночки в ответ на советы

>неспособность воспринимать критику

Есть и кое-что что я переоценил - уровень твоей культуры общения и, скорее всего, возраст.

>Тебя не интересует наука, тебе просто кажется что ты умнее остальных и МЛ дастся тебе просто так, без усилий, а конкретно МЛ ты избрал объектом своей самореализации из-за хайпа который сейчас вокруг него есть.

Двачну, очень точно выразил суть вкатывальщиков, помню даже времена когда точно такое же было, но по отношению ко всяким СПАРКАМ, СКАЛЕ, БИГ ДЭЙТА.

>>14034

Нет не имеет.

Универ на самом деле дает плюшки, какой-то системный подход к обучению. Я хорошо вижу эту хуйню по друзьям, которые в шарагах не учились. С теорией там все очень хуево, да и обобщающая способность нейронок мозгов как-то слабовата, могут задрочить хорошо какие-то скилы, но в нестандартной ситуации всегда фейлят.

Ну и матан тебе универ дал какой-никакой, так что тебе легко кукарекать.

Что не отменяет того, что не топовые рашкоуниверы параша ебаная, все полезные вещи которых можно ужать до 1 года обучения.

44 Кб, 1000x405

44 Кб, 1000x405Ты просто спутал меня с классическим двачером-кукаретиком, который думает, что можно делать нихуя, а всё будет. Бывает. Ты так же пытаешься отыскать оправдание себе и своим друзьям с вузовским образованием, доказать, что в этом есть нечто стоящее. Про 21й век упомянание имело в виду то, что сейчас информации по любой теме просто до жопы, какой смысл приковывать себя к программе вуза, с неоптимальным темпом, профессорами, лишними предметами? За 4 года возможно достичь в несколько раз больших высот.

Мой изначальный вопрос вообще состоял не в том, смогу ли я интеллектуально достичь уровня среднестатического дата-саентиста, с этим проблем нет; он состоял лишь в том, насколько адекватны компании, которые берут к себе на работу этих саентистов, понимают ли они вышеуказанные тезисы про вышку или нет, дропают ли они резюме автоматически без графы про вышку или дают шанс показать себя.

Лол, хули ты тут так мечешь и доказываешь что не верблюд? Тем кто тут давно смешно смотреть на это со стороны т.к. зекач полон такими вкатывальщиками, которые думают что сейчас УХ как начнут работать в поте лица и придут к успеху, и вообще они не эти лохи, которые поматросят и бросят через месяц, сами забивая через неделю.

Насчет твоего вопроса тебе уже отвечали выше: вышку требуют, без нее хрки сразу дропают твое резюме. Дальше будет только хуже т.к. хайп и вкатывальщиков лезет огромное количество, особенно с вышкой. Но если ты имеешь какие-то достижения за плечами типа побед в кагле или успешные репозитории на гитхабе или как-то еще заявишь о себе - могут взять и без вышки, если сумеешь пройти хрофильтр или в хр будет не девочка-нихуя-не-умею-много-о-себе-думаю, а адекватный профессионал-мужик.

Ты мог уже сам открыть бишопа и уже прочесть сотню другую вакансий и сам посмотреть. В слаке ODS вон народ сидит с вышками, пет проджектами, хорошими рейтами на кагле и не может найти работу.

6 Кб, 369x136

6 Кб, 369x136Не беда, буду тогда стендалон саентистом, тогда у меня ещё эти эйчары посмотрят.

Я ещё никогда не бросал своих начинаний.

245 Кб, 727x1093

245 Кб, 727x1093Как это "меньше срача на двачах"?

Ты думаешь если моей целью было бы движение к успеху, я стал бы вообще постить на этой параше?

Тогда ладно, я вот захаживаю сюда токмо для движения к успеху. В треде иногда годнота проскакивает.

Сука, как же заебала эта новая капча, чувствую себя сраной бесплатной нейронкой для гугла

А я просто кликаю галочку "мамой клянусь, что не робот", и меня пускает.

то есть если у меня есть только ноут с mx150 то это безнадега? даже для образовательных целей на пару лет до покупки гипотетического компа не вкатиться?

Сап нейрач, пока молодой, хочу вкатиться в нейросети. Знания на уровне "слышал мемы про жаву". Интересует с чего стоит начинать чтоб в последствии работать именно с нейросетями. Реквестирую базовые мануальчики по программированию, которые могут послужить хорошей базой.

Сначала выучи матан, линал, теорвер и матстат, через полгода приходи к нам снова. Без этого все программирование бессмысленно.

Без вуза у тебя вряд ли что-нибудь получится.

Учебники есть хорошие, но только без программы обучения у тебя ничего не выйдет.

Поэтому поступи в вуз для начала, а после 2 курса уже приходи за нейронками.

Начни с http://neuralnetworksanddeeplearning.com/

Всё что непонятно из математики - изучай сам по учебникам

Учить тупо всю математику не обязательно, достаточно базы чуть выше школьной

101 Кб, 900x598

101 Кб, 900x598Сука, заебали со своими вузами.

Я может и физикой хочу заниматься, и биологией, мне за этим тоже в вуз вкатываться?

В конце концов, программы вузов лежат в открытом доступе. Хочешь следовать конкретному регламенту - следуй.

Что вы такие беспомощные-то.

Чтоб хоть какая-то база была в программировании. У меня действительно очень абстрактное понимание как это работает. На уровне информатики школьного курса

Ну ты бы хотя бы с Кнута тогда начал или Кормена, SICP - так себе начало.

Но хуй тебя куда возьмут без вышки или процесса ее получения. Я вот дропнул свой топовый вуз после двух курсов, решил вкатиться в биоинформатику, но в трех НИИ меня послали из-за отсутствия образования.

Лол, НИИ? Чтобы работать там за копейки?

Проблема решается просто - сделай что-нибудь великое в своей области, и НИИ сами будут просить тебя к ним.

Чтобы сделать что-то великое тебе лет так пять нужно поработать в мле, покрутиться в этой среде с такими же знающими людьми и только потом сможешь начать делать что-то великое. Один так и будешь import tf as tf десятилетиями дрочить. Когда работаешь темп обучения раз в этак 10 больше и ебланить месяцами не получиться т.к. сроки и дедлайны.

>отлови бозон Хиггса

В бозоны очень высокий порог входа по оборудованию, у одиночки нет денег на коллайдеры.

С машобом все намного проще, нужны только видеокарта, датасет и мозги.

>>14553

>Когда работаешь темп обучения раз в этак 10 больше

Хорошо если задачи разнотипные, а если одно и то же, но в разных вариациях? Какое-нибудь говно типа прогноза кликов на рекламу в фейсбуке.

Скажешь, невозможно? Ты же уже 2 курса отучился, и уже в принципе должен основные концепты всех 4х, так что сдашь за 2 года

Я тупо не смогу 16 экзаменов за сессию сдать, бака. Да и не предусмотрена тут такая возможность.

Датасеты церна можно скачивать из открытого доступа же.

>>14040

Ну давай разберём тобою написанное, "простой инженер". Ты же у нас в данных шаришь?

>абсолютно все

Бывают не абсолютно все?

>имеют минимум бакалавра/магистра или учатся на них в данный момент

То есть все имеют бакалавра, некоторые магистра, некоторые учатся на них в данный момент. Диаграмму Венна ещё не прошли?

>в более менее нормальных вузах.

Их даже несколько? Наверное, у каждого по нормальному вузу?

ML-инженер не мог написать такую хуйню, значит, ты не ML-инженер.

И довесочек

>Среди моих коллег

Это нерепрезентативная выборка.

>я еще не встречал случаев когда люди обучились математике (а весь МЛ суть она) по онлаен курсам или сами значит это та область где нужны учителя

Какой ты нахуй инженер. Ты школьник с максимализмом головного мозга и логикой тупой пизды.

>Без вуза у тебя вряд ли что-нибудь получится.

Ведь кататься на пары, жить в общаге и переписывать в тетрадку с меловой доски - это единственный способ выучить матан.

>Но хуй тебя куда возьмут без вышки или процесса ее получения.

В ООО "Вектор" не возьмут, конечно. В нормальную контору без проблем.

> кататься на пары, жить в общаге и переписывать в тетрадку с меловой доски - это единственный способ выучить матан.

Будешь смеяться, но да. Без надсмотрщика 99,9999% на матан забьют через месяц в лучшем случае. А если ты уберменш, способный мотивировать себя годами изучать что-то, ты не только в мле, а в чем угодно себе имя сделаешь без дяди.

>С машобом все намного проще, нужны только видеокарта, датасет и мозги.

с таким набором разве что котиков распознавать будешь всю жизнь. по нормальному мл нужно внедрять в роботехнику, вот там простор для изобретений. но в одиночку и без денех такого не осилить.

Раздался голос со стороны вебмакак.

>разве что котиков распознавать будешь всю жизнь

Ты котиков-то распознай нормально а не как сейчас, прежде чем за Робокопа браться.

Ну давай разберем по частям тобою написанное, "разбиратель написанного". Ты же у нас говоришь по делу?

>Бывают не абсолютно все?

Доебка до речевого оборота с абсолютно понятным смыслом.

>То есть все имеют бакалавра, некоторые магистра, некоторые учатся на них в данный момент.

А теперь перечитываешь еще раз то что цитировал, вместе с контекстом.

>Их даже несколько?

Да, представь, нормальных вузов больше одного.

>Наверное, у каждого по нормальному вузу?

Диаграмму Венна прошел? Это сейчас шестой или седьмой класс?

>ML-инженер не мог написать такую хуйню, значит, ты не ML-инженер.

ЯСКОЗАЛ, ЗНАЧИТ НЕ МОЖИТ!!1

Это феерическое НИВЕРЮ даже комментировать не надо.

Ну и довесочек:

>Это нерепрезентативная выборка.

Теперь цитируешь место где я заявлял о реперезентативности своей выборки, или прекращаешь выдавать свои фантазии за мысли оппонента.

За репрезентативной выборкой идешь нахуй ODS, CrossValidated / Quora или любой другой рилейтед ресурс, спрашиваешь людей и получаешь такой же ответ, а потом кукарекаешь о репрезентативности.

>Какой ты нахуй инженер. Ты школьник с максимализмом головного мозга и логикой тупой пизды.

Какой ты нахуй разбиратель, ты обычная порватка которая встретила мнение отличное от своего и мгновенно воспламенилась. Ах, да, еще ты животное не обученное элементарному сетевому этикету, а значит беседовать с тобой нет смысла. Довольно показательный пример того чем отличаются люди ведущие диалог от обезьян пытающихся закидать собеседника говном.

Можешь продолжать гореть.

Ну давай разберем по частям тобою написанное, "разбиратель написанного". Ты же у нас говоришь по делу?

>Бывают не абсолютно все?

Доебка до речевого оборота с абсолютно понятным смыслом.

>То есть все имеют бакалавра, некоторые магистра, некоторые учатся на них в данный момент.

А теперь перечитываешь еще раз то что цитировал, вместе с контекстом.

>Их даже несколько?

Да, представь, нормальных вузов больше одного.

>Наверное, у каждого по нормальному вузу?

Диаграмму Венна прошел? Это сейчас шестой или седьмой класс?

>ML-инженер не мог написать такую хуйню, значит, ты не ML-инженер.

ЯСКОЗАЛ, ЗНАЧИТ НЕ МОЖИТ!!1

Это феерическое НИВЕРЮ даже комментировать не надо.

Ну и довесочек:

>Это нерепрезентативная выборка.

Теперь цитируешь место где я заявлял о реперезентативности своей выборки, или прекращаешь выдавать свои фантазии за мысли оппонента.

За репрезентативной выборкой идешь нахуй ODS, CrossValidated / Quora или любой другой рилейтед ресурс, спрашиваешь людей и получаешь такой же ответ, а потом кукарекаешь о репрезентативности.

>Какой ты нахуй инженер. Ты школьник с максимализмом головного мозга и логикой тупой пизды.

Какой ты нахуй разбиратель, ты обычная порватка которая встретила мнение отличное от своего и мгновенно воспламенилась. Ах, да, еще ты животное не обученное элементарному сетевому этикету, а значит беседовать с тобой нет смысла. Довольно показательный пример того чем отличаются люди ведущие диалог от обезьян пытающихся закидать собеседника говном.

Можешь продолжать гореть.

да гугл нормально котиков распознает. а гугл капча датасет для распознавания дорожных знаков для самоуправляемых машин собирает например.

ох лил

А что не так? Горилла и есть. Нейроночке ты не пояснишь за блек лайвс маттер, СЖВ идеалы и прочее говно.

Вот это подгорело, класс. Наверняка ты не ожидал такого ушата холодной воды, когда высокомерно отчитывал вкатывальщика, да, мудачок?

спасибо проорался)))))

>Хочу создать Искусственный Интеллект, даже нашел формулу F = T ∇ Sτ, но пока не создал. Почему так?

42

Да.

>атветил значит подгорело.

Хех, посмеялся, судя по постам пылает как раз у тебя.

Мимозоонаблюдаю

Два анона срутся и оба пытаются создать видимость общественной поддержки. Ничего нового.

ну накодю на готовых либах известные мл алгоритмы, которые я нагуглю. не буду при этом читать объемные книги на 600 страниц матаноформул.

я сторонник практики. еще ни разу не учил программирование по книгам.

>объемные книги на 600 страниц матаноформул

Все ML описывается десятком формул, откуда там 600 страниц?

Без знания теории не будешь знать какие алгоритмы где применять, что касается чистого кодинга там справиться даже трехлетний ребенок, так что какой смысл?

Бурбакизмы

Я тоже тока на соченениях старался... а типерь я ML-инженер! Имею право писать как зохочу)

Научи меня numpy и быть таким же бесстрашным.

Это же питон. Всё что связано с питоном - школьное, простенькое говно.

ну не 600, а 452, но они читаются так медленно с-ка.

https://doc.lagout.org/science/Artificial Intelligence/Machine learning/Machine Learning_ An Algorithmic Perspective (2nd ed.) [Marsland 2014-10-08].pdf

Добра тебе.

Какой самый простой практический способ обзавестись нужными мощностями? Отдельную ферму под это собрать? Какое железо брать? Есть какой-нибудь внятный гайд по таким практическим вещам?

Если что, сейчас мне это нужно только для своих экспериментов. Играть с тензор-флоу, запускать новую йобу с гитхаба.

AWS гугли и не еби себе мозги кошелёк, если только для экспериментов. Там и триал есть вроде как.

AWS я знаю само собой, я про железо спрашиваю. Эксперименты это не значит, что это мне на полчаса нужно.

https://pcpartpicker.com/user/kevindewalt/saved/2br999

Это примерно средний вариантец. Я собрал за 2100 урезав на том и на сем. Главное 32+ Гб памяти, 1080ти, и процессор из верхнего сегмента.

>2100

пендоляров за кудахтер? ты ебанулся. потом такой прийдешь, я тут вам нейроночку спроектировал, на роспазнование двух цветов, вам нужно всего лишь ;50000 на серваки

Я так понимаю, ты это используешь как десктоп. Есть подводные камни при использовании в качестве хедлесс машины по ssh? Необходимость какой-нибудь ебучей винды, например. Меня ноут в качестве инструмента вполне устраивает. Я, если честно, вообще рассчитывал, что смогу отделаться рекомендациями в стиле покупки внешней видяхи к ноуту, ну да ладно.

>>16322

Ты кокойто прям студент. Знал бы ты, сколько любая мало-мальски приличная организация тратит в месяц на сервера. А от затрат на рекламу вообще охуел бы.

Да, у меня это десктоп. Хедлесс еще лучше будет, наверное, т.к. загруженность ГПУ не будет помехой в работе - у меня сейчас все ацки тормозит, если ГПУ нагружен на 100%. У меня АМД, там нет встроенной видюхи на ЦПУ.

Внешние карточки я смотрел - так и не понял что там с дровами, совместимостью. Почти наверное не оче. А вся эта экосистема с кудой на линуксе и так как карточный домик, пока все заработает пять раз их переустановишь. Это на самой стандартной конфигурации, если там что-то экзотическое, то какая-то безнадега будет, видимо.