Это копия, сохраненная 19 сентября 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем выяснять, кто двигает ноуку: толпы смузихлёбов или фундаментальные деды.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/ | https://www.general-ai-challenge.org/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.cf/thread/340653/

http://arhivach.cf/thread/355442/

http://arhivach.cf/thread/360889/

http://arhivach.cf/thread/366809/

http://arhivach.cf/thread/368934/

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1209084 (OP)

Или у них вся суть в особой архитектуре?

Блять, как криво работает вставка.

http://science.sciencemag.org/content/358/6368/eaag2612.full

А, Vicarious, это NTM-образная штука. Ничоси, они в Science опубликовались. При чем тут автоэнкодер не знаю, "делит картинку на части и ищет закономерности" это какое-то абсурдно-примитивное описание работы автоэнкодера. На таком уровне ничем, наверное, не отличается. Еще они оба компьютерные программы.

Эм, а что за NTM?

>При чем тут автоэнкодер не знаю, "делит картинку на части и ищет закономерности" это какое-то абсурдно-примитивное описание работы автоэнкодера.

Это к тому, что я не особо понял, как оно работает и из описания сразу вспомнил про автоэнкодер, мне показалось, что принцип работы похожий. А описание такое, потому что у меня некоторые проблемы с формулированием мыслей, извините.

@

Почему это правительство должно платить авторам статей, в которых кто-то заинтересован и хочет прочесть? Мы что, коммунисты?

Деньги за доступ к статье получают издательства (картельный сговор), а не авторы.

И если уж деньги на науку идут народные (налоги), то и результаты должны быть доступны этому самому народу.

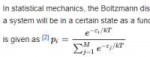

12 Кб, 645x386

12 Кб, 645x386У меня пикрелейтед. Что скажете?

умножил, получил гомологии группы G

HTM, я описался. Hierarchical Temporal Memory. Это старая модель, которую эти люди разрабатывают многие годы, основана на некоторых идеях о том, как может быть устроен неокортекс (область мозга). Авторы и их последователи считают, что это потенциально более интересное направление, чем, например, нейроночки. Мнение это оспаривается многими интернетными экспертами. Основная причина сомнений была в том, что преимущества модели не были продемонстрированы на практике.

Ну вот теперь они сделали эту штуку с капчей. Стоит признать, это довольно круто, хотя тест все равно синтетический, в то время как изначально предполагалось, что модель как бы будет более терпима к шумным real-world данным.

У меня отношение скорее скептическое. Еще у них постоянные попытки коммерциализировать это, какие-то непонятки с оупенсорсом - вроде бы они всегда выкладывают не самые крутые и последние наработки, кароч мутновато.

Если ты прочел только основную статью в саенсе, то неудивительно, что ничего не понял. В таких журналах основной текст это скорее что-то вроде расширенного абстракта. Вся суть статьи, технические детали и описания в supplementary materials. Читай их, может станет понятнее.

Они и доступны. Полтинничек заплати и читай себе. Или тебе еще бесплатный интернет, компьютер предоставить?

Ты хуйни не неси. Сейчас бы копротивляться за шекели (((правооблядайтеров))), которые в науке вообще посторонние паразиты и проходимцы, стригущие бабло с исследователей, читателей и со всех остальных, до кого могут дотянуться своими загребущими ручонками.

Бвахаха, полюбуйтесь на этого копротивленца, который как обычно не имеет ни малейшего представления, о чем говорит. Их кто-то под дулом автомата заставляет в Саенс статью посылать? Вон у них целый вебсайт есть, выкладывайте туда, или на гитхаб вообще бесплатно для всех. Посылай на конфу, там тебе найдут пару студней сделать пир ревью. Но нет, поди ж ты, они шлют в саенс, сами себе враги, наверное.

Если ты ищешь бозон хиггса для ЦЕРН, то еще может быть в пределах нормы, а если это какой-то ирис или мнист, то ты где-то накосячила.

Что такое активация 0-1? Если у тебя функция активации возвращает только 0 или 1, то выходным значением может быть только 0 или 1, никаких ближе или дальше. Но в этом есть смысл только если ты работаешь с простой задачей вроде XOR.

В любом случае, какой лейбл у входящих данных, такой должен быть и выход. Если у тебя one-hot encoding, то на выходе бери то у чего значение ближе к 1.

А эта книга - это уровень введения семестровый или чуть больше этого?

sci-hub же есть лол

Это полный курс. Там очень много материала, включая довольно новые модели, изложено довольно плотно местами. За семестр с нуля ты точно не сможешь все прочитать с пониманием, за год тоже вряд ли.

Отлично. Спасибо. Просто чтобы понимать корреляцию между объемом текста и сроком обучения

>>26938

Что такое уровень введения семестровый? Это очень хорошая книга, с объяснением теории от начал математики до обзора базовых моделей, на которых стоит машобчик, включая модные и свежие. Ты можешь осилить ее за семестр, но фактически пройдешься по верхам, а впереди тебя будет ожидать имплиментация всего этого счастья (вот тут начинается реальное понимание), практические проблемы, попытки в свой пет-проджект, боль, унижения и годы (да, это не веб-макакинг, быстрого вкатывания не существует) тяжелой работы и чтения пейперов. Если тебе это нужно для того чтобы зарабатывать на хайпе, то я с удовольствием посмотрю на твои мучения, а если тебя увлекает тема, то ты бы не задавал тупых вопросов и не рассчитывал быстро проскочить.

https://twitter.com/hwitteman/status/1015049411276300289

Начало цикла,

форвард,

бэк,

сохранение веса.

Больше одного слоя - это форвард и бэк в цикл for взять?

Да. И размерности увеличить.

Спасибо.

как ты у нейронки получишь feature importance? мне кажется, можно визуализировать, интерпретировать и тд, но прям фичи не получишь

Таки взял натренированную сеть и скармливаю ей один датасет той же размерности, но в каждой итерации заменяю один столбик на его среднее значение, тоесть убираю фичу и смотрю на результат. Рокет саенс.

Симуляции? Поди марковские цепи с монте Карло дрочат.

Вот удивили то!

Код кладешь на гитхаб, в статью ссылку. Псевдокод в тексте тоже приемлемо.

Обучать не пробовал?

Нейроночки

>А что вообще такое Data Science?

Мартышка к старости слаба мозгами стала;

А у людей она слыхала,

Что это зло еще не так большой руки:

Лишь надо применить нейронОчки.

Все модные нейронОчки себе она достала;

Вертит нейронОчки и так и сяк:

То тренирует их, то стопицот слоев нанижет,

То их в ансамбль соберет, а то полижет;

НейронОчки не действуют никак.

"Тьфу пропасть! — говорит она, — и тот дурак,

Кто на ютубе смотрит врак:

Всё про нейронОчки индусы мне налгали;

А проку на-волос нет в них".

Мартышка тут с досады и с печали

Делитом так хватила их,

Что только файлы засверкали.

Гридсерч чего? Гиперпараметров? Нет. Например, ты learning rate так выберешь слишком большой, а он за собой потянет все остальные гиперпараметры.

Гиперпараметров. А если вынести learning rate и через callback кераса уменьшать автоматически?

Learning rate это лишь самый очевидный пример. Все остальное тоже будет неоптимально в общем случае. Гарантий нет.

> Все остальное тоже будет неоптимально в общем случае. Гарантий нет.

Потому что нейроночки это машоб курильщика. Подрочить вприсядку с бубном, авось сойдется.

Тоесть, другие модели так можно тюнить? Или ты просто стриггерился на нейроночки?

Что лучше?

Морфологический разбор речи? Вроде учат в школе.

Юдковский растекается мыслями по поводу того как работает человеческое сознание и полагает что его выводы делают понимание интеллекта lesswrong, большинство статей оттуда или обозревают и систематизируют выводы из когнитивистики, или не несут никакой пользы и абсолютно гуманитарны, а из того что представляет интерес получилось собрать годный фанфик по Гарри Поттеру, который этот самый lesswrong и распиарил. Для тех кто не может в английский есть перевод статей.

И в любом случае ты ошибся тредом.

Я не могу понять, в чём её смысл? А именно почему разность между очередным значением и средним значением возводится в квадрат, а не берется по модулю? И что мне показывает полученное значение дисперсии? И почему процедура получения дисперсии именно такая?

Можно брать и по модулю, это просто другое определение расстояния в пространстве(метрики). Просто квадраты сильнее "штрафуют" за отдаление от среднего значения.

Ребята, хорошее введение в машинное обучение?

>>28717

> Я не могу понять, в чём её смысл?

Разброс значений случайной величины.

>Вот просто по аналогии - много ли можно понять у какого-нибудь Достоевского, не зная русского даже не языка, а алфавита?..

Да

>учебник Вентцель.

576 стр лол

Надо с более простых вещей начинать, чтобы не пугать человека. Каких-нибудь вводных курсов по теорверу ВШЭ или МГУ более чем достаточно.

Ты же понимаешь что русских ноунеймов никто читать не будет? Может и хорошее, но можно просто взять http://www.deeplearningbook.org/

> Ребята, хорошее введение в машинное обучение?

Воронцов штоле? Лол, навернешь у него вариационного исчисления с первой страницы без объяснений что вообще происходит.

>Просто квадраты сильнее "штрафуют" за отдаление от среднего значения.

Спасибо за ответ. Я бы понял такое объяснение в случае не с дисперсией, а, например, с квадратичной функцией потерь, что там надо оштрафовать то, что сильно отклонилось от правильного ответа. Но вот с дисперсией - нет. Не пойму за что штрафовать? Зачем? Не могу осилить понимание механизма, который делает дисперсию правильной именно с квадратом, а не с модулем.

>>28736

Благодарю за ответ.

>По теорверу есть очень годный учебник Вентцель.

Так то теор.вер., а я про мат. статистику хотел узнать. В теор. вере. формула дисперсии в другая, чем в учебниках мат. статистики. Например, в теор. вере ряд распределения дан с величинами и вероятностями. А мат. статистике просто ряд со значениями.

Вентцель просто дает формулу, вот формула дисперсии, пользуйтесь. А почему квадрат, а не модуль там не говорится.

>Разброс значений случайной величины.

Не могу смысл найти, разброс можно было бы и модулем померить, а тут квадрат.

Не все учились в лицеях.

Есть у коо полные ответы на Pattern Recognition and Machine Learning?

Каждому слою нейронов нужен свой bias, почитай что это такое прежде чем использовать. В каждом треде этот вопрос, пора его в шапку.

Ок, ступил, хотя это больше для мниста, тогда высокая вероятность, если это не какое-нибудь умножение или другая хитрая корреляция, но это ты и сам знаешь

Картинка, из нее скаляр * количество слоев + смещение и активация тангенсом. Я на выходе имею четкое отделение одного от другого. Зачем разный bias, если если я уже контрастно отделил одни числа от других? Смысл честно говоря не пойму.

Проблема в том, что науканы не пытаются понять, что делает нейронка. Они рассуждают примерно так: "Ну кароч нейрон что-то делает, хуйзнает, но мы его аппроксимируем линейной функцией, чтобы сильно не напрягаться. Поэтому у нас два параметра для обучения - вес и bias. А чтобы херни на выходе не получалось, мы края обрежем нелинейностью - сигмоид, тангенс, ReLU, похуй ваще, сами разбиратесь, нам это неинтересно."

Ты спрашиваешь про MIRI. Они там какие-то формулы придумывают, чтобы оценивать злобность/дружественность ии, или может просто деньги пилят.

> Они рассуждают примерно так: "Ну кароч нейрон что-то делает, хуйзнает, но мы его аппроксимируем линейной функцией, чтобы сильно не напрягаться.

Это ты так рассуждаешь, мань. Полно работ по биологическим аспектам нейрона, начиная с того же Розенблатта и Маккаллока с Питтсом. Вместо того, чтобы тут кукарекать, ознакомился бы.

и делают его из перьев

> А самолет изобрели зоологи

Тебя зоологи изобрели, судя по всему. Хоть бы с историей идей машоба ознакомился, прежде чем срать здесь.

>прежде чем срать здесь.

Смешно шутишь.

Насрал тебе на голову, кстати.

Маняматика нинужна, ЖС лучший и единственный язык, Путин - президент мира.

Что делает первый слой свертки в ResNet?

>Это ты так рассуждаешь, мань. Полно работ по биологическим аспектам нейрона, начиная с того же Розенблатта и Маккаллока с Питтсом. Вместо того, чтобы тут кукарекать, ознакомился бы.

Это где относительно недавно глиальные клетки начали изучать и только десяток лет назад поняли, что это не просто балластный жирок?

А котематики уже кококок кучу моделей абстрактного говна нахуярили по мотивам старых исследований.

Кстати, у маняматиков на теме открытий в области нейроглии тут же обосратушки-перепрятушки и новые охуительные истории пошли, внезапные откровения озарили, бгг:

https://hal.inria.fr/hal-01221226/document

>Это где относительно недавно глиальные клетки начали изучать и только десяток лет назад поняли, что это не просто балластный жирок?

Кстати, а почему вся эта ученая пиздобратия считает, что мышление происходит в мозгу?

Да хуй его знает. У них самих из инструментов познания - только жидорептилоидные маняматика, да манялогика, которые им время от времени подгоняют. А потом отвлекают внимание на этих лошар, дескать они агенты зога. Лошары они слепошарые. Вот маняматики те да - чистые рептилии. Того же Перельмана вспомнить, как он способ управления миром по его словам открыл.

Это не обязательно.

Намного эффективней, чем хуярить мышь током и смотреть какие там у ней участки мозга закоротило, ну это физиологи допустим, а маняматики, какие у них эксперементы? Если они пытаются в аналогию мозга, то почему они не наблюдают за его работой? Откуда они понапиздили всюе эти нейроны и перцептроны?

>>29053

но, хотя я и ступил, но это же не дает тебе фича импотанс в прям уж чистом виде, с тем же успехом можно просто смотреть веса первого слоя, как в простой регрессии

http://explained.ai/rf-importance/index.html

не знаю, зачем я тебе отвечаю, но потому что есть (и очень много) экспериментальных данных, как люди теряют способность к разным аспектам мышления при травмах головного мозга, и это просто из самых базовых объяснений

и предлагаю из названия следующего треда убрать слово "НЕЙРОНОЧКИ", оставить только машинное обучение

> предлагаю из названия следующего треда убрать слово "НЕЙРОНОЧКИ"

Изначально его там и не было. Это позже петросянство началось. Диплернинхбук из этой же области, абсолютно непригодные для начинающего объяснения как работают те же сверточные сети.

>теряют способность к разным аспектам мышления

Это хуяня, а не объяснение. Если ты у радио выбросишь пару деталей, оно начинает хуево работать, но это не значит, что радиостанция находится внутри него. Веятного объяснения того, что мозг является мыслительным органом нет.

>Веятного объяснения того, что мозг является мыслительным органом нет.

В человеке мыслит душа, а не мозг

Алсо, да покормил.

Да, я. Ты сперва докажи, что он радио, а потом поговорим. Если радио посадить в среду с изолированным внешним сигналом, то оно нихуя работать не будет, а человек будет.

Да, я поговорю с шизиком.

> Ты сперва докажи

Нет, это уж ты докпжи, что там происходят мыслительные процессы.

>изолированным внешним сигналом

Кто тебе про электромагнитные волны говорил, мань?

Активность нейронов, зависимость восприятия и мышлительных процессов от различных дефектов в строении нейронов. Других доказательств нет и пока кто-либо не предоставит другие, то все будут считать, что вычисления проходят в мозге.

91 Кб, 400x411

91 Кб, 400x411>Других доказательств нет

>то все будут считать, что вычисления проходят в мозге.

Обожаю современную науку

Могу предложить только одно - перестать матанопетухам наебывать людей. Вся эта нейронная билиберда чистый маркетинг, не имеющий отношения ни к мозгу ни к живым существам.

>Вся эта нейронная билиберда чистый маркетинг, не имеющий отношения ни к мозгу ни к живым существам.

Докажи

Как там подготовить свои данные,

то есть не скачивать готовое https://keras.io/datasets/ ,

а подготовить свои текстовые данные,

собираюсь заниматься анализом текстов с помощью построения RNN с LSTM, не понимаю как вообще организовать папку с данными, где есть данные и лейблы,

в документации ничего об этом не нашел, там пишут, мол качайте готовое, для вас быдла уже все сделано

>Это не является доказательством

Тоесть, когда ученые столько лет лепят пули из говна, а они не стреляют, нужны еще какие то доказательства?

Да

Не совсем понятен вопрос. Упрощая - все данные это таблицы (и ты можешь невозбранно ручками скачать много таблиц ну хотя бы с kaggle). Это может быть база данных, а может быть csv файл, но это таблица с текстовыми данными. Если хочешь работать с текстами, создавай файл text.csv в котором первый столбик заполняй... текстом, это твои Х, а второй столбик лейблами, это твои Y, затем с помощью например pandas read csv ты загружаешь эту таблицу в программу, и например через train_test_split из библиотеки sklearn получаешь точно такие же массивы тренировочных и тестовых данных которым тебя уже приучил керас.

Картинки (и любые другие данные) обрабатываются абсолютно таким же образом, ты берешь файл картинки, делаешь из него строку или двухмерный массив со значениями пикселей от 0 до 255 (в черно-белом варианте) или трехмерный от 0 до 255 для каждого цвета rgb (спойлер, их три), хотя конечно я тебя никак не ограничивая и ты можешь представить картинку как побитовую запись файла или его хеш или как тебе приспичит, это дата саенс, детка. Запиши все это в первый столбик таблицы, а лейблы во второй и все. Дата саенс это не распознавание негров на однообразных данных, это обработка и анализ данных так чтобы из них начало получаться что-то стоящее, а использовать можно хоть линейную регрессию или деревья, деревья вообще тащат а XGB топчик. Перестань бояться данных, они твои бро.

Скармливай данные и лейблы, все. У нее годная архитектура, может научиться хоть лисьим хвостом управлять, хоть языком смотреть.

Поощряй за успехи, давай пиздюлей за ошибки.

хочу вот так же сделать, но со своими данными,

https://pastebin.com/bUXeqqaE

вот только не могу понять как их готовить

>sklearn

>pandas

можно ли как-то то же самое сделать через спарк и керас?

мне именно с ними надо работать,

ну типа спарком можно как-то обработать сырые данные и дать их на растерзание питоновскому скрипту, потестить разные параметры сети и разные архитектуры,

а потом самую удачную переписать на нативной спарковской библиотеке MLlib на Scala,

у меня такой план

Ты можешь это сделать через стандартную библиотеку питона, но зачем? Я тебе про идею, ты мне про инструменты. Это не веб-макакинг где нужно учить новые фреймворки каждые два года, pandas и все что входит в scipy это стандарт, к тому же, тебе всего пара функций нужна оттуда - сперва ты обрабатываешь данные, а потом используешь спарк, керас и что угодно, это два разных процесса в большинстве случаев. Керас просто не предназначен для препроцессинга на таком уровне, он упрощает какие-то специфические моменты в работе со строками и изображениями, но уже после того как по ним прошлись pandas или sklearn.

Кажется, тебе сперва нужно вообще разобраться с тем что такое данные и что такое эти ваши нейроночки, если у тебя нет представления о том что такое X_train.

хорошо,

а как придумать лейблы, если я собираюсь анализировать серверные логи,

например, "ERROR", "INFO" и "WARN" это хорошие лейблы?

> 0, 1 и 2 это хорошие лейблы. Начни с http://www.deeplearningbook.org/

В диплернинхбук такое пишут? Хорошие лейблы это н-р "1 из N", https://en.wikipedia.org/wiki/Constant-weight_code А 0 1 и 2 будут просто непрерывными значениями как при регрессии.

One-hot encoding тоже один из стандартных метов и в диплернинхбук о нем пишут.

Мне бы пригодилось, еще диплом сдавать и общаться с "преподавателями" в вузеке

> Почему часто в статьях приводятся результаты для валидационного сета?

Потому что они показывают, что модель правильно обучена и может обобщать, т.к работает на данных, не использовавшихся в обучении.

Ну потому что Keras таки для нейронных сетей, а методов препоцессинга в нем не много. Тебе лучше почитать про то, как готовить данные к ML в целом и как лучше векторизовать тексты в конкретной задаче, почитать про numpy, sklearn, pandas, попробовать чей-нибудь простое типа tf-idf и прочего, а потом открыть для себя doc2vec, word2vec, language models и прочее.

Мимо-нлпшник

Давайте с начала. Нужно получить да или нет ответ. На вход делаем цифры в каком-либо виде. Для контрастности добавляем смещение, активацией выравниваем. Цифры будут разделены на две группы. Зачем делать слои, менять learning rate и разные активации на каждом слое? Или вы получаете больше чем да-нет?

Да-нет это бинарная классификация. Есть классификация с множественными классами, есть регрессия, есть аппроксимация плотности распределения, априори неизвестной. В зависимости от задачи делается датасет и подбирается подходящий алгоритм, пусть хоть нейроночки эти ваши. Хотя я абсолютно уверен, что если задача не в том что бы негров распознать или котиков под Пикассо разрисовать, можно не изьебываться с сотнями слоёв, достаточно простой SVM.

Был же скрипт, который в гуглокапче включал аудио вариант и использовал для его распознавания сервис самого гугла.

Они включили йобазащиту, когда просто банят и не дают ввести капчу

>21 век

>не умеет общаться представителями своего вида

Какие тебе нейроночки, ты же сам животное, лол

Это показывают данные из тестового набора, а валидационный таки использовался... ну... для валидации по ходу обучения.

потому что эти статьи неправильные, а их модели оверфитнутые, но никто не проверяет же

Нет, в статьях идут таблицы и графики средних результов и тестов, и валидаций.

Там попросили номер карты, я ввел, потом сообразил, что вообще-то могу получить студенческий доступ, создал новый аккаунт, а карту перепривязать не удалось.

Ну напиши им в техподдержку

Их отдельные энтузиасты пилят понемногу. https://journal.r-project.org/archive/2017/RJ-2017-008/ например. Не думаю, что тема мертва, там ещё есть куда расти и вообще, сама идея ГА (эволюционные методы оптимизации) интересна.

Ты не понял, что там написано. Не расстраивайся, просто описание слишком поверхностное.

>вместе со значением функции сразу вычисляется градиент

Не вычисляется градиент, а строится граф для его вычисления. Т.е. символьно вычисляется выражение. Потом этот граф нужно исполнить, чтобы вычислить значение.

Deep reinforcement learning. Даже во всякие арканоиды и понги учат играть эти ваши гейроночки.

Получай.

>Не могу осилить понимание механизма, который делает дисперсию правильной именно с квадратом, а не с модулем.

Дисперия случайной величины x есть по определению: Var x = E(x-Ex)^{2}, где E - оператор взятия среднего значения( математического ожидания) Предположим, мы считаем, что корректней определять дисперсия через модуль, т.е: Var x = E|x-Ex|. Раскрываем модуль: если x > Ex тогда |x - Ex| = x - Ex и наша новая "дисперсия" равна нулю, если x < Ex то тогда |x - Ex| = Ex - x, и наша дисперсия снова тождественно равна нулю. Таким образом наше определение, очевидно, несостоятельно.

>что с генетическими алгоритмами?

Идешь сюда: http://gecco2018.uma.es/proceedings/gecco18_papers_toc.html

И качаешь свежие статьи с недавней конфы.

user: gecco2018

password: kyoto

В целом на чисто ml-задачах GP сосет. Самый модный алгоритм epsilon-lexicase selection на задачах регрессии работает в 6-20 раз дольше, чем xgboost и дает, как пишут в их бенчмарках https://github.com/EpistasisLab/regression-benchmark чуть лучший результат.

Однако, что это за бенчмарки? Максимальный размер датасета на котором они тестировались был 1000 наблюдений на 100 признаках.

В общем пока представляет интерес только для соревновательного стекинга.

>Предположим, мы считаем, что корректней определять дисперсия через модуль

Ты только что стандартное отклонение

>В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

At first i was like:

>HOLY SHEEEET THESE WORDS ARE TOO COMPLICATED

But then i:

>бля, я же по всему этому получил отлично в экономическом универе и даже через десяток лет всё помню и знаю большую часть

Тру стори, анончик. Как-то хожу сразу в нужные треды, а вот решил почитать и охуел изначально, чот трудна. И ушёл дальше. Вспомнил, что в шапке какой-то мемас есть и решил его понять. Прочитал ещё раз и охуел с того, что я же реально это всё великолепно освоил в универе.

Это ведь действительно глаза боятся, а руки делают.

Ещё один повод начинать кекать с моих одногрупников, которые "блееее, нахуй мне ваша матеша, она нинужна в иканомике" или "фу, ебучий эксель, КТО ИМ ВООБЩЕ ПОЛЬЗУЕТСЯ в экономике?". А теперь эти шакалы за 20к бумажки перекладывают в пыльных некондиционируемых офисах на самом деле, больше половины сидит по местным управлениям миллионника, а остальные съебали в другие страны, ведь направление было блатным и всех куда надо пристроили, только одна тян залетела от хуй пойми кого и в семью играет, ну и я, долбоёб, в кодерство ударился.

Только в современных соревнованиях обычно миллионы примеров.

А я не умею в квадратные уравнения.

поцеловала в щечку

Ну почему я не учил математику в школе и не пошел на математическую специальность в вуз? Так хочется вкатиться в датасаенс, но не умею в английский и математику. Что делать, братцы?

Увы, скорее всего, поезд ушел. Английский выучить не должно быть серьезным препятствием, можешь начать с него. Все равно пригодится.

Это совершенно разные понятия. Нейроночки используют деревья как данные и иногда генетические как внутренние алгоритмы.

Почему?

Это все алгоритмы машоба, ньюфаг, про деревья читай random forest (и прочие леса) и всякие xgboost (и прочие ансамбли). ГА внезапно тоже могут в машоб, просто очень медленно.

Я прекрасно понимаю что это. Это совершенно разные понятия, которые к тому же относятся к машобу.

> Какая-то чушь. Иначе бы рыночек давно бы порешал такие журнальчики.

Без публикаций в таких журнальчиках не сделаешь карьеры, вот и все. (((Владельцы))) таких журнальчиков настолько ушлые, что сами давно порешали рыночек.

Двачую, хотя английский это ерунда.

Если не секрет, то почему хочется вкатиться?

Меня, например, возбуждает история тян из штатов:

Есть сеть супермаркетов, Таргет (читай Лента), которая работает по картам покупателей. И вот, эта тян ~16 лет закупалась там постоянно и всё было заебись. Пока в один день её на почту (физическую) не начали приходить скидки на всякие памперсы и детскую еду. Батя этой тян впал в ярость берсерка от такой ошибки и начал бегать по судам. Таргет по итогу извинился бабками. И что же вышло в итоге? Тян и была беременной, сама этого не знала даже.

Бигдата Таргета сравнила её со всеми беременными тян и сопоставила изменения в её покупках с теми изменениями, которые делают беременные тян, и выдала такую рекламу.

Если у тебя от такой истории не встал писюн, то нахуй тебе бигдата и датасайенс, братишка?

Чё не так?

Она в Фейсбуке писала, она Гуглила. Ее запросы были отданы в ФБР. ФБР являясь американской организацией приняло решение защитить своего гражданина и оказать помощь в рождении ребенка и прислало на почту уведомление. Это очередной раз подтверждает превосходство Америки.

Добавьте в шапку:

- работать без профильного PhD или хотя бы магистратуры получится только в стартапах на три человека, один из которых почитал про нейронки и решил что бывший веб-макака с этим справится.

- если считаешь что достаточно хорошо знаешь матан и после своих смузи-фреймворков без проблем вкатишься, открываешь http://www.arxiv-sanity.com/ и читаешь первые три-четыре статьи, это самое читаемое по машинлернингу типа ваших хабров и.. и того что там еще похоже на хабры. Никакой черезмерной сложности, это как раз ровный средний уровень, наслаждайся.

- если не знаешь английского то ты просто не нужен, у тебя нет шансов ни в науке, ни в средней работке, ни в личной жизни и твои родители тебя ненавидят.

- быстрое вкатывание это два года магистратуры, на диване это два года имплементации готовых алгоритмов, чтения статей и хотя бы одного большого пет-проекта

- если ты не публикуешься, ты зафейлил свое вкатывание

- шапку почти никто не читает

- чем она больше, тем меньше вероятность ее прочтения

- человек, не обладающий навыками/заслугами, которые ты упомянул, прочитав твой текст, не уйдет отсюда с окейфейсом. Наоборот, он будет долго нудеть о своей уникальной биографии и о том какой он обучаемый, умный и вообще молодец, а все остальные дураки, упрашивая кого-нибудь согласиться что именно в его случае ПхД не нужно и он может уже посылать резюме в гугл брейн и дипмайнд

Меня оскорбляет то что ты упомянул только проекты Гугла. Тред это безопасная зона в которой запрещены акты микроагрессии, извинись и мы продолжим нормальное дружественное общение в располагающей обстановке.

Так толсто что даже бодипозитивно.

даже за нипс нужно платить оргвзнос

Не слушайте этого дауна, любой человек, закончивший ПМИ легко освоит абсолютно всё, что нужно за полгода максимум.

О, малыш, но ведь просто прочесть недостаточно, нужно еще и применить. А требование к PhD обязательное со стороны работодателя.

Это НЕ культ.

Ну или в общем в закрытую одежду

> На сколько сложно распознавать порно и эротический контент

Легко, ютюб уже лет десять это делает.

> одевать людей из него в паранджу?

Тоже не сложно.

Не.

71 Кб, 800x550

71 Кб, 800x550Все время ленты предлагают мне курсы, курсы бесплатные открываемые не самыми плохими университетами, или открытые по госпрограммам.

То есть отрасаль реально востребованная - специалистов не хватает.

Пытаюсь найти инфу о пороге вхождения - курсы курсы курсы.

Обрисуйте ситуацию возможно ли если я не доктор математтческих наук?

>обрисуйте

Открываешь хх.ру или другой сайт, где рабов покупают, и обрисовываешь себе до умопомрачения.

Порог вхождения на 4ом оп-пике, если задача именно разобраться в машобчике. Если речь о трудоустройстве, то да, тебе на хх.

8 Кб, 268x103

8 Кб, 268x103Кому? Тому кто занимается или тому кто нанял раба?

всем сложно, нужно отделить от бэкграунда - это уже не очень просто. А учитывая все многообразие поз и того, как ткань будет вести себя в динамике, и вовсе невозможно на данный момент.

https://hh.ru/vacancy/26616968

>>3

Вот за что люблю /pr так это за то что здесь картиночки смешнее чем в /b

В программировании ничего не понимаю

Предикшен в чем заключается? Из лучших весов выбираем лучший и его делаем? Мне нужно чтобы нейронка действие вперёд предугадывала.

Регуляризации навернуть

Количество эпох оценивается по количественным параметрам на training и validation множествах. Скоро всего ты уже 7 часов 59 минут как тупо переобучаешь.

я думаю нужно просто часть из них зарандомить гауссовым распределением а остальные оставить нулями если

И как бы его получше определить?

Или лучше early_stopping_rounds использовать с кросс-валидацией?

А насколько имеет смысл что-то типо бустинга делать: пусть у нас есть выборка X размера N, тогда построим X_train выбрав N элементов из X с повторениями и в X_valid возьмём всё что не попало в X_train (или как-то по другому??) и будем учить на таких парах это всё K (какое выбрать?) раз.

Где почитать ответы на такое?

А то на кэгле даже доверительный интервал никто не построит никогда нахуя вы советуете тогда тут гамалогии учить?

мимо перекатывающийся студент-математик расстроенный тем что зря учил всю эту парашу

Нетривиальной математики даже в статьях почти не используется, что уж про кагл. Там про другое вообще.

Попробуй сам поучаствовать в кагле, чтобы понять что там да как.

Ды нет это понятно (то есть видно даже из моего очень скромного опыта), что почти никогда к математике никто не обращается. Хотелось бы поглядеть на исключения, как раз.

Если математику в статьях минимально я видел, то на кагле вообще нет.

Гугли manifold hypothesis и далее

slowfix:бутстрапинга

а зачем? это же не натуральные числа кто может ответить на вопрос тот поймет

> нахуя вы советуете тогда тут гамалогии учить?

Кто тебе тут советует гамалогии учить? Наоборот, все пишут что третьего оп-пика достаточно.

> Кстати накидайте примеров использования какой-то нетривиальной математики _на практике_ в машобе

Вапник же. И вообще теория статистического обучения. Ну если вариационное исчисление для тебя достаточно нетривиально. В машобе сложнее ничего нет.

Чот не видел где там необходимо вариационное исчисление (ну или может максимум эйлер-лагранж), но это я наверное глупый.

А я же спрашивал на кэгле/в реальных проектах где посмотреть, что прям вот VC размерность чего-то посчитали и помогло..

Кстати в статьях видел и гамалогии и случайные матрицы, но это конечно экзотика.

![1280px-Bufobufo03-clean[1].jpg](/pr/big/thumb/1226323/15324569676770s.jpg) 137 Кб, 1280x853

137 Кб, 1280x853Собственно застревать в этом не собираюсь, надо всего лишь решить одну задачу - распознать зеленых жаб на фотографии. Эти зеленые пидоры неплохо маскируются, однако их надо отыскать любыми средствами.

С чего начать? Что учить? Знания математики - на считал производные в 11 классе, больше ничего не знаю

Скачай керас и посмотри получасовой тутор. Готово.

На nobrain.dk хорошие переводы были.

Манясигнал управляющий мозгом по определению материально взаимодействует с миром, иначе бы он не управлял мозгом. Таких взаимодействий не найдено.

Не взаимодействуют, значит не управляют, значит источник - мозг.

Не влияет на материальный мир. Если влияет - не является тонким, а является частью материального.

>Если влияет - не является тонким, а является частью материального.

Расскажи ка дружочек мне про электрон из чего он состоит и к какому миру он относится

Азазаза

Ты бы лучше ИИ тянку зделол, ну или симулятор школотрона из 3б

Занимаются кое-где. На ВМК МГУ есть кафедры. Но главный вопрос тут: зачем? Такое ПхД ты вряд ли потом сможешь использовать. Да и у нас не платят же за него.

Получить профильное PhD в РФ можно выехав из РФ пока есть такая возможность. В прошлых тредах уже разжевали что это проще чем кажется и люди готовы пихать тебе деньги в карманы чтобы ты потратил часть своей жизни на исследования которые отнимет у тебя гугол и пейсбук.

>>34771

Приходи сюда когда закончишь школу.

>Приходи сюда когда закончишь школу.

Закончил тебе за щеку, держи карман шире, а то деньги пихать не будут, прохфесор пхилософии

https://pastebin.com/cvJeNKUV

и она все равно мне на каждом шагу выдает скор.

то есть вопрос том как правильно использовать verbose

и еще как скормить lgbm'овский датасет в fit?

запустил и оно вообще у меня не останавливается, натаскивается на validation_bin почему-то

и с verbose'ом тоже разобрался: почему-то надо указывать train'у аргумент verbose_eval, но почему он игнорирует значение в параметрах -- я не понимаю.

Остается только вопрос о том как скармливать lgm.Dataset fit'у

чо скажете? стоит ли вообще экономить на памяти?

сколько по времени на такой карте будет тренироваться сетка с 4000 входами приблизительно при архитектуре допустим 4000/500/1

>стоит ли вообще экономить на памяти?

Нет. Будет ли тренироваться 4 часа или 8 часов - это в принципе похуй, один хуй будешь на ночь ставить, но если памяти нет, то ее нет.

Нейронке требуется память под параметры самой себя и под параметры оптимизатора. Интересные архитектуры просто в твои три гигабайта не помесятятся.

<З ?

В Стэндфорд.

Как можно организовать обучение нейронки "в рантайме"?

Например работает какое-то приложение на сервере и выдает какие-то логи, а нейронка бы их хавала определенной порцией и предсказывала бы, ведут ли потенциально эти логи к какой-нибудь фатальной ошибке типа "out of memory" или к ошибке типа "null pointer exception",

если да, то будут предприниматься какие-нибудь действия (например придет электическое письмо дяде сисадмину)

предсказывать будет какой-нибудь простой классификатор типа наив бейс или рандом форест или svm, но он вроде самый долгий,

второй вариант, что предсказывает какая-нибудь RNN, но с дип лернингом я пока не знаком,

насколько по вашему эта идея может взлететь?Как бы вы реализвовывали?

У меня такая реализация,

пока что я лишь присматриваюсь к нужному алгоритму, играю с логами и пишу методы, что б их парсить, весь ML реализован на Питоне с использованием библиотеки sklearn, а так же других стандартных библиотек,

парсинг логов и вытаскивание из них полезной информации целиком сделан с помощью регулярок и питоновской библиотеки re.Пишу в jupyter notebook на питоне 3.7

Можно анализировать лог, как естественный язык, есть набор тестовых логов, которые ведут к определенным ошибкам, к примеру: "out of memory" , "null pointer exception".

Проходимся по логу препроцессингом: убираем все знаки препинания;

потом идет Stemming - сокращаем слова до минимума, что бы осталась самая суть, (responsible, responsibility итд превращаются в response),

далее по тексту проходимся алгоритмом tfidf и превращаем текст в числовой вектор, это готовые features для классификатора, заранее берем от них 10% для тестирования, на выходе имеем 2 питоновских list

features_training и features_test

target это вектор, где единичка обозначает соответствующую ошибку,к которой ведет лог, нулевой вектор - нет ошибок

Думаю ни для кого здесь не секрет, что всем алгоритмам классификаторам пофиг на содержание текста, их интересует только частота появления определенного слова и наличие как можно большего количества тренировочных данных, больше того, наличие большого количества хороших данных это более внушительный залог успеха, нежели совершенность алгоритма,

Пока что проблема с подготовкой данных,

какую часть лога лучше брать для features ? Само сообщение лога или целиком строчку с таймстемпом,

Пример лога:

2017-03-14 22:43:14,405 FATAL [org.springframework.web.context.support.XmlWebApplicationContext]-[localhost-startStop-1] Refreshing Root WebApplicationContext: startup date [Tue Mar 14 22:43:14 UTC 2017]; root of context hierarchy

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Loading XML bean definitions from Serv

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with another entry after

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with no entries after

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with no entries after

2012-02-02 12:47:03,227 ERROR [com.api.bg.sample] - Exception in unTech:::[Ljava.lang.StackTraceElement;@6ed322

java.io.IOException: Not in GZIP format

at java.util.zip.GZIPInputStream.readHeader(Unknown Source)

at java.util.zip.GZIPInputStream.<init>(Unknown Source)

at java.util.zip.GZIPInputStream.<init>(Unknown Source)

at com.api.bg.sample.unGZIP(sample.java:191)

at com.api.bg.sample.main(sample.java:69)

Пока что пишу классификатор на "плохое"(ведущее потенциально к скорой ошибке) и "хорошее" (нейтральные логи, которые не ведут к потенциальной ошибке)

соответсвенно target это вектор [0] - хорошо [1]- плохо (есть ошибка)

Как можно организовать обучение нейронки "в рантайме"?

Например работает какое-то приложение на сервере и выдает какие-то логи, а нейронка бы их хавала определенной порцией и предсказывала бы, ведут ли потенциально эти логи к какой-нибудь фатальной ошибке типа "out of memory" или к ошибке типа "null pointer exception",

если да, то будут предприниматься какие-нибудь действия (например придет электическое письмо дяде сисадмину)

предсказывать будет какой-нибудь простой классификатор типа наив бейс или рандом форест или svm, но он вроде самый долгий,

второй вариант, что предсказывает какая-нибудь RNN, но с дип лернингом я пока не знаком,

насколько по вашему эта идея может взлететь?Как бы вы реализвовывали?

У меня такая реализация,

пока что я лишь присматриваюсь к нужному алгоритму, играю с логами и пишу методы, что б их парсить, весь ML реализован на Питоне с использованием библиотеки sklearn, а так же других стандартных библиотек,

парсинг логов и вытаскивание из них полезной информации целиком сделан с помощью регулярок и питоновской библиотеки re.Пишу в jupyter notebook на питоне 3.7

Можно анализировать лог, как естественный язык, есть набор тестовых логов, которые ведут к определенным ошибкам, к примеру: "out of memory" , "null pointer exception".

Проходимся по логу препроцессингом: убираем все знаки препинания;

потом идет Stemming - сокращаем слова до минимума, что бы осталась самая суть, (responsible, responsibility итд превращаются в response),

далее по тексту проходимся алгоритмом tfidf и превращаем текст в числовой вектор, это готовые features для классификатора, заранее берем от них 10% для тестирования, на выходе имеем 2 питоновских list

features_training и features_test

target это вектор, где единичка обозначает соответствующую ошибку,к которой ведет лог, нулевой вектор - нет ошибок

Думаю ни для кого здесь не секрет, что всем алгоритмам классификаторам пофиг на содержание текста, их интересует только частота появления определенного слова и наличие как можно большего количества тренировочных данных, больше того, наличие большого количества хороших данных это более внушительный залог успеха, нежели совершенность алгоритма,

Пока что проблема с подготовкой данных,

какую часть лога лучше брать для features ? Само сообщение лога или целиком строчку с таймстемпом,

Пример лога:

2017-03-14 22:43:14,405 FATAL [org.springframework.web.context.support.XmlWebApplicationContext]-[localhost-startStop-1] Refreshing Root WebApplicationContext: startup date [Tue Mar 14 22:43:14 UTC 2017]; root of context hierarchy

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Loading XML bean definitions from Serv

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with another entry after

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with no entries after

2017-03-14 22:43:14,476 INFO [org.springframework.beans.factory.xml.XmlBeanDefinitionReader]-[localhost-startStop-1] Here is a multiline

log entry with no entries after

2012-02-02 12:47:03,227 ERROR [com.api.bg.sample] - Exception in unTech:::[Ljava.lang.StackTraceElement;@6ed322

java.io.IOException: Not in GZIP format

at java.util.zip.GZIPInputStream.readHeader(Unknown Source)

at java.util.zip.GZIPInputStream.<init>(Unknown Source)

at java.util.zip.GZIPInputStream.<init>(Unknown Source)

at com.api.bg.sample.unGZIP(sample.java:191)

at com.api.bg.sample.main(sample.java:69)

Пока что пишу классификатор на "плохое"(ведущее потенциально к скорой ошибке) и "хорошее" (нейтральные логи, которые не ведут к потенциальной ошибке)

соответсвенно target это вектор [0] - хорошо [1]- плохо (есть ошибка)

В Украине.

>Например работает какое-то приложение на сервере и выдает какие-то логи, а нейронка бы их хавала определенной порцией и предсказывала бы, ведут ли потенциально эти логи к какой-нибудь фатальной ошибке типа "out of memory" или к ошибке типа "null pointer exception"

А где здесь обучение в рантайме? Берешь тонну логов с заведомо известным итогом, обучаешь сетку. Пока она работает, копишь новые логи.

Можно либо каждый раз обучать с нуля либо, если данных ну реально дохуя, дообучать (я бы не стал), во втором случае возможно придется сделать некоторые трюки типа рандомизации весов или пилообразной кривой learning rate, чтобы нейронка вышла из локального минимума (а-ля алгоритм имитации отжига), но этого будет достаточно.

>Пока что проблема с подготовкой данных, какую часть лога лучше брать для features ?

Если у тебя дипленинг, скармливай текст целиком, нейронка разберется. Я бы взял сверточную нейронку, которая бы анализировала, допустим, 16 кб логов, и так скользящим окном и делала бы предсказания. Дешево, сердито и никаких RNN. А стэммингам-хуеммингам она сама научится.

Даже интересно, сможет ли оно что-то предсказать. Задача вообще-то нетривиальная, т.к. обычно искать нужно не какие-то конкретные паттерны, а всевозможные отклонения от нормы.

sklearn.ensemble.IsolationForest

Если ты сможешь объяснить за день алкоголику-бомжу, что делать, то сможет. Если не сможешь объяснить студенту мехмата за неделю, то не сможет. Вилка где-то такая.

Пока рынок не отобьет затраты, не дождешься. Мы тоже не все разработки в открытый доступ выкладываем, все равно конкурентов нет

Юзаю openCV.

Не могу отделить нормально текст от фона для того чтобы заюзать бинаризацию, они сливаются. Пробовал контрасты всякие, насыщение етц, но тогда текст слишком сильно кораптит и иногда ocr просто рандомные значения выдает, к тому же "13" и "15" сливаются в одну циферку. Алсо фотка оч чувствительна к качеству, любой блик или тень к хуям вся портит.

пикчу перед обработкой обрезаю

Не надо ничего подготавливать. Больше данных, больше свёрток и сеть и так будет твои картинки распознавать

13 и 15 ты точно не отделишь. Сложный текст. Почитай статьи, как капчи распознают, может поможет.

Нейроночкой придется делать. Но датасет как ты будешь набирать я не знаю. Даже 10000 фоток (довольно маленькая выборка) ты помрешь делать.

178 Кб, 322x384

178 Кб, 322x384>Не надо ничего подготавливать. Больше данных, больше свёрток и сеть и так будет твои картинки распознавать

Ищи паттерны цвета какие-нибудь. Блять. Это банальная арифметика, нахуя ты это спрашиваешь.

Спс, няша

Индусам и китайцам отдай вместо капчи.

Deep Learning (Adaptive Computation and Machine Learning)

и

Hands-On Machine Learning with Scikit-Learn and TensorFlow: Concepts, Tools, and Techniques to Build Intelligent Systems

Гейроночки.

1) Есть ли Русская версии книги диплернинг.орг?

2) Нужно ли изучать основы программирования для работы с МЛ?там же на пайтоне и я пытался в него вкатится на днях-понял чуть менее, чем нихуя(алгоритмы, теории графов и т.д.)

Без английского тебе ловить все равно нечего, учи его сначала. Программировать нужно.

Как и программирование

Нужно начинать с основ программирования и только потом переходить в МЛ? Или просто начать читать эту книгу и кодить без фундаментальных основ программирования?

Да не нужно там программирование. Нужный объём за неделю осилишь, если не торопиться. Диплернинхбук - говно из жопы, попробуй сам почитать нраву про сверточные сети и убедиться, что авторы пишут хуйню, непонятную начинающему.

>а можно без английского языка?

>а можно без математики?

>а можно без программирования?

>а можно не умея читать?

>а можно будучи идиотом?

>а можно обезьяне?

>а можно камню?

Да можно, можно. Если кто спросит - говорите, что я разрешил.

А что не говно в таком случае?

Ебать, я как бы интересуюсь, а не собираюсь не делать лишнюю работу

Ниасилил и осуждаю, нужно чтобы в картиночках.

Ничо не понял.

22 Кб, 326x322

22 Кб, 326x322То есть по активности юзера винда пытается определить, отошел он поссать, или ушел домой, а значит можно скачать апдейт и перезагрузиться.

К чему тут снобизм? Вот первоисточник: https://blogs.windows.com/windowsexperience/2018/07/25/announcing-windows-10-insider-preview-build-17723-and-build-18204/

>How many times have you been immersed in a captivating virtual experience and…

>

> Wanted to take a quick peek at someone nearby?

> Wanted to reach for a drink, your phone or a keyboard?

> Needed to find a surface to set down your controllers?

>

>In the past you probably fumbled about or removed your headset, which can be clumsy if you have controllers in your hands.

Помогите определить уровень аутизма.

Любая плохообученая RNN с текстом.

С 231cs'a неслабо рвется жопа от первых двух домашних заданий. Датасаентисту из пиков в шапке нахуй не усралось писать свертки/полносвязные слои на нумпае

Будешь дрочить ненужную теорию, полезных знаний не получишь. Меня заебало на половине, дропнул.

заявление на фин. помощь подай

Отдавая деньги Яндексу ты финансируешь войну в Сирии.

только чтоб не какой-то индус рассказывал как он на tf курс биткойна предсказывает, а чтоб с рокетсаенсом

В этой книге очень наглядно и ПО ПРОСТОМУ все объясняется.

> В этой книге очень наглядно и ПО ПРОСТОМУ все объясняется.

Иди на каких-нибудь других даунах свои гроши зарабатывай. Зарепортил.

Еблан?

Что бы там зарабатывать нужны многотысячные скачивания. Больше источников я не нашел если найдешь лучший источник то выкладывай.

И сьеби школьник.

Съебал тебе за щеку.

>вашем какашечном диплернинхбуке

))

>многие и английского не знают

Ну и пусть нахуй идут, чего уж надрываться.

>ргхост

Здоровья брату.

А сколько платят?

Добавьте вопрос в фак, а то хз стоит ли вообще тратить время на изучение.

Тем, кто задаёт такие вопросы - не платят.

24 дошика буду зарабатывать каждый день. Вот это да.

Спасибо

Ути какой милый ватничек!

потрепал за щечку

Ничего, английский очень простой язык и ты обязательно сможешь однажды его выучить чтобы читать статьи для больших мальчиков, а не переводы на хабре.

>Ничего, английский очень простой язык и ты обязательно

Я достаточно знаю это говно что бы читать техлитературу, а так же вполне очевидно что никто из копетооиздов не будет рассказывать о своих наработках, а вот пиздануть хуйни это да, большие мальчики любят жрать говно.

Сколтех вроде что-то публикует. Я видел только на английском. У Ветрова были статьи на русском точно.

> а так же вполне очевидно что никто из копетооиздов не будет рассказывать о своих наработках,

Какое же ты быдло. Маня, очнись, гугл тебе наработки сливает нахаляву, слесарьплов тот же. Забирай, пользуйся. Но тебе проще ныть, оправдывая свое биомусорство грязноштанными мантрами про плохих капиталистов. Петух, сука.

> Деньги мне плати, тогда расскажу.

> англоязычные капиталисты ничего не могут, только щедрые русские постят ноу-хау

>Маня, очнись, гугл тебе наработки сливает нахаляву, слесарьплов тот же.

Кококо, кудахкудах, ФайндФейс провел шершавым по нейроноблядям и съебал в закат, а гугля выкладывает неработоспособную хуйну и зоонаблюдает как петушня пытается слепить из говна пулю, впаривая им потихонечку курсики.

Мб, добавить в шапку

>Водка закончилась?

Послал за ней автономный автомобиль на нейронках, но он не отличил дерево от дороги и самовыпилился.

>гайда как вкатиться в математику со школьного уровня?

Нейронодибилы ИТТ еще сами вкатываются

Что там непонятного? Выучи определение пучка и вперед "Что такое математика". Когда зазубришь определение единицы и некоторые другие бурбакизмы, тогда обращайся в этот тред. Картофан не нужен.

Я хотел программу вербицкого предложить, но ты меня опередил

Давно уже пора делать учебник математики с йобами и мемасами. Но интерактивный, чтобы адаптировался под ученика с помощью слесарьплова. Дополнительно прикрутить всякие там Coq и демидовичи.

Теоремы будем писать в виде будапешт-тредов

Применим Бенедикта Камбербэтча.

патралил лалку, кек

https://shazoo.ru/2018/08/05/68631/strim-ii-protiv-topovyh-igrokov-v-dota-2

>этот студентик гордящийся просмотром сериалов в оригинале

Ну а ты, если поднажмёшь, сможешь выучить и другие языки когда-нибудь, тогда может получится избавиться от своей болезни неофита.

разъебал их!!!!!!

Конечно.

Что такое equal variance??

Во второй раз просматриваю эти лекции, но понимание не приходит

https://classroom.udacity.com/courses/ud730/lessons/6370362152/concepts/63798118400923

Вся матчасть нужная для нейроночек есть на русском, любые совковые учебники подойдут, нихуя в этом калкулусе не изменилось со времён Фихтенгольца, как и в основах теорвера со времён Вентцель. Интеграл он и в Африке интеграл, как и теорема Байеса. Читайте хотя бы самые азы на русском, ничего плохого в этом нет. Потом хоть лекции эти понятны будут, если они вообще нужны.

Ненужное говно

Просто внимательно смотрите эти лекции, и найдите где-нибудь задания по математике. Лучшее, что есть их русскоязычного сегмента.

Тебе мало сотен имеющихся учебников?

На крайний случай есть https://www.khanacademy.org/math/calculus-home

>Лучше делайте новый учебник математики

Бытует мнение, что без сапога в жопе вуза математике научиться будет очень сложно. В вузе тебя ебут и ты вынужден чем-то заниматься, а на самообразовании в математике далеко не уедешь, особенно если с нуля начинаешь.

А для "нашей эпохи" без видео и мемасиков совсем никак? В любом случае, на что рассчитывают вкатывальщики в нейроночки и датасаенс если не могут осилить обычные учебники по математике?

> без видео

Ну почему, я выше скинул лекции СПБГУ по математике. Если смотреть их и еще заниматься по учебникам, то, может, что-то и получится.

Перефразирую, "нашей эпохе" обязательно учиться по видео и мемасикам? По пейперам тоже будете видяшки ждать на ютубе? Вообще, это внезапно похоже на бизнес-идею, поднять канал где милая рыжая "датасаентисточка" с двумя курсами английской филологии будет поставленным голосом пересказывать санити и рисовать заранее подготовленные нефотогеничными бородачами иллюстрации.

>где милая рыжая "датасаентисточка"

Вроде такой курс был у мфти, там тяночка вела датасаенс.

Ну вообще да, желательно учиться по книгам, но в довесок можно и серьезные лекции смотреть.

>нашей эпохи

Это которая "нихуя не знаю, ничего не умею, со сраковерфлоу код копирую"? Удачи, ага.

Давно пора вернуть пту, чтобы загонять туда в край охуевших современных холопов я б сам пошёл в пту, если бы там качественно готовили, лол

>>42023

Уже ведь вроде есть канал с названием типа "пейпорс ин файв минетс", где какой-то индус разжёвывает всякое популярное говнецо.

ПТУ - это кстати очень годная тема, потому что 90% людей высшее образование совсем не нужно.

Там скорее обзорные популярные видео уровня "Анализ данных и машинное обучение простыми словами"

Так ведь это то, о чем мечтают напомоечники ИТТ: смареть про машобчик без матеши.

Ну есть же разные врачи, физики-ядерщики, йоба-инженеры и математики, которые придумывают новые дата саенсы.

А остальным не нужна, да.

Совсем никак. Современное поколение даже не умеет толково завязывать шнурки и определять время по аналоговым часам. Нужно адаптировать и повышать уровень образования.

> Учебник будет интерактивным и расширит идею 4 фотокарточки с ОП-сообщения.

Так расширь её сам, начни с себя. Вот лично я рисовал сигму и интеграл, которые туда потом добавили. Возьми нарисуй что-нибудь ещё.

Для дипленинга ничего кроме градиента и перемножения матриц знать не надо!

пруф что это не так

Лалки/мемасики

Да, только при устройстве на работу требуют Master Degree, а то и PhD в области математики/computer science.

Я вот например в computer vision хочу, там вот почему-то нужно намного больше, чем матрицы и градиент

лол ну чтоб прочитать на вики определение нормированного пространства не нужно 5 лет брать интегралы на мехмате

не вполне знаком с программой матмеха, но полагаю что еще года 3 надрачивают концепты еще более далёкие от машоба чем счёт интегралов

Суть в том, что на матмехе легче найти людей, которые интересуются машобом.

Ну и, учась на обычного программиста, ты, скорее всего, даже ту жалкую математику для машоба не осилишь

ну тык открываешь на вики страничку про нормированные пространства, оттуда идёшь на страничку про векторные

В интуиции это всё уже у нас есть, нужно просто прочитать про то, как это называют окружающие

И таких понятий, совершенно элементарных, не так много, причем можно по ходу обучения мл'ю их познавать, видя примеры и зачем это надо

это так, да

Можем обсудить то что родители хотят чтобы я бросил науку, начал кодить всякие игры-сайтики и нашел обычную тяночку.

Так скажи им, что ты уже знаком с дядей йобой, который по совместительству завкафедрой и он тебя берет на работу.

Нет, ну а что, говори, что будешь преподом работать

Бля, такого я не ожидал

Ну говори, что любишь спокойную работу. Скажи, что будешь до 80 лет работать в вузе, в то время как твои сверстники умрут в 40-50 лет, работая на заводе или где-нибудь программистами

Сын папиного друга закончил на химика, кажется, а теперь успешный кодер за 300кк/c, а дочь маминой подруги отучилась на филологии, после чего стала эйчаром, теперь спокойно живет с кучей свободного времени и хорошей зарплатой. А я отучился на программиста и внезапно не в айти - больная тема для всей семьи, знакомые смеются.

Ну так твоё мнение не репрезентативно, для человека, который толком математикой не занимался, начать вики по математике листать будет проблематично. Это тебе всё очевидно, другим не очень

Само собой

Но читать все тома зорича тоже плохое решение

Курс по матеше для МЛ должен составлять какую-то очень-очень малую часть от того, что запихивают в вузиках.

И такой вполне под силу должно быть осилить даже без прессинга вузовского

только сомневаюсь что он существует

Это не прессинг, а мотивация к обучению.

Ну вот покажите мне персонажа, который полностью самостоятельно поднял математику со школьного уровня и хоть как-то вкатился?

Идешь в вузик первый курс адово ботаешь всё, заводишь знакомства и готовишься к поступлению в ШАД

После поступления в ШАД дропаешь вузик

+Матешка

+Связи

+Бумажка для работодателя

+Сэкономленное на философии и диффурах время

А где ты жить будешь?

>первый курс адово ботаешь всё

Если ты какой-нибудь сверхразумист с айсикью > 180, то может и осилишь.

Обычные люди идут в шад, когда уже учатся в аспирантуре/магистратуре

Залез в вики. А разве в ШАД учат машобу? Вроде там статистика и бигдата только.

Я предпочитаю выписывать темы из википедии и смотреть объяснения на ютубе, они меня расслабляют и успокаивают.

Области очень похожие и во многом пересекаются, но это разные вещи.

Так эти лекции на ютубе есть, лол.

Просто например для человека, который ни разу ничего не слышал про множества, функции и прочий высший матан, будет гораздо проще и легче начать с каких-нибудь лекций, которые его заинтересуют, а потом уже можно и книжечки начать ботать.

Гораздо более перспективное и полезное подмножество чем весь остальной датасаенс, лол.

Машоб там читают два сема, читает Воронцов даже видео есть, а у местного анона галлюцинации

>Если ты какой-нибудь сверхразумист с айсикью > 180

Но машинное обучение же для таких, разве нет? ага, очень сложно подгонять параметры

>Обычные люди идут в шад, когда уже учатся в аспирантуре/магистратуре

Мне казалось, там большинство студентов идут после 2 курса ФИВТ или ФКН или т.п.

Так-то в хорошей (даже не математической) школе в мат. классе дают пределы через епсилон-дельта, производную и интеграл.

Я, например, первый курс вообще хуи пинал. В СПбГУ

мимо

Просто ты не в курсах, что на предикторы можно навесить пространство функций и это тоже будет линейной регрессией

Основные теоремы из 20-го, алё.

ну йобаИИ без phd не создать и тут дело больше в среде чем в математике

В таком случае тут от регрессии вообще нихуя не остаётся. Это вообще перестаёт быть каким-либо решением или аппроксимацией.

Поэтому непараметрическая статистика - выбор мужиков!

Какое-то окно в круга элиты этот ваш двач.

Он их сам в model dir сохраняет в види чекпоинтов. Бери последний. Потом сохраняй в frozen graph

Квадрат - гладкая функция, везде дифференцируема, а модуль - нет, у него особая точка в нуле. Иногда удобнее работать с функциями, которые можно продифференцировать.

если брать квадрат то получается как бы скалярное произведение

на пространстве случайных величин с нулевым мат ожиданием

отсюда имеем некоторые приятности

точнее если E[X] = E[Y] = 0, то скалярное произведение у нас <X, Y> = E[XY]

и тогда дисперсия Var[X] это |X|^2 в этом гильбертовом пространстве

В частности независимые случайные величины будут ортогональны и мы получим Var[X + Y] = Var[X] + Var[Y] в таком случае, что приятно и полезно

fix:В частности -> например

Допустим, я получил оптимальные гиперпараметры с помощью чего-либо. Далее проверяю качество обученной на трейнинг датасете модели на валидационном наборе, и если оно хуёвое, то что? Пытаюсь упростить модель или перейти к другой?

Пиздос. Это основы, которые в любой книге в той или иной степени подробности описаны. Иди ищи сам.

> Как проверить модель на оверфит?

Очень низкая или нулевая ошибка на обучающие сете и очень большая на тестовом.

это какой-то уж очень вырожденный случай

Я бы на кросс валидации посчитал скор, если есть возможность и если скор на кросс валидации будет значительно отличаться от скора на тесте, то да оверфит

Ну или можно смотреть на скор на трейне/тесте в зависимости от итерации обучения и когда скор на тесте пойдет вверх, то мы начинаем переобучаться

Это из каких-то наивных соображений если

коко нужно ли мотимотеко?

последний тред, 2 года спустя:

коко нужно ли мотимотеко?

как проверить модель на оверфит?

И что ты этим хотел сказать?

> и когда скор на тесте пойдет вверх, то мы начинаем переобучаться

Ты наверно хотел написать "вниз". Да, такая идея, иногда чуть сложнее используется. А вообще читай книжки. Даже в самом простом гайде для конченных дебилов это написано.

Потому что матожидание это минимизация именно квадратичного момента E[(x-С)^2], т.е. С=Ex это такое С при котором для данных x величина минимальна.

Если ты возьмёшь абсолютный первый момент вместо второго E[abs(x-С)], то ты обнаружишь что он минимизируется уже в медиане, а не в среднем.

Поэтому, если ты берёшь матожидание в качестве параметра для оценки "среднего", то к нему логичнее брать именно среднеквадратичное отклонение.

а через C-api вообще реально обучать и сохранять чекпоинты?

Помогите с пандас.

У меня есть датафрейм и я хочу в некоторых его столбцах поменять НА на среднее по этому столбцу, допустим. Среднее у меня вычисляет функция MyMean почему же тогда не работает такой код?

https://pastebin.com/ECAnZtkP

А что не так?

Ну вообще две причины есть для этого, а скорее даже три.

Я хочу попрактиковаться в таком синтаксисе.

Я не знал, как mean обходится с пропущенными значениями.

Моя функция работает с датафреймом, а mean с массивом.

Делай по каждому столбцу отдельно. ДФ и нампи массив это не одно и то же, например типы данных у столбцов будут разные. Такие операции со всем ДФ это не пандас-вей.

>Делай по каждому столбцу отдельно

В смысле циклом проходится? Эх, а я хотел каким-нибудь питоновским изъебом воспользоваться.

Т.е. ты советуешь брать по столбцу, считать среднее и заменять?

И можешь пояснить насчет разницы между датафремом и масивом нумпай. Если я вытащу первый столбец, то это же будет массив нумпай или все же это будет дата фрейм? Т.е. я не очень понимаю, с чем я в итоге должен работать, чтобы следовать пандас-вей.

Да, циклом. Там делов на одну строчку больше по сравнению с твоим кодом.

ДФ это набор столбцов. Каждый столбец это т.н. Series. Чтобы преобразовать это в массив нампи, нужно использовать поле values.

Padas-way это преобразование датафреймов как таблиц, наподобие реляционной БД. Там для этого есть индексы, всевозможные join и groupby.

Последний вопрос, можно?

А в чем смысл этих values, если я могу обратиться через iloc допустим и индекс и получу то же самое число?

Через iloc ты можешь получить либо скаляр, т.е. одно число, строку и т.п., либо опять же пандасовские типы DataFrame или Series. values преобразовывает все в типы numpy.

Еще один тонкий момент, который не упоминается в доках: любой доступ к ДФ на порядки медленнее доступа к массивам нампи. Так что часто не имеет смысла пользоваться пандас, если тебе не нужны его специфические вещи. Если у тебя там просто матрица в ДФ, лучше взять от нее values и работать с массивом.

You mean "latest"?

Это копия, сохраненная 19 сентября 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.