Это копия, сохраненная 28 июня 2017 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Pattern Recognition and Machine Learning, Bishop.

Information theory, inference & learning algorithms, MacKay http://www.inference.phy.cam.ac.uk/itila/

Machine Learning: A Probabilistic Perspective, Murphy

Introduction to Statistical Learning ( http://www-bcf.usc.edu/~gareth/ISL/ISLR Sixth Printing.pdf )

Elements of Statistical Learning ( http://statweb.stanford.edu/~tibs/ElemStatLearn/printings/ESLII_print10.pdf )

Foundations of Machine Learning, أشهد أن لا إله إلا الله وأشهد أن محمد رسول الله. http://www.cs.nyu.edu/~mohri/mlbook/

Fundamentals of Neural Networks: Architectures, Algorithms, and Applications, Fausett L.

А. Пегат, "Нечёткое моделирование и управление"

другое

http://libgen.io / http://bookzz.org/ - здесь можно одолжить ^ книги и не только

http://arxiv.org/find/all/1/all:+nejronochki/0/1/0/all/0/1

https://www.reddit.com/r/MachineLearning/wiki/index

https://vk.com/deeplearning и http://deeplearning.net/reading-list/

https://www.kadenze.com/courses/creative-applications-of-deep-learning-with-tensorflow/info тюториал по slesarflow

http://rgho.st/8g68fTCSx две брошюры по deep learning для слесарей.

http://kaggle.com - весёлые контесты. денежные призы

https://www.hackerrank.com/domains/ai/machine-learning/difficulty/all/page/1 - олимпиадки

курс от китаёзы

http://videolectures.net/mlss09uk_cambridge/

яп

1. http://julialang.org/

2. https://www.microsoft.com/en-us/research/project/infernet/

3. https://www.r-project.org/

4. питухон и так все знают

5. idris/coq - модные яп для формально верифицированных нейроночек с тренировкой на этапе компиляции

ПЛАТИНА

Книги хорошо, но с чего начать практический вкат?

Во-первых, вам нужна любая unix-based система. На Windows возможно запустить нижеперечисленное, но ждите пердолева с настройкой и неодобрительных взглядов анонимуса. Кроме того, в компаниях, так или иначе связанных с разработкой йоба-ПО и machine learningом, Linux/OS X является стандартом. Привыкайте.

Во-вторых, определитесь с языком. Python и C++ наиболее мейнстримовые инструменты, с ними вы без еды не останетесь. Есть еще R, на котором пацаны живут статистикой и анальными пакетами. Некоторые инструменты являются языко-независимыми (Vowpal Vabbit, XGBoost), но обвязывать их вы все равно будете из какой-либо среды.

На Java разработано много production-ready инструментов для бигдаты и если вы угораете по терабайтам данных, то имеет смысл посмотреть в её сторону. Впрочем, лучше это делать уже потом, когда прийдет осознание потребностей.

В-третих, выбирайте себе задачу. Что угодно: распознать качпу, обнаружить ботов по логам, найти раковых больных. Список можно посмотреть, например, на kaggle.com. После чего приступаете к решению выбранной задачи.

Не прийдется ли мне потом с таким наборищем знаний идти в макдак работать?

Несмотря на хайп вокруг ML, далеко не во всех IT компания есть необходимость в ML и понимание круга задач, которые можно решить этими методами. Но поверьте, в 2017 компетентный специалист будет востребован. В России потребителями ваших знаний могут стать: Яндекс, Mail.ru, Вконтакте, Rambler, Касперский, Билайн, Связной, ABBYY, Хуавэй. В биоинформатике есть определенный спрос, можно поскролить http://blastim.ru

Здорово, но я так и не понял чем же вы занимаетесь в IT компаниях?

Попытаюсь ответить со своей колокольни и сразу хочу предупредить, что это едва ли консенсуальное мнение.

ML-специалист - это такое зонтичное определение для человека, способного увидеть проблему, выгрепать кучу логов и данных, посмотреть на них, придумать решение проблемы и врезать это решение его в продакшн. По сути, это кодер, решающий не чисто технические, а, в некотором роде, человеческие проблемы.

Имхо, мы все же остаемся в первую очередь разработчиками.

Что такое TensorFlow?

TensorFlow - опенсорсный гугловый инструмент для перемножения тензоров и оптимизации функционалов. Опенсорсный - потому что даже важные куски типа параллелизации уже выкачены в паблик. Если вам все ещё непонятно что это, значит это вам и не нужно, сириусли. Google перестарался с рекламой и теперь люди думают, что TF - это серебряная пуля и затычка для каждой бочки. До TF был Theano, который выполнял свою работу не хуже. И, в отличии от TF, он уже находится в стабильной фазе.

будет ли ML нужен в ближайшие 10 лет, или это просто хайп?

будет. хайп.

смогу найти работу?

Яндекс, мейлру, касперский, несколько биоинформатических компаний (iBinom, можно еще blastim.ru поскролить на тему работы), билайн (они с НГ целое подразделение открыли под ML и биг дату), связной. Ну и западные аутсорсы, если готов рачить за валюту.

нужна математика?

для начинающего ничего особого знать не нужно

https://www.amazon.co.uk/Calculus-Michael-Spivak-x/dp/0521867444

https://www.amazon.co.uk/dp/0534422004/ref=pd_lpo_sbs_dp_ss_2?pf_rd_p=569136327&pf_rd_s=lpo-top-stripe&pf_rd_t=201&pf_rd_i=0980232716&pf_rd_m=A3P5ROKL5A1OLE&pf_rd_r=3TZ38AZ2BY28R19H4SA5

https://www.amazon.co.uk/Calculus-Several-Variables-Undergraduate-Mathematics/dp/0387964053

https://www.amazon.co.uk/Introduction-Probability-Dimitri-P-Bertsekas/dp/188652923X

"основы теории вероятностей" Вентцель

поясните за нейроночки

нейроночка - массив

шад)))

Нет там ничего ML-специфичного, знание матана и теорвера на уровне заборостроительного вуза. Теорвер проходится на третьем курсе, как раз 20 лет.

Рандомный хрен туда не сможет поступить, потому что планка намеренно задрана, а не потому что там такая охуенно сложная программа. Это традиционная наебка "элитных учебных заведений", в которой учат так же хуево, как и везде, но за счет отбора поступающих якобы формируются неебовые успехи, которые объясняются именно качеством преподавания.

Иными словами, у тех, кто способен поступить, и так в жизни проблем с трудоустройством не будет.

Тред #1: https://arhivach.org/thread/147800/

Тред #2: https://arhivach.org/thread/170611/

Тред #3: https://arhivach.org/thread/179539/

Тред #4: https://arhivach.org/thread/185385/

Тред #5: https://arhivach.org/thread/186283/

Тред #6: https://arhivach.org/thread/187794/

Тред #7: https://arhivach.org/thread/196781/

Тред #8: https://arhivach.org/thread/209934/

Тред #9: https://arhivach.org/thread/223216/

Тред #10: https://arhivach.org/thread/234497/

Тред #11: https://arhivach.org/thread/240332/

Тред #12: https://arhivach.org/thread/246273/

Тред #13: https://arhivach.org/thread/256401/

все кто ниже пидорасы ебал их мамок

Почему мне кажется что тут одни школьники...

нет ты мамку ебал

а тут в конкурсах кто-то занимал призовые места?

Они уже создали ИИ. Гугли AIXI.

задаешь приорное распределение над параметрами и теоремой баэса +данные вышисляешь постериор

вместо точечной оценки параметров как в устаревшем классическом/частотном подходе у тебя есть распределение вероятности над пространством параметров

Школьник, уйди в /сцай

Я работаю в стартапе. Теоретически это от 9 до 5, но, как правило, все мы остаемся позже. Большая часть дня действительно находится перед терминалом, отлаживая или записывая код, время от времени обучая модель или две, но часто это то, что просто работает в фоновом режиме, пока вы работаете над чем-то другим. Каждую неделю проводятся как минимум несколько встреч, но они, как правило, довольно короткие.

Мне нравится, что каждый день появляется что-то новое, и мы также стараемся идти в ногу с исследованиями. С другой стороны, неясность и отсутствие четкой документации - самые неприятные вещи, особенно если вы ищете какую-то загадочную причину, то что-то не работает.

Я работаю над своими задачами, которые обычно связаны с одним из:

Оценка модели, которая была обучена

Работа по настройке для обучения новой модели

Оценка литературы для перспективных технологий

Данные по очистке

Составление потенциального подхода к проблеме

Развертывание модели для производства

Я работаю в псевдо-исследовательской среде. Я заходила в 10 утра, выходила около 5 вечера. Вернитесь к компьютеру около 9 часов вечера и немного поработайте / играйте до 11 или 12 ночи. Я часто работаю во время одного из вечеров выходных (обычно в воскресенье вечером, когда у меня есть свободное время, чтобы поиграть с моделями и т. Д.).

Типичный проект состоит из бесконечных обсуждений и исследований, чтобы решить, что является подходящей целевой переменной и целевой группой. Лучше ли смоделировать вероятность дефолта в 1y? 6m? Что представляет собой дефолт (это действительно сложно)? Если я создаю модель для оценки вероятности того, что кто-то не оплатит свою кредитную карту, хочу ли я использовать данные из всех банков или только моих клиентов? Являются ли мои выбранные данные обновленными в рабочей среде? Могу ли я полагаться на эту информацию? Моя модель - это инструмент для принятия решений, но на самом деле решения будут приниматься на основе модели? Если ваша модель должна использоваться менеджерами филиалов, но они не могут понять ее логику, они могут просто игнорировать ее.

Я работаю в стартапе. Теоретически это от 9 до 5, но, как правило, все мы остаемся позже. Большая часть дня действительно находится перед терминалом, отлаживая или записывая код, время от времени обучая модель или две, но часто это то, что просто работает в фоновом режиме, пока вы работаете над чем-то другим. Каждую неделю проводятся как минимум несколько встреч, но они, как правило, довольно короткие.

Мне нравится, что каждый день появляется что-то новое, и мы также стараемся идти в ногу с исследованиями. С другой стороны, неясность и отсутствие четкой документации - самые неприятные вещи, особенно если вы ищете какую-то загадочную причину, то что-то не работает.

Я работаю над своими задачами, которые обычно связаны с одним из:

Оценка модели, которая была обучена

Работа по настройке для обучения новой модели

Оценка литературы для перспективных технологий

Данные по очистке

Составление потенциального подхода к проблеме

Развертывание модели для производства

Я работаю в псевдо-исследовательской среде. Я заходила в 10 утра, выходила около 5 вечера. Вернитесь к компьютеру около 9 часов вечера и немного поработайте / играйте до 11 или 12 ночи. Я часто работаю во время одного из вечеров выходных (обычно в воскресенье вечером, когда у меня есть свободное время, чтобы поиграть с моделями и т. Д.).

Типичный проект состоит из бесконечных обсуждений и исследований, чтобы решить, что является подходящей целевой переменной и целевой группой. Лучше ли смоделировать вероятность дефолта в 1y? 6m? Что представляет собой дефолт (это действительно сложно)? Если я создаю модель для оценки вероятности того, что кто-то не оплатит свою кредитную карту, хочу ли я использовать данные из всех банков или только моих клиентов? Являются ли мои выбранные данные обновленными в рабочей среде? Могу ли я полагаться на эту информацию? Моя модель - это инструмент для принятия решений, но на самом деле решения будут приниматься на основе модели? Если ваша модель должна использоваться менеджерами филиалов, но они не могут понять ее логику, они могут просто игнорировать ее.

Бля, хотелось бы на русском. Но, все равно спасибо.

> пик1

Зачем такие картинки в медленной тематике постить, где висеть на нулевой будет три дня? Не под NSFW же сидеть.

Да меня вообще ничего уже не ебет. Просто пообщаться с кем-нибудь на эту тему интересно было бы. Чего сегодня такой злой?

Увы, у нас разные системы ценностей, друже. Но ты не виноват, ты такое же животное как я, со своим набором нейромедиаторов в черепной коробке.

всегда пользовался готовыми либами для алгебры/моделек под видюхи

свой кудакернел написать не смогу

хинт: юмор не о твоём посте

https://github.com/arrayfire/arrayfire

опенсорсная обёртка над другими опенсорс либами

много функций для матриц и прочих алгоритмов для массивов

доступна на многих яп, я пользовался на юле и эфсярпе

немного течёт (читай вызываешь сборку мусора вручную лол) но для моих говноподелок норм

простой пример ускорения: умножить 2 рандомных 10к х 10к матрих ~0.3 сек на 1080, где-то в 20 раз быстрее проца

Вот это интересная вещь, сейчас изучу. Спасибо, доброанон!

мамка в комнате рядом?

>Надо через месяц простой распознаватель наличия кошечек и людей на фотке сдать

смотри как в opencv это зделано

каскады хаара, если не ошибаюсь

шабллоны в хмл есть и для людей и для котов

>на каком уровне нужно знать, скажем, Python?

Уровня "import tensorflow as tf" хватит. Тебе ж не новые алгоритмы разрабатывать.

Почему заебется? Питон же не сложный. А линал на практических примерах гораздо проще и тверже усваивается.

перекатываюсь к вам из пхп-треда

Я уже тут два раза спрашивал, кто-то вкатился в индустрию на зарплату? Вот почему.

А учить дрочить можно хоть рокет саенс ради прикола, но ракеты ты от этого строить не будешь. Клоуны.

Зачем нон-стоп сидеть тут, если уже вкатился? Я в пхп-тред захожу пару раз за полгода, например.

А ответ на твой вопрос есть в архивах тредов.

Да никто не вкатился, что вы как маленькие, тут просто все как хобби ковыряют не спеша эту тему.

Доктор блять по физике, ну нихуя себе блять, тут на сосаке большинство закончили гуманитарошараги! шараги! блять. И эта говномасса мечтает о нейроночках.

Ну я на 6 курсе мфти например

Математику на уровне Миши Громова или Макса Концевича на худой конец, физику хотя бы на уровне Эдварда Виттена итд ну ты понял

Отталкивайся от AIXI и Solomonoff induction.

Если часто, то какой базой можно еще воспользоваться для обучения говнонейроночки на распознавание?

О! Спасибо! Чем-то напоминает мою ситуацию.

>>981325

PhD соответствует уровню кандидата, гуманитарий ты наш из шараги.

чое гуманитарий тип) азхах

Та же херня. 3 курс, работаю жабомакакой. Из-за МЛ окончательно бросил развиваться как программист. А ведь хотел писать крутые архитектуры, знать паттерны и всё такое. И это всё ведь поможет мне стать крутче на рыночке, укатиться на другой континент. Но я как мудак сижу и дрочу нейрончики.

Ну вот перекачусь. Может быть.

Какие достижения в ml? Давно куришь тему?

>всм надоел?

всм заебал

> задача

Вообще у меня метрика, но в го-тредике крудо-песатели долбоебы, а этот тред мне показался ревелантным. Ну в самом деле, не у веб макак же спрашивать. Что касается выбора технологии, то хозяин великодушно разрешил выбрать самому.

>мало либ

Жаль. Два года назад искал аналог nltk на Go, до сих пор с этим хуево.

Сайт тензорфлова говорит, что у него есть C API. Гугол говорит, что жабаскрипт умеет в FFI.

Вперед и с песней.

все вещественные параметры белые люди выводят теоремой бейса и плоским нормальным приором

аналогично, вместо нормального ебашат дискретнный равномерные приор

Что вообще почитать для биггинеров в машобе? Можно на английском.

Ты уверен что сможешь стать настоящим слесарем, если не можешь прочесть оп-пост, придурок?

Или даже потребности начинающего уже включают в себя аренду мощностей на амазонах, и домашний пека можно не апгрейдить?

ИИ

- есть набор картинок, на картинках зависящие друг от друга фигуры.

- датасет организован так, чтобы представить эту зависимость в форме 4картинка = f(3картинка,2картинка,1картинка), следующий набор - 5картинка = f(4картинка,3картинка,2картинка) и т.д., по-сути нечто вроде матрицы Ганкеля, но не с цифрами, а с картинками фигур, что есть стандартный метод представления динамической системы.

Вопрос - сможет ли сверточная нейроночка идентифицировать систему по такому датасету, конкретно требуется, чтобы она выдавала 4ую фигуру по предъявленным трем предыдущим?

Школота блять

Что с ними не так? Обычные среднестатистические

Меня другое в яше поразило, как они относятся с людям, мне письмо от них пришло через ЕБУЧИЙ МЕСЯЦ, когда я уже нашел другую работу. Нахуй так делать? Или им кролики нужны которые только на Яндекс молятся?

Ну а что ты предлагаешь им делать? Чем богаты, тем и рады.

Первое лицо вообще непонятно почему тебя смутило.

Ну хуй знает, как то сухо все идет повествование, мне бы что покрасочнее с картиночками графиками, охуительными историями.

Так сказать книга обзор, экскурс в область. Не углубляясь. И не сильно обмазываясь.

Просто интересно кем надо быть чтоб туда попасть. Если я обычный хуй с старших курсов мфти каковы мои шансы

>каковы мои шансы

высокие, для нормальных людей яндекс зашквар, только матанопитухи мечтают там петушиться

Будут ли веса нейросетей, распознающих эти изображения похожи хотя бы на начальных слоях?

Можно ли по схожести весов сказать о схожести изображений?

нет

ML рассматриваю как возможный путь переката из мобайла в течение года, поэтому не особо спешу, и идея посматривать видосы параллельно с книжками кажется нормальной. Но вот сертификат этот - он вообще что-то даст?

Скорее всего ничего не даст, но я прохожу.

Половину специализации можно пройти за две недели, дальше пока не знаю. Хочу уложиться в два месяца. На мой нубский взгляд, очень крутая специализация.

мимо такой же перекатыватель

>>983290

Котаны, а я просрал все полимеры, не серьезно отнесся ко всей этой шляпе, и на 2-ом курсе специализации не сдал все домашки, и в итоге сертификат второй не получил.

Дропнул, думал может заного вкатиться пробовать.

Млять... и сейчас думаю может пробовать заного вкатываться...

У меня просто каша в голове: Нейронные сети, Машинное обучение, БигДата, ИИ, Диплернинг, Компьютерное зрение, и т.п.

Типо как граф связей что от куда вытекает , что сначала надо изучать.

Почему бы и не попробовать?

Я сейчас заканчиваю первый курс, но морально настроен на его повторное прохождение и осмысление, т. к. чувствую, что знания усвоились недостаточно твёрдо (хотя ответы на все вопросы в тестах даю правильные).

Планирую найти какой-нибудь задачник по линейке, попрактиковаться с матрицами, векторами, функциями. Может кто подскажет годные варианты?

На втором курсе сложность просто по экспоненте вверх поползет, 1-ый просто лайтовый.

Что такое норма векторного пространства? Простым языком можешь объяснить?

Там в основном все до 1993 года освещается, а мне бы что происходит в настоящем.

Может тебе второй курс показался сложным, потому что материал первого не до конца понял?

Ну вот что я нашел, что-то подобное еще встречали?

Длина вектора

В питоне же куча библиотек, тот же scikit, pandas, numpy, bob, opencv, tensorflow и еще 100500. И вряд ли на r есть пакеты уровня opencv. Вот собственно интересно чем же r так хорош

Сто раз пояснял, что кроме сверточных нейроночек пистон для мл по сравнению с R пустое место. Но школьники все равно кроме сверточных сетей и хгбуста ничего не знают, поэтому пояснять что'то бесполезно.

Я после каждой лекции смотрю видео на ютубе, там очень простым языком все понятия объясняются, и читаю книжку машин лернин виз питон. Мне кажется, простые понятия из линейки можно и на википедии смотреть, либо на том же ютубе.

На моих данных PCA чот хуёво работал, сейчас нагуглил про автокодировщики, пасаны грят охуенная тема.

В том числе. Я обычно просто набираю название непонятной вещи, типа ordinary least squares, и там вылезает куча видео, в которых простым языком именно эта вещь объясняется.

ну хз за 2 недели можно пройти если ты нигде не работаешь/не учишься и просто щелкаешь правильные ответы.

>>983325

Интересно, с линалом у меня все ок, а вот больше проблемы с тервером.

Ты почти прав. На работе куча свободного времени, там и прохожу. Да и первый курс крайне простой, за день осилить легко. В целом не вижу ничего не реального в том, чтобы неделю в день-два делать.

А как ты вкатиться планируешь?

У меня тут пукан бомбит что у меня шарага техническая, а не божественный МФТИ, а ты голодранец вообще без ВО?

КАК? Или ты для души куришь машоб?

Я пока не строю планов по вкату. Просто тема интересная.

Цель на текущий момент — заполнить пробелы в знаниях по матеше и запилить что-нибудь в машобчике, уровнем тянущее на диплом нормального вуза. Для себя.

Ещё мне почему-то начал нравиться питон.

Ну и непохоже, что эти вакансии невозможно потянуть и без ВО:

https://yandex.ru/jobs/vacancies/research/mlspec_ydf/

https://yandex.ru/jobs/vacancies/analytics/data_scientist_market/

ВО нужно, если в твои должностные обязанности входит написание статей в научных журналах или ты метишь в глубокое R&D. Ну мне так кажется, возможно и неправ.

Я начитался что в яндексе одни петухи работают, и типо там маленькие ЗП, а мотивируют они это тем что "работать в нашей компании большая честь".

Да, скорее всего, так и есть. Зарплата пых-макаки с годом опыта.

>>983792

>и типо там маленькие ЗП

Тоже слышал такое. Но после нескольких лет работы в яндексе, думаю, тебе в большинстве случаев не составит труда перекатиться на хорошие деньги в другие конторы.

>труда перекатиться на хорошие деньги в другие конторы.

с опытом быгдота т.е. впаривания контекстной рекламы то до, прям всем нужны

Читаешь https://followthedata.wordpress.com/2012/06/02/practical-advice-for-machine-learning-bias-variance/

Видишь, что у тебя high variance - то есть модель твоя переобучается, не генерализуя достаточно. Поэтому усложнять модель (ставить еще больше слоев) не надо, тогда она будет переобучаться еще сильнее.

Больше данных - ок. Больше пикселей - не совсем ок, так как ты, с одной стороны, увеличишь число данных, но при этом увеличишь и размер твоей модели.

Далее, можно добавить регуляризацию, например, batch normalization или дропаут. Это тоже поможет от переобучения. Начни с этого.

В конце концов скорее всего high variance превратится в high bias, тогда можно будет и усложнить модель, и так ебашить циклично, пока не добьешься нужных цифр.

Долго ли нога будет входить в твою задницу?

Если бинарные изображения 100 на 100 пикселей и датасет из тысячи картинок, то не долго.

Зависит от сети. Если преобразовать сеть в целочисленную, то можно будет добиться скоростей намного быстрее рилтайма.

https://culurciello.github.io/assets/nets/acc_vs_net_vs_ops.svg

Кто-нибудь может пояснить за правую картинку? Что за иероглифы идут посел петуха?

Вкратце - Тета (H) - это гипотеза, Х - obseravation (данные). Теорема Байеса задаёт зависимость между вероятностью H|X (вероятность гипотезы при наблюдаемых данных Х, постериорная) и вероятностями H(априорная), X|H и H. Фреквинитсткий подход - думать в терминах X|H (как часто мы наблюдаем такие-то данные, если гипотеза верна). Не думать о данных - подход макаки (просто есть слепая вера в гипотезу). Не думать о гипотезе, а только о наблюдаемых данных - подход недалёкого позитивиста.

Очень сумбурно написал - если что-то непонятно попробую дополнить.

А вот что значит последний иероглиф я не знаю - поясните кто-нибудь.

И еще один вопрос после того, как я применил алгоритм обратного распространения ошибки к свертке я получил матрицу 64х64 как теперь этим обновить веса свертки, размер которых 6х3х3?

Последний иероглиф про вореции.

В случаях, когда стат.модель достаточно сложна, апостериорное распределение можно приближать вариационным методами: mean field, expectation propagation, stochastic variational bayes там всякие.

Вопрос собеседуещего петуха, а что под схожестью изображений понимаеться? Если основные цвета то возможно. Какая нейронка используеться, как кормим, но основе чего получаем веса?

Не туда написал. Извините.

Предложи лучше.

Потому что программисты петухи - зашквары

Да да

Поясните за дата аналитику. Я полный нуб в этой области. Позязя, братцы.

Где работают?

Что делают?

Что конкретно надо знать чтобы быть аналитиком: какая математика, какие инструменты?

Я пользовался DataRobot. мне вообще ничего не пришлось делать, я загрузил CSV и он мне все показал, какте алгоритмы лучше кореллириуют, какие хуже и какие данные значимы как фичерсы.

плюс потом дал мне точку с апи, и я слал туда новые данные, а он на основе классификатора высылал прогноз. Мартышкин труд.

Хотел отправить сосать хуи, но таги годнота, пока оставайся тут

За что ты называешь меня быдлом, быдло? Я даже не знаю норма это или нет.

так чо он же платный же поход

Да я кучу всего нагуглил, но узнавать из первых рук все равно надо, у того кто с этим работает. Я неб, но не дерево.

Намек понятен

Ты хочешь котиков распознавать научиться? Есть ImageNet, MNIST, https://en.wikipedia.org/wiki/List_of_datasets_for_machine_learning_research вот еще список

Neural Networks, Types, and Functional Programming

Что можете сказать?

Вот, кстати да, если есть такие крутые нейросети, то почему всё-еще есть проблемы с распознаванием текста, а старые книги еще не сделаны, например, в нормальные pdf с текстом, который можно выделять и копировать?

Ну я еще в прошлом году тут писал, что нейроночки это зависимый тип, в этом году писал, как алгоритмы на основе теории чтатистического обучения Вапника свести к типизированной лямбде и получать автосатически генетмческим программированием. Вот не только мне очевидно, что млтт это будущее не одной математики, но и машинного обучения. Ждем, когда до этой мысли дорастут ведущие специалисты в области мл.

Есть, у гугл букс можно искать кучу книг по фразе, но копирайт, библиотеки и тд не дают выкладывать полностью в открытый доступ, кроме того, сканировать книги довольно трудоемко, ну, и если выложить в открытый доступ, не будет профита

https://www.youtube.com/watch?v=mbyG85GZ0PI&list=PLD63A284B7615313A

на последних слоях свертки они вообще уже становятся одного сплошного цвета.

Если бы только проектировал, то, наверное, таких проблем не было.

И зачем ты так делаешь? В современным библиотеках строиться граф, бегают тензоры по графу, оптимизаций куча...

В смысле, без ВО и ИИ вкатиться и работать реально?

Ну, мне кажется, что если оно все за меня делать будет, то я ничему не научусь.

Обычно есть разделение на исследователей и простых макак. Исследователям желательно что-то типа PhD.

Если хочешь стать исследователем - то да.

>>987289

Да-да, а ещё кассиры в маке больше исследователя получают. Тебе с дивана виднее.

>Если хочешь стать исследователем - то да.

В это дело я бы с радостью. Правда возраст уже не позволяет образование получать (24 года)

но ведь спрос на макак больше

сейчас даже ссаные турагентства, которые должны умереть как мамонты, пытаются в БИГДАТУ, МАШИНЛЕНИНГ И КЛАСТЕРНЫЙ АНАЛИЗ

для их уровня хватит видосиков на ютубе и решения задачки про титаник

https://www.ft.com/content/f809870c-26a1-11e7-8691-d5f7e0cd0a16

После финансового кризиса 2008 года их бизнес-модель оказалась под давлением, так как компании сократили расходы на юридические услуги, а технология воспроизвела повторяющиеся задачи, с которыми юристы более низкого уровня в начале своей карьеры работали в прошлом.

Раньше BLP собирал небольшую группу младших юристов и помощников юристов в кратчайшие сроки, а затем отправлял их в комнату для извлечения этих данных вручную из сотен страниц - процесс, который мог занять недели. Система Ravn проверяет и извлекает ту же информацию за считанные минуты.

Пока, говорят фирмы, технология не означает потери рабочих мест. Но профессор Сусскинд считает, что впереди волна увольнений - юридические фирмы все еще экспериментируют с ИИ вместо того, чтобы разворачивать их через свои офисы.

TRANSLATED BY НЕЙРОНОЧКА

Какая нах нейроночка, если автоматизация в этой области полностью решается экспертной системой? То же самое и в области постановки мед диагнозов (этим вроде Ватсон сейчас занимается, а там коре - экспертная система). Но вообще всё это хуйня, поскольку юристику невозможно формализовать, там больше психологии. Разве что мелкую хуйню, типа административки с минимальной предысторией.

Смотря что ты подразумеваешь под "заниматься машинным обучением". Есть немало дата аналитиков, которые, грубо говоря, просто юзают алгоритмы как чёрные коробки.

>987264

>Смотря что ты подразумеваешь под "заниматься машинным обучением"

Как раз и заниматься разработкой этих самых "черных коробок", теорией алгоритмов, статистикой, теорией информации и обучением интеллектуальны систем.

Я в общем понимаю, что это больше в "исследователи", а это значит, что нужно "ВО". Но надеялся всё же на лазейку. Мол, можно ли без ВО каким-либо образом этим заниматься, ибо в 24 года поступать в универ такая себе идея

>юристику невозможно формализовать

Внезапно, нейронки решают то, что нельзя формализовать.

Скорее бы юристов пидорнули, не люблю этих ЧСВ-шных говнокодомакак уровня 1С.

Ну почему же, там сейчас у сбера конкурс есть по оценке недвижимости, можно на CPU считать.

Да и по другим конкурсам я не очень понимаю, зачем там титаны, если конечно ты не обучаешь десять ансамблей по тридцать моделей в каждом, как некоторые отбитые товарищи.

Так при чём тут титаны. Дата саенс это же не про "давайте навернём десять тыщ слоёв", а про грамотный анализ данных, отбор фич, генерирование макрофич, очистку датасета и т.д. Для всего этого титаны не нужны.

>>987408

Ну я сам не лез еще, но краем уха на хабрах всяких неоднократно слышал что одна из проблем использования кегли для саморазвития - что там в топах и кернелах часто висят парни, которые просто стакают сетки в ансамбли, а не придумывают что-то новое или поясняют за анализ.

Если тебе для саморазвития - какая разница, кто там в топе? Просто решай задачи, получай бесценный опыт.

>парни, которые просто стакают сетки в ансамбли

Ну есть такое. А ты придумай новое.

>поясняют за анализ

Победители обычно расписывают свое решение, но там редко что-то ценное. Чаще всего ансамбли и дрочево

>Если тебе для саморазвития - какая разница, кто там в топе

Ну так интересней гораздо, когда на что-то претендуешь

Плюс:

>Победители обычно расписывают свое решение, но там редко что-то ценное. Чаще всего ансамбли и дрочево

Ну в том и суть, что, выходит, найти интересные решения сложно среди тонны решений в стиле "Я запускаю керас и собираю ансамбль из 500 тыщ моделей..." как раз из-за титанщиков в в топе.

Но я понял суть, попробую-таки кагл, спасибо за ответы

А на чем делать ИИ? Нейросети же обладают гладкостью.

>юристику невозможно формализовать,

Юристика - это формализация курильщика, конкретный пример, когда формализацию делают гуманитарии. Как итог - закон что дышло, кто больше занес / имеет больше связей, тому и вышло. И без видимых противоречий, все по закону. Потому что начни там копать формально, пиздец сколько хуйни повылезет, противоречие на противоречии противоречием погоняет. Еще Лейбниц понимал необходимость формализовать эту область, сейчас это даже возможно технически (я про пруверы), только всем похуй - законы крутятся, баблишко мутится.

Пока довены-ботанидзе в этом итт треди пердят и превозмогают во имя светлого машинного будущего, нормальные пацаны используют ML по назначению.

https://medium.com/the-mission/rocket-ai-2016s-most-notorious-ai-launch-and-the-problem-with-ai-hype-d7908013f8c9

P.S. Лол, приямо можно провести аналогию с гоммунизмом и тому подобным разводиловом для лохов под видом реформаторства.

Делил, слишком однородные данные, распознается почти все.

То есть, наверняка, там используются topic modelling и sentiment analysis, но это явно не вся история. Чего еще не хватает?

Ну еще сверточные сети, как обычно. Еще в прошлом году тута постили ссылку на пейпер, в котором это описано. Мне вот интересно, ЦП оно генерировать может из текста?

спасибо. Было бы совсем круто, если кто-нибудь поделится ссылочкой на пейпер)

Рассказы брать на стульчик.нет?

Портить исходные. При чем в теории портить можешь с помощью GAN сетки, подавая дискриминатору на вход порченные данные или же фото с камеры, а генератору на вход имейджнет, а на выходе собственно чтобы он портил.

Нет, мне не нужно избавляться от отрицательных значений, мне нужно нормализировать градиент к значениям от -1 до 1.

Так "исследователи", этим всем занимающиеся, и сидят в основном в вузиках, а работают всякие хадуп-макаки, у которых вместо теорий - ноухау.

Если ты всю математику знаешь без диплома и вообще умен, можешь и поступить, и сразу пойти искать лабораторию, в которой тебе дадут разрабатывать коробки. Тем, кто делом занимается, диплом не нужен, главное чтоб работа выполнялась, а то грант отберут.

Если не знаешь, то какое тебе исследование? Выйдет только новое поколение кадров для РАЕН.

С помощью функции f(x) = atan(Cx)/(pi/2) ты можешь смапить -inf...inf в -1..1, оставив маленькие значения более-менее такими же, а большие сильно уменьшив, управляя силой сжатия параметром C. А дальше нормируешь вектор как обычно к новой длине.

длина_вектора=sqrt(sum(градиент.^2));

новая_длина_вектора = f(длина_вектора)

новый_градиент = градиент новая_длина_вектора/длина_вектора

Вместо atan можно взять tanh или sigmoid. Если возмешь C=1, то маленькие значения меняться не будут, так как касательная у арктангенса в нуле имеет угол 45 градусов.

Спасибо, но я что-то не понял. Зачем нужна эта

>А дальше нормируешь вектор как обычно к новой длине.

>длина_вектора=sqrt(sum(градиент.^2));

>новая_длина_вектора = f(длина_вектора)

>новый_градиент = градиент новая_длина_вектора/длина_вектора

часть? Я посчитал тут, и особой разницы не заметил.

Твой реквест был сократить длину больших векторов до 1, при этом маленькие не трогать. Для этого нужно использовать функцию типа atan, которая примерно это и сделает.

Я понял зачем нужна функция atan. Зачем нормировать вектор? Может я что-то не понял?

Во-первых посмотри на тот пост со звездочками в нужных местах https://pastebin.com/JPynJ8cM

Если тебе это ясно, то градиент - это вектор. Ты хочешь изменить его длину. Чтобы из вектора длиной l1 сделать вектор длиной l2 и сохранить его направление, нужно сделать v_new=v_old*l2/l1, простейший линал или даже аналитическая геометрия.

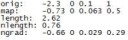

Тут >>989853

orig - начальные данные

map - данные после использования atan

length - длина оригинального вектора

nlength - длина вектора после использования atan

ngrad - данные после нормирования вектора

Я имел ввиду, что не заметил особой разницы между ngrad и map. Почему нельзя остановиться на map?

Двачую, теоретические знания без практической части - полный ноль.

на c# прост пилю, вроде норм, но выкладывать в публично чот стыдно

О, привет, братишка. Я вообще для себя пишу чисто. Думаю тоже начать куда-то выкладывать может заметят и куда-то на работу примут нет.

C#-кун

Сверточную нейронную сеть. Использую аккорд для ускорения через линейную алгебру. Вроде бы работает)

Да и он работает кое-как. Планирую перейти на пистон или что-то другое с норм либами после этого проекта. Аж грустно.

Сам когда-то сталкивался с подобным вопросом, но тут тебе не ответят, потому что сидят те кто использует готовые скриптовые решения на питонах и т.д. или вообще только с вопросом как вкатиться и пропадают. Посмотри как соединены и вычисли производную, вот и все.

>использует готовые скриптовые решения на питонах

А нахуя поступать как-то иначе? Вы ебнутые из разряда тех, кто в 90-е на ассемблере писал.

Посмотрите на это быдлецо, быдцело делает import tensorflow as tf и по примерам со стековерфлоу рисует графики в своих поделках или на датаслесарской работке. Быдлецо не знает алгоритмов и математики, которая стоит за тем что он использует, поэтому вынуждено подбирать инструменты спрашивая тех, кто в 90-е на ассемблере писал, или простым перебором. Если в интернете нет гайда как на питоне что-то сделать, быдлецо прибежит сюда беспомощно спрашивать в какой библиотеке можно найти нужную ему функцию.

"Небыдлецо" закукарекало вместо авроры. Ты сам читаешь, что постишь? Как тебе самописные говнонейроночки помогут узнать, в какой либе что реализовано? Совсем уже одурели школоилитарии, возомнившие себя гуру машинлернинга по той причине, что осилили набыдлокодить игрушечный вариант ленета из 80х годов последнего века прошлого тысячелетия. Сам ты все равно эту быдлонейроночку не улучшишь даже, не говоря о своем алгоритме. Так к чему все эти пальцы веером и сопли пузырем? Ты такой же слесарь, который не смог нагуглить как пропагейшн реализован между слоями, т.к. в интернете нет гайда (или что скорее всего, есть, причем не удивлюсь, если все детально описано в оригинальной работе самого Лекуна но ты не смог найти по причине общей одаренности).

>Быдлецо не знает алгоритмов и математики

И с хуя ты так решил? Я знаю алгоритмы и математику намного лучше тебя, потому что я учил алгоритмы и математику, а не низкоуровневый дроч. Я понимаю, если бы ты решил вручную запилить tf.nn.conv2d, чтобы понять архитектуру tf и как пилить кастомные слои (чего я не умею и мое почтение), но ты ведь реально делаешь самописную говнонейронку на C#, которая пригодится тебе примерно так же, как взятие производных на первом курсе универа помогло тебе впоследствии заниматься программированием.

Написав свою нейронку, он потом и кастомные слои сможет, и кастомные сольверы, и все остальное гипотетически. А ты предлагаешь ему погружаться в очередной говнофреймворк, который еще десять раз перепилят. Кто-то дрочит теорию, кто-то практику, каждому свое

У меня кстати на работе есть датасаентист топовый, который раньше несколько лет слесарем работал. Он и сейчас для души иногда слесарит.

Уроки иди делай.

Посоветуйте книжку по матану хорошую.

ОБЧИТАЛСЯ НЕЙРОТРЕДЖА НА ДВАЧЕ И РЕШИЛ УГОРЕТЬ ПО ML

@

НАПИСАЛ ПРОСТЕНЬКУЮ НЕЙРОНКУ, ПРОДАЮЩУЮ %ПРОДУКТ_НЕЙМ% ТВОЕЙ КОМПАНИИ КЛИЕНТОЛОХАМ

@

ОБ ЭТОМ УСЛЫШАЛО РУКОВОДСТВО, ЗАИНТЕРЕСОВАЛОСЬ

@

ПООЩРИЛИ РАЗРАБОТКУ ПИЗДЮЛЯМИ И ДОБРЫМ СЛОВОМ

@

ЕБОШИШЬ ВТОРУЮ ВЕРСИЮ, ОТ РЕАЛЬНОГО ПРОДАЖНИКА ПОЧТИ НЕ ОТЛИЧИТЬ

@

ЗАКУПАЮТ НЕСКОЛЬКО СЕРВЕРОВ, СТАВЯТ НА НИХ ТВОИ НЕЙРОНКИ И ВЫПИЗДЫВАЮТ НАХУЙ ВСЕХ ПРОДАЖНИКОВ

@

СПЛОШНЫЕ ПРОФИТЫ

@

РУКОВОДСТВО НАЧИНАЕТ НЕДОБРО ПОГЛЯДЫВАТЬ НА ТЕБЯ

@

ВСЁ ЧАЩЕ СЛЫШИШЬ "А ЗАЧЕМ НАМ СИСАДМИН/РАЗРАБОТЧИК, ЕСЛИ И ТАК ВСЁ УЖЕ РАЗРАБОТАЛ НАМ, ДА И НАПИСАТЬ СЕБЕ ЗАМЕНУ СМОЖЕТ?"

@

ДАВЯТ И ПРИКАЗЫВАЮТ НАПИСАТЬ НЕЙРО-СИСАДМИНА, КОТОРЫЙ ЕЩЁ МОЖЕТ В НАПИСАНИЕ НЕЙРОННЫХ СЕТЕЙ, ИНАЧЕ УВОЛЯТ ПО СТАТЬЕ

@

ПИШЕШЬ

@

УВОЛЬНЯЮТ ПО СОБСТВЕННОМУ

@

@

@

@

СПУСТЯ ПАРУ МЕСЯЦЕВ НЕЙРОТЫ ПИШЕТ НЕЙРУКОВОДСТВО

@

МЯСНОЕ РУКОВОДСТВО УВОЛЕНО

@

СПРАВЕДЛИВОСТЬ ТОРЖЕСТВУЕТ

@

А В ТВОИХ ТРУСАХ И МАТРАСЕ ХЛЮПАЕТ ПОДЛИВА%%

@

ДОБRО ПОЖАЛОВАТЬ, СНОВА

ОБЧИТАЛСЯ НЕЙРОТРЕДЖА НА ДВАЧЕ И РЕШИЛ УГОРЕТЬ ПО ML

@

НАПИСАЛ ПРОСТЕНЬКУЮ НЕЙРОНКУ, ПРОДАЮЩУЮ %ПРОДУКТ_НЕЙМ% ТВОЕЙ КОМПАНИИ КЛИЕНТОЛОХАМ

@

ОБ ЭТОМ УСЛЫШАЛО РУКОВОДСТВО, ЗАИНТЕРЕСОВАЛОСЬ

@

ПООЩРИЛИ РАЗРАБОТКУ ПИЗДЮЛЯМИ И ДОБРЫМ СЛОВОМ

@

ЕБОШИШЬ ВТОРУЮ ВЕРСИЮ, ОТ РЕАЛЬНОГО ПРОДАЖНИКА ПОЧТИ НЕ ОТЛИЧИТЬ

@

ЗАКУПАЮТ НЕСКОЛЬКО СЕРВЕРОВ, СТАВЯТ НА НИХ ТВОИ НЕЙРОНКИ И ВЫПИЗДЫВАЮТ НАХУЙ ВСЕХ ПРОДАЖНИКОВ

@

СПЛОШНЫЕ ПРОФИТЫ

@

РУКОВОДСТВО НАЧИНАЕТ НЕДОБРО ПОГЛЯДЫВАТЬ НА ТЕБЯ

@

ВСЁ ЧАЩЕ СЛЫШИШЬ "А ЗАЧЕМ НАМ СИСАДМИН/РАЗРАБОТЧИК, ЕСЛИ И ТАК ВСЁ УЖЕ РАЗРАБОТАЛ НАМ, ДА И НАПИСАТЬ СЕБЕ ЗАМЕНУ СМОЖЕТ?"

@

ДАВЯТ И ПРИКАЗЫВАЮТ НАПИСАТЬ НЕЙРО-СИСАДМИНА, КОТОРЫЙ ЕЩЁ МОЖЕТ В НАПИСАНИЕ НЕЙРОННЫХ СЕТЕЙ, ИНАЧЕ УВОЛЯТ ПО СТАТЬЕ

@

ПИШЕШЬ

@

УВОЛЬНЯЮТ ПО СОБСТВЕННОМУ

@

@

@

@

СПУСТЯ ПАРУ МЕСЯЦЕВ НЕЙРОТЫ ПИШЕТ НЕЙРУКОВОДСТВО

@

МЯСНОЕ РУКОВОДСТВО УВОЛЕНО

@

СПРАВЕДЛИВОСТЬ ТОРЖЕСТВУЕТ

@

А В ТВОИХ ТРУСАХ И МАТРАСЕ ХЛЮПАЕТ ПОДЛИВА%%

@

ДОБRО ПОЖАЛОВАТЬ, СНОВА

Ну вот ты и говоришь как типичная низкоуровневая блядь из начала нулевых. Сейчас мало кто из любителей компьютерной графики способен написать алгоритм Брезенхема на асме, а тогда сказать о том, что это нахуй не нужно, потому что у тебя есть OpenGL - это наткнуться на такую реакцию, что как так можно, если ты не знаешь, как выводить линию, то как ты будешь разбираться с выводом тысяч треугольников и шейдингом... А вот так, лол, что жизнь усложняется и практическая имплементация основ нахуй не нужна. Возможно, мне нужно знать, как устроен топор, чтобы построить дом, но мне точно не нужно делать топор вручную, чтобы доказать, что я мог построить дом. Чтобы знать, как устроен топор, достаточно почитать абзац текста. Чтобы знать, что такое chain rule и как берется производная свертки - тоже. Нахуя тут что-то имплементировать - не понятно. Особенно утверждая при этом, что те, кто этого не сделал, ну нихуяшеньки не понимают в математике.

Примерно та же хуйня была с вебом. Современные фреймворки далеки от кода, написанного в ручную, как диды завещали, примерно так же, как современные MVC-фреймворки далеки от CGI-софта, написанного на С++ в 2000 году. Этот софт был ужасен, разработка была дико медленной и хуевой, пока сообщество с болью не вывело более-менее успешную формулу - на С написана только БД, все остальное на динамическом языке. Дальше та же самая хуйня повторилась на новом уровне - дидами тут уже были те, кто писал без помощи rails-подобных фреймворков и CMS. Сейчас в здравом уме уже никто не будет писать CGI-софт или разрабатывать игру на ассемблере, ровно по одной причине - диды стали прадедами, и мы стали дидами.

С графическими интерфейсами было то же самое. Высшим шиком было написать на голом WinAPI софтину, или же на MFC. А выиграл в итоге кто? Кто уже тогда начал писать на Qt и спокойно портирует свои наработки без привязки к wine.

Короче, из года в год повторяется одно и тоже.

1. Диды пишут как могут. Хуево, неэффективно, убивая кучу времени на отладку одних и тех же багов.

2. В конце концов рождается инструмент, ускоряющий разработку. В данном случае CAS-фреймворки. Качественно новая схема.

3. И дальше общество делится на два типа людей. У одни - "ну, диды же так писали, надо как они, по-другому научиться ничему нельзя", а перед пилением своего изучают best practices в отрасли, и только потом пилят что-то свое. И первый тип сосет примерно как соснул вот этот хуй https://habrahabr.ru/post/327596/

Вот и все. Ты из подобного дроча получишь ноль знаний, которые тебе бы пригодились в будущем. Первым делом надо выкинуть нахуй C#, это ебаное делфи современности, затем взять http://cs231n.github.io/assignments2017/assignment2/ , прорешать, и забыть о производной свертки как о страшном сне. Это при условии, если не уверен, что понимаешь, как она берется. Если понимаешь, то и этого делать не обязательно, лучше внимательно почитать материалы этого самого cs231n и не ебать мозг далее, в мире куча статей нечитаных.

Ну вот ты и говоришь как типичная низкоуровневая блядь из начала нулевых. Сейчас мало кто из любителей компьютерной графики способен написать алгоритм Брезенхема на асме, а тогда сказать о том, что это нахуй не нужно, потому что у тебя есть OpenGL - это наткнуться на такую реакцию, что как так можно, если ты не знаешь, как выводить линию, то как ты будешь разбираться с выводом тысяч треугольников и шейдингом... А вот так, лол, что жизнь усложняется и практическая имплементация основ нахуй не нужна. Возможно, мне нужно знать, как устроен топор, чтобы построить дом, но мне точно не нужно делать топор вручную, чтобы доказать, что я мог построить дом. Чтобы знать, как устроен топор, достаточно почитать абзац текста. Чтобы знать, что такое chain rule и как берется производная свертки - тоже. Нахуя тут что-то имплементировать - не понятно. Особенно утверждая при этом, что те, кто этого не сделал, ну нихуяшеньки не понимают в математике.

Примерно та же хуйня была с вебом. Современные фреймворки далеки от кода, написанного в ручную, как диды завещали, примерно так же, как современные MVC-фреймворки далеки от CGI-софта, написанного на С++ в 2000 году. Этот софт был ужасен, разработка была дико медленной и хуевой, пока сообщество с болью не вывело более-менее успешную формулу - на С написана только БД, все остальное на динамическом языке. Дальше та же самая хуйня повторилась на новом уровне - дидами тут уже были те, кто писал без помощи rails-подобных фреймворков и CMS. Сейчас в здравом уме уже никто не будет писать CGI-софт или разрабатывать игру на ассемблере, ровно по одной причине - диды стали прадедами, и мы стали дидами.

С графическими интерфейсами было то же самое. Высшим шиком было написать на голом WinAPI софтину, или же на MFC. А выиграл в итоге кто? Кто уже тогда начал писать на Qt и спокойно портирует свои наработки без привязки к wine.

Короче, из года в год повторяется одно и тоже.

1. Диды пишут как могут. Хуево, неэффективно, убивая кучу времени на отладку одних и тех же багов.

2. В конце концов рождается инструмент, ускоряющий разработку. В данном случае CAS-фреймворки. Качественно новая схема.

3. И дальше общество делится на два типа людей. У одни - "ну, диды же так писали, надо как они, по-другому научиться ничему нельзя", а перед пилением своего изучают best practices в отрасли, и только потом пилят что-то свое. И первый тип сосет примерно как соснул вот этот хуй https://habrahabr.ru/post/327596/

Вот и все. Ты из подобного дроча получишь ноль знаний, которые тебе бы пригодились в будущем. Первым делом надо выкинуть нахуй C#, это ебаное делфи современности, затем взять http://cs231n.github.io/assignments2017/assignment2/ , прорешать, и забыть о производной свертки как о страшном сне. Это при условии, если не уверен, что понимаешь, как она берется. Если понимаешь, то и этого делать не обязательно, лучше внимательно почитать материалы этого самого cs231n и не ебать мозг далее, в мире куча статей нечитаных.

>И первый тип сосет примерно как соснул вот этот хуй

Он не совсем соснул.

Во-первых разработка началась под актуальный конфиг компа 99 года, а закончилась, когда таких компов уже не осталось, отсюда большинство хитрых изъебств с графеном стали не нужны, но если бы игру запилили быстрее они пришлись очень кстати.

Во-вторых его игру можно найти на торрентах и она вполне себе играбельна не хуже близовского старика. Для бородатого индюка из двухтысячных это сорт оф вин.

> я луцше знаю мотимотику!

> нит я!

долбоёбы

http://lstm.seas.harvard.edu/latex/

https://github.com/harvardnlp/im2markup

то же в виде порта для слесарьфлоу https://github.com/ssampang/im2latex

пейпер https://arxiv.org/pdf/1609.04938v1.pdf

датасет https://zenodo.org/record/56198#.V2p0KTXT6eA

полтора онлайн-ресурса посмеяться:

http://detexify.kirelabs.org/classify.html

http://shapecatcher.com/

этот, правда, впечатляет - https://webdemo.myscript.com/views/math.html

Пик стронгли релейтед.

А ты говоришь, как типичная вебмакака. Кроме скорости разработки есть еще много важных критериев, и по ним твои фреймворки сосут. Например, гибкость разработки и эффективность софта. Для клепания гостевух и вебшопов твой говнофреймворк еще годится, а чуть что сложнее или highload - и сразу начинается пердолинг с С++, архитектура микросервисов, fastcgi, вот это все. А когда я качаю какой-нибудь калькулятор на Qt, то охуеваю сначала от размера дистрибутива в 100Мб, а потом от уебищного интерфейса а-ля "Gnome в нулевых". Все потому, что затраты на поддержку кросплатформенности разработчик перенес на конечного пользователя. Ему же ничего не стоит еще восемь гигов памяти прикупить и новый винт.

Но это отдельная большая тема, по которой очень много чего можно сказать, давай не будем разводить тут срач. Пусть каждый сам решает, пилить свое или использовать чужой код, новые Кармаки и Торвальдсы тоже нужны.

Обоссал студентика.

Тонко.

>Например, гибкость разработки и эффективность софта.

Но ведь в машобе гибкость разработки - это возможность в пару кликов запилить новую модель для тестов, а эффективность напрямую завязана на скорости матана, который в готовых фреймворках прокинут на всякие бласы, эйгены и ффтв, работающие на магии, ассемблере и изредка на С, скомпилированном под задачу в рантайме.

>возможность в пару кликов запилить новую модель для тестов

Это если дальше тьюториалов не отходить. Но однажды ты столкнешься с тем, что просто "запилить модель" для успеха недостаточно. Нужно делать что-то еще.

Например, если я захочу гиперпараметры динамически во времени менять или даже датасеты? А если мне понадобится кастомный слой?

Машоб еще очень сырой, и библиотеки для него тоже, их сочиняют на ходу.

Честно - хз. Я считал точно так же как для полносвязной, толь с учетом того что, теперь связей у меня меньше. Получается, что дельта ошибки суммируется для последующего вычисления дельты веса. Прежде чем пробовать сверточную, желательно пробовать полносвязную.

>полносвязную

У полносвязной все легко получается из-за того, что там одна связь - один вес и легко все программится. Со сверточной надо смотреть не проебаться с индексами и краевыми эффектами, потом еще оптимизировать желательно код, т.к. не всегда с первого раза напишешь самую быструю версию.

или еще что-то там изучить над, кофе разные ?

Кофе умеет под андр собираться?

Да. Меня из двух университетов числанули, сижу на шее у мамки и подбираюсь к кагглу.

Какое представление цветных изображений больше подходит для сверточной сети? Например, есть jpeg в RGB, его можно привести к трехмерному массиву со значениями от 0 до 255 (или от 0.0 до 1.0 (или от -1.0 до 1.0)). Какой вариант лучше?

И еще: для цветных изображений больше годится двумерная или трехмерная свертка? Насколько я понял, в первом случае к R,G и B каналам фильтры применяются по отдельности, а во втором сразу ко всем (т.е. фильтр тоже имеет 3 канала).

21. Летом опять поступать буду.

А где там конкретно? Это https://github.com/openai/gym/blob/master/gym/envs/registration.py ?

хватит с глазами, если чего-то нет, то пишешь кастомный слой, функцию или еще что-то, так же тебе хватит любой другой либы

Скопирую из старого треда, ибо я даун

Анон. Тупой вопрос. Как заставить нейронку рисовать? Тупой ньюфаг в этой сфере, да. Запилил лишь самую базовую (банальный массив х на у с пересчетом нейронов и обучением).

Как нейронке потенциально скармливать что-то и как получать на выхоод что-то? Что юзать и что прикручивать? Куда копать?

Меня интересует именно аутпут изображений. В духе тех, что ща в гугл плеях наводнили тоннами. Понимаю, что это через сверточную нейронку делается, но вот детали - полный туман просто.

если прям рисоваь, то нужно копать в сторону attention models

В первом случае у тебя распределение 0--1, во втором - -3--3. В чем разница? Наверное зависит от того, какие у тебя нелинейности и как ты их инициализируешь. А еще, скорее всего, у тебя адский оверфит.

safebooru.org

Скачай imagenet в виде картинок с торрентов.

"Попал или промазал".

пинтерест

Конечная задача: распознование изображений

Текущая ситуация: джава макака, скачал Бишопа, так как начитался хвалебных отзывов. Но понял, что это пока не ля моего уровня. Хотелось бы что то поближе к программированию, но не слепое использование модных библиотек.

зависит от того, насколько сильно будешь задрачивать и насколько слабая у тебя база. Есть вероятность устроиться менеджером в области машиночек, айти и тд. Сейчас у каждого второго студента техвуза нейронки в дипломе.

lstm нейронки

Сжимают шикарно, аутоэнкодеры могут целый фильм сохранить как веса, но и потери большие. Это совсем не вариант.

>>996726

Можно из чистого хулиганства, но лютый костыль же. Регрессия, классификация, кластеризация - вот хорошие области для нейросеточек.

Это потому что ты свой стартап гуглу не продал.

И да, >И, в отличии от TF, он уже находится в стабильной фазе.

TensorFlow разве не стабильный уже?

https://books.google.ru/books?id=V3r_AgAAQBAJ&pg=PA69&lpg=PA69&dq=полумодулярная+решетка&source=bl&ots=Uv8jWu1O4f&sig=-0r_vBnhKFGFzKYv_OIh_bcFpPg&hl=ru&sa=X&ved=0ahUKEwjgpprtqZDUAhUEG5oKHerMBd0Q6AEILDAD#v=onepage&q=полумодулярная решетка&f=false

Он утверждает что N5 полумодулярная но

c^b<.b

c#b.>a.>c

пункт 7 в сылке

По сути это тоже ведь можно решить с помощью регрессии.

Но каким образом нейроночка начинает подбирать значения?

http://fpi.gov.ru/activities/konkurs/robot

У студентиков есть еще 3 дня чтобы кинуть заявку.

Участвовал в прошлой хуйне http://fpi.gov.ru/activities/konkurs/spacemap,

было довольно годно. Уникальный ни с чем не сравнимый экспириенс по обучению годной нейроночки на пиздецовом просто говнище вместо данных - редко такое встретишь. Хочется побольше конкурентов.

ARIMA, если ряд 1. Регрессия ансамблями деревьев (только надо нагенерировать кучу признаков), если рядов много.

Нужны, я первое время жалел о проебанном матане, но там ничего выше 2-го курса шараги не встречалось.

Работу найти будет невозможно скорее всего, выбирай это как хобби или делай свой проект. Порог входа высокий.

Яйкс, спасибо что предупредил

кто тебя в серьёзное место возьмёт если ты лол даже в маге не знаешь про что диплом писать будешь!!!

В TUM спокойно можно поступать на англоязычное обучение, со знанием немецкого уровня спросить дорогу (кажись, цитата с оффсайта).

> Регрессия ансамблями деревьев (только надо нагенерировать кучу признаков), если рядов много.

Бустинг? Хгбуст например? А как генерировать признаки?

матан для питухов

Вопрос снят, все получилось.

Так а с перспективами в нём что? Можно будет легко вкатиться в индустрию, если есть профильное образование?

Что значит "легко вкатиться в индустрию"? Пишешь пейперы, проекты, потом можешь с однокурсниками загонять стартапы гуглу или подаваться на позицию датаентиста. Без образования в это вкатиться нереально, тебе не будут воспринимать как серьезного соискателя. Профильный диплом известного вуза ставит тебя на уровень со всеми, игра идет на публикации, гитхаб, каггл и опыт работы.

Спасибо! Первый адекватный ответ, который я встречал. А где можно почитать про этот путь подробнее? Статьи йоба-физика, криво и раком, но в итоге вкатившегося в сферу, уже читал, а вот описание своего пути человеком, который получил профильное образование, найти пока что не удалось.

Чет глупость, тягаться с гуру индустрии можно и без образования, а шанс выстрелить со своим проектом такой же.

Единственное, что дает учреждение и такое вот, подобное образование - это возможности.

Идти у университет за знаниями - глупость, ты должен заводить максимум знакомств и использовать возможности.

Так что с такой позиции вкатиться в индустрию проще.

Кстати, а сколько стоит обучение в таких вот местах?

Постоянные лабораторки, а потом ресерч как-то не способствуют ведению блога, но я не вижу причин не поискать "become a data scientist blog", первый в выдаче так и называется. В этом пути нет никаких секретов - ты учишь реально много математики, какие-то бесполезные вещи, если повезет с преподом то сдаешь пет проекты в качестве семестровых работ. Как сказал >>997522 , в универе ты получишь знакомства, научного руководителя, какое-то наследие и финансирование - получить стипендию довольно просто (если ты девушка, то еще целая куча фондов будут бегать за тобой чтобы дать денег на то чтобы ты двигала науку). Все практические навыки должен приобретать сам, за ручку тебя никто водить не будет, только проверять соответствует ли твой скилл минимальным требованиям.

Ещё раз спасибо тебе, добрый человек! Теперь более-менее понятно, куда двигаться. Надеюсь, из меня что-нибудь да получится, кроме уборщика в макдаке.

Почему у нас D через запятую стоит?

>p(y|x, D)

В книге написано In our notation, we make explicit that the probability is conditional on the test input x, as well as the training set D, by putting these terms on the right hand side of the conditioning bar |.

Типа условная вероятность на тестовом входе x такая же, как у всего тренировочного набора D и поэтому их переносят на правую часть.

А как тогда идёт деление, сначала на x, потом полученное на D?

Условная вероятность от тренировочного и тестового набора данных вместе.

p(y|x,d) = p(y,x,d)/p(x,d)

Понял, это же два разных набора данных.

Кстати, а что с этим вычислением мы делаем потом?

Полученное делим ещё раз на максимизированное значение x и d? И тогда уже получаем map?

И argmax - это, например, если у нас есть статистика температуры за все дни и мы берём наивысший показатель?

бишоп же на первой ссылке

Ну всё, пацандре, я вот сегодня закончил курс по машин лернингу у себя в универе. Это такой интродакшн был скорее: обо всём по чуть-чуть. Но я многое узнал и запомнил, теперь буду знать хоть, куда копать если чё.

Я вот теперь думаю, стоит ли пилить дипломку на магитра на какую-нибудь такую тему или не стоит? Слишком уж дохуя времени наверное уйдёт, да и ещё сама по себе тема сложная, я не знаю, как я с работой осилю. Да и тем более надо же придумать саму тему, где можно эту шнягу всю применить, да и то просто сравнением нескольких способов, решением какого-нибудь компетишена с каггла и небольшим анализом результатов отделаться на получиться, нужно что-то СУРЬЁЗНО будет делать наверное... Ужас короче, как меня эта дипломка изводит!

> Пишешь пейперы

ПРОСТО БЕЗ ЗАДНЕЙ МЫСЛИ БЕРЕШЬ И ПИШЕШЬ

Вообще хуйня это все, проебали мы хайп, можно дальше дрочить жаваскрипт.

Долго и затянуто. Лучше сразу глянуть https://yandexdataschool.ru/edu-process/courses/machine-learning, а курсеру для практики использовать.

Спасибо! И еще такой вопрос, есть ли смысл читать Elements of Statistical Learning, или после Бишопа там ничего полезного уже не будет?

В начале, кажется, рассказывалось про решение проблемы деления информации на test и training сеты

А все, нашел

Machine Learning: An Algorithmic Perspective, Second Edition

Кстати, местные эксперты, оцените ее годность.

Блин, как же тяжело читать эту книжку, только сейчас допер до этой Map estimate, боюсь, что до матана в последующих частях буду добираться годами.

Есть ли годные учебники по матану, что помогут разобраться с написанным там? Гугл далеко не всегда спасает.

А чего в scipy нейросеть считает так ровно? Она там сама анализирует классы по инпуту и округляет результат до них?

Написал простую нейросеть, которая решает задачи прогнозирования (массив на входе с ответами, на выходе ответ на частный случай).

Тексты? Изображения?

Давайте оживим тредж

>оцените ее годность.

Выше среднего. Для умеющих в пистон вообще около 10/10, т.к. не только теория, но и конкретный код, что при желании поможет вкатиться в тему не простым слесарем, а с более глубоким пониманием как что работает и как реализовать общие для всего МЛ моменты даже под алгоритмы, не описанные в книжке.

>массив на входе с ответами, на выходе ответ на частный случай

Я тебя не понимаю. Можешь подробней объяснить?

>Где можно арендовать/попросить мощности?

Вся же суть пистономартышек. Даже про облачные сервисы не слышали. Когда еще гугл для себя откроют...

Полагаю, ты про ETA: 3060s

>>1000084

Это моя почти лаба1 по нейронкам после семестра анализа данных и в задницу гугол.

Нет, я про альфу. Этот аргумент пикрил. И сколько у тебя слоев и сколько нейронов в каждом слое?

По иронии, это буква эта и в керасе я ее руками не задаю.

Два слоя, пулинг, дропаут, два слоя, пулинг, дропаут. Если результат меня устроит, срежу половину и попробую еще раз. Нейронов изначально задал 1024 (и вот тут меня ждало бы несколько дней с урчащей грелкой вобнимку), но поскольку времени мало, сократил до 128, скорость приемлемая, но волнуюсь за результат.

Вообще, было бы полезно почитать про более осмысленный подбор гиперпараметров и добавить какой-то препроцессинг, оба этих пункта оставили на мою совесть или деньги мажоров с титанами.

Господи, у вас в пистоне нельзя даже альфу задать? Это пиздец, господа. А насчет нейронов в полносвязных слоях, для скрытого слоя я использую такую формулу (размер_входа + размер_выхода)^(1/2). Размер входа это количество выходных параметров после всей свертки. Меня эта формула еще не подводила.

Можно все, только в других пакетах или на самописной поделке, в керасе подбирается сама, кажется.

Вообще, как раз надо поставить тренироваться один велосипед и сесть писать второй на нумпае - своя реализация нейроночки, forward\backward pass, обновление весов, активаторы, оптимизаторы, функции стоимости. Вот и разберусь как все устроено.

Правильно мыслишь.

Ах да, забыл про Dense - в первом случае 128-256, во втором 512-1024

Короче, какое из этих направлений в моем случае правильней и с чем лучше экспериментировать? Уменьшать вторую или увеличивать первую? Может, фильтры, которые стабильно 3х3 всегда, попробовать пощупать?

Олсо, в обоих случаях оверфит начинается обычно с 7-9 эпох

>Хайкин.

Аутизм.

>>1000056

Fundamentals of Neural Networks: Architectures, Algorithms, and Applications, Fausett L. И Рохас http://gen.lib.rus.ec/book/index.php?md5=82D428AEE58085A79AFC4E08F1A0628F

Не ну а чо а почему бы и нет. Там много людей, кошечек и собак в среднем качестве, с камеры мобилки, как раз как мне надо. Основные данные конечно с имажнета.

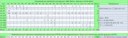

Еще один даун не прочитал про bias-variance tradeoff. На тестовых у тебя 75%, а на тренировочных? Если тоже 75%, значит усложняй модель (тут или 120х120 тебе мало или бери inception+resnet, архитектуры типа VGG - самые тормозные, смотри пикрелейтед, а судя по описанию у тебя именно VGG со стэком сверток и пулингов), если 99, увеличивай число данных - или вращениями-поворотами (сдвиги НЕ нужны, сверточные сети к ним устойчивы by design), а еще лучше намайнить больше. И так до победного.

Кстати, про "намайнить больше" не пишут в научной литературе и кагле, которые заточена на победу в фиксированном датасете. Но в реальном мире это как раз основной способ, потому что рабочий день человека, размечающего данные, стоит раз в 10 меньше рабочего дня емельщика.

на рентгене не могут найти черные пятна? хуета какаято

Дай ссылку

Блядь, ты че, не можешь определение загуглить?

Норма линейного пространства это отображение из V в R >=0 такое что ||av||=|a| ||v||, неравенство треугольника ||u+v||<=||u||+||v|| и что нулевую норму имеет только нулевой элемент. векторного пространства.

А это имеет значение? Я думал в таких вещах обычно псевдокод какой-то. Всяко умею калякать.

Продливаю вопрос этого анона.

Как там обучаться на 950, 1050ti? Или меньше 1060 даже не стоит пытаться?

Зависит от задач. Если googlenet тебе норм, то можно и на 750M обучать, как я делаю. Вот VGG уже в пытку превращается. Но мне проще поработать с датасетом на простенькой сетке типа alexnet, добиться максимума производительности, а дальше взять сеть покруче и или подождать пару дней, или взять AWS. И только сейчас я созрел до покупки чего-то покруче, но это не то, без чего нельзя жить.

Интегралом Коши.

Очень годная книга, написано все связно и очень понятно.

LSA, LDA, topicmodels например. Профильный обзор пакетов для R - https://cran.r-project.org/web/views/NaturalLanguageProcessing.html Тута любят кукарекать против R, специально для таких реквест - покажите-ка мне аналог вот такой штуки ftp://cran.r-project.org/pub/R/web/packages/LSAfun/LSAfun.pdf вна каком-нибудь пистоне, или что там сейчас модно у школьцов. Особенно обратите внимание на функцию MultipleChoice().

но мог бы и погуглить

Foundations of Statistical Natural Language Processing - Christopher D. Manning

Speech and Language Processing - Daniel Jurafsky and James H. Martin

есть большой пласт статей/книг по парсингу (синтаксису)

в этом курсе неплохой силлабас дан

http://cs287.fas.harvard.edu

То и идти туда тебе особо не надо.

>We think about the weights that connect into a particular neuron, and plot the strengths of the weights by using one axis for each weight that comes into the neuron, and plotting the position of the neuron as the location, using the value of w1 as the position on the 1st axis, the value of w2 on the 2nd axis, etc

Что такое particular neurons и strengths of the wrights

А то я пока лишь понял, что весы у нас принимаются за оси координат и ориентируясь на них мы можем разместить нейроны, это правильно?

Не слушай его.

Во-первых, у тебя будет научный руководитель. Правильное поступление, это когда ты поступаешь чтобы учиться-работать с конкретным человеком, с которым ты заранее познакомился в деловой (у меня было не очень деловой) переписке. Он пропихнет тебя в исследовательские группы и будет со всем помогать, потому вы связаны и ты тоже приносишь ему профит. Ну или если это старпер с перманентом, то будешь мыть полы в лаборатории и от него получишь только его имя на всех твоих пейперах, да пару внезапных встреч в году, во время которых он для профилактики тебя размажет.

Университет это первая и самая многообещающая ситуация, в которой ты оказываешься вместе с наиболее близкими тебе по интересам людьми, некоторым она так нравится, что они пробуют еще и еще с разными наборами человеков.

Представь себе сетку из нейрона и двух весов. Тогда все возможные состояния такой сетки могут быть описаны парой чисел или точкой на плоскости. А обучение сети -- движением точки на плоскости по направлению градиента двумерной функции потерь. А теперь обобщи на случай миллиона весов. Все то же самое, только пространство многомерное.

>обучение сети -- движением точки на плоскости по направлению градиента двумерной функции потерь.

Причем, для доказательства сходимости нейроночки достаточно показать, что дифференциал функции Ляпунова отрицателен в любой момент времени.

Когда уже запретять всё это leave as an exercise говно.

Ну хуй знает, я не представляю кто будет моим руководителем, слава богу мне еще больше года до этого.

> которой ты оказываешься вместе с наиболее близкими тебе по интересам людьми,

Как блять это поможет если никто с тобой не хочет общаться, Да никак.

Не правда, думаю единицы людей из треда и вообще машоба знают про функцию Ляпунова, а ты просто потраллить решил.

Как же вы заебали.

Этого нет в программе, только если йоба-вуз.

Какая разница? Такая сетка - это функция f(x,y), а вид этой функции может быть любым.

Kaggle, MNIST

>Каким образом нейроны из пространства весов размещаются в пространстве входов?

Ты походу представляешь себе какое-то космическое пространство, где что-то где-то размещается.

А есть просто нейроночка, которая является просто функцией вида выход1...выходN=f(вход1, ... входN, параметр1, ..., параметрN).

Чтобы подогнать вход к выходу мы должны зафиксировать вход и выход и сделать границентный спуск в пространстве параметр1...параметрN. Отсюда собственно это пространство и возникает. А если ты фиксируешь параметры, то возникает пространство входных данных. А если ничего не фиксируется - еще какое-то пространство. И т. п.

Поэтому все обучение машобу и начинают с линейной регрессии выход=вход*k+b. Всего 1 вход, 1 выход и 2 параметра. Поэтому легко представить аналогии в 2д или 3д пространстве. А если ты сразу начинаешь работать с глубокими сетями, где у сетки миллиарды параметров и сотни тысяч входов с выходами, понятно, что нихуя не понятно, что происходит.

Вот есть у меня классификатор. Он дает на тестовом датасете из 10 примеров 80% пресижона и 80% реколла.

А вот есть другой классификатор, он на миллионе примеров дает 80% пресижона и 80% реколла.

Можно ли как-нибудь обоснованно сравнить (а еще лучше - измерить количественно) их качество?

На уровне ощущений понятно, что тот, который измерен на тысяче примеров более правдоподобед, но не знаю как это доказать.

Память подсказывает что на втором курсе и лабах по физике что-то было связанное с коэффицентами стьюдента и хи квадратом, но я пока не уверен, туда ли я копаю.

Я про оценку точности классификации. Не может же оценка точности базироваться только на отношениями внутри конфьюжен матрикс, естественно, что чем больше выборка, тем более классификатор правдоподобен.

Да нет, конечно правдоподобность классификатора не зависит от того, как ты его тестируешь. Что изменится, так это доверительный интервал. Довольно бесполезная штука на самом деле, поэтому если интересно, поройся сам.

То есть если в первом случае у тебя вероятность false positive 80+-3sigma1 с вероятностью 99%. Во втором - 80+-3sigma2 с вероятностью 99%, и там и там будет 80, но отличаться будет этот +-, ведь чем меньше ты протестировал, тем меньше ты знаешь.

Смотри https://stackoverflow.com/questions/41068858/confidence-interval-margin-of-recall-or-precision

Формулу он предлагает следующую:

p +/- Z_score_at_alpha * std_error где

p = adjusted_recall=TP+2/(TP+FN+4)

std_error = sqrt(adjusted_recall(1-adjusted_recall)/(N+4))

TP - true positive, FN - false negative, N - число в выборке,

Z_score_at_alpha - какаую-то хуйня по типу коэффициента Стьюдента

Но это довольно бесполезная вещь, мы не ракеты производим, чтобы делать выводы по 10 образцам, сравнивать классификаторы нужно на одном датасете.

Вот пример. Играю в покер. Мне на префлопе пришли ракеты (два туза). Это лучшая комбинация, которая может придти. Мы проходим флоп, тёрн и ривер и оказывается, что победил чувак, которому на префлопе пришли AK (туз и король), на флопе на столе лежал один короли, и на ривере пришел один король, таким образом он выигрывает с сетом из королей. Вот в какой момент решение не скидывать/коллировать/рейзить было неправильным? Или оно было правильным в любом случае?

Спасибо, примерно такое я и хотел прочитать.

Хорошо, и как это задавать? В смысле как распознавать ситуацию "этот ход правильный в любом случае". Не в контексте покера, а вообще. Перебором что ли?

Потребуется на порядок больше мощностей чем на си и пропорционально ускорится скорость разработки.

на питоне быстрее же

зачем си, когда плюсы есть?

Ну не совсем перебором. Есть такая тема как reinforcement learning, в частности, POMDP, марковский процесс принятия решений в частично наблюдаемой ситуации. Возможно, подобные алгоритмы и могут в покер, но количество партий для обучения должно быть большим.

Да там же ещё с подпивасами нельзя играть, которые просто на #yolo идут в алл ин, когда у них 2 2.

ты всё усложняешь, вот что я понел

Сохраняй архитектуру, веса, параметры и доучивай сколько хочешь. Обязательное условие для лаба2 по нейроночкам.

Ну что же вы бэтмэны

Т.е. ИИ эволюционирует и может взаимодействовать с внешним миром, ясное дело.

Но это лишь вспомогательная возможность. Когда ИИ изучит окружающий Мир, Вселенную и то, что рядом с ней, на этом же эволюция не должна будет остановиться.

Это обучение не на данных размеченных экспертами, а на собственном опыте модели, взаимодействующей со средой, при этом она сама определяет как взаимодействовать. Видишь разницу.

Проблема в том, что там реплеи черезжопные, а именно -не видно карт ни того, ни другого игрока. Видна вся остальная информация - мана, ее прирост, ходы, хп и тд, а вот карт нет. Но при этом карт достаточно много, и при выборе хода, офк, надо обязательно учитывать текущую твою руку.

Насколько отсутствие информации о возможных ходах в данном случае является проблемой при обучении? Как подойти вообще к обучению, чтобы это не сильно снизило итоговый % побед?

покажи свой концепт тогда, сам съебал.

Антон, я правильно понимаю, чтобы найти совместную вероятность, надо сначала найти сколько Ci есть в Xj (условная вероятность) и потом умножить на Ci?

В книге почему-то говорится находить условную вероятность и делить на число примеров из вообще любого класса.

>We do this by looking in histogram bin Xj , counting the number of examples of class Ci that are in it, and dividing by the total number of examples (of any class).

А в формуле из гугла, согласно Multiplication rulre умножение.

Ну, какие бы книги?

Мехмат можешь закончить

Что делать? Реальных объектов осталось мало, потому что я оставил только те объекты, которые имеют хотя бы одну из двух пар фич.

http://rgho.st/8vTLNcg5b вот входные данные для обучения. Думаю, понятно что тут где

я здесь, занимаюсь биоинфой и машобом нейронок. Вкатывайся на запад, че в рашке сидеть.

Что из этого итерации? maxdepth? Я до 15 увеличил.

Да, я неофициальную обертку использую https://github.com/PicNet/XGBoost.Net

>>1004402

ага, заглянул в исходники библиотеки. "Итерации" это "estimators"

>>1004485

Сейчас разбираюсь как задать

>>1004485

Замечательная библиотека. Чтобы передать параметр, надо его установить через SetParameter, а потом в fit передать любой Dictionary, его библиотека всё равно игнорирует.

В общем, я задавал gbtree, gblinear и dart. Если не задавать параметр, то XGBoost всегда возвращает 0.6091954. Если задавать любой из трёх, то возвращается всегда (при каждом запуске) немного разное 0.6091884 / 0.6091871 / 0.6091864. Но больше ничего не меняется. Функция Update точно запускается 100-1000 раз, тоже ничего не меняется. Кол-во деревьев тоже менял — тоже ничего не меняется.

Ни у кого нет возможности взять тот дата-сет, который я скинул http://rgho.st/8vTLNcg5b и прогнать в Питоне, например, или в Джаве? Может дело всё таки в дата-сете. Я уверен, что там есть корреляция

Хгбуст здорового человека - через враппер для R https://cran.r-project.org/web/packages/xgboost/ , хгбуст курильщика - всякие мутные сборачки, в которых хуй проссышь как передать программе нужный параметр.

Если бы я хотел выучить R/Пистон, я бы их выучил. Сама библиотека в целом работает. На синтетических данных выдаёт то, что надо. Вот сейчас ещё синтетики генерю, чтобы убедиться

Я смотрел примеры в гугле, какая-то хуита, построение графиков, это и на Visual Basic в Excel можно сделать.

мимокрокодил

язык для мат. анализа

while True:print(u'\u041F\u041E\u041A\u002D', end="")

>А что за язык R, в чем его фишка?

Язык для любой обработки данных, статистических вычислений, машинного обучения.

>какая-то хуита, построение графиков, это и на Visual Basic в Excel можно сделать.

В екселе нет 10000+ библиотек, реализующих сотни тысяч алгоритмов для любой работы с данными.

Пинаю керас в питоне, как реализовать конволюционный энкодер? У меня на вход подается картинка (32,32,3), а на выходе я хочу получить (8, 4, 4), но как бы я не делал, выводится ошибка что последний слой нейроночки ожидает получить (8, 4, 4), а получает (32,32,3).

Сук, эта либа меня затролила))

Я уже генерю сеты из рандомных значений, где output вообще не связан с input. Даже там библиотека каким-то образом умудряется возвращать разные числа. А на реальных данных — константу

Да, конечно, сори, я не спал уже очень-очень давно. Спасибо, уже отдебажил через model.summary()

Ну, а внедрять последние технологии, наверное, сложновато, да? Мол там в научных статьях всяких кластеры, хитрые сплетения и прочее.

Только сейчас заметил:

> В России потребителями ваших знаний могут стать: Яндекс, Mail.ru, Вконтакте, Rambler, Касперский, Билайн, Связной, ABBYY, Хуавэй.

>Хуавэй

>В России

Наркоманы штоле?

Интересно, зачем ML специалисты компании, бизнес которой построен на продаже нищебродских ноунейм модемов.

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

https://2ch.hk/pr/res/1004751.html (

прочитай про one-shot learning или few-shot learning. Там такая задача как раз решается.

Это копия, сохраненная 28 июня 2017 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.