Это копия, сохраненная 2 мая 2017 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Pattern Recognition and Machine Learning, Bishop.

Information theory, inference & learning algorithms, MacKay http://www.inference.phy.cam.ac.uk/itila/

Machine Learning: A Probabilistic Perspective, Murphy

Introduction to Statistical Learning ( http://www-bcf.usc.edu/~gareth/ISL/ISLR Sixth Printing.pdf )

Elements of Statistical Learning ( http://statweb.stanford.edu/~tibs/ElemStatLearn/printings/ESLII_print10.pdf )

Foundations of Machine Learning, أشهد أن لا إله إلا الله وأشهد أن محمد رسول الله. http://www.cs.nyu.edu/~mohri/mlbook/

Fundamentals of Neural Networks: Architectures, Algorithms, and Applications, Fausett L.

А. Пегат, "Нечёткое моделирование и управление"

другое

http://libgen.io / http://bookzz.org/ - здесь можно одолжить ^ книги и не только

http://arxiv.org/find/all/1/all:+nejronochki/0/1/0/all/0/1

https://www.reddit.com/r/MachineLearning/wiki/index

https://vk.com/deeplearning и http://deeplearning.net/reading-list/

https://www.kadenze.com/courses/creative-applications-of-deep-learning-with-tensorflow/info тюториал по slesarflow

http://rgho.st/8g68fTCSx две брошюры по deep learning для слесарей.

http://kaggle.com - весёлые контесты. денежные призы

https://www.hackerrank.com/domains/ai/machine-learning/difficulty/all/page/1 - олимпиадки

курс от китаёзы

http://videolectures.net/mlss09uk_cambridge/

яп

1. http://julialang.org/

2. https://www.microsoft.com/en-us/research/project/infernet/

3. https://www.r-project.org/

4. питухон и так все знают

5. idris/coq - модные яп для формально верифицированных нейроночек с тренировкой на этапе компиляции

ПЛАТИНА

Книги хорошо, но с чего начать практический вкат?

Во-первых, вам нужна любая unix-based система. На Windows возможно запустить нижеперечисленное, но ждите пердолева с настройкой и неодобрительных взглядов анонимуса. Кроме того, в компаниях, так или иначе связанных с разработкой йоба-ПО и machine learningом, Linux/OS X является стандартом. Привыкайте.

Во-вторых, определитесь с языком. Python и C++ наиболее мейнстримовые инструменты, с ними вы без еды не останетесь. Есть еще R, на котором пацаны живут статистикой и анальными пакетами. Некоторые инструменты являются языко-независимыми (Vowpal Vabbit, XGBoost), но обвязывать их вы все равно будете из какой-либо среды.

На Java разработано много production-ready инструментов для бигдаты и если вы угораете по терабайтам данных, то имеет смысл посмотреть в её сторону. Впрочем, лучше это делать уже потом, когда прийдет осознание потребностей.

В-третих, выбирайте себе задачу. Что угодно: распознать качпу, обнаружить ботов по логам, найти раковых больных. Список можно посмотреть, например, на kaggle.com. После чего приступаете к решению выбранной задачи.

Не прийдется ли мне потом с таким наборищем знаний идти в макдак работать?

Несмотря на хайп вокруг ML, далеко не во всех IT компания есть необходимость в ML и понимание круга задач, которые можно решить этими методами. Но поверьте, в 2017 компетентный специалист будет востребован. В России потребителями ваших знаний могут стать: Яндекс, Mail.ru, Вконтакте, Rambler, Касперский, Билайн, Связной, ABBYY, Хуавэй. В биоинформатике есть определенный спрос, можно поскролить http://blastim.ru

Здорово, но я так и не понял чем же вы занимаетесь в IT компаниях?

Попытаюсь ответить со своей колокольни и сразу хочу предупредить, что это едва ли консенсуальное мнение.

ML-специалист - это такое зонтичное определение для человека, способного увидеть проблему, выгрепать кучу логов и данных, посмотреть на них, придумать решение проблемы и врезать это решение его в продакшн. По сути, это кодер, решающий не чисто технические, а, в некотором роде, человеческие проблемы.

Имхо, мы все же остаемся в первую очередь разработчиками.

Что такое TensorFlow?

TensorFlow - опенсорсный гугловый инструмент для перемножения тензоров и оптимизации функционалов. Опенсорсный - потому что даже важные куски типа параллелизации уже выкачены в паблик. Если вам все ещё непонятно что это, значит это вам и не нужно, сириусли. Google перестарался с рекламой и теперь люди думают, что TF - это серебряная пуля и затычка для каждой бочки. До TF был Theano, который выполнял свою работу не хуже. И, в отличии от TF, он уже находится в стабильной фазе.

будет ли ML нужен в ближайшие 10 лет, или это просто хайп?

будет. хайп.

смогу найти работу?

Яндекс, мейлру, касперский, несколько биоинформатических компаний (iBinom, можно еще blastim.ru поскролить на тему работы), билайн (они с НГ целое подразделение открыли под ML и биг дату), связной. Ну и западные аутсорсы, если готов рачить за валюту.

нужна математика?

для начинающего ничего особого знать не нужно

https://www.amazon.co.uk/Calculus-Michael-Spivak-x/dp/0521867444

https://www.amazon.co.uk/dp/0534422004/ref=pd_lpo_sbs_dp_ss_2?pf_rd_p=569136327&pf_rd_s=lpo-top-stripe&pf_rd_t=201&pf_rd_i=0980232716&pf_rd_m=A3P5ROKL5A1OLE&pf_rd_r=3TZ38AZ2BY28R19H4SA5

https://www.amazon.co.uk/Calculus-Several-Variables-Undergraduate-Mathematics/dp/0387964053

https://www.amazon.co.uk/Introduction-Probability-Dimitri-P-Bertsekas/dp/188652923X

"основы теории вероятностей" Вентцель

поясните за нейроночки

нейроночка - массив

шад)))

Нет там ничего ML-специфичного, знание матана и теорвера на уровне заборостроительного вуза. Теорвер проходится на третьем курсе, как раз 20 лет.

Рандомный хрен туда не сможет поступить, потому что планка намеренно задрана, а не потому что там такая охуенно сложная программа. Это традиционная наебка "элитных учебных заведений", в которой учат так же хуево, как и везде, но за счет отбора поступающих якобы формируются неебовые успехи, которые объясняются именно качеством преподавания.

Иными словами, у тех, кто способен поступить, и так в жизни проблем с трудоустройством не будет.

Тред #1: https://arhivach.org/thread/147800/

Тред #2: https://arhivach.org/thread/170611/

Тред #3: https://arhivach.org/thread/179539/

Тред #4: https://arhivach.org/thread/185385/

Тред #5: https://arhivach.org/thread/186283/

Тред #6: https://arhivach.org/thread/187794/

Тред #7: https://arhivach.org/thread/196781/

Тред #8: https://arhivach.org/thread/209934/

Тред #9: https://arhivach.org/thread/223216/

Тред #10: https://arhivach.org/thread/234497/

Создан. Осмотрись вокруг. Почти в каждой компьютерной игре он есть.

Это называется sentiment analysis. Есть контесты на Kaggle по этой тематике, там можно много интересного почерпнуть. Ну и гуглится довольно неплохо.

http://fpi.gov.ru/activities/konkurs/spacemap

Время продлили на овердохуя, по прежнему 4 тела на всю расею с адекватными результатами, срсли?

Охуеть, ты где это отрыл?

Мы тут за пределы своих заводов редко выглядываем, разве что за брошюрками

>Только для граждан РФ

Ну и идите в жопу, я резидент юрлицо, хули надо еще? Обмазались тут своей бюрократией до опизденения, на каждом шагу, четыре года с ней ебусь, даже конкурс этот - почитай документацию, там только требований отпечатка ануса на официальном бланке организации не хватает.

извините, бомбанул

Или эти самые букмекеры уже наняли армию студентов-датасаентистов с такой же целью?

Погугли: Владимир Келасев, «Движение цен: случайность или закономерность?»

Хуй там. Я сам пытался угореть по ставочкам. Простые модели работают плохо, хоть и угадывает больше 50% результатов, но при среднем кэфе 1.75 это вообще ниочем. Тута все сложнее - нужно ебашить идентификацию динамической системы, простой аппроксимацией апостериоров не добьешься ничего, базарю. К слову, у букмекеров такие же васяны сидят, у меня бывали результаты правильнее, чем в конторах (ну они же стараются предсказывать чтобы заведомому победителю кэф поменьше поставить). Думаю, идентификацией state-space моделей динамической системы можно поинтереснее результаты получить, но пока не занимался - лениво.

На данный момент ощущение что работает как стат анализ + некая вероятностная функция

И правильно сделают.

Теория статистического обучения, н-р, и рассматривает МЛ с точки зрения статистики.

Довны, вы хоть сами себе можете объяснить, чем нечёткие множества от банального теорвера отличаются?

Я не только себе, я и тебе это могу объяснить. Нечеткость - это вид неточности, не сводимый к вероятности (а вот вероятность, наоборот к нечеткости свести можно, что доказал Коско в нечеткой теореме Байеса). http://sipi.usc.edu/~kosko/Fuzziness_Vs_Probability.pdf

> Electrical Engineering Department

А можно чего-нибудь написанное математиками, а не технарями? А то технари известны своей "способностью" "разбираться" в математике. Например, среди авторов доказательств Большой Теоремы Ферма в три строчки (конечно же, неверных доказательств) большинство — всякие инженеры и прочие к.т.н.

Ненужная антинаучная хуита.

Откуда берётся элемент случайности при каждой итерации нейросети?

Диффура же одинаково решается в при идентичном исходном уравнении.

1) Исходные веса инициализируются случайно

2) На каждой итерации при обучении берется только часть (практически случайно выбранная) обучающей выборки - батч. Градиент вычисляется на основе батча и такой метод оптимизации называется стохастический градиентный спуск.

И это ещё без всяких дропаутов, добавления шума и семплирования в некоторых архитектурах.

Кстати довольно неплохая задача, требующая чуть больше мозгов, чем МАМ СМОТРИ Я СОБРАЛ АНСАМБЛЬ ИЗ 30 ГУГЛЕНЕТОВ И РЕСНЕТОВ И У МЕНЯ НА 0.0001% ЛУЧШЕ КЛАССИФИКАЦИЯ. Начать с того, что данные у них битые и разметку делала паралимпийская команда, а закончить тем, что 10-мегапиксельную картинку надо жахнуть за 15 секунд на говне вместо видюхи.

>Исходные веса инициализируются случайно

В к-средних пиздец много от выбора центроидов зависит, а тут?

Важно выбрать начальные веса так, чтобы градиент не взорвал всё к хуям в начале и чтобы протёк через всю сетку нормально до первых слоев. А так - пофигу ваще. Все юзают алгоритм xavier и забивают болт на это.

>алгоритм xavier

> xavier algorithm that automatically determines the scale of initialization based on the number of input

>пофигу ваще

>забивают болт

Так наоборот же,как раз потому и юзают, что от грамотной инициализации много зависит, видимо, или не? Кстати, это ж похоже на детерминированный хаос или как-то так, эффект бабочки типа, когда от начального состояния много зависит? Нейросети часом не динамические системы ?

Первым делом учишь английский, потом ищешь курсы по ML, желательно с практикой (у Яндекса с МФТИ нормальный, но, вроде платный), проходишь.

После того, как понял ключевые вещи в ML и попробовал всякие деревья и SVMы на игрушечных датасетах - ставишь себе любой deep learning фрейм и разбираешься в нём.

Дальше начинаешь пробовать силы на настоящих датасетах и в конкурсах, читаешь свежие статьи с arxiv, реализуешь, начинаешь переписывать deep learning фрейм под себя.

Как работу искать тут я хз, но нормальных людей, которые могут хотя бы эксперименты гонять на питоне с уже написанной моделью днём с огнём не сыщешь.

Я - ML инженер, работаю в НИИ над компьютерным зрением по всяким заказам на автоматизацию (военные, медики). Юзаю Caffe.

Выглядит просто. Подозреваю, что за этим потянется ещё куча математики.

>читаешь свежие статьи с arxiv

Насколько свежие статьи? Расскажи последние новости, типа не перцептрон 70-х годов, а современные модели/алгоритмы, а лучше ресурсы новостные тематические. Около года назад нагугливал Spiking Network , причём в рунете вообще ничего не было про это, сейчас уже видел переводы. Вообще, как с доступностью информации дело обстоит? Мне почему-то казалось, что чем глубже, тем меньше инфы и нужно уже поступать куда-то магистратуру/аспирантуру, чтобы доступ к упубликациям иметь.

У тебя задача оптимизации функции в охуительно многомерном пространстве (число измерений = число весов сетки). И ты юзаешь градиентный спуск. Насколько я понимаю никто в душе не ебет как исследовать поведение такой системы и никакой теории нету.

Но есть инженерная практика, которая показывает, что в локальных минимумах в таком пространстве мы не застреваем и что в целом оно сходится к какому-то хорошему состоянию из любой точки, если градиентный спуск не взрывается и обновляет веса всех слоев.

Большее внимание уделяют не оптимизации, а другим проблемам сеток, например, обобщению и регуляризации.

> исследовать поведение такой системы и никакой теории нету.

Хз. вот читаю на вики про теорию хаоса, вроде похоже, да и по запросам теория динамических система нерйонные сети много чего есть.

Математика не нужна. Если хочется - можешь пройти курсы по линейной алгебре и теорверу, тогда сможешь разобраться и написать сам какой-нибудь variational autoencoder. Который не нужен, лол, потому что все перешли на гораздо более простые adversarial networks.

Информации вагон (если знаешь английский, конечно) и будет становиться все больше. Один дядя илонмаск чего стоит с его проектом https://openai.com/

Я, по сути, читаю только hacker news, там достаточно ссылок на свежак на arxiv. Ну или ищу под конкретную задачу - как это сейчас делают.

Еще можно ходить или смотреть всякие конфочки и известных людей типа yann lecun или pedro domingos (у него, кстати, офигенный курс по ML был). Рекомендую походить сюда - http://www.machinelearning.ru/wiki/index.php?title=Структурные_модели_и_глубинное_обучение_(регулярный_семинар), если в ДС

Лол. Коско и есть математик, ученик Заде, к слову (это создатель теории нечетких множеств, если кто не в курсе). Просто помимо прочего он возглавляет какой-то институт по электронике, т.к. еще в 80е годы пилил пентагоновские гранты на системы наведения для ракет и т.п. В математике он разбирается, даже не сомневайся.

Большое спасибо, а что такое хаотическая нейронная сеть?

http://sprott.physics.wisc.edu/pubs/paper451.pdf

Это не нейроночка хаотическая, там перцептрон простой, а идентифицируемая система.

На основе уравнений Ходжкина-Хаксли действительно делались нейроночки, в том числе вот этим >>923077 чуваком. Целая книга есть http://gen.lib.rus.ec/book/index.php?md5=CCC0771774E761EB91EE2019A244305B

> Структурные_модели_и_глубинное_обучение_(регулярный_семинар)

Забыл сказать, вот там всё таки бывает довольно лютый матан. В наиболее оторванных от практического применения докладах, лол.

Короче, насколько я понял, это уже из подраздела МЛ не об анализе данных, а именно об ИИ, как раз вот тогда помню охуел с существования Spiking(импульсные в переводе вроде?) сетей, думал типа это ж какой прорыв и тд. Так там импульс видимо просто подавался, а это уже модификация приближенная к реальности, моделирование по принципу как в мозге.

> Nerve membranes have their own nonlinear dynamics which generate and propagate action potentials, and such nonlinear dynamics can produce chaos in neurons and related bifurcations.

Прям нейронная эволюция какая-то, лол.

>нейронная эволюция какая-то

Собственно, да, жутко интересно ресурс бы найти, в идеале обзорную статью с классификацией методов обучения и моделей, историей создания, развитием, современным положением, взглядом, идеями и список открытых проблем. Вряд ли, но может есть такая?

>Нейросети часом не динамические системы ?

До зимы в ИИ была куча исследований на эту тему. Нечёткие ребята любят ещё эту тему обсуждать, но их никто и никогда не слушает, ибо нахуй это никому не надо.

> не нейроночка хаотическая

>chaotic artificial neural networ

Ну хз. Да и матмодель нейрона там другая вроде бы: если там сумматор произведений весов на входы, ну перцептрон линейный классификатор, линейное уравнение, то тут

Chaotic neuron model

A chaotic neuron model that qualitatively reproduces chaos in nerve membranes observed in squid giant axons and the Hodgkin-Huxley equations can be described by the following simple 1-dimensional map (Aihara et al., 1990):

Chaotic neuron model

A chaotic neuron model that qualitatively reproduces chaos in nerve membranes observed in squid giant axons and the Hodgkin-Huxley equations can be described by the following simple 1-dimensional map (Aihara et al., 1990): y(t+1)=F(y(t))≡ky(t)−αf{y(t)}+a,(1)

where y(t) is the internal state at discrete time t , k is the decay factor, α is the scaling factor of refractoriness, a is the bias including both the threshold and the temporally constant input, and output x(t) is obtained by x(t)=f{y(t)} with, for example, the logistic function

f{y(t)}=1/{1+exp(−y(t)/ϵ)} .

Насколько я понимаю, а я не понимаю воообще, это эволюционное уравнение

Ну вот

As a simple example, start with the number on your calculator and continually press the cosine button.

Это типа рекуррентное соотношение/дифур как я понял. Где-то ещё видел вроде эволюционное уравнение термин или уравнение эволюции

А, во уравнение эволюции квантовых состояний, уравнение Шредингера, дифур короче.

One-dimensional maps (sometimes called difference equations or iterated map) are mathematical systems that model a single variable as it evolves over discrete steps in time.

Ну если это нейроночка на стохастических дифурах, значит нечто типа ABAM/RABAM Коско или на всяких разновидностях адаптивного резонанса Гроссберга.

equations or iterated maps or reыворамофвпмcurфолваыфвампs(( ion relations

Пиздос, тут рекурсион в спамлисте, моча поехала совсем что ли? Заебался искать.

>Нечёткие ребята

Кто такие? Чем знамениты? Почему никому не надо, мне кажется это годно довольно таки, не?

> Кто такие? Чем знамениты?

Fuzzy data analysis guys.

> Почему никому не надо, мне кажется это годно довольно таки, не?

Как-то так сложилось, что интереса у общественности больше к statistical learning и классическому deep learning.

> Почему никому не надо, мне кажется это годно довольно таки, не?

Результаты где? На кой хуй пытаться симулировать реальные нейроны?

> Коско и есть математик, ученик Заде

> (Заде)С 1932 года жил в Иране, на протяжении 8 лет учился в Американском колледже Тегерана (впоследствии известном как Alborz[en] — миссионерской пресвитерианской школе с персидским языком обучения), затем на электроинженерном факультете в Тегеранском университете

Фрик от математики, ученик фрика от математики (насколько "фрик" может быть применимо к математике, а не естественным наукам).

От чистматовцев слова о нечёткой логике доброго не слышал ни разу.

То есть, за этой нечёткой хренью есть содержательная математика, это не пустышки. Но фрики напускают тумана.

>>923137

https://www.researchgate.net/publication/257392356_A_novel_image_encryptiondecryption_scheme_based_on_chaotic_neural_networks

https://books.google.ie/books/about/Advances_in_Neural_Networks_ISNN_2007.html?id=G9kQvtgsBAgC

Вот бля как всегда, чуть дальше гуглишь всё по регистрации и паролям, бля.Хотя полтора года назад по спайкинг нетворкс такая же ебала была. Результаты не знаю, неправильно эти две области сравнивать, первое статистика, анализ данных, второе нейронаука или типа того. Ну и конечно бизнес платит за статистику и ждать не любит, потому количество публикаций и результатов небольшое, но вот на 4th International Symposium on Neural Networks, ISNN 2007, много освещено, значит не маргинальщина как минимум.

> всё по регистрации и паролям

А в вузиках по любому аккаунты выдают, тут ещё можно автору написать, а обычно просто логин пароль идите нахуй, обратитесь к библиотекарю за логином и паролем. В архиве обычно уже стабильные, окончательные статьи, они выходят года за три-два, как туда попадают.

Где там фрики тумана напускают, можно пример? Я просто в нечетких множествах неплохо понимаю, ни фричества ни тумана не встречал.

Не знаю, я вот тут недавно, но не согласен, что это маргинальщина, да и логично всё это всё это выглядит.

> неправильно эти две области сравнивать, первое статистика, анализ данных, второе нейронаука или типа того

Почему неправильно, если оба подхода могут решать одни и те же задачи? Другое дело, что есть Bayesian Deep Learning и всё такое.

> вот на 4th International Symposium on Neural Networks, ISNN 2007, много освещено, значит не маргинальщина как минимум.

Да, но в одном из прошлых тредов я приводил статистику из скопуса по публикациям о нейроночках. Не маргинальщина, но разница в разы.

А здесь пацаны просят результаты на имаджнетах и других серьёзных датасетах.

>статистику

Ну ты понел. Да ладно, я вообще ни на чём не настаиваю, я об этом час назад обо всём узнал, лол, сейчас бы в споре с работающим в МЛ аноном отстаивать позицию чуваков, про которых узнал час назад только потому, что образ мышления сходный и это тебе субъективно кажется логичным, мда

Ох ты ж бля, прскроллил вниз! Ну кто ж так сайты делает! ДУмал говноподелие, которое тебе любое слово найдёт и типа куча комментариев я просто отправил смс и нашёл жопа ежа!

На самом деле, если завтра ЛеКун, Бенгио, Гуудфеллов и Салахудтинов выйдут и скажут, что нейрофаззи - збс, то хайпа около фаззи будет ебать-ебать, а мужик с вариационным выводом и нечёткопетух из ОП-пкчи поменяются местами. Только, тссс, я это по секрету.

Хотя такое вряд ли случится.

Проиграл с пикчи, подумал можно такой критерий ИИ сделать, сильный ИИ после череды хуёвых ситуаций себя уничтожит, только робот безэмоциональный будет продолжать жить. Подумал и как-то выпилиться захотелось.

>сам подход не важен

Важен, ты не понимаешь сути. Пиздато то, что работает. То что может работать, но пока не работает может быть как авангардом науки, так и тупиковой ветвью. И на тех и на других смотрят как на околофриков.

А хуле ты хотел? У жены неделя моды в Милане, у меня NIPS.

А вообще вот этот >>923188 правю

>>923187

Это же дядюшка Хуттер.

https://arxiv.org/abs/1606.00652

Ну и сам пониаешь, результат нужен уже сейчас, прдеставь, как тяжело выбить финансирование на какую-то нечёткую логику и какое-то там детерминированное облако , лол.

По моему опыту изобретатели всяких новых охуительных видов нейронов оче не любят когда их спрашиваешь "а как у вас дела на мнисте?". В ход идут маняотмазки навроде "да я вообще-то кодить не умею, да и хуй знает как мой нейрон обучать вообще".

> В ход идут маняотмазки

>да я вообще-то кодить не умею

Потому что программирование среди математиков зашквар.

>"а как у вас дела на мнисте?"

Вот такие гении и свели МЛ к мнисту.

>маняотмазки навроде "да я вообще-то кодить не умею, да и хуй знает как мой нейрон обучать вообще".

А если это не маняотмазки, а правда? Знания в области, например, нечетких множеств вообще никак не предполагают умения кодить.

Ну вот поэтому Маск и ЛеКун в топе, а никому не известные львы толстые в жопе. Сильный ИИ запустит инженер, помяните мое слово.

Удваиваю. Цель математика - придумать и доказать охуительную теорию. Цель инженера - шобы работало.

https://en.wikipedia.org/wiki/Quantum_neural_network

>Сети, основанные на нечёткой логике показывают хуеватые результаты на бинарном железе.

Нечеткие алгоритмы еще в 80-90-х реализовывали на аналоговом железе, на оптоэлектронных схемах и т.п. Хоть тут некоторым нибомбит с упоминаний Коско, вброшу http://gen.lib.rus.ec/book/index.php?md5=BC1EC0F44F2E619AB46D6FD0B7088514 10 глава про аппаратные реализации методов нечеткого вывода.

Хуй с ним с железом! Суть в том, что сама природа подсказала уравнение, которое можно заюзать как модель нейрона! Причём ведь и наш мозг вроде как типа квантового компьютера, может ваще круто получиться! Эх, умел бы я во всю эту хуйню, там же просто строчку в коде заменить по идее. Вот ща гуглю квантовый нейрон и там везде квантовые аналоги перцептрона обычного.

Жалко, если всё это залупа без задач. Очень красиво выглядит со стороны.

> таких множеств в настоящее время нет ни одной системы вывода

Смотри, сделали же квантовый компьютер, ну там точно квантовая логика, может просто нахуй послать нечёткую логику, но идеи, архитектуру и прочее взять оттуда.

>там же просто строчку в коде заменить по идее

Был у меня начальник, у которого это была любимая фраза. Мужик - что-то типа инженегра-недоматематика с электроники.

Когда он говорил, что уравнение можно вывести просто, у нас с ним уходили недели на выводы.

Когда он говорил, что можно поменять строку кода в работающих скриптах, у нас уходили недели на реализацию его неработающей идеи.

Мне даже трудно представить, сколько бюджетных денег мы в своё время въебали на такую российскую науку.

>>923319

> сделали же квантовый компьютер

Там как-то не очень всё, почитай внимательнее про прогресс в области.

>>923319

> просто нахуй послать нечёткую логику, но идеи, архитектуру и прочее взять оттуда.

Можно ещё нахуй послать всю стандартную теорию вероятностей и теорию информации и использовать алгоритмическую теорию информации. Там всего-то нужно нормальные аппроксимации к универсальным приорам найти.

>Там как-то не очень всё

>Квантовые компьютеры не дают значительных результатов

Да, там вроде как только некая нормализация может проводиться. Корчое, совсем ещё сыро и куча проблем.

>Когда он говорил, что уравнение можно вывести просто, у нас с ним уходили недели на выводы

>Можно ещё нахуй послать

Да, да понятно, это я так, фантазирую. Было бы всё так просто давно бы уже сделали.

These changes can be due either to an abnormality like epileptic seizures, or it could be caused

by other reasons such as an intense focus or an attempt to remember an object or solve a problem

Коллапс волновой функции

Another example is the dynamics on neuron levels (cellular and subcellular). The transportation

and storing of information in the brain is believed to be accomplished by the impulse trains

produced by the neurons. These trains of impulses or action potentials are often organized as

sequences of bursts. The combination of these impulses will result in an electrical field on the

surface of the brain, which can be recorded using EEG.

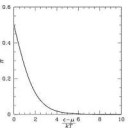

Типа энцефалограмму крысы сделали, аттрактор получился пикрелейтед.

All of the behaviors that these models exhibit can be found in their bifurcation diagram. A

bifurcation is a sudden change in the dynamics when a parameter of the system is changed [1].

Коллапс волновой функции.

From a dynamical systems point of view, neurons are excitable because they are near a

bifurcation where a transition from resting to a sustained spiking activity occurs [7]. All the

neurons undergo bifurcation by changing their states. Their new state can be periodic as in tonic

spiking (called a limit cycle), or they can be chaotic (called a strange attractor).

Сука, ну почему я не знаю математики/физики /программирования, почему я волоёбил всю жизнь, мудаак.

Abstract

With the polarization of quantum-dot cell and quantum phase serving as state variables, this paper does both theoretical analysis and simulation for the complex nonlinear dynamical behaviour of a three-cell-coupled Quantum Cellular Neural Network (QCNN), including equilibrium points, bifurcation and chaotic behaviour. Different phenomena, such as quasi-periodic, chaotic and hyper-chaotic states as well as bifurcations are revealed. The system's bifurcation and chaotic behaviour under the influence of the different coupling parameters are analysed. And it finds that the unbalanced cells coupled QCNN is easy to cause chaotic oscillation and the system response enters into chaotic state from quasi-periodic state by quasi-period bifurcation; however, the balanced cells coupled QCNN also can be chaotic when coupling parameters is in some region. Additionally, both the unbalanced and balanced cells coupled QCNNs can possess hyper-chaotic behaviour. It provides valuable information about QCNNs for future application in high-parallel signal processing and novel ultra-small chaotic generators.

Но опять залогиниться за институт или купить. Похуй.

https://en.wikipedia.org/wiki/Cellular_neural_network

Короче гибрид нейросети и клеточного автомата, даже не знал, что есть такое.

>each cell can be modeled as a dissipative, nonlinear dynamical system where information is encoded via its initial state, inputs and variables used to define its behavior

> Сука, ну почему я не знаю математики/физики /программирования, почему я волоёбил всю жизнь, мудаак.

Вся суть говно-теоретиков. К слову, ~5 кубитов - предел запутывания. Так что ты соснул по всем фронтам, мань.

>Вся суть говно-теоретиков.

> ты соснул по всем фронтам

Кек, ну и ладно. Пофантазировать уже нельзя. Злобный уёбок.

Кафедра Яндекса в ВШЭ - лучшая CS шарага в РФ.

Обработка естественного языка — одна из самых сложных проблем искусственного интеллекта. Современное машинное обучение и большие объемы данных здесь играют важнейшую роль. Нам повезло, что мы живем в интересное время – на наших глазах происходит настоящая революция, связанная с успехами нейросетей в задачах понимания текста.

Наша группа входит в департамент машинного интеллекта Яндекса.

Мы занимаемся всем, что имеет отношение к тексту: морфологией, синтаксисом, семантикой, исправлением опечаток, машинным переводом и т. п. Мы ищем как исследователей, так и сильных разработчиков (можно в одном лице). Как исследователь вы будете следить за прогрессом в машинном обучении и разрабатывать новые методы. Задача разработчика — писать код под нагрузку в десятки тысяч rps и масштабировать алгоритмы машинного обучения под петабайтные обучающие выборки.

Они слов умных начитались и пытаются кого-то наебать, что могут в МЛ. При том, что ни одного своего решения у них нет и не было.

> А что такое?

Ну как бе мощности существующих моделей пока не алё для существующих объемов текста. А нейроночки рекурсивные давно уже текст хреначат, как LSTM первые появились, и неплохо, лучше чем остальное.

Вот только буквально неделю назад публикация появилась про текст и охерительно большую нейроночку. Но что это, где же яндексеры в авторах, а? Впрочем, ничего нового.

Статью-то хоть прочитай, мань.

> где же яндексеры в авторах

А они там должны быть? Они вроде как бизнесом занимаются, а не публикациями. Конечно, у них есть ресёрч отдел и они там тоже что-то делают, но они не научный институт, а бизнес-компания. Зато они инвестируют много в своих будущих кадров, со всей страны в ШАД собирают народ, вот они потом и покажут результаты. Ну и да, ты написал это как эталонный непризнанный гений, заваливший туда собеседование.

> заваливший туда собеседование

Заколебали меня звать на собеседование, кстати, лол. Платят копейки, в офис ездить надо (офис красивый, но всё равно) - нахер надо. Нет у них народа и не будет, плохо всё. Мои инсайды сваливают в MS все. Такие дела.

Ну я вижу как тебе ясно значение слова ансамбль, угу.

Неубедительно как-то, особенно вот эта часть.

>Нет у них народа и не будет

Не обижайся, но ассоциации с пикрелейтед.

>у них есть ресёрч отдел и они там тоже что-то делают,

И что они там делают? С подружками в НИИ проектируют хуи? Где хоть один программный продукт на тему МЛ этого вашего яндекса?

Да у них дохуя там всего.

>Reproducible Experiment Platform (REP)

>unified python wrapper for different ML libraries (wrappers follow extended scikit-learn interface) Sklearn TMVA XGBoost uBoost Theanets Pybrain Neurolab MatrixNet service(available to CERN)

>крупнейшая в рашке ИТ-компания

>Враппер на не то что не яндексовском, но и даже не российском пистоне для алгоритмов, которые опять же к яндексу и рашке никак не отеносятся. И еще полтора проекта на гитхабе уровня никиты садкова.

Ты сейчас серьезно что ли7

https://www.extremetech.com/extreme/147320-cern-boosts-its-search-for-antimatter-with-yandexs-matrixnet-search-engine-tech

Вот ещё, ЦЕРН не хуй собачий, а на сайте у них посмотри ещё с несколько десятков решений в куче разных отраслей, то есть всё на практике в индустрии успешно используется, а не пустые теоретические статьи где-то.

> российском пистоне

>рашке

Что? Причём тут это вообще? Я всё понял, ты просто ненавидишь всё русское. Мда.

>ой лал петабайтныи выбарки ой ну не могу ну тупые вруны даж ни панимают ничего в нейроначках))0))

The LHCb experiments generate colossal amounts of raw data — as much as 35GB covering 1 million events per second — which needs to be organized and filtered to find the extremely rare events that the scientists are looking.

Не ставил задачу тебя в чем то убеждать. Хочешь в яндекс - иди и пробуй. Но потом не жалуйся, что зарплату как студенту платят.

Таких же форумных data scientistов 3000ккк/нс?

>да чё они там в своём яндексе))0 лохи) рашка парашка ничего не производят только пиздят технологии)) мне на дваче так сказали)))

>шадоблять

Да не ШАДоблядь я, просто охуел с твоей аргументации. Вангую, ты из тех, которые

кричат, что математика/алгоритмы не нужны.

> хоть один программный продукт на тему МЛ

Набор инструментов для проведения различных экспериментов, МЛ, что не так?

>враппер

Ну да, в других библиотеках по 20 уникальных алгоритмов обучения и моделей сети в каждой.

продолжаю читать Deep Learning и возникают вопросы про некоторые пассажи в книге, вот, например, кусок текста.

Каким боком мы начали говорить про гауссианы (из-за предположения, что ошибки распределены нормально)? Почему нас вообще парит его среднее?

Как я понимаю из просмотра cs231n и делания заданий, общая цель обучения (в постановке обучения с учителем) - сделать функцию, которая будет на заданных входах давать правильные классы, или как это изложено в книжке минимизировать ошибку в смысле cross entropy. Так причем тут гауссиан?

Ну ты выдал кусок текста без контекста, а нам теперь гадать.

> Каким боком мы начали говорить про гауссианы (из-за предположения, что ошибки распределены нормально)?

Логично, это самое частое предположение.

> Почему нас вообще парит его среднее?

Ещё ковариационная матрица обычно парит, ибо нормальное распределение задаётся двумя моментами.

> общая цель обучения (в постановке обучения с учителем) - сделать функцию, которая будет на заданных входах давать правильные классы

Может давать классы, а может действительные значения, как в регрессии.

> или как это изложено в книжке минимизировать ошибку в смысле cross entropy

> общая цель

Общая цель - подобрать параметры так, чтобы они давали максимум правдоподобия на данных, дальше в зависимости от задачи и допущениях о распределениях вытекают минимизируемые ошибки. Ну там на самом деле ещё риски рассматривают, MAP и постериоры над параметрами, но это потом

Классы тут нипричем, речь про регрессию же небось. x - вход, y - вектор на выходе, вещественный. В идеале ты бы хотел, зная вход x, получить не просто некое значение y, а распределение вероятностей по y при условии x, т.е. насколько вероятно любое значение y при данном x. Это полезно, т.к. в реальном мире в цене дома (y) есть элемент случайности, который не описывается целиком его площадью и чем там у тебя еще на входе есть (x) - и имея полное распределение вероятностей ты можешь четко понять какая может быть цена у дома.

Но это в идеале - на практике твой линейный юнит не выдаст тебе распределение вероятностей - а всего лишь некую его оценку, статистику. Самая полезная оценка самого простого предполагаемого распределения вероятностей - гаусса - это его матожидание.

Друзей, сваливших из параше-яндекса в bing. Как тебе такое, а?

Мы с тобой жопой читаем, у него там hidden layer.

>>924235

Смари сюда, кароч, у тебя на хводе какая-то ебала с ошибкой, которая там скорее всего распределена по нормальному закону и какой-то там дисперсией. У тебя слой линейный, а линейное преобразование нормальной ебалы - другая нормальная ебала, с нелинейным слоем такая хуйня не канает. Поэтому у тебя пока слои линейные, там будут гауссианы по ним ходить. Кросс-энтропия это про категориал уже, это потом покажут.

> математика/алгоритмы не нужны

Большая часть параши в шапке нахуй не сдалась для практического вката. Хотите дрочить эту хуйню и алгоритмы (какие, блять, конкретно, алгоритмов хуева тонна) сидя у мамки на шее или пописывая говносайтики - вперед.

Написано же linear output layers. Я почти уверен, что там речь именно о выходе регрессии с предположением что шум модели гауссов. Но я эту херню давно читал и открывать снова влом, сорян.

Значит я жопой читаю.

>Ну да, в других библиотеках по 20 уникальных алгоритмов обучения и моделей сети в каждой.

Ты не понял. Российская ИТ-компания, у которой даже название не российское, а какая-то хуйня. Из программных продуктов одна реклама под андроид, весь телефон засрали, заебался вилкой вычищать на тему МЛ - полтора враппера на гитхабе. При том, что теоретически какой-то исследовательский отдел присутствует, вон выше какую-то хуету цитировали. И на этом основании я должен поверить, что эта шарашка вообще может в МЛ.

>Что такое иррациональное число? Это просто те вещественные числа, которые не являются рациональными. Всё. Аксиоматика построена.

>Арифметика также утверждает, что порядок операций умножения и деления не имеет значения. Значит (1 / 3) 3 = (1 3) / 3 - так? А вот и ни фига.

В такое говно в 2017 я верить просто отказываюсь, это не заслуживает никакой критики абсолютно.

(1 / 3) x 3 = (1 x 3) / 3

https://ru.wikipedia.org/wiki/Десятичная_дробь#.D0.9D.D0.B5.D0.BE.D0.B4.D0.BD.D0.BE.D0.B7.D0.BD.D0.B0.D1.87.D0.BD.D0.BE.D1.81.D1.82.D1.8C_.D0.BF.D1.80.D0.B5.D0.B4.D1.81.D1.82.D0.B0.D0.B2.D0.BB.D0.B5.D0.BD.D0.B8.D1.8F_.D0.B2_.D0.B2.D0.B8.D0.B4.D0.B5_.D0.B4.D0.B5.D1.81.D1.8F.D1.82.D0.B8.D1.87.D0.BD.D0.BE.D0.B9_.D0.B4.D1.80.D0.BE.D0.B1.D0.B8

В math скинули вот эту ссыль, но этож тоже софистика уровня "ну ты понел"

Это не жир блядь, я реально интересуюсь. Ещё один долбоёб, решивший что это жир - здравствуй

>создадим две параллельных вселенные, где у нас А равно одному и тому же значению. Равно ли А самому себе в другой вселенной?

И это тоже нихуя не жир. Куда мне обращаться с этими вопросами вообще? Ведь они чисто кэповские, и "жир" потому что "ну ты же знаешь что это жир", так чтоли?

Да похуй мне на сци. Сци - один большой зашквар.

https://www.reddit.com/r/mathematics/comments/5rlzcx/please_tell_me_where_can_i_find_answers_to_this/

Перекат короче. Хоть повод появился регнуться на реддите

Я писал сразу в обоих т.к у меня не особо много времени ждать ответ, но видимо придётся подождать. Как ты заметил - >>924597 здесь уже сообщено о разделе math

0.(9) - ровно единица, ни больше, ни меньше.

1 / 3 = 0.(3)

0.(3) 3 = 0.(9)

1 / 3 3 = 1

=> 1 = 0.(9)

4) All numbers that are not rational are irrational numbers. Really? Binary logic in 2017? Is there any alternative to "rational" or "irrational"? Any kind of meta-rational numbers maybe?

Короче исходя из этой блядской параши я считаю что

1/3 is metaraional number for 0.(3)

Не. ну серьёзно, мне где об этом спрашивать? Я же не мог тут велосипеднуть внезапно

>ну оно равно единице, ну чо ты. Равно же!" - не кат

Ну ты и пидорас, если тебе моё док-во не понравилось, окей, давай рассмотрим другое

Ряд 9 умножить 10^(-k), k от 1 до +inf.(0,9 + 0,09 + 0,009 ...) Это сумма бесконечно убывающей геометрической прогрессии. Можешь посмотреть школьную формулу , подставить величины И УБЕДИТЬСЯ ЧТО ТАМ ЕДИНИЦА

Не, меня это не убеждает. Машине неведома бесконечность вследствие переполнения буфера. В то время как 1/3 выглядит совершенно рациональной хернёй - 0.(3) выглядит полностью иррациональным говном для аутистов.

>Машине неведома бесконечность

Зато ведома аппроксимация. 0.9999999 - это аппроксимация единицы, такое число классификатор и отнесет к единице, а не к нулю, 0.5 и т.д. А теперь уебывай.

Приближения и наука - никак не связанные вещи. Это лишь костыль, который помогает в аутотренинге что "всё заебись", но на самом деле это остаётся лишь костылём. Очень пиздецовым костылём. Причём в самом начале вычислений.

>Приближения и наука - никак не связанные вещи.

Зато приближение - это суть МЛ, мягких вычислений. А это - МЛ-тред.

Я тебе привёл строгое математическое доказательство с рядом. Дело в том, что, когда появляется мат. доказательство споры уже неуместны. Ты пытаешься рассуждать над цифрами не с точки зрения математической науки, а с точки зрения ссаной машины Тьюринга.

Как повысишь точность без повышения количества слоёв до охулиарда - приходи, поговорим

нейронные_сети_слои_сравнение_статистика_клоун.жпг (не нашёл за нескольки минут пик)

>>924683

>математика без вычислимости

>наука

Я всё понял, подожду чьего-нибудь другого ответа.

А это простейший пример не вычислимости. Даже 1/3 - нихуя не вычисляемая штука. Терабайт оперативки. Эксабайт. Машине похуй. Можно сделать костыль - но это будет лишь костыль. Костыли - это охуенная олимпиада, конечно, но я, пожалуй, от неё откажусь.

>нейронные_сети_слои_сравнение_статистика_клоун.жпг (не нашёл за нескольки минут пик)

Сам же и ответил на свою претензию. Да, теория статистического обучения как раз об этом, как повысит точность не асимптотически (охулиардом слоев), а правильно ставя и решая задачу обучения.

Так я вроде её и ставлю её нормально, разве это не проблема современной науки?, что там костыль ебанули, потом далее, ещё пару костылей, а потом все "почему-то" охуевают чего это всё в конце по швам трещит

оп, Theano, TF это понятно. Непонятно почему ты решил, что внимания стоит монструозный жрущий TF, который в бенчмарках совсем не блещет и вообще был унылым говном до определенного времени. Где keras, где промышленный deeplearning4j, где наконец всея нагибатор Torch, которые не просто сделан пряморукими людьми (в отличие от параши Theano) достаточно просто посмотреть на исходный код GRU модуля, чтобы у тебя встал.

Где основа основ -- ML курс от Стенфорда?

С его вкатывание как раз и надо начинать, а не с книг по 500 стр.

Еще один думает, что TF это обычная пистонопараша для модного у школьников диплернинга.

Сообщу нихуя не поддерживаемое никем мнение. Нет ничего жрущего или нет. Есть только то за что ты получишь в итоге бабло, а за что ты получшишь лишь в еблище или тебя пизданут на мороз

или то*

Ебашим вместе с подругой нвидией всё на кофе на крестах, рвем все бенчмарки и ссым в лицо фреймворкам для даунов.

только вот школьники что-то совсем не юзают его:)

ну а если серьезно, TF скорее для офисных червей, которые работают работу и зарабатывают зарплату и вполне естественно, что в /pr на него дрочат. Но раз уж тред по ML, а не про TF, то и обсуждать лучше плюсы минусы всех библиотек.

Все, что не поддерживает и пистон и кресты идет нахуй сразу. Особенно всякая lua параша (это ж надо было придумать юзать неподдерживаемое говно, а).

А почему под виндой-то? И почему под виндой должно быть медленнее, лалс? А, я понял, потому что нитакие школьники угорают по МААМ МААМ ЛИНУПС ЭТА КРУТА!!111.

Во многом благодаря "луа параше" офисные черви вообще узнали, что такое дип лернинг. Науч. статьи совсем не читаем, да?

Torch первый релиз в 2002 и именно его юзали Deep Mind и сейчас продолжает Facebook, NVIDIA. Theano первый в 2009, университетский проект, т.е. части кода писались всякими практикантами и пхд студотой скорее всего, что как-бы намекает. И поэтому промолчим про качество кода в Theano.

И да, пистон сосет у lua если что, и соответственно Theano сосет у Torch.

Ну и вот немножечко бенчмарков вам для повышения ЧСВ.

https://github.com/glample/rnn-benchmarks

ну про скорость это ты додумал (интересно почему).

Это было к тому, что под виндой, где нет нормальных средств для разработки, а я имею в виду, нормальные редства разработки, а не ваши отмазки и костыли ни один уважающий себя кун не будет в r&d.

Заранее прошу прощения у сишарпов и с++ для которых заботливая MS слабала отличную VS у кучу других костылей.

> нормальные редства разработки, а не ваши отмазки и костыли ни один уважающий себя кун не будет в r&d.

Ну-ка ну-ка поясни за средства разработки, мне аж прям интересно стало. Сам на чем ML делаешь? Чего под винду нет?

Там рассказывается про виды выходных нейронов, их выбор зависит от того, что тебе удобнее получать на выходе в конкретной задачe.

Линейные выходы(без функции активации) подходят для задач регрессии, сигмоида для классификации 1/0,

Нормальность распределения предполагается во всех методах, использующих метод максимального правдоподобия, об этом страниц пять назад в твоей книжке написаною.

>>924260

>>924247

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

>е нахуй не сдалась для практического вката

Бред написан дичайший, а потом

>Большая часть параши в шапке нахуй не сдалась для практического вката

Как бы вся суть. И это притом, что в книжке страниц пять назад написано:

>Previously, we saw that the equivalence between

maximum likelihood estimation with an output distribution and minimization of

mean squared error holds for a linear model, but in fact, the equivalence holds

regardless of the f ( x ; θ ) used to predict the mean of the Gaussian.

An advantage of this approach of deriving the cost function from maximum

likelihood is that it removes the burden of designing cost functions for each model.

Specifying a model p (y | x ) automatically determines a cost function log p(y | x ).

Просто ёбаные дауны, то есть тут даже читать без толку, один хуй всё вылетает.

>Большая часть параши в шапке нахуй не сдалась для практического вката.

>ШАД шарага))0))0 а я умныыыый)0)0

Пиздец какой.

нужен бишоп/маккай

Чё за гудфеллоу? Нихуя не въехал.

Один жопой читает книги, половину не понимая, другой несёт хуйню шизофазийную из того, что где-то когда-то услышал, гаусианы у него по слоям ходят, третий фантазёр, на ходу под ответ компилирует, в цене дома элемент случайности, будто на экзамене троечник.

> Но я эту херню давно читал и открывать снова влом, сорян.

Ну и довершает всю эту картину вишенка

>Большая часть параши в шапке нахуй не сдалась для практического вката. Хотите дрочить эту хуйню

Антракт.Ёбаный пиздец. Вы же вообще не понимаете, что делаете. То есть вообще. А от прочитанных книг только ещё большая каша становится, потому что базовых понятий нет/они неверные.

А потом такой скроллишь вверх,а в шапке

>шад)))

Нет там ничего ML-специфичного, знание матана и теорвера на уровне заборостроительного вуза

Просто мммаксимум долбоёбы. Ебать у вас тут загон.

> повысишь точность

Зачем? 0.(3),1/3 куда точнее-то? Давай тогда вместо pi или e по 1000 символов писать.

Ну и вали нахуй урод, хули ты тут забыл?

The bias–variance decomposition is a way of analyzing a learning algorithm's expected generalization error with respect to a particular problem as a sum of three terms, the bias, variance, and a quantity called the irreducible error, resulting from noise in the problem itself.

В цене дома у него не может быть случайности.

Стоит ли в шапку добавлять?

там уже есть "курс от китаёзы"

бенчмарки не читаем, ты же не думаешь, что я настолько дурачок и буду сравнивать доступность библиотек.

да это просто доп. информация, абы знал для чего еще. На твоем месте я бы прошел stanford ML coursera курс.

лондан из зе кепитал оф грейт британ, уровень каждого первого российского погромиста. На их месте я бы не Bishop-а читал, а учил язык лол

двачую адеквата, долбоебам, которые решили вкатится для начала надо закончить курсеру и только потом пробовать в книги. Блядь, но нет, тут же каждый в поле агроном.

Ты настолько дурачок, чтобы выбирать DL либу по бенчмаркам? В которых нет половины DL либ и бенчмарк только по рекурсивкам, лол. Еще один диванный теоретик.

ну я знаю, что выбирать, т.к. пишу дисер по рекурсивкам. И собственно тон выбрал, чтобы потроллить немного борду и растрести нормальных кунов. Естественно, нет лучшей либы, все под свои задачи. Но шапка требует доработки, т.к. куча полезных и нужных фреймволков отсутствует вообще.

Опа-опа чё за дисер? Согласен ли ты что существующие рекурсивки (LSTM) - костыльное говнище? Что думаешь за neural turing machines?

линк: https://www.google.de/url?sa=t&rct=j&q=&esrc=s&source=web&cd=1&cad=rja&uact=8&ved=0ahUKEwjavKrF-_HRAhXJLsAKHZ3FDOwQFggaMAA&url=http://cs231n.stanford.edu/slides/winter1516_lecture12.pdf&usg=AFQjCNEruVeYhkzWmcZ2N8k-rpUHHAITYA&sig2=So34QvPzJ1NlXACB4YAfmA&bvm=bv.146073913,d.ZGg

ну вообще вопрос не совсем корректный? тут дело не в том как ты процессишь свой hidden layer вообще, т.е. не в LSTM дело. Как говорил Микола, главное это ваш корпус, фичи и настройки параметров.

Про тюренговые машинс увы я тебе ничего не скажу. Надо скачала почитать статьи по ним.

да, и что-то я не понял про LSTM, они outperform все что только можно на данный момент. Чем ты недоволен?

Тем, что это просто квинтэссенция костыльной архитектуры с костылем на костыле? Одна зависимость от временного масштаба чего стоит (забывает все нахрен если частота данных большая) - и ради того, чтобы это побороть наворачивают еще костылей - гейты, которые открываются каждые K, 2K, 4K временных шагов и т.д. (влом искать статью, на прошлом семчике в ИППИ было). Просто пиздец.

То же самое со сверточными сетками, которые могут в трансляцию, но внезапно не могут в поворот и другие симметрии. Хотя казалось бы одна хуйня.

Но и там и там народ пытается придумать что-то нормальное - для симметрий Домингос придумал deep symmetry networks, для нормальной памяти - neural turing machines.

И вообще надо давно пробовать полноценные дифференцируемые программы, а не 2.5 костыля как LSTM, Колмогоровская сложность же. Попробуй заставить твой LSTM отсортировать массив, вперед.

> neural turing machines

Если в двух словах, то это нейросеть, которая помимо своего основного режима способна выполнять обычный код?

Ок, знаток, спасибо за твой резкий, но информативный ответ. Можешь пояснить, почему мы выбираем гауссиан как p_model?

Я знаю английский где-то между Advanced и Proficiency, проблема не в языке, а в некотором грузе нотации + математики, тот же cs231n с course notes значительно легче воспринимается вероятно из-за формата и большей ориентированности на практику.

>>924897

>>924891

Я прошел курс, но не сказать, чтобы он дал много понимания. Да, смогу тебе зафитить и регрессию и деревья скорее всего под датасет, что теперь больше знать ничего не надо?

ну по сравнению с ванильной RNN, которая похоронила все надежды на "успех" в свое время, LSTM был прорывом и благодаря именно этой архитектуре интерес к рекаррентам воскрес и сейчас мы пожинаем плоды этого "интереса" (в виде вот таких вот трололо тредов).

Конечно, одной лишь "забавной" архитектурой ты не решишь все проблемы. Другое дело, что создать что-то более менее хорошо работающее даже с LSTM далеко не так просто как кажется.

У LSTM была задача решить проблему исчезающего градиента (vanishing gradient). Они с ней справились.

Почитай еще про Highway networks -- классические FFNN только с прикрученными гейтами. Тоже ниче, успешно применяются. Гейты рулят на самом деле. Более того, зачем ебать мозг куда более сложными архитектурами, если подборка толкового корпуса и настройка параметров всегда и дешевле, и быстрее в результате.

Ну а в сравнение с представленными тобой решениями, LSTM смотрятся теоретически слабо. Но это просто ступень.

ну вот, молодца.

ну текст, который ты вывалил выглядит нормальным, хотя предложение, соглашусь, длинноватое для восприятия без перечитки.

Ты почитай дедушку Эльмана например, вот там пиздец.

Когда я не понимаю о чем речь это скорее всего от недостатка математического бекграунда. Тогда я начинаю гуглить и читать смежные темы. Да долго, но зато разбираешься.

>То же самое со сверточными сетками, которые могут в трансляцию, но внезапно не могут в поворот и другие симметрии.

Как будто ты можешь.

Так как пользуемся методом максимального правдоподобия для обучения сети, а он асимптотически нормален, то есть его распределение аппроксимируется нормальным распределением, которое N(y;y,I). Во втором случае мы тоже пользуемся методом максимального правдоподобия, но теперь у нас классификация, потому используется распределение Бернулли( которое есть биномиальное с н=1, которое при

больших n также нормальное).

>>Previously, we saw that the equivalence between

maximum likelihood estimation with an output distribution and minimization of

mean squared error holds for a linear model, but in fact, the equivalence holds

regardless of the f ( x ; θ ) used to predict the mean of the Gaussian.

An advantage of this approach of deriving the cost function from maximum

likelihood is that it removes the burden of designing cost functions for each model.

Specifying a model p (y | x ) automatically determines a cost function log p(y | x ).

О чём он тебе и говорит, до этого ты строил линейную регрессию с mean square error в качестве функции потерь, в итоге твои точки почти все лежали на получившейся линии. А теперь, говорит он тебе, посмотри внимательно, что ты сделал. Mean square error по-русски дисперсия, то есть разброс относительно матожидания, ну и ты его минимизировал и получил ровную линию. Дык вот, говорит нам автор,нам удалось получить соответствие между предсказанными и исходными значениями при помощи минимизацией дисперсии не потому, что наша модель линейна , а потому, что мы предполагали, что наша величина распределена нормально. Она не распределена нормально, мы предполагаем, что она распрелена нормально и на этом предположении строим приближение.

Блядь, почему p-model? p(y|x), условная вероятность, p-model не обязательно нормальное, Бернулли в регрессии, например.

А, лол, это и есть p(y|x). Нужна регрессия берёшь нормальное, нужна классификация берёшь Бернулли. По сути это одно и то же, хотя не совсем, вот биномиальное и Бернулли одно и то же, частный случай для n=1, а тут просто на больших n (вроде больше 30)как нормаальное себя ведёт по центральной предельной т еоремееею.

>Нужна регрессия берёшь

Линейный выходной слой.

> нужна классификация берёшь

Сигмоиду.

Та\м об этом параграф в общем.

>это и есть p(y|x

Точнее матожидание, которое хотели получить. Вот, кстати, c этого тогда проорал:

> В идеале ты бы хотел, зная вход x, получить не просто некое значение y, а распределение вероятностей по y при условии x, т.е. насколько вероятно любое значение y при данном x. Это полезно, т.к. в реальном мире в цене дома (y) есть элемент случайности,

Внимание, правильный ответ:

>Instead of learning a full probability distribution p(y | x ;θ) we often want to learn just one conditional statistic of y given x .

Сука, ну с точностью наоборот! Чё там? Агаа, офэн мин, ну бля, видимо короче хотелось бы всё взять, а получается тока среднее и дааавай хуярить истории охуительные про полезность элементов случайности, не описывающихся площадью, аааа. Нахуя вы этим занимаетесь, понять не могу, если вам это не интересно.

>ну с точностью наоборот

Просто типа какой смысл? Испорченный телефон по итогу, хоть 200 книг толстых прочитай, даже ещё хуже станет. Надо либо нормально заниматься, прежде всего математикой, просто чтобы понимать, что ты хоть делаешь, а не ВНУТРЕ У НЕЙ НЕЙРОНКА))0)либо не страдать хуйнёй, пизда, температура, умираю, нахъуй, походу скорую вызывать надо, зуб ебучий мудрости неделю уже охуеваю. Короче, не страдайте вы хуйнёй. Я кончил.

>Точнее матожидание

Точнее условная вероятность, лол.

https://en.wikipedia.org/wiki/Multivariate_normal_distribution

>Mean square error по-русски дисперсия

>>925168

> Mean square error по-русски дисперсия

F{F{F{F{{F{{F{FАСХХАХАХААЪАЪАЪ КААААРА ХАХАХАХАХУХУХХУХАХАХ >>925179

>очнее условная вероятность, лол.

>>925179

>>Точнее матожидание

>Точнее условная вероятность, лол.

>>925178

>>ну с точностью наоборот

>Просто типа какой смысл? Испорченный телефон по итогу, хоть 200 книг толстых прочитай, даже ещё хуже станет. Надо либо нормально заниматься, прежде всего математикой, просто чтобы понимать, что ты хоть делаешь, а не ВНУТРЕ У НЕЙ НЕЙРОНКА))0)либо не страдать хуйнёй, пизда,

УХХАХАХАХХАХАХАХУХХА ЕБАТЬ Я ДАААУН АААААААААААА ААА_+А++А+А+А++АААХАХАХАХА

Мораль: прежде, чем копировать с вики нужно тщательно перепроверять соответствие терминов. Мда, вот так слив.

Тоже пробовал, сложно узнавать людей вверх ногами

2. И есть ли какая-то логика, что оперирует временем, временными отношения и таким подобным? То есть, разработано ли некое формальное представление времени в формальной логической системе. Хотелось бы что-то вида деления на настоящее время и "вероятное", а во втором возможность использовать ту же нечеткую логику и теорию свидетельств. Хотя, может кто-то сделал намного лучше и логичнее.

доброе утро! уже давно так и делают

нейроночки и аппаратно реализируются - у АМД процах бранч предиктор на нейроночках

1. Пилю самоорганизующуюся карту Кохонена. Возник вопрос по алгоритму: зачем вводится элемент случайности при выборе элемента для представления его карте, что будет, если тупо итеративно скармливать системе весь датасет;

2. Хорошо разобрался в нечетких машинах вывода Мамдани-Заде, они моделируют мышление человека,но не понимаю смысловой подоплеки в машинах вывода Сугено, посоветуйте статейку, желательно со сравнением первого со вторым.

1) Случайная инициализация опорных векторов - один из возможных вариантов инициализации опорных векторов. Суть в том, что даже если их задать рандомно, в итоге все сходится к оптимальному представлению опорными векторами входных данных.

2) Отличие вывода Сугено от Мамдани в дефаззификации. В модели Мамдани результирующее множество представляется в виде единственного четкого значения методами вычисления центроидов и т.д., оператор Сугено - получение единственного значения из нескольких заданных правилами синглтонов (пик2) или линейных функций (гомогенных или аффинных, пик1 - аффинные). Суть в том, что этот метод гораздо проще с вычислительной точки зрения, ну есть еще плюсы. Самая нормальная статья, внезапно оригинальный пейпер Такаги и Сугено, но там авторы сами в своей нотации запутались и знатно накосячили в некоторых формулах, исправленный вариант на пике1.

1. Ты не понял, я имею ввиду не инциализацию начальных значений весов, с этим я разобрался. Я имею ввиду требование случайного порядка обхода датасета в течении одной эпохи, почему нельзя просто обходить датасет в его естественном порядке? Просто я реализовывал k-means и СLOPE, и там не было такого требования, и, вообше, было бы удобно использовать курсор базы данных и прочие итераторы.

2. Про Сугено спасибо, буду разбираться.

>>925712

>Я имею ввиду требование случайного порядка обхода датасета в течении одной эпохи, почему нельзя просто обходить датасет в его естественном порядке?

Почему нельзя, можно. Просто ты говоришь о стохастическом варианте SOM, в идеале его иллюстрируют именно так - от балды берутся значения опорных векторов и элементы датасета. Если их брать один за другим - это не изменит ничего, т.к. функция плотности вероятности, заданная на датасете от этого не изменится и в итоге точно так же аппроксимируется опорными векторами.

>функция плотности вероятности, заданная на датасете от этого не изменится и в итоге точно так же аппроксимируется опорными векторами.

Точно?

Если сет огромен и в память не влезает, то альтернатив-то и нет.

Конечно. Датасет один и тот жи, опорные векторы одни и те же. Какая разница, в каком порядке сравнивать строки датасета с опорными векторами? Там важнее само количество предьявлений, достаточное для сходимости.

>Какая разница, в каком порядке сравнивать

А разве не будет разницы? Например, если мы будем каждый раз извлекать максимум, то получим вот такое распределение. Или это не играет роли? Или я хз.

>А разве не будет разницы?

Откуда там будет разница? Суть-то в чем: берется вектор из датасета, для него находится лучший (с минимальным евклидовым расстоянием от него) опорный вектор, который обновляется по соотв. правилу. В каком порядке не бери векторы датасета, все равно каждый из них будет обновлять наиболее подходящий для себя опорный вектор. Важно только количество предъявлений, чтобы в итоге все опорные векторы соответствовали датасету, в т.ч. аппроксимировали плотность вероятности, имеющуюся на нем.

Ясно.

Глянь вот эту книжку http://bookzz.org/book/460672/dd566b главу про SOM, там есть простой численный пример,прямо на пальцах показано как все считается и сходится.

>что будет, если тупо итеративно скармливать

>Depending on the implementations, t can scan the training data set systematically (t is 0, 1, 2...T-1, then repeat, T being the training sample's size), be randomly drawn from the data set (bootstrap sampling), or implement some other sampling method (such as jackknifing).

Ничего, зависит от реализации. Хотя, наверняка это как-то влияет на результат.

>It has turned out in practice that ordered cyclic application of the available samples is not noticeably worse than the other, statistically stringent sampling methods.

Даже вот так, получается, всегда можно применять.

всегда можно цикл юзать

Посраль смачно тебе в глотку.

Что за семинар? Может тоже похожу

Со вторым понятно, но первые откуда лезут7

Пользуясь случаем передаю привет мамке опа

реквестирую годную книгу по динамическим импульсным нейронным сетям похуй если нету - напишите её, лол

Это костыль. Костыли не нужны. Если костыль есть в такой коренной функции - то всё остальное не стоит и говна

И еще вопрос о образах. Как они хранятся в мозгу и в ИНС?

Восприятие: Как мозг переводит хаотичный поток нервных сигналов от органов чувств в целостную картину восприятия? Какие внутренние правила и закономерности регулируют этот сложный процесс? Как информация от разных органов чувств объединяется мозгом воедино?

Типа это кодирование есть нерешенная проблема нейробиологии?

Ну, а как это кодирование называется вообще? Есть ли термин? Хочу понять, как гуглить это.

Ну, и образы. Это тоже непонятно пока? А в ИНС это просто веса или как?

>А в мозгу человека, когда сигнал проходит от глаз в зрительную кору, он как-то переходит в абстрактную форму? Если да, то как она выглядит и как этот процесс называется? Я ведь вроде слышал, что у тех же хомячков можно подключить зрение к слуховой коре, а слух к зрительной коре и им будет нормально все.

>Как они хранятся в мозгу и в ИНС?

Насколько я понимаю обычно это матрица весов, типа ничего общего, НО! Пали вот тут! пали >>923341

https://www.researchgate.net/publication/257392356_A_novel_image_encryptiondecryption_scheme_based_on_chaotic_neural_networks

Короче, есть типа класс сетей непопулярный, который как модели юзает динамические

системы, типа наш мозг тоже такая система,

ВО, цени

Основная идея резервуарных вычислений заключается в использовании

рекуррентной нейронной сети как резервуара с богатой динамикой и мощ-

ными вычислительными возможностями. При этом резервуар формируется

случайным образом, что исключает необходимость проводить его обуче-

ние. При подаче на вход резервуара непрерывного сигнала он попадает в

определенный динамический режим или состояние. Это состояние зависит

от входного сигнала. Резервуар формируется таким образом, чтобы для

похожих входных сигналов это состояние было похожим, а для разных –

разным. Выход резервуара соединен со специальными устройствами – счи-

тывателями, которые по состоянию резервуара решают поставленную за-

дачу – производят классификацию, предсказание, кластеризацию. В каче-

стве считывателей могут использоваться статические обучающие машины

с простыми алгоритмами обучения. Таким образом, резервуар интегрирует

в своем состоянии динамику входного образа, а считыватели по состоянию

резервуара распознают входной образ.

Один из разделов теории динамических систем связан с теорией хаоса

и синергетикой. В хаотической динамике рождаются структуры под дей-

ствием внешних возмущений, и она изначально может содержать все мно-

жество возможных вариантов. Хаотические системы позволяют выйти на

следующий уровень обобщения и расширить возможности вычислений од-

новременно над целым множеством вариантов, причем это множество будет

формироваться под воздействием внешних сигналов и тем самым обеспечи-

вать адекватную сложность. Во многом это похоже на парадигму, исполь-

зуемую в квантовых вычислениях, в этом случае до момента считывания

ответа содержится все множество вариантов решений

А на той пикче короче снимок электромагнитный типа энцефалгораммма мозга крысы, и там типа аттрактор по форме. В общем будто такой колебательный контур, колторый тпринимает форму определённую в зависимости от среды, куда его помесятт. Круто пиздец. Ну и ещё там есть два режима работы: периодический и хаотический, смысл типа в том, что в такой системе можно один маленький параметр изменить и оно как домино свой режим работы сменит, на этом там память сделали, а ещё где-то там тоже были исследования, что наше внимание так работает, и что с нарушением закона динамики или как то так связаны эпилептические припадки

Короче, анон, я объебался спидами и вот так тоже случайно сюда забрёл, в итоге уже почти неделю не сплю, гуглю какие то статьи, английский не знаю не хуя, но каким-тоо хуем читаю, понимаю че там написнао, типа как тоже хаотическая сеть, крыша едет пиздец, похзоду словил серотониновый синдром, пожрать пытался сразу дристать иду, иллюзия температуры лютая, оказалось 36 6, кажется будто зуб болит и щёки распухди, к стоматологу пришёл, у меня всё норм, это я проходжу сам шёки схъед, но зракам пизда в стоматологии охуел и на улице. Сегодня выбросил остатки, хоть бы хуже не было. Короче анон, это жёсткая темма, она тебя сожрёт, все эти нейроменные сети, китайцы очнеь дохуя работ сделали.

http://www.oalib.com/search?kw=chaotic+neural+network

Одни китайцы. Ещё на анонов агрился тут, казалось, что я типа всё понял, а они дауны,Ю потом перечитывал и это я даун, а потом опять они и так по кругу.

https://www.youtube.com/watch?v=ggpJkuN9eiM

>А в мозгу человека, когда сигнал проходит от глаз в зрительную кору, он как-то переходит в абстрактную форму? Если да, то как она выглядит и как этот процесс называется? Я ведь вроде слышал, что у тех же хомячков можно подключить зрение к слуховой коре, а слух к зрительной коре и им будет нормально все.

>Как они хранятся в мозгу и в ИНС?

Насколько я понимаю обычно это матрица весов, типа ничего общего, НО! Пали вот тут! пали >>923341

https://www.researchgate.net/publication/257392356_A_novel_image_encryptiondecryption_scheme_based_on_chaotic_neural_networks

Короче, есть типа класс сетей непопулярный, который как модели юзает динамические

системы, типа наш мозг тоже такая система,

ВО, цени

Основная идея резервуарных вычислений заключается в использовании

рекуррентной нейронной сети как резервуара с богатой динамикой и мощ-

ными вычислительными возможностями. При этом резервуар формируется

случайным образом, что исключает необходимость проводить его обуче-

ние. При подаче на вход резервуара непрерывного сигнала он попадает в

определенный динамический режим или состояние. Это состояние зависит

от входного сигнала. Резервуар формируется таким образом, чтобы для

похожих входных сигналов это состояние было похожим, а для разных –

разным. Выход резервуара соединен со специальными устройствами – счи-

тывателями, которые по состоянию резервуара решают поставленную за-

дачу – производят классификацию, предсказание, кластеризацию. В каче-

стве считывателей могут использоваться статические обучающие машины

с простыми алгоритмами обучения. Таким образом, резервуар интегрирует

в своем состоянии динамику входного образа, а считыватели по состоянию

резервуара распознают входной образ.

Один из разделов теории динамических систем связан с теорией хаоса

и синергетикой. В хаотической динамике рождаются структуры под дей-

ствием внешних возмущений, и она изначально может содержать все мно-

жество возможных вариантов. Хаотические системы позволяют выйти на

следующий уровень обобщения и расширить возможности вычислений од-

новременно над целым множеством вариантов, причем это множество будет

формироваться под воздействием внешних сигналов и тем самым обеспечи-

вать адекватную сложность. Во многом это похоже на парадигму, исполь-

зуемую в квантовых вычислениях, в этом случае до момента считывания

ответа содержится все множество вариантов решений

А на той пикче короче снимок электромагнитный типа энцефалгораммма мозга крысы, и там типа аттрактор по форме. В общем будто такой колебательный контур, колторый тпринимает форму определённую в зависимости от среды, куда его помесятт. Круто пиздец. Ну и ещё там есть два режима работы: периодический и хаотический, смысл типа в том, что в такой системе можно один маленький параметр изменить и оно как домино свой режим работы сменит, на этом там память сделали, а ещё где-то там тоже были исследования, что наше внимание так работает, и что с нарушением закона динамики или как то так связаны эпилептические припадки

Короче, анон, я объебался спидами и вот так тоже случайно сюда забрёл, в итоге уже почти неделю не сплю, гуглю какие то статьи, английский не знаю не хуя, но каким-тоо хуем читаю, понимаю че там написнао, типа как тоже хаотическая сеть, крыша едет пиздец, похзоду словил серотониновый синдром, пожрать пытался сразу дристать иду, иллюзия температуры лютая, оказалось 36 6, кажется будто зуб болит и щёки распухди, к стоматологу пришёл, у меня всё норм, это я проходжу сам шёки схъед, но зракам пизда в стоматологии охуел и на улице. Сегодня выбросил остатки, хоть бы хуже не было. Короче анон, это жёсткая темма, она тебя сожрёт, все эти нейроменные сети, китайцы очнеь дохуя работ сделали.

http://www.oalib.com/search?kw=chaotic+neural+network

Одни китайцы. Ещё на анонов агрился тут, казалось, что я типа всё понял, а они дауны,Ю потом перечитывал и это я даун, а потом опять они и так по кругу.

https://www.youtube.com/watch?v=ggpJkuN9eiM

ХОРОООШАЯ КРЫЫША ЛЕТАЕТ СААМАА И В САМЫЙ НИИЗ И В САМЫЕЕЕ ВЕРХАА ТРАЛИ ВАЛИ КРЫЫША ГДЕ ТЫ БУДЕШЬ ЗАВТРАА

Здесь говорят, что, например, свёрточная сеть учит представление(representation).

http://cyberleninka.ru/article/n/analiz-elektricheskoy-aktivnosti-golovnogo-mozga-pri-absans-epilepsii-prikladnye-aspekty-nelineynoy-dinamiki

https://ru.wikipedia.org/wiki/Синхронизация_(нейробиология)Ъ

http://nauchkor.ru/cloud_storage/documents/587d36765f1be77c40d58fcb.pdf

Вот навскидку, там информации дохуя и больше.

Дело в том, что есть разный взгляд на это дело, подавляющее большинство не занимается всякими сомнительными исследованиями и придерживается того, что сеть это некая матмодель/алгоритм, способный за счёт, например, последовательной минимизации ошибки решать конкретную околостатистическую задачу. То есть нейронные сети это не попытки создать электронный мозг, лол, там совсем другие задачи, это широчайший спектр методов автоматизации человеческой деятельности, просто название такое хайповое.

Но есть и вот такие ответвления, от них дух захватывает.

>а как это кодирование называется вообще? Есть ли термин?

Термина нет, как и кодирования, это не та область науки, за этим иди в нейробиологию,когнитивистику и тд

Не-не. Способ аппроксимации нелинейных функций и статистического вывода.

Вообще странно, что некоторые думают, что люди знаю как человек мыслит, лол.

>Как мозг переводит хаотичный поток нервных сигналов от органов чувств в целостную картину восприятия?

Насколько я понял за эту неделю мозг ничего не переводит, он и есть хаотичный поток! ПРикинь! То есть это такой морфящийся от внешних воздействий электромагнитный контур!

>Какие внутренние правила и закономерности регулируют этот сложный процесс?

Хуй знает, за этим иди в теорию динамических систем и тд, там пытаются отвечать на подобные вопросы. Я тут как-то угарнул, что мб наверняка один из атких законов/правил уравнение Шредингера, ну оно тип тоже хаогтическое всё такое)0)0

>Вообще странно, что некоторые думают, что люди знаю как человек мыслит, лол.

Пытаются ответить на вопрос как, сравнивают датчики импульсов, примеряют разные модели, а как же? Это же главный вопрос с начала времен! Приблизиться к тайне сознания!

Очень хотел скопировать, пускай даже не слишком осознанно твой стиль сообщения, но решил стереть. Писал о конце света Матроне 10 февраля из-за создания ИИ, приметах по белых пятная на ногтях, эффекте Буба-Куки, фоносемантика, о том, что последнее время многое обращаю на форму, вывожу какие-то геометрические объекты в мир, эйдетика, методичка советская, звук начал смешиваться, люди начали говорить несвойственными голосами, постоянное повторяющее дежавю напоминающее мое предсказание будущего или даже когда отличие возникло, что "если событие Z произошло после события Y, то не обязательно считать, что есмь Yгрек причина события Zет", что во многом и может быть началом человека, стараюсь использовать оба полушария, математика стала выводиться в виде мультиков с геометрическими формами разных геометрий, внутреннего диалога уже как несколько недель нет. И все это при том, что я ничего не употреблял. Вроде даже тебя разумею. Все так, вообще, запуталось, подарили мне браслет с Буддой, а ты пишешь о Агате Кристе и Кришне, что напоминает мозг в банке, но уж солипсизм не подходит. Все перемешалось и пытается в проецирования из одной области знания в другую.

>Не-не. Способ аппроксимации нелинейных функций и статистического вывода.

Ну сам по себе ценности он мало несёт, мало ли методов всяческих, имел ввиду, что МЛ очень прикладная область математики, по сути для каждого конкретного случая уникальное решение строится, типа большая зависимость от реальной задачи, хотя математика обычно довольно абстрактна, а тут всё суперконкретно, потому такие вопросы тут даже не стоят.

Мне кажеться, что этот язык есть музыкальный ключ к появлению ИИ. Тем более, если использовать семиричную систему счисления.

>Все перемешалось и пытается в проецирования из одной области знания в другую.

Точка бифуркации, друг мой, тонкая грань между тобой и мной стирается, режим работы мозга переходит в альтернативный, Y же вовсе не причина X, это условность, зависящая от того, откуда отсчитывать время, от смерти или от рождения, мне очень нравится концепция теории хаоса, пока ничего более ошеломляющего и правдоподобного не встречал. Огромное фазовое пространство ф пространстве в пространстве, несколько уравнений, аттрактор-гравитатор, все настройки соблюдены, ПУСК! НАЧАЛОСЬ! Невидимые, едва заметные течения гравитационных волн пронизывают всё вокруг, где-то образуется завихрение и возникает планета, а там волну из тысяч людей несёт к точке бифуркации, один случайны из них потом станет Князем, всю свою жизнь он будет думать, что он особенный и это его заслуга, так никогда и не узнав правды, а вон там очередное колебание, произошедшее тысячи лет назад повлекло мутацию растения, так появилась живая клетка, а вон там один из сперматозоидов достиг яйцеклетки.

Это такая игра, вроде пасьянса или домино вселенского масштаба, каждая константа должна быть вывереена, любое отклоноение повлечет за собой катастрофу спустя миллиарды лет и мир схлопнется, термин эффект бабочки оттуда же.

Бля, конечно, на саомм деле всё на порядки порядков сложнее, но такая концепция наиболее близка к реальности. Меня как отпустит я за математику засяду, хочу разбираться в этом.

https://www.youtube.com/watch?v=SRr-YgBIiCc

> оба полушария

> постоянное повторяющее дежавю напоминающее мое предсказание будущего

Феномен Баадера-Майнхоф (Baader-Meinhof phenomenon; frequency illusion/частотная иллюзия) — искажение человеческого мышления, заключающееся в том, что после того, как человек приобрел некую новую информацию, она, как ему кажется, начинает появляться повсюду.

Если предположить, что у некоторых сходных событий есть что-то вроде течения и если ты, скажем, как-то боком в этом информационном течении повернулся, то такие вещи вполне могут замечаться, другое дело,

Я даже не заметил, что там, вообще есть "т" и "ся".

>Вы заебали хуйню нести.

Блядь, мы понимаем, что в качестве

>Способ аппроксимации нелинейных функций и статистического вывода.

это всё хуета непрактичная, там на практике вообще очень мало можно сделать, до сих пор нет методов работы с чуть более сложными системами. Дай ты попиздеть о всяком сомнительном , что ж вы фашисты-прикладники такие все.

Что работает, то важно, остальное сжечь! Ересь!

У меня из-за спамфильтра пост порвался

>оба полушария

это про ту картинку типа, вообще, правда ведь ИРЛ системы с выраженными левыми и правыми центрами принятия решений наиболее устойчивы? Та же двухпартийная система в мурике, например. Да и много где ещё, борьба левого с правым это ж вообще концепция фундаментальная. Хотя, вроде как это миф на самом деле и у полушарий примерно одинаково распределены функции. Но всё равно прикольно.

С крокодилом поздороваться.

>это миф на самом деле и у полушарий примерно одинаково распределены функции.

Опять хуйня пошла. Нобелевский лауреат Сперри с тобой бы не согласился.