Это копия, сохраненная 5 декабря 2018 года.

Скачать тред: только с превью, с превью и прикрепленными файлами.

Второй вариант может долго скачиваться. Файлы будут только в живых или недавно утонувших тредах. Подробнее

Если вам полезен архив М.Двача, пожертвуйте на оплату сервера.

Продолжаем спрашивать очевидные вещи, о которых знает любой индус, прочитавший хоть одну книгу по машобу.

FAQ:

Я ничего не понимаю, что делать? Либо в тупую import slesarplow as sp по туториалам, либо идти изучать математику курсы MIT тебе в помощь. Не нужно засирать тред вопросами типа "что такое сигма?".

Какая математика используется? В основном линейная алгебра, теорвер и матстат, базовый матан calculus многих переменных.

Что почитать для вкатывания? http://www.deeplearningbook.org/ | Николенко и др. "Глубокое обучение" На русском, есть примеры, но уже охват материала

В чем практиковаться нубу? http://www.deeplearning.net/tutorial/ | https://www.hackerrank.com/domains/ai | https://github.com/pytorch/examples

Где набрать первый самостоятельный опыт? https://www.kaggle.com/ | http://mltrainings.ru/

Где работать? https://www.indeed.com/q-deep-learning-jobs.html

Где узнать последние новости? https://www.reddit.com/r/MachineLearning/ | http://www.datatau.com/ На реддите также есть хороший ФЭК для вкатывающихся

Где посмотреть последние статьи? http://www.arxiv-sanity.com/

Где ещё можно поговорить про анализ данных? http://ods.ai/

Нужно ли покупать видеокарту/дорогой пека? Если хочешь просто пощупать нейроночки или сделать курсовую, то можно обойтись облаком. Иначе выгоднее вложиться в 1080Ti или Titan X.

Список дедовских книг для серьёзных людей:

Trevor Hastie et al. "The Elements of Statistical Learning"

Vladimir N. Vapnik "The Nature of Statistical Learning Theory"

Christopher M. Bishop "Pattern Recognition and Machine Learning"

Взять можно тут: http://libgen.io/

Напоминание ньюфагам: немодифицированные персептроны и прочий мусор середины прошлого века действительно не работают на серьёзных задачах.

Архивач:

http://arhivach.cf/thread/396055/

Остальные в предыдущих тредах

Там же можно найти треды 2016-2017 гг. по поиску "machine learning" и "НЕЙРОНОЧКИ & МАШОБЧИК"

Предыдущий тред: >>1267390 (OP)

>А как же нейроны перцептроны, все вот это.

ты по верхам нахватался какой-то хуйни. ну нельзя сделать стол, если не понимаешь и не умеешь работать с деревом, инструментами и тд. так и тут.

У тебя какие-то абсурдные вопросы. Вот есть калькулятор, он тоже складывает, вычитает. Зачем вам компьютеры?

Перцептрон это последовательность многомерных линейных регрессий, связанных между собой через нелинейное преобразование

>Зачем вам компьютеры?

А зачем? С приходом компьютеров никакой промышленной революции не было, а вот деградация началась.

Level 2 - Always evaluating on test set.

Level 3 - Only using a test set when you're uncertain.

Level 4 - Knowing that you're good enough to not need a test set.

>Trevor Hastie et al. "The Elements of Statistical Learning"

Читал кто-нибудь? Мне кажется, он издевается над теми, кто пытается прочитать эту книжку самостоятельно. Почти за каждым знаком равно в любой формуле у него скрывается около страницы преобразований через свойства матожиданий и интегралов, а он даже никакими пояснениями не сопроваждает. Просто

>исходная формула

>= уже близкая к конечной промежуточная формула

>= конечная формула

Я должен ему верить на слово и пропускать или просто туповат и нормальным пацанам все очевидно, они раскрывают и преобразовавают за секунды в уме?

Общепринятая практика. Если это не какое-то новое исследование, то обходятся без выкладок, иначе книги были бы раза в полтора толще.

>Я должен ему верить на слово и пропускать

Хочешь - верь, не хочешь - проверяй.

>нормальным пацанам все очевидно

Смотря что. Большая часть хуйни про преобразования выветривается напрочь уже через год, после того как ты её в вузике надрочил.

Цитирую первую главу (Introduction):

>Who Should Read this Book

>We expect that the reader will have had at least one elementary course in statistics, covering basic topics including linear regression.

>As statisticians, our exposition will naturally reflect our backgrounds and areas of expertise.

>We expect that the reader will have had at least one elementary course in statistics

У нас в униче была статистика. И регрессия, и оценки параметров, и проверки гипотез. Проблем особо не было. Но если я взгляну на какую-нибудь из простых формул, то уже не вспомню, как мы ее выводили на семинаре. А тут еще сложнее, потому что не какие-то популярные свойства выводятся, а специальные формулы для определенных задач.

Ты туповат, потому что не умеешь абстрагироваться.

Представь себе обезьяну, которая видит в тексте что-то типа 31334*43434=1360960956 и начинает это всерьез проверять, и не может читать текст, не поняв, а почему 4х4 это 6 и 1 в уме.

Вывод формул это вообще последнее, что нужно в книжках.

Ну да, чтобы закончить мысль: важнее понимать, что значат цифры 31334 и 43434 в моем примере, а дальше поверить на слово про вывод и понять уже, что следует из 1360960956. Промежуточные этапы уже не нужны.

ну почти всегда от того что ты увидишь КАК произвели длинную цепочку преобразований с матрицами тебе легче не станет

очень хочется -- сядь сам их произведи, там ничего сложного не бывает, когда идею показали

535 Кб, 700x560

535 Кб, 700x560Попытался читать MIT'шную книгу Deep Learning на ангельском. Мой уровень B1-B2, но это ужасно долго выходит. На 5 страниц введения ушло 35 минут, так как раньше никакой литературы на английском не читал (пробовал Гарри Поттера от скуки, после страниц 10 забросил из-за недостатка прилагательных, коих в русском хоть голыми руками ешь).

Так вот вопрос. Вкатываться в дипльонинх особо не собираюсь, просто попробовать, лежит к этому душа или нет, так что во времени я не ограничен, но стоит ли начинать читать книги на чужом языке, прыгая прямо в машоб с головой? Может мне все же улучшить язык сперва, а потом уже переходить к таким вещам?

Пока читал, много раз ловил себя на мысли, что я перевожу целое предложение, и на это тратилось больше времени, чем когда я просто читал и думал на английском. Рефлекторно как-то оно выходило, когда встречал незнакомое слово и начинал его гуглтранслейтить. Может это через страниц 100 пропадет и я зря переживаю?

В общем дайте совет, чтобы я лишнее дело не делал, практика в английском посредством изучения машоба адекватное решение или я обосрусь и ничего не пойму?

>Мой уровень B1-B2

>никакой литературы на английском не читал

Не верю.

Читай через силу, постепенно снизойдёт. Я так учил в десятом классе

Ну я в далеком 2007 был слабым киберкотлетом и общался с англоязычным комьюнити на форумах и в тимспике. Потом на собеседованиях проходил тесты, которые давали, там и показало Upper-Intermediate. Так вот и получилось.

А по поводу художественной литературы ну очень не понравилось читать без родной описательной воды. Также часто читаешь, переводишь то, что непонятно, в словаре и думаешь: "Они сложили два слова и получилось новое, при том с другой, хоть и близкой, смысловой нагрузкой. И как мне это теперь понять, это далеко от привычного мне английский-хуиский, тут в разы сложнее конструкции."

Также этот геморрой с временами. Видел классный сайт (metod12.com), там алгоритмически расписано построение предложений англичанами, но на автомате я так делать никогда не умел, всю жизнь строил простые предложения и не мучал свои мозги, хотя это уже немного вдаль от моего вопроса.

И все же спасибо за ответ, постараюсь пересилить себя. Боюсь, что в начальных главах с математикой буду беспомощно болтыхаться, так как я её уже давно забыл, а каким образом её понимать на чужом языке я вообще понятия не имею.

Я только первую часть хотел прочесть, чтобы необходимые штуки из математики вспомнить/выучить. Дальше думал выбрать что-то другое. После того, как впитаю вышеуказанное, попробую следовать твоему совету, спасибо! Или лучше сразу пробовать cs231n?

Это что, наука? Нет, это пляски с бубном.

Что делать, если мне не нравится машинное обучение, а "классическое" программирование?

За машобом будущее, все остальные программисты очень скоро станут не нужны. И что же мне делать, если я не хочу заниматься машинным обучением?

> За машобом будущее, все остальные программисты очень скоро станут не нужны.

Бред же.

> И что же мне делать, если я не хочу заниматься машинным обучением?

Страдай.

>Это что, наука? Нет, это пляски с бубном.

Ой блядь, еще один верующий в науку, в непогрешимость и святых ученых, а сейчас людишки-то не те пошли. А потом появляются посты про "настоящие исследования", в которые ты не попадешь.

Наука так и устроена, прикинь. Вот блядь ровно так. Ты просто первый раз в жизни с ней столкнулся.

>Перцептрон это последовательность многомерных линейных регрессий, связанных между собой через нелинейное преобразование

Получается, сеть из перцептронов, это что то вроде полиномиальной регрессии?

Можешь привести пример там где используется линейная регрессия и полиноминальная и где нужны нейронки уже с их бэкпропом, а то я чет не понимаю.

>Что делать, если мне не нравится машинное обучение, а "классическое" программирование?

Рузге 100 балаф.

>Наука так и устроена, прикинь

Сейчас больше уклон в теоретику, профиты от этого матанопетушня давно пользует, а вот всякие физики относительно недавно.

> Получается, сеть из перцептронов, это что то вроде полиномиальной регрессии?

А каждый нейрон с двумя входами представляет частную функцию от полного полинома. Потому что полином любой степени можно представить через суперпозицию частных функций от двух переменных. Это ещё в 50е годы доказали Арнольд и Колмогоров. А теперь мне тут рассказывают про то, что современный машобчик это дохуя новые технологии. Да все это статистика максимум середины прошлого века.

Как это частная функция от полинома? Ведь как правило у нейрона просто функция активации, которая на выходе дает 0/1. Или ты про какие то другие функции нейрона без активации?

Я не понимаю как из нескольких нейронов можно сделать полиноминальную функцию.

>Получается, сеть из перцептронов, это что то вроде полиномиальной регрессии?

Нет.

Линейная регрессия - это

y=A x

У тебя есть набор входов x, набор выходов y и матрица (линейное преобразование), которая связывает вход с выходом. Задача по x и y найти A.

Полиномиальная регрессия это

y=A f(x), где f - функция вектор->вектор (возможно большей размерности), которая, что важно, не имеет внутренних параметров, которые мы настраиваем. Поэтому посчитав z=f(x), мы сводим нашу линейной регрессию к y=A z и считаем в два этапа, сначала, зная x, находим z, потом умножаем на матрицу и находим y. Если не понятно в обобщенном формате, вот на практике:

У тебя есть координаты точек x и y, ты можешь вычислить z1=x^0, z2=x^2, z3=x^3 и решать уже эту регрессию, как будто z1,z2,z3 и т. д. это точки в более многомерном пространстве.

Перцептрон - это

y=h(W1 h(W2 x) ), где h - это функция активации, W1, W2 - параметры, которые нам нужно найти.

1. Зачем нужна функция активации? Потому что без нее было бы y=W1 W2 x, а произведение матриц является матрицей, то есть y = A x, где A = W1 W2. Иными словами, персептрон без нелинейной функции между слоями не имеет смысла, это все та же линейная регрессия.

2. Как это говно обучать? Находить производную и спускаться градиентным спуском. Способ поиска производной называется бэкпропом и недалеко ушел от школьной формулы f(g(x))=f'(g(x))*g'(x)

То есть, отвечая на твой вопрос, если моделируемая тобой функция линейная, то ты используешь линейную регрессию, если сводима к линейной через вручную заданное преобразование входных координат - полиномиальную, а если ты не хочешь и самое преобразование задавать, то нужна нейронка, каждый слой которой как-то преобразовывает пространство, облегчая задачу для следующего слоя.

Вчитывайся в главное, пропускай несущественное.

Это местный шизик, не образай внимания.

или только перекатывальщики из разнорабочих?

Все с пхд, кроме тебя.

С Бишопа, конечно. Но там процентов 80 уже устарело и не нужно, ты вряд ли сумеешь понять что актуально, а что нет. Да и фиг с ним - читай все, знания лишними не будут.

Да говори уж правду, что там устарело все да и машоб ваш нихуя не работает кроме негров и котиков.

Трафик - он же в оптоволокне. Как машина может ехать в оптоволокне, она же слишком большая, а волокно жесткое? Не говоря уже о том, что трафик это световые импульсы в волокне, в которых вообще непонятно как можно ехать.

>ехать в оптоволокне

ты знаешь о чем я, но вот опять несешь хуйню. Давай тогда о НЛП поговорим?

>Наука так и устроена

Поправочка: так устроены хуёвые науки, служащие просто для отращивания хирша ораве дармоедов на деньги налогоплательщиков. Если их убрать, человечество не проиграет.

Ты зашел в противоположную крайность. Тяжело следовать твоему совету, когда в уме связь между двумя выражениями, записанными через равно, не прослеживается.

Впрочем, я не хочу продолжать этот дискурс. Я искал в интернете вывод некоторых формул. Они нетривиальные и часто помимо применения свойств матожидания/матриц/интегралов содержат банальные, но хитрые арифметические фокусы, сводящие их к виду, в котором эти свойства можно применить. То есть если читать их в раскрытом виде, все просто и понятно, но они изначально не были рассчитаны на анализ читателем и понимание.

Вполне возможно, что тебе просто не хватает опыта, и очевидное для всех преобразование уровня sinx^2 + cosx^2 = 1 тебя ставит в тупик, потому что тебе надо его выводить из определения синуса и косинуса, потому что ты ничего не знаешь.

> С Бишопа, конечно. Но там процентов 80 уже устарело и не нужно,

Что там может устареть, свидетель сойбоев?

Ага, ненастоящий шотландец. Нет, все науки так устроены.

Там, где наука устроена не так, например, изобретен какой-то нетривиальный метод, типа открытия таблицы Менделеева, случается быстрая революция, но после этого все опять возвращается к случайному поиску, на которых кладут жизнь phd.

Просто и понятно что? Ты, кажется, не понимаешь смысл формул. Формулы нужны тебе, не чтобы понимать их вывод. Более того, иногда даже саму формулу помнить не нужно. Достаточно помнить, что есть способ, что она есть, ее вход и ее выход. Точно так же, как в программировании - если бы я читал исходники всех библиотек, которым я пользовался, я бы охуел с сомнительным итогом.

Я полистал эту книжку, мне не понравилась, потому что мало того, что помогает интуиции. Слишком сжато. Лучше взять книжку по каждой теме и почитать отдельно.

Ну это примерно как судить о музыке по битлз, что вот есть звезды, они двигают науку, про них фильмы снимают. А остальные не нужны, их же никто не слушает.

Не от большого ума.

Ну ок, что там толпы ученых-говноедов революционного понаоткрывали то за последнее время?

Как?

>Ага, ненастоящий шотландец. Нет, все науки так устроены.

Скорее угандиец, который претендует на то чтобы называться шотландцем.

"Так" это с одним и тем же процентом карьеристов марающих бумагу бесполезной ерундой, которую никто никогда не прочитает кроме рецензентов? Это неправда, процент везде разный: например, в гендер стадис и в машобе таких людей в разы больше чем в топологической k-теории или физике лазеров.

>"Так" это

Нет. Так - это когда множество ученых работает над тем, чтобы улучшить результат на процент, в том числе (и в основном) нелюбимым тобой методом проб и ошибок. Потому что если бы у них в руках был другой метод, они бы его использовали и случилась революция. Но для революции нужен набор накопленных фактов, революции на пустом месте не появляются.

>например, в гендер стадис и в машобе таких людей в разы больше чем в топологической k-теории или физике лазеров.

Ты просто веруешь в это.

>множество ученых работает

Эти хуеплеты природу магнетизма и заряда уже выяснили, или продолжают нести дичь?

Ты как-то слишком серъёзно всю эту куновскую историю воспринял, на деле же успех этого твоего "метода проб" зависит от изначальной разумности всей этой деятельности.

>Ты просто веруешь в это.

Проверяется наблюдением за носителями.

Так вот подскажите, пожалуйста, если обратиться к какому-нибудь наемному программисту по машинному обучению для создания научной статьи, то сколько будет, примерно, стоить час работы такого умельца?

P.S. Сам я хуй знает, но думаю за 10 часов такой умелец должен управиться. Ибо результаты он может даже из головы взять, главное чтобы они были хоть немного похожи на правду для старых МухГУшников.

Логично, что нет, чо за хуета вообще, в датасаенс нельзя вкатиться, не проучившись 4 года в мгу/мфти/вше/спбгу

Поэтому срочно бросайте ваши шараги и всеми силами стремитесь поступить в топы

Фууу, шаражник.

У нас на работе таких очень сильно не любят. Практически весь коллектив закончил МГУ/МФТИ/ВШЭ, а к таким как ты очень презрительно относятся.

>а остальное ерунда, тьфу, было бы кого бояться

Ну уж нет, лол. Когда в коллективе к тебе относятся как говну, не очень приятно, согласись.

А тут ребятки все в основном учились в топовых физматшколах, а потом в топвузах, поэтому у них и чсв не хилое. Я сам шаражник, попал в такую контору дс, так меня травили в коллективе просто не из-за чего, называли тупым и всячески оскорбляли.

>травили

>называли тупым

>всячески оскорбляли

>все в основном учились в топовых физматшколах, а потом в топвузах

Святая толстота.

Да ладно, это ты просто успешных альфачей математиков не видел.

У нас трое таких было. Один вообще при этом был спортсменом и спокойно мог прописать в ебыч кому угодно, тянки к нему липли как мухи. И при этом еще успешно выступал на олимпиадах по математике, которые ему потом дали льготу на поступление в вуз без экзаменов.

Но большая часть (половина класса) была аутистами-хикканами вроде меня и моих знакомых.

мимо проучился в физмате 4 года

Поступать в шад не хочу, потому что обучение будет длиться долго и не все курсы мне нужны. К тому же не хочу работать 70 часов в неделю.(40 часов на работе и 30 - в шад)

Суть плана в том, чтобы дропнуть работу и фуллтайм учиться. Но пока непонятно, сколько это может занять. Нужны ваши оценки. Я прикинул, что уйдет на это около 1000 часов. Оценка основана на загруженности шадовцев.

Что скажете?

Насколько это сложно и примерно как это делается?

теория графоф

Распознаётся бибизьянка, тречется, накладывается ярый аджастмент. И т д

Ну-у-у, ты что, когда он выебывался на тебя, то тебе надо было схватить его за грудки и сказать так: "Ты кто такой? Встреваешь тут? Или бабки мне хочешь поставить!? Кто ты такой чтобы запрещать мне нервничать!? Кто ты такой? Пришел тут, базаришь. Ты не авторитет для меня, понял? Я знаю где ты живешь, сколько ты зарабатываешь, где живет твоя жена. Я завалю тебя, понял. Душонка ты коммерсантская! Все базар окончен. Тьфу".

Уёбывай отседова

Нейронка ищет закономерность. А в биржах и ставках там все слишком случайно, там все меняется все время.

Всё сведётся к тому что кормовой анон будет опять просить софт для определения количества жуков в банке

Теоретики

Тебя настолько не устраивает текущая работа, что ты готов потратить год на машоб? Ты ведь осознаёшь, что твой восторг довольно быстро пройдёт, и ты поймёшь, что это такая же рутинная область, как и другие?

Так-то за год вполне реально, я так с основ вроде линейной агрессии до ганов и прочей хуитки дошёл. Но у меня бакалаврская в ПМИ

>>282144

>Насколько это сложно

Не очень. Я в универе подобную фигню для курсача делал.

>>282171

Хуеретики. Во-первых, нашёл дурачков работать за идею, во-вторых, особо интереса для более-менее нормального спеца делать очередную распознавалку-детехтор нет, а направление куда копать ему указали.

Сейчас идет прямая трансляция от Яндекса, там сказали, что зарплата у джуна в ml до 120к. 80-120. Средняя зп в ml 200-250к. У всяких тех. лидов могут быть свыше 600-800к.

Если они работают 4 недели в месяц, 5 дней в неделю по 8 часов, то выйдет 160 часов. Возьму между 80-120 тыс. у джуна, то есть 100 тыс. Делю 100 тыс. на 160 часов, выходит 625 рублей в час.

>80-120

Какой-то гнилой пиздёж. Это у низ там внутри компании такие зп? Обычно такие вакансии максимум до 40, притом ты будешь ручным газонюхом, размечающим данные вручную и пишущим вспомогательные скриптики для взрослых дядь.

Фуллтайм не конвертируется в почасовую работу. Как минимум прибавь 40% налогов, которые ты будешь платить (или не платить) сам. Затем учти отсутствие отпуска и больничных. Короче, 1200 проси но тебе не дадут

cs231n

Я если честно, не знаю. Ну, а что плохо что-ли? Веб-макакам вон по 150-200 платят за хуй пойми что. Неплохая вроде зп для джуна.

На специальных людей, возможно на удаленке. Я студентов в воркаче находил, а в идеале я бы нанял РСП, которая с такой непыльной работы хуй уйдет куда. 40к вполне норм.

В любом случае наличие говновакансий в стиле "повар-унитазочист" не опровергает того, что человек с обязанностями повара должен получать больше, и что бежать от таких говновакансий нужно сразу, как только ты такую увидел.

>Ты ведь осознаёшь, что твой восторг довольно быстро пройдёт, и ты поймёшь, что это такая же рутинная область, как и другие?

Осознаю. Но я нахожу эту сферу в целом более полезной обществу, чем, например, очередное бизнес деливери говно, которое декомиснется внутри компании через 2 года.

>во-вторых, особо интереса для более-менее нормального спеца делать очередную распознавалку-детехтор нет

Нихуя у тебя ЧСВ, математик чтоли? Я не видел ни одной приемлемой распознавалки-детектора, помню распознавание деталюшек на транспортерной ленте была практически нерешаемой задачей. Хуйня этот ваш дипленинх.

>особо интереса для более-менее нормального спеца делать очередную распознавалку-детехтор нет, а направление куда копать ему указали

Научились писать скрипты в десять строчек на питоне, и кичитесь своими знаниями, хуже байтоебов

ТЫЖПРОГРАММИСТ

264 Кб, 700x863

264 Кб, 700x863Матиматику ниприятно

Что тебе нужно-то? Распознавать объекты? Кури компьютерное зрение, real-time object detection. Tenserflow/opencv/yolo/keras в помощь. Не забудь прихватить нормальную видеокарту. Инфы на англ. источниках более чем достаточно.

>>282193

Не, я не просить. Я наоборот хочу наблатыканного вкатывальщика нанять часов на 10 для простой псевдонаучной псевдозадачи. Я знаю таких парней в ВУЗике, парни шарят, но не работают в машинном обучении, просто учатся. Хочу примерно представить сколько это может стоить. До тогда как обсужу с кем-нибудь из них цену, если они согласятся.

>>Ты ведь осознаёшь, что твой восторг довольно быстро пройдёт, и ты поймёшь, что это такая же рутинная область, как и другие?

>Осознаю.

Зря ты ему поверил. Машоб намного менее рутинный, чем простой кодинг. Просто потому что тебе всегда есть, что автоматизировать, а полную рутину можно спихнуть кому-то неквалифицированному.

Фактически, как только твоя работа превращается в рутину, она начинает делаться автоматически - типа подбора гиперпараметров, который ты сначала пилишь руками, а потом открываешь для себя байесовскую оптимизацию.

С кодингом так не получится. Еще хуже с этим делом в инженернии, где тебе чертить нужно.

Так все тру-прогеры - байтоебы. Веб-макака, ты?

Лол, так бы сразу и сказал. Студентов можно наебывать как хочешь, особенно когда ты их нашел, а не они тебя. 500 в час это даже многовато, можно на 300 остановиться.

Другое дело, студент может и за еду работать на энтузиазме, ну это уж как повезет.

64 Кб, 511x409

64 Кб, 511x409>Tenserflow/opencv/yolo/keras в помощь

А ты смешной, это говно не работает, совсем-совсем. Хотя круг от треугольника через неделю обучения отличить сможет, да.

> Еще хуже с этим делом в инженернии, где тебе чертить нужно.

Я мимопроходил. Я в ранней молодости, пока учился в ВУЗике работал на заводе и чертил чертежи. Все время туда сюда ногами ходишь, спрашиваешь, а как тут начертить, а как тут? Потому что это как понятия. Неписанный закон как чертить. А понятия - неписанные законы знают только те, кто понятия имеет. Идешь к авторитету, который знает понятия. И он говорит вот здесь так черти, вот тут так.

Все время надо было куда-то ходить к разным авторитетам, которые знают как разрулить твою задачу и попутно навешивают еще задачи.

Я в той юности был молодой и красивый. На Джастина Бибера был похож. Я когда увольнялся, то там одна тяночка, которая была несколько старше чем я, сильно расстроилась, она, наверное, думала, что я там надолго и найду ключ к лизанию ее пипирки. А я - дурак, думал, что я молодой и перспективный, найду работу лучше, чем на этом умирающем заводе.

>из них цену, если они согласятся

Просто если они смогут использовать эту работу как диплом или еще как, то можно и бесплатно. Детей обманывать не тяжело.

1.5-2х их текущей часовой ставки.

Я омеган, я не умею обманывать. Нет, вся псевдонаучная теория уходит мне, к ним в дипломы не пойдет.

10к за проект, доя студента очень норм.

>псевдонаучная теория уходит мне, к ним в дипломы не пойдет.

А вот здесь тебя можно и наебать. Как ты предотвратишь утечку?

> Как ты предотвратишь утечку?

Никак. Имел ввиду, что просто деньги заплачу. А отдавать результаты в дипломы не планирую. Типа так договорюсь на словах.

А почему дадничаешь? Заплати пол суммы и разреши использовать в дипломе. Всем будет хорошо.

Потому что эта псевдонаучная фигня пойдет в сорт оф диплом мне. Как-то не айс будет, что все будут использовать в диплом одно и тоже. К тому же там ебаный стыд, они себе получше найду задачу.

Не фейк? Фреймрейт низкий же, очень. Я думаю у теслы повкуснее начинка должна быть.

Это местный шизик, у него все дно, что не терминатор из голливудских фильмов, а машоб свернул не в ту сторону в 1957 году

Мало читаю. Смысл? По моей теме выходит не так много статей, а пытаться объять всё не вижу смысла. Ближайший год я точно не буду заниматься каким-нибудь машинным переводом, ну и нахуя мне все эти RNN.

Только когда у меня есть конкретная тема, я читаю по ней все доступные статьи, и их, как правило, около пары десятков. Читаю абстракт-результаты (секунд за 30), узнаю, что на 0.1% улучшен state of art двухлетней давности, который делается в 10 строчек на керасе, забиваю.

Гораздо важнее гитхабы чекать с опенсорсными реализациями. Вот это заебывает, да, знать 100500 фреймворков и их особенности, чтобы прочекать, как оно будет работать на моем датасете.

Самая подстава, когда в результатах статьи утверждаются какие-то чудеса, а на гитхабе нет реализации, и ты вынужден пилить ее сам. И шансов на успех мало, и гемора куча. Вот это заебывает - когда потратил неделю на статью, которая делает совсем не то, что заявляется, и ты не знаешь, то ли статья говно, то ли ты что-то не учел. Поэтому я стараюсь без опенсорсной имплементации вообще статьи не читать - здоровье дороже.

Медленно и неточно. Говно короче.

Там не чистый, там куча датчиков и еще карта есть. Типа робопидарантелей из бостонсдинамикс.

Это понятно, я имею ввиду, ввести зондирование вообще всех машин. Чтобы датчики сигнализировали друг-другу. Это же вообще йоба будет.

А потом на дороге появляется дядя Вася из колхоза и всем пизда. При том, что машину детектировать не очень сложно. То есть ты потратишь кучу денег на одну из самых легких задач.

>Кстати, а почему автопилоты пытаются запилить на чистом компутер вижине?

Потому что это очень дешево. Так-то лучшее, что нужно для автопилота - лидар и немного вижна для знаков, поворотников, и прочей поеботы, но лидары очень дорого стоят (хотя наверное могут и дешевле при растущем спросе - хули там, лазер и детектор).

Я тупой и так и не понял Keras поддерживает или нет ускорение на GPU? Или Keras без тензорфлоу бэкенда так не может?

При наличии достаточно большого датасета можно добиться точности, выше человеческой. Соответственно делаешь примерно 10000 фоточек помидоров, нанимаешь в воркаче в толока-треде раба, который тебе это разметит, далее берешь сетку, могующую в object detection с гитхаба, обучаешь. В общем-то и все.

Круто, спасибо. А сколько займет обучение на размеченном датасете? Возможно ли горизонтальное масштабирование?

Так причем тут дядя Вася? Я имею ввиду, как дополнительную меру въебать в машину френдли чип, который будет сигнализировать софту на другой машине данные: координаты, точную скорость и прочее. Компутер вижн же не может точно определить расстояние, скорость и прочие хр-ки. Например чип в машинах полиции/скорой помощи будет сигнализировать об их важности и давать какой-то приоритет на дороге итп. Конечно для такого еще рано, но думаю, что будущие автопилоты должны обязательно иметь средства для взаимодействия друг с другом.

При том, что рассчитывать автопилот нужно на то, что на дороге будет дядя Вася. Даже если со временем будет стандарт на взаимодействие между компьютерными ИИ, дяди Васи никуда не денутся.

Возмущаюсь почему нет обсуждения этой проблемы. Например: 2 машины на автопилотах встретились лоб в лоб и остановились, обе не едут, потому что видят перед собой другую машину. Без взаимодействия проблема не решается.

От нескольких часов до недели. Не принципиально на самом деле, больше времени потеряешь на настройку гиперпараметров

Дядя Вася человек или что ты имеешь ввиду? Так он будет компутер вижином обрабатываться и как раз зондирование поможет сделать основной акцент на детектировании живых существ. Я же писал выше. Я не предлагаю полностью отказаться от компутер вижина, а предлагаю использовать гибридные технологии, которые будут взаимодействовать друг с другом.

Спасибо большое.

Блокчайн трафик, гыгы

В моем представлении зондирование обязательная мера. Если уж такой индивид появился, то опять же, компутер вижин его обрабатывает, но без учета точных хр-к. + вызывает полицию и сообщает о нарушение, ведь зондирование, обязательно!.

вротанберу

Они не будут подключены к какой-то глобальной сети тогда мамины хакеры и фбр начнут ахуевать, а будут сканировать пространство вокруг себя на наличие данных.

И что теперь с этим всем делать? Пытаться начать делать что-то самому?

Да

Да

Бля то что ты перечислил это капец. Успеешь наверно только содержание за три когда по каждому направлению прочитать.

>Успеешь наверно только содержание за три когда по каждому направлению прочитать.

Ну конкретно в моем месте ебут довольно сильно, поэтому приходится подробно изучать все это. Но там потом статистика пойдет, я вот думаю, можно ли как-то ее применить в машобе?

А ты думал тебя на 1 курсе научат нейроночки деплоить? Пиздец необучаемые, зачем вы лезите в эту универопарашу в 2018 году? Даже курсы на всяких гикбрейнс информативней.

Терпеть. Не служил не мужик и все такое.

> Но там потом статистика пойдет, я вот думаю, можно ли как-то ее применить в машобе?

Машоб и есть статистика, считай.

На самом деле химера, слепленная из статистики, комбинаторики и методов оптимизации.

>статистика

Надоело слышать статистику смертей. Во всем виноваты вы, злые языки. Злые языки, сука.

в обычном софтевейа инжиниринг никогда не работал, но мне лично больше нравится просто аутировать и писать скрипты, чем решать машобские задачи

Где оно работает?

в машобе такие же зарплаты, что и у обычных разработчиков. Что в рашке, что в Microsoft. И машоб в любой компании идет бонусом к знаниям-cs. Так что стив мейн - просто обиженка.

Поговорил со скриншотом твиттера

>Алгоритмы обучения хреновые.

Почему их не пидорнули и не запилили новые? Слишком много PhD в этом замешано?

Потому что https://en.wikipedia.org/wiki/AI_effect

ML работает неебически охуенно, просто всегда будут пидорахи с когнитивными искажениями, которые будут ныть о том, что это все не то

>> все остальные программисты очень скоро станут не нужны

Что натолкнуло тебя на эту мысль?

Ты же понимаешь, что если "нейроночки" разовьют до того, что они смогут писать бизнес код, то они смогут делать и многое другое, и тогда все по сути станут не нужны (кроме гей-пидаров, конечно)

Никого не слушай, братан, вкатывайся. Сам сейчас стараюсь вырвать момент на заебавшей бизнес-параше с перекладыванием одних скриптов на другие чтобы посмотреть кусочек курса по диплёрнинху

>Естественного интеллекта не хватает.

Ну они же могут сказать "стоп, мы обосрались, возвращаемся"? Или это как в физике, релятивисты начинают городить ебаную поебень, лишь бы не признать наличие эфира?

> Или это как в физике, релятивисты начинают городить ебаную поебень, лишь бы не признать наличие эфира?

Воу. Так антиэмельщик еще и кефирщик. Впрочем, неудивительно.

Шизик, как же ты заебал

То, что всегда найдутся шизики, у которых "так, эту проблему решили, но это НЕНАСТОЯЩАЯ ПРОБЛЕМА. Ой, и эту проблему решили? Ща... А, это тоже ненастоящая проблема. Ой, и эту проблему решили? Ща... А, это тоже ненастоящая проблема. Ой, и эту проблему решили? Ща... А, это тоже ненастоящая проблема. Ой, и эту проблему решили? Ща... А, это тоже ненастоящая проблема"

И так далее. Типичный AI effect.

>Ты до сих пор не показываешь, какую такую проблему вы уже ришили?

Потому что шизика можно только обоссать, очевидно же. Чем скорее ты съебешь из этого треда, чем лучше.

Тагда я буду здесь срать и угорать над окукленными лошками, сколько посчитаю нужным.

Ой блядь испугал. Сколько вас таких шизиков было, от золотца с его "покажи мне бесконечность", до кефирщиков в /sci/. Борды таких привлекают - ведь сообщения анонимные и можно прикинуться человеком ради небольшого внимания. До очередного детектирования.

Это просто момент гигиены, видишь шизика - обоссы его, чтобы нормальные люди отошли подальше от носителя вони.

183 Кб, 700x933

183 Кб, 700x933Ребенок-теоретик

>"стоп, мы обосрались, возвращаемся"

Куда возвращаться? Машоб не в тупике, прогресс есть небольшой, нет понимания, куда двигать дальше.

>релятивисты начинают городить ебаную поебень

Ну в общем да, я тоже не считаю их теорию самой удачной.

>Куда возвращаться?

Разве альтернатив не было? Я вот за ЭС топлю, даже думаю, что факты можно автоматически генерировань на основе статистики.

>Машоб не в тупике, прогресс есть небольшой, нет понимания, куда двигать дальше.

Нихуя себе нет понимания. В других бы науках не было такого понимания.

Как ты вообще себе представляешь это понимание? Типа, сидят 20000 ученых, и у них есть понимание. Ну окей. Они, правда, нихуя не делают (если сделают, то понимания уже не будет), но хули, вот и сидят. Наука по определению работает с чем-то непонятным, иначе это не наука.

Что касается того, куда двигаться дальше - в one shot learning прежде всего. Потому что задачи, требующие больших датасетов - уже инженерия. И модные нынче ГАНы это как раз шаг в сторону one shot learning.

Ну понятно , что есть два пути - менять архитектуру, менять алгоритм обучения.

Менять архитектуру - как? Пробуют слои какие-то вставлять, и так и эдак, у кого-то получается иногда. Каждый китаец по разу ткнет, глядишь и получится что-то. Гугл перебором генерировал. Тоже сомнительный метод.

Алгоритм обучения - что с ним делать? backpropagation мусолят уже столько лет. То регуляризаторы покрутят, то лосс, то оптимизатор. Результат не сказать, чтобы радикально отличался. Как оно в мозгу обучается, кто знает?

one shot learning - это просто более высокий уровень. Прогнали через энкодер, запомнили фичи, проиндексировали - вот и все. Но перед этим нормальный энкодер нужно сделать, и тут возвращаемся к исходной проблеме.

44 Кб, 700x533

44 Кб, 700x533Почему? Ведь тем нет рендома, статистики, черного ящика, сплошная логика понятная даже ребенку.

Потому что ЭС это нейронка на ручном обучении. Рэндома, статистики, черного ящика нет, потому что ты её готовыми фичами кормишь.

А логика внутри всех нейронок есть.

> ЭС это нейронка на ручном обучении.

нет, там правила логического вывода, называемые продукцией, нейронками там и не пахнет.

>Менять архитектуру - как? Пробуют слои какие-то вставлять, и так и эдак, у кого-то получается иногда. Каждый китаец по разу ткнет, глядишь и получится что-то. Гугл перебором генерировал.

Ну, допустим, завтра изобретут какой-то революционный метод. Перформанс улучшится. Уже послезавтра ты начнешь ныть, что нихуя нового не изобретают. И так по кругу.

Тут претензии к китайцам, потому что вы долбоебы натуральные. Прикол IBN-Net же не в "0.2%" перформанса, а в том, что "When applying the trained networks to new domains, e.g. from GTA5 to Cityscapes, IBN-Net achieves comparable improvements as domain adaptation methods, even without using data from the target domain."

То есть чуваки решают ровно ту задачу, о которой тут принято плакаться, а именно, как обучать сетки без гигантских датасетов. А маньки видят 0.2% и все, маньякам ничего не интересно. Ведь они у мамы самые умные, а китайцы, хули, обезьяны, которые слепо тычутся и не видят, что МАЩИНЛЕНИНГ В ОПАСНОСТИ. ИДЕТ НЕ ТУДА. ЗАСТОЙ.

>Тоже сомнительный метод.

Сомнительный для кого? Практически вся наука, будь то разработки новых материалов, технологий и т. д. - это ровно такой метод. Был какой-нибудь кевлар, какой-нибудь китаец нашел способ получить кевлар немного прочнее и сэкономить, например, миллион долларов. За десятилетия копится прогресс - вроде бы айрбас похож на ил-86, однако на илах уже не летают - невыгодно.

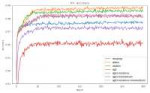

Потому что время революций в большинстве наук прошло еще лет 100 назад. Нам повезло жить во время революции в ML (а до этого - железа, интернета и сотовой связи). Но рано или поздно она остановится. Но пока - нет. Пока лично я не успеваю имплементировать все то охуенное, что делается в сообществе. По сути моя сетка это год 2016 примерно.

>То регуляризаторы покрутят, то лосс, то оптимизатор.

>Результат не сказать, чтобы радикально отличался.

Ну нихуя себе. С дивана да, не отличается. А на практике ты обучешь сетку не 24 часа, а час, перейдя с SGD на какой-нибудь AdamW. Прогресс "всего лишь" в 24 раза. Но маньки скорее повесятся, чем признают, что где-то есть прогресс без их любимых.

Та же хуйня со способами инициализации. Грамотная инициализация из свежего пейпера может сократить мне время обучения на пару порядков. Но тебе, как маньке с дивана, этого видно не будет, потому что ты дрочишь только на циферки перформанса на попсовом датасете, шовинистически относишься к китайцам и являешься долбоебом и с других сторон.

>one shot learning - это просто

Ну раз просто, то вперед, пиши пейперы. Мне вот не просто.

>Менять архитектуру - как? Пробуют слои какие-то вставлять, и так и эдак, у кого-то получается иногда. Каждый китаец по разу ткнет, глядишь и получится что-то. Гугл перебором генерировал.

Ну, допустим, завтра изобретут какой-то революционный метод. Перформанс улучшится. Уже послезавтра ты начнешь ныть, что нихуя нового не изобретают. И так по кругу.

Тут претензии к китайцам, потому что вы долбоебы натуральные. Прикол IBN-Net же не в "0.2%" перформанса, а в том, что "When applying the trained networks to new domains, e.g. from GTA5 to Cityscapes, IBN-Net achieves comparable improvements as domain adaptation methods, even without using data from the target domain."

То есть чуваки решают ровно ту задачу, о которой тут принято плакаться, а именно, как обучать сетки без гигантских датасетов. А маньки видят 0.2% и все, маньякам ничего не интересно. Ведь они у мамы самые умные, а китайцы, хули, обезьяны, которые слепо тычутся и не видят, что МАЩИНЛЕНИНГ В ОПАСНОСТИ. ИДЕТ НЕ ТУДА. ЗАСТОЙ.

>Тоже сомнительный метод.

Сомнительный для кого? Практически вся наука, будь то разработки новых материалов, технологий и т. д. - это ровно такой метод. Был какой-нибудь кевлар, какой-нибудь китаец нашел способ получить кевлар немного прочнее и сэкономить, например, миллион долларов. За десятилетия копится прогресс - вроде бы айрбас похож на ил-86, однако на илах уже не летают - невыгодно.

Потому что время революций в большинстве наук прошло еще лет 100 назад. Нам повезло жить во время революции в ML (а до этого - железа, интернета и сотовой связи). Но рано или поздно она остановится. Но пока - нет. Пока лично я не успеваю имплементировать все то охуенное, что делается в сообществе. По сути моя сетка это год 2016 примерно.

>То регуляризаторы покрутят, то лосс, то оптимизатор.

>Результат не сказать, чтобы радикально отличался.

Ну нихуя себе. С дивана да, не отличается. А на практике ты обучешь сетку не 24 часа, а час, перейдя с SGD на какой-нибудь AdamW. Прогресс "всего лишь" в 24 раза. Но маньки скорее повесятся, чем признают, что где-то есть прогресс без их любимых.

Та же хуйня со способами инициализации. Грамотная инициализация из свежего пейпера может сократить мне время обучения на пару порядков. Но тебе, как маньке с дивана, этого видно не будет, потому что ты дрочишь только на циферки перформанса на попсовом датасете, шовинистически относишься к китайцам и являешься долбоебом и с других сторон.

>one shot learning - это просто

Ну раз просто, то вперед, пиши пейперы. Мне вот не просто.

>значит ты не понял нейронки

Я их и не понимал и не собираюсь, предпочитаю заниматься тем, что работает. Но полагаю, ты хочешь сказать, что нейронки это статистические выведенные правила? Если так, то опять к ЭС это не относится.

8 Кб, 831x130

8 Кб, 831x130нейронки знатный тригер для швабропидарах

Очевидно, у нас разные взгляды на научные открытия. Для меня это - физические законы, подтвержденные теории, закономерности, какие-то новые факты об устройстве мира. То, что дает понимание и новые знания. А не "мы сделали чо-то и улучшили на процент". Почему так, а не иначе? А как оно работает? Это оптимальный метод, или можно еще улучшить? А не повлияет ли этот метод негативно в других условиях? Может он имеет какие-то ограничения и недостатки? Нужно как макака, просто повторять, и не задавать вопросов?

Я согласен, что делать что-то надо, хотя бы рашить, и нужно делиться опытом. Дрочить на этот процент, выдавать его за его изобретение - твое право, но я не буду, я перфекционист с дивана, да.

Про китайцев и шовинизм вообще мимо, шутка была что их много, а так-то в каждом первом пейпере китайские фамилии. Они еще раньше людей ИИ сделают.

Очень хорошие, но я в области НЛП, там такой пиздец, что приходится велосипедить простейшие вещи, поскольку ученые-в говне моченые не хотят делится своими наработкамипидоры

Построение дерева зависимостей Теньера на основе ЭС показало свою состоятельность и простоту реализации.

Ну ОК, считай так.

>Очевидно, у нас разные взгляды на научные открытия.

Потому что ты потребитель, и взгляд у тебя сытого бюргера. Дайте мне все и сразу, как в седьмом классе было. И взгляды у тебя человека, который никогда банальной историей науки не интересовался.

Физические законы? Ок. Возьмем тяготение. Сначала Тихо Браге годами наблюдал за звездами, потом Кеплер вывел эмперические законы (вот оно так, а почему - хуй знает), потом Ньютон обобщил их до чего-то более-менее приемлемого.

И все это время существовал ты - сначала, пиздел, что Тихо Браге тупо проедает государственные харчи и вообще тупой лжеученый (много ли надо ума цифры записывать?), потом что Кеплер на самом деле нихуя не понимает и записал какую-то хуйню про площади секторов у эллипсов, а потом, что Ньютон, который свел все в элегантную формулу, виноват в том, что так и не объяснил, откуда берется гравитация, а значит вся его работа бесполезная хуйня, не то, что Библия, где все в первых нескольких абзацах написано (в атестическом настоящем вместо Библии - религия под названием "наука", со святыми учеными в прошлом и меркантильными пидарасами в настоящем, которые тупо проедают харчи, нихуя не понимают и вообще ни одной проблемы не решили).

И это еще более-менее хорошая история.

Вот есть наука химия, она в теории сводится к квантовой механике. Но

1. Химия была и до квантовой механики. То есть глубинных процессов не понимали, а химия была. И ты ныл о том, что химики сами не знают, что делают.

2. Решать химические задачи через квантовую механику - оверкилл, так никто не делает. То есть все знают, что оно должно получаться, но на самом деле никто не проверял, точное решение есть только для водорода, численные решения непомерно сложны. И ты до сих пор ноешь, что новые модели аккумуляторов медленно появляются. Хотя казалось бы - в отличие от ML, все нужные теории есть, бери и предсказывай без опытов, но оказывается, что теории настолько сложны, что натурные эксперименты проще.

>То, что дает понимание и новые знания. А не "мы сделали чо-то и улучшили на процент".

Так в пейпере написано очень много по этому поводу. Если ты этого не видишь, кто в этом виноват?

Вся мякотка в том, что люди думали, анализировали статистики разных слоев, и придумали, и ход их мыслей интереснее результата. А ты думаешь, что "Пробуют слои какие-то вставлять, и так и эдак, у кого-то получается иногда". Ну типа, не могут же люди быть не то, что умными, а умнее тебя. Точно рандомом тыкают, макаки эдакие, и вообще у них там заговор тупых.

>Дрочить на этот процент, выдавать его за его изобретение - твое право, но я не буду, я перфекционист с дивана, да.

Что значит - дрочить? У меня есть нейронка, которая делает свою работу лучше всех в мире и решает проблему, которая несколько лет назад считалась нерешаемой. Это несложно, благо революция случилась пару лет назад и сейчас ты просто берешь и адаптируешь подход к чему угодно, и он выстреливает. Если я попробую добавить их подход, возможно она станет еще лучше.

>Очевидно, у нас разные взгляды на научные открытия.

Потому что ты потребитель, и взгляд у тебя сытого бюргера. Дайте мне все и сразу, как в седьмом классе было. И взгляды у тебя человека, который никогда банальной историей науки не интересовался.

Физические законы? Ок. Возьмем тяготение. Сначала Тихо Браге годами наблюдал за звездами, потом Кеплер вывел эмперические законы (вот оно так, а почему - хуй знает), потом Ньютон обобщил их до чего-то более-менее приемлемого.

И все это время существовал ты - сначала, пиздел, что Тихо Браге тупо проедает государственные харчи и вообще тупой лжеученый (много ли надо ума цифры записывать?), потом что Кеплер на самом деле нихуя не понимает и записал какую-то хуйню про площади секторов у эллипсов, а потом, что Ньютон, который свел все в элегантную формулу, виноват в том, что так и не объяснил, откуда берется гравитация, а значит вся его работа бесполезная хуйня, не то, что Библия, где все в первых нескольких абзацах написано (в атестическом настоящем вместо Библии - религия под названием "наука", со святыми учеными в прошлом и меркантильными пидарасами в настоящем, которые тупо проедают харчи, нихуя не понимают и вообще ни одной проблемы не решили).

И это еще более-менее хорошая история.

Вот есть наука химия, она в теории сводится к квантовой механике. Но

1. Химия была и до квантовой механики. То есть глубинных процессов не понимали, а химия была. И ты ныл о том, что химики сами не знают, что делают.

2. Решать химические задачи через квантовую механику - оверкилл, так никто не делает. То есть все знают, что оно должно получаться, но на самом деле никто не проверял, точное решение есть только для водорода, численные решения непомерно сложны. И ты до сих пор ноешь, что новые модели аккумуляторов медленно появляются. Хотя казалось бы - в отличие от ML, все нужные теории есть, бери и предсказывай без опытов, но оказывается, что теории настолько сложны, что натурные эксперименты проще.

>То, что дает понимание и новые знания. А не "мы сделали чо-то и улучшили на процент".

Так в пейпере написано очень много по этому поводу. Если ты этого не видишь, кто в этом виноват?

Вся мякотка в том, что люди думали, анализировали статистики разных слоев, и придумали, и ход их мыслей интереснее результата. А ты думаешь, что "Пробуют слои какие-то вставлять, и так и эдак, у кого-то получается иногда". Ну типа, не могут же люди быть не то, что умными, а умнее тебя. Точно рандомом тыкают, макаки эдакие, и вообще у них там заговор тупых.

>Дрочить на этот процент, выдавать его за его изобретение - твое право, но я не буду, я перфекционист с дивана, да.

Что значит - дрочить? У меня есть нейронка, которая делает свою работу лучше всех в мире и решает проблему, которая несколько лет назад считалась нерешаемой. Это несложно, благо революция случилась пару лет назад и сейчас ты просто берешь и адаптируешь подход к чему угодно, и он выстреливает. Если я попробую добавить их подход, возможно она станет еще лучше.

Бро, где работаешь, чьо пилишь?

223 Кб, 1280x720

223 Кб, 1280x720>Бородатый мужик в очках

>РЯЯЯЯ СОЙБОЙ

Заебала эта мода среди ебланов. Каждый первый обмудок с пидарской бородкой и в очках. Я ни одного нормального человека не знаю с такой внешностью, пикрелейтед лук - 100% детектор долбаеба. Естественно, ни один учёный так выглядеть не может, я к этому веду.

Так значит, я многого хочу? Возможно, что и так. Но сейчас такие благоприятные условия для науки - глобализация, информационная сеть. Это же не средние века, когда веками смотрели в трубу на звезды.

Я рад, что ты из этих пейперов видишь ход мыслей их авторов. Я вижу только введение, одну-две формулы с пространными объяснениями, сравнение метода с конкурентами, пару графиков и картинок, конклюжн, и всё. Одно из двух - либо я тупой, либо там никакой теории и анализа нет.

Часто бывает, что появляется новый метод, и старые тут же становятся неактуальными, про них все забывают. А ведь это тоже был чей-то труд, и когда-то считался открытием.

Я не умаляю заслуг ученых. Накопление информации для анализа - тоже наука, даже такая, как запись движения звезд, или смешивание говна с мочой в пробирке.

Но если машоб сейчас на уровне Тихо Браге в астрономии - это очень печально, так как это самое начало пути.

Невозможно что-то доказать шизику. Это из той же обоймы, которые в медицине будут доебывать: "А чёй-то вы рак ещё не вылечили? Ну подумаешь выживаемость повысили на 1% и риск заболевания на 5%, но не победили значит БЕСПОЛЕЗНЫМ говном занимаетесь, нет бы сразу всё ррррряяяя!"

Вот не надо примазываться к медицине. У них там исследования стоимостью в миллиарды, и огромный накопленный опыт. А нейронки задрачивать может каждый китаец. Я год назад пробовал делать InstanceNormalization, вставлял куда придется, и даже что-то начало получаться, но я забил. Мне не хватило ума/настойчивости/везения, а кому-то хватило. Никакого бугурта по этому поводу не испытываю, но и наукой не считаю.

ты даже статью не смог прочитать, которую прикрепил.

> Some language models should not be blindly trained on input data without first taking all the nuances of the language into account.

Сначала лемматизируешь все с rnnmorph, затем на этом обучаешь fasttext, и будут нужные результаты, где леммы алкогольных напитков будут близки. Просто нельзя забивать гвозди одним и тем же микроскопом, не подкручивая параметров.

abbyy уже сделали компрено, теперь везде применяется

>Но сейчас такие благоприятные условия для науки - глобализация, информационная сеть

Это благоприятные условия для науки, а не для ученых. Все происходит очень быстро, быстрее, чем может переварить человек. Вообще ML это прежде всего отказ от долгой публикации к пользу препринтов на архиве. Например, пока эта статья https://ieeexplore.ieee.org/document/7444187 публиковались (где-то год), вышло несколько препринтов, которые сделали ее не очень полезной, например, они проспали ResNet.

Это немного демотивирует, как и то, что любая твоя идея скорее всего имплементирована и проверена кем-то. Просто по закону больших чисел. Но науке - заебись.

А ученому выгодно противоположное. Ему выгодно быть председателем какого-нибудь королевского общества, чтобы вокруг не было конкурентов, а он один сидел такой умный и красивый и работал годами над идеей не спеша.

Отсюда растет феномен лженауки - в науке большая конкуренция, значит я создам свою, настоящую науку со шлюхами и блекджеком.

>Одно из двух - либо я тупой, либо там никакой теории и анализа нет.

И из двух теорий

1. Ты - тупой, как минимум - недостаточно опытный

2. В мире имеется заговор, а именно сотни ученых пользуются незаслуженной славой, деньгами и т. д., а призаваемые ими результаты - не результаты.

Ты выбираешь второе. В ней ты умнее 99.9998% людей. Или честнее 99.9998% людей. Мм, и какова вероятность этого?

>Я вижу только введение, одну-две формулы с пространными объяснениями, сравнение метода с конкурентами, пару графиков и картинок, конклюжн, и всё.

Так любой пейпер устроен. Пейперы устроены одинаково, чтобы ты мог легко парсить их мозгом, так как их много, а тебя мало. Если точнее, мудаки, которым важно опубликоваться, а не создать знание, вместо пространных объяснений пишут просто пару формул и все, ебитесь как хотите. (и это не значит, что у мудаков нет результата). Но этот пейпер хороший, там разжевано все для самых тупых типа меня.

Главное там:

>IN provides visual and appearance invariance, while BN accelerates training and preserves discriminative features.

>IN is preferred in shallow layers to remove appearance variations, whereas its strength in deep layers should be reduced in order to maintain discrimination

>component of IBN-Net can be used to re-develop many recent deep architectures

То есть, как видно, за главное - это мысль, что IN нужно располагть повыше, а BN поглубже, потому что IN лучше регуляризует абстрактные фичи, а BN лучше maintain discrimination, ну а еще то, что это универсальный метод, а не просто подгон под конкретный датасет. Хорошая статья, хороший результат.

>Но сейчас такие благоприятные условия для науки - глобализация, информационная сеть

Это благоприятные условия для науки, а не для ученых. Все происходит очень быстро, быстрее, чем может переварить человек. Вообще ML это прежде всего отказ от долгой публикации к пользу препринтов на архиве. Например, пока эта статья https://ieeexplore.ieee.org/document/7444187 публиковались (где-то год), вышло несколько препринтов, которые сделали ее не очень полезной, например, они проспали ResNet.

Это немного демотивирует, как и то, что любая твоя идея скорее всего имплементирована и проверена кем-то. Просто по закону больших чисел. Но науке - заебись.

А ученому выгодно противоположное. Ему выгодно быть председателем какого-нибудь королевского общества, чтобы вокруг не было конкурентов, а он один сидел такой умный и красивый и работал годами над идеей не спеша.

Отсюда растет феномен лженауки - в науке большая конкуренция, значит я создам свою, настоящую науку со шлюхами и блекджеком.

>Одно из двух - либо я тупой, либо там никакой теории и анализа нет.

И из двух теорий

1. Ты - тупой, как минимум - недостаточно опытный

2. В мире имеется заговор, а именно сотни ученых пользуются незаслуженной славой, деньгами и т. д., а призаваемые ими результаты - не результаты.

Ты выбираешь второе. В ней ты умнее 99.9998% людей. Или честнее 99.9998% людей. Мм, и какова вероятность этого?

>Я вижу только введение, одну-две формулы с пространными объяснениями, сравнение метода с конкурентами, пару графиков и картинок, конклюжн, и всё.

Так любой пейпер устроен. Пейперы устроены одинаково, чтобы ты мог легко парсить их мозгом, так как их много, а тебя мало. Если точнее, мудаки, которым важно опубликоваться, а не создать знание, вместо пространных объяснений пишут просто пару формул и все, ебитесь как хотите. (и это не значит, что у мудаков нет результата). Но этот пейпер хороший, там разжевано все для самых тупых типа меня.

Главное там:

>IN provides visual and appearance invariance, while BN accelerates training and preserves discriminative features.

>IN is preferred in shallow layers to remove appearance variations, whereas its strength in deep layers should be reduced in order to maintain discrimination

>component of IBN-Net can be used to re-develop many recent deep architectures

То есть, как видно, за главное - это мысль, что IN нужно располагть повыше, а BN поглубже, потому что IN лучше регуляризует абстрактные фичи, а BN лучше maintain discrimination, ну а еще то, что это универсальный метод, а не просто подгон под конкретный датасет. Хорошая статья, хороший результат.

>Но если машоб сейчас на уровне Тихо Браге в астрономии

ML сейчас на уровне Кеплера - есть эмпирические законы без хорошей подлежащей фундаментальной теории. Но законы при этом рабочие.

Но, в общем-то, когда ее найдут, будет как с химией, в которой открытие квантовой механики надобность в химии не отменила. Я уверен, что будут копать в сторону manifold hypothesis, изучат свойства этого самого многообразия, докажут, ну и заебись. Легче от этого не станет. Мы так и останемся химиками.

>это очень печально, так как это самое начало пути.

Это охуенно и мечта ученого. Печально - это поиски "теории всего" в физике.

> ML сейчас на уровне Кеплера - есть эмпирические законы без хорошей подлежащей фундаментальной теории.

Есть теория, только сойбои в неё не могут, потому что сложно. Проще наебенить слоёв без понимания, нахуя все это.

180 Кб, 729x486

180 Кб, 729x486>Каждый первый обмудок с пидарской бородкой и в очках.

Нет, чувак, пидорство - это бриться каждый день, еще большее пидорство - это ходить в барбершопы. А это самый непидорский лук, который можно придумать.

Нормальный человек по своей воле часто бриться не будет - от этого нихуя, кроме раздражения кожи, не получишь. Раньше общество было более тоталитарным, были корпоративные правила и требовалось соблюдать дресскод - костюм, галстук, выбритое лицо. Барбершопы еще более ебанутая вещь, для господ из 19 века, которым совершенно нехуй делать было.

Сейчас такого нет, люди одеваются в удобный и универсальный casual и имеют удобную растительность на лице. А очки - ну блядь, охуенная предъява вообще, ты чо, очкарик)))

Все нормальные белые мужчины так и выглядят. Не выглядят так азиаты или индусы, у которых борода просто не растет. Прикол в том, что это тестостерон как раз - ты мужик и у тебя растет борода, но нет, жирные школьники с форчана с гинекомастией выдумали каких-то сойбоев.

То, что они при этом выглядят как говно, а не как Клинт Иствуд, и нарушают твои эстетические чувства - ну так может ты и есть пидор, что тебя ебет, как выглядят мужики? Или ты любитель тоталитарного сапога в жопе, ходить строем и быть гладко выбритым? Короче, это с тобой что-то не так, если ты в принципе видишь в этом какую-то моду.

148 Кб, 994x745

148 Кб, 994x745Сойбойство не во внешности, а в головах. Просто так завелось, что сойбои выбирают именно такую внешность - короткая стрижка/лысина, борода, очки.

Основная суть сойбойства - почитание навязанных обществом трендов. Что угодно, лишь бы не казаться аутсайдером. Нинтендо свитч, современные сериалы с нетфликса, использование ультрамодных джаваскрипт-фреймворков - настоящее сойбойство. Внешние признаки - большая вероятность того, что человек сойбой (потому что нормальные люди никогда не захотят быть спутанными с одним из них).

>почитание навязанных обществом трендов

Имплаинг это не всегда было так .

По мне так уж лучше хипстеры,чем как чулочные трапы в 18 веке.

>почитание навязанных обществом трендов

Имплаинг это не всегда было так .

В 18 веке было модным и обязательным у знати ходить как чулочный трап, с отпудернным лицом и в парике нопремер.

214 Кб, 350x350

214 Кб, 350x350вербит? тысячи их

читал несколько статей по медицине

Выглядят они еще хуже чем по машобу

описывают больного не слишком подробно говорят лечили вот этой хуйней и помогло

Ну это та парочка статей что я по своей болезни читал ясное дело что есть и лучше.

>Сойбойство не во внешности, а в головах

Ну кому ты пиздишь.

Вот поциент: https://twitter.com/smaine

Нинтендо свитч? Мимо. Современные сериалы с нетфликса? Мимо. Жаваскрипт фреймворки? Мимо.

Что остается. Борода блядь и очки. И уверенность, что у этого мужика борода и очки не потому что бриться лень, а в линзах за монитором сохнут глаза, а потому что "лишь бы не казаться аутсайдером".

>почитание навязанных обществом трендов

>нормальные люди никогда не захотят быть спутанными с одним из них

Вот это божественная ирония.

Общество: форчан, knowyourmeme и прочие места тусовок нитакихкакфсе школьников

навязывает тренд: не любить людей с бородой и очками, а за кривляние на камеру просто убивать

И ты ему следуешь. Но при этом ты считаешь, что это ты нормальный человек. Лалка, воистину кого Юпитер хочет погубить, того лишает разума.

Нормальные люди подобным не заморачиваются, нормальные люди не бреются, не стесняются очков, если у них плохое зрение, и, о ужас, могут купить себе свитч, ведь у каждого первого миллениала в детстве была NES или ее клон.

В медицине все очень хуево с повторяемостью. Люди и их болезни более уникальны, чем один и тот же датасет.

>И ты ему следуешь

Ай-яй-яй. Вот тут ты промахнулся. Не нужно вешать на меня ярлыки за то, что я описал, как выглядят и чем увлекается типичный сойбой. Я не принадлежу ни к одной социальной группе, но очень люблю их критиковать.

>нормальные люди не бреются

Нормальные люди что хотят, то и делают, а не слушаются анонов на дваче, дабы соответствовать определённому образу.

>не стесняются очков, если у них плохое зрение

Носить очки из-за плохого зрения - нормально. Носить очки без диоптрий, чтобы казаться умным, потому что это модно - долбоебизм.

>могут купить себе свитч

Не вижу вообще никакого смысла в покупке устройства, предназначенного только и исключительно для игр (если ты под эту платформу не собираешься ничего разра). Вернуть этим NES-детство всё равно не получится.

38 Кб, 1213x587

38 Кб, 1213x587>Ай-яй-яй. Вот тут ты промахнулся

Нет. Если бы ты написал как выглядит сойбой, это одно (хотя сама по себе замороченность по их поиску уже о многом говорит). Но ты еще добавил: "потому что нормальные люди никогда не захотят быть спутанными с одним из них". А это уже диагноз.

>Я не принадлежу ни к одной социальной группе

Ха-ха-ха-ха.

Ты принадлежишь к социальной группе "озлобленный на весь мир анонимус" как минимум. И у этой группы тоже есть тренды. Пик релейтед.

А вообще ты пересечение разных социальных групп - от своей семьи и группы русскоязычных до научных фриков.

Все это вместе составляет некий многомерный вектор и это собственно позволяет не очень умным людям, подверженным когнитивным искажениям, доебываться, как они хотят. Можно найти тысячи параметров, по которым ты будешь совершенно средним представителем своей группы. А можно найти что-то уникальное у каждого. Как, собственно, озлобленные анонимусы и поступают, они берут один критерий, в котором они считают, что лучше других людей, и дальше ранжируют этих самых людей по этому критерию. Типа, мужик из Сиэтла с хорошим образованием и работой, неплохо устроившийся в жизни и живущий как хочет. Чем он хуже меня, живущего с мамкой в проперженном совковом интерьере нищука? А, у него пидорская бородка. И все - жизнь прекрасна, гиперплоскость проведена, ты на стороне классных пацанов, остальные - сойбои.

>Носить очки из-за плохого зрения - нормально. Носить очки без диоптрий, чтобы казаться умным, потому что это модно - долбоебизм.

На твоем пике у всех очки с диоптриями.

>Не вижу вообще никакого смысла в покупке устройства, предназначенного только и исключительно для игр

Это типичная позиция для людей из твоей социальной группы.

Паперы пишут для того, чтобы со степухой и грантами не пидорнули, только долбоеб будет это бесполезное говно читать.

>>283315

>в которой открытие квантовой механики надобность в химии не отменила

Химики шлют нахуй квантовую механику и топят за эфир

Типичный представитель социальной группы "научные фрики".

>Но ты еще добавил: "потому что нормальные люди никогда не захотят быть спутанными с одним из них". А это уже диагноз

А ты знаешь, почему они никогда не захотят? Или ты мыслишь лишь домыслами?

Я отвечу тебе, друг мой. Потому что судят по одёжке. Потому что в сознании людей бородка и очки == сойбой (и пост >>282823 это подтверждает как нельзя кстати). Точно так же, как в сознании людей кепка и треники == гопник. Если ты своей внешностью похож хоть на какой-то стереотипный образ, то это нехорошо. Нужно любой ценой избегать собственного стереотипирования. Поэтому нормальные люди никогда не захотят быть спутанными с сойбоями. Если тебя спутали - значит, ты выглядишь стереотипно.

>Ты принадлежишь к социальной группе "озлобленный на весь мир анонимус" как минимум

Ммм, угу, угу, а с чего ты сделал такие выводы? Или же ты проецируешь? У меня есть работа и я люблю гулять - это отличает меня от группы "озлобленный анонимус". Всё, стрелочка больше не поворачивается, она сломалась.

>ты на стороне классных пацанов, остальные - сойбои

И опять ты оказался в ловушке проекций своего ограниченного мышления. Для тебя существует только две половинки мира, не так ли? Свои и чужие, классные пацаны и сойбои, на кого ещё у вас там модно делить мир? Всё так в твоём представлении, верно? И ты не можешь даже представить, что что-то может быть по-другому?

Видишь ли, быть на любой стороне - что "классных пацанов", что сойбоев, противно самой моей природе. Любая принятая сторона, на которой есть хоть ещё 1 человек, по определению вредна. Не так это работает. У меня всегда найдётся запас отличительных признаков от любой социальной группы, к какой бы ты ни пытался меня причислить.

>На твоем пике у всех очки с диоптриями

Что не значит, что люди так не делают из-за моды.

>Это типичная позиция для людей из твоей социальной группы

Ещё раз прочитай это - я не принадлежу ни к какой социальной группе. Нет такой вещи, как "моя социальная группа". Не нужно подгонять моё поведение под какие-то стандарты, а потом пытаться ожидать от меня чего-то в соответствии с этими стандартами.

>Но ты еще добавил: "потому что нормальные люди никогда не захотят быть спутанными с одним из них". А это уже диагноз

А ты знаешь, почему они никогда не захотят? Или ты мыслишь лишь домыслами?

Я отвечу тебе, друг мой. Потому что судят по одёжке. Потому что в сознании людей бородка и очки == сойбой (и пост >>282823 это подтверждает как нельзя кстати). Точно так же, как в сознании людей кепка и треники == гопник. Если ты своей внешностью похож хоть на какой-то стереотипный образ, то это нехорошо. Нужно любой ценой избегать собственного стереотипирования. Поэтому нормальные люди никогда не захотят быть спутанными с сойбоями. Если тебя спутали - значит, ты выглядишь стереотипно.

>Ты принадлежишь к социальной группе "озлобленный на весь мир анонимус" как минимум

Ммм, угу, угу, а с чего ты сделал такие выводы? Или же ты проецируешь? У меня есть работа и я люблю гулять - это отличает меня от группы "озлобленный анонимус". Всё, стрелочка больше не поворачивается, она сломалась.

>ты на стороне классных пацанов, остальные - сойбои

И опять ты оказался в ловушке проекций своего ограниченного мышления. Для тебя существует только две половинки мира, не так ли? Свои и чужие, классные пацаны и сойбои, на кого ещё у вас там модно делить мир? Всё так в твоём представлении, верно? И ты не можешь даже представить, что что-то может быть по-другому?

Видишь ли, быть на любой стороне - что "классных пацанов", что сойбоев, противно самой моей природе. Любая принятая сторона, на которой есть хоть ещё 1 человек, по определению вредна. Не так это работает. У меня всегда найдётся запас отличительных признаков от любой социальной группы, к какой бы ты ни пытался меня причислить.

>На твоем пике у всех очки с диоптриями

Что не значит, что люди так не делают из-за моды.

>Это типичная позиция для людей из твоей социальной группы

Ещё раз прочитай это - я не принадлежу ни к какой социальной группе. Нет такой вещи, как "моя социальная группа". Не нужно подгонять моё поведение под какие-то стандарты, а потом пытаться ожидать от меня чего-то в соответствии с этими стандартами.

>Нужно любой ценой избегать собственного стереотипирования.

Можно, если хочешь напугать омегана, который ссыт гопника, то можно таки нацепить мохнатую кепочку восьмиклинку, нанести малобаром разовые татухи, сфотографироваться с пистолетом или с битой в руках, пригласить создать фон быдлоклассников, которые колоритно выглядят.

39 Кб, 500x366

39 Кб, 500x366Если есть пара-тройка имплементаций на гитхабе - то хорошо. Одна от автора - ну такое. Если нет - то, может хорошо, а может и нет. Не трать время.

А так arxiv-sanity это начальная точка. Ну и твиттеры-хуиттеры, реддиты и прочее говно.

если это что-то годное значит будет в книжке уже 99%

Ничего ни читай, сэкономишь время с тем же результатом

Тогда имплементация будет или на том же гитхабе (при чем тут возраст статьи вообще), в scipy, в матлабе (как в пользовательском файловом архиве, так и как часть тулбокса), в R, Mathematica или, в самом пиздецовом случае, на фортране каком-нибудь. И можно даже ранжировать по степени годности.

Вероятность того, что твоя статья никем в паблике не имплементирована и при этом годна крайне мала.

>А ты знаешь, почему они никогда не захотят?

Конечно знаю.

>Я отвечу тебе, друг мой. Потому что судят по одёжке.

Yep. В этом и заключается мой диагноз - у тебя комплесы из разряда "что люди подумают".

>Если ты своей внешностью похож хоть на какой-то стереотипный образ, то это нехорошо

Почему?

>Ммм, угу, угу, а с чего ты сделал такие выводы? Или же ты проецируешь? У меня есть работа и я люблю гулять - это отличает меня от группы "озлобленный анонимус".

Вообще, не удивительно, что ты в ML не можешь. Ты даже посыл моего поста не понял. Я просто взял и препарировал тебя тем же методом, которым ты препарируешь других.

Фишка-то в чем. Сойбоев не существует. Потому что каждый из них может сказать "у меня всегда найдётся запас отличительных признаков от любой социальной группы, к какой бы ты ни пытался меня причислить". Равно как и не существует "озлобленных анонимусов". Ровно по той же причине. Каждый человек уникален, как уникальны его отпечатки пальцев. Однако социальные группы существуют. Как так получается? Ну, довольно просто - из уникальности человека не следует, что люди не кластеризуются. Даже в случае полностью равномерного распределения признаков люди находят паттерны - например, созвездия это поиск паттернов в достаточно равномерном 2д-распределении звезд. А у нас, естественно, распределение не равномерно.

Мы сначала кластеризуем людей, потом усредняем признаки, и дальше считаем норму между человеком и "средним человеком из данной социальной группы". Меньше какого-то порога - ярлык навешен. Поэтому то, что у тебя есть работа, не отрывает тебя от группы "озлобленный анонимус", потому что по совокупности других признаков ты являешься озлобленным анонимусом. Более того, это было бы крайне невероятным, если бы у тебя таких признаков не было. Я об этом писал выше - "Можно найти тысячи параметров, по которым ты будешь совершенно средним представителем своей группы. А можно найти что-то уникальное у каждого".

>И опять ты оказался в ловушке проекций своего ограниченного мышления.

Нет, я оказался в ловушке твоего ограниченного мышления.

>Ещё раз прочитай это - я не принадлежу ни к какой социальной группе.

Это будет решать социум, мой дорогой квир.

>А ты знаешь, почему они никогда не захотят?

Конечно знаю.

>Я отвечу тебе, друг мой. Потому что судят по одёжке.

Yep. В этом и заключается мой диагноз - у тебя комплесы из разряда "что люди подумают".

>Если ты своей внешностью похож хоть на какой-то стереотипный образ, то это нехорошо

Почему?

>Ммм, угу, угу, а с чего ты сделал такие выводы? Или же ты проецируешь? У меня есть работа и я люблю гулять - это отличает меня от группы "озлобленный анонимус".

Вообще, не удивительно, что ты в ML не можешь. Ты даже посыл моего поста не понял. Я просто взял и препарировал тебя тем же методом, которым ты препарируешь других.

Фишка-то в чем. Сойбоев не существует. Потому что каждый из них может сказать "у меня всегда найдётся запас отличительных признаков от любой социальной группы, к какой бы ты ни пытался меня причислить". Равно как и не существует "озлобленных анонимусов". Ровно по той же причине. Каждый человек уникален, как уникальны его отпечатки пальцев. Однако социальные группы существуют. Как так получается? Ну, довольно просто - из уникальности человека не следует, что люди не кластеризуются. Даже в случае полностью равномерного распределения признаков люди находят паттерны - например, созвездия это поиск паттернов в достаточно равномерном 2д-распределении звезд. А у нас, естественно, распределение не равномерно.

Мы сначала кластеризуем людей, потом усредняем признаки, и дальше считаем норму между человеком и "средним человеком из данной социальной группы". Меньше какого-то порога - ярлык навешен. Поэтому то, что у тебя есть работа, не отрывает тебя от группы "озлобленный анонимус", потому что по совокупности других признаков ты являешься озлобленным анонимусом. Более того, это было бы крайне невероятным, если бы у тебя таких признаков не было. Я об этом писал выше - "Можно найти тысячи параметров, по которым ты будешь совершенно средним представителем своей группы. А можно найти что-то уникальное у каждого".

>И опять ты оказался в ловушке проекций своего ограниченного мышления.

Нет, я оказался в ловушке твоего ограниченного мышления.

>Ещё раз прочитай это - я не принадлежу ни к какой социальной группе.

Это будет решать социум, мой дорогой квир.

>использование ультрамодных джаваскрипт-фреймворков

А можно мне их использовать если они рили помогают?

>Yep. В этом и заключается мой диагноз - у тебя комплесы из разряда "что люди подумают"

М, нет. Люди - лишь индикатор того, что с тобой что-то не так. Но при этом индикатор довольно точный и очень глупо им не пользоваться.

>Почему?

Потому что чтобы прожить свою собственную жизнь, нужно, чтобы она была твоей собственной. Стереотипность образа - верный признак того, что твоя жизнь - не больше чем одна из готовых моделей.

>Вообще, не удивительно, что ты в ML не можешь

Это тот самый ML, который на картинке с гориллой находит барсука, если к картинке добавить совсем небольшой шум?

Вот оно, собственно - ты узник своей модной технологии и пытаешься подогнать весь мир под неё. Три года назад ты задрачивал облака, потом веб-фреймворки, а сейчас задрачиваешь ML. Ты не больше чем стереотипная пустышка. Таких, как ты - миллионы и все вы проживёте свою жизнь одинаково. И не важно даже, хорошо ли вы её проживёте или нет. Важно, что одинаково.

>Сойбоев не существует

>Равно как и не существует "озлобленных анонимусов"

Существуют. До тех пор, пока они подходят под определённые критерии и не стараются впоследствии их избегать, они существуют.

>Мы сначала кластеризуем людей, потом усредняем признаки, и дальше считаем норму между человеком и "средним человеком из данной социальной группы"

Тут вот в чём дело. Если всю жизнь мерить по ML, то можно подобрать абсолютно любой набор признаков, по которым любого человека можно причислить к любой группе. Просто меняя признаки и объём выборки. Понимаешь, к чему я клоню? Реальная жизнь сложнее твоей математической модели. Модель можно обмануть, жизнь - нет.

>Это будет решать социум, мой дорогой квир

Нет уж, это решаю я. Социум - это индикатор, он не может ничего решать.

Можно. Делать вообще можно что угодно, главное - показать, что ты отличаешься от других, кто использует такой же фреймворк.

Тут постят несмешное.жпг

>>281076 (OP)

Столкнулся с такой проблемой:

Предположим, что наша дата - это покупки в онлайн магазине.

Там много feature, в том числе город. Скорее всего, нордические воины не будут часто заказывать себе солнечные очки, а южане не купят ушанку.

Как поступить в этой ситуации? Можно разделить людей по областям и рассчитывать индивидуально, но тогда не будет учитываться общая картина. Можно выбросить из даты города вообще.

Или я чего-то не понимаю и проблемы тут нет - просто юзать деревья и оно там как-нибудь само..?

>Или я чего-то не понимаю и проблемы тут нет - просто юзать деревья и оно там как-нибудь само..?

А то. Только просто город как фича не очень, можно добавить географические координаты хотя бы. А так в конкурсе от авито как только не изъебывались

45 Кб, 403x604

45 Кб, 403x604дано:

1. 30 лвл

2. вроде бы хорошо помню весь необходимый матан с универа

3. могу в питон

4. могу в простой английский (то есть в хорошо поставленную, не быструю речь)

5. непосредственно с нейронками и машобом дела ранее не имел

6. сложилась ситуация, что могу обучаться этому в рабочее время.

Ищу годных курсов или записей лекций по машрбу, дабы по пацанский разъяснили что да как. желательно на английском что бы и его подкачать. желательно с tensorflow и keras.

существуют такие?

на крайняк возможны русскоязычные курсы, тодько блджад без всякой воды и с нормальным преподом.

38 Кб, 810x1080

38 Кб, 810x1080Препод в универе дал задачку.

Дано: фото риса рассыпного на столе

Требуется: Посчитать количество рисинок на фото

Проблема: Если на фото есть слипшиеся рисинки, я не знаю как посчитать их количество в этой слипшейся кучке.

Помогите придумать алгоритм как разделить эти слипшиеся рисинки или просто оценить их количество в этой слипшейся кучке.

на твоей фотке у них у всех примерно одинаковая площадь

можно попробовать количество рисинок в "комках" оценивать по ней

276 Кб, 500x387

276 Кб, 500x387>Основная суть сойбойства - почитание навязанных обществом трендов

Ой блять. Сойбойство - это, в первую очередь, отсутствие маскулинности. Соя плохо влияет на тестестерон

Как земля.

Социализм это лучшее что придумало человечество, подрастешь может и поймешь

Так обучи различать

53 Кб, 2051x1365